©作者 | 韩聪

单位 | 美团

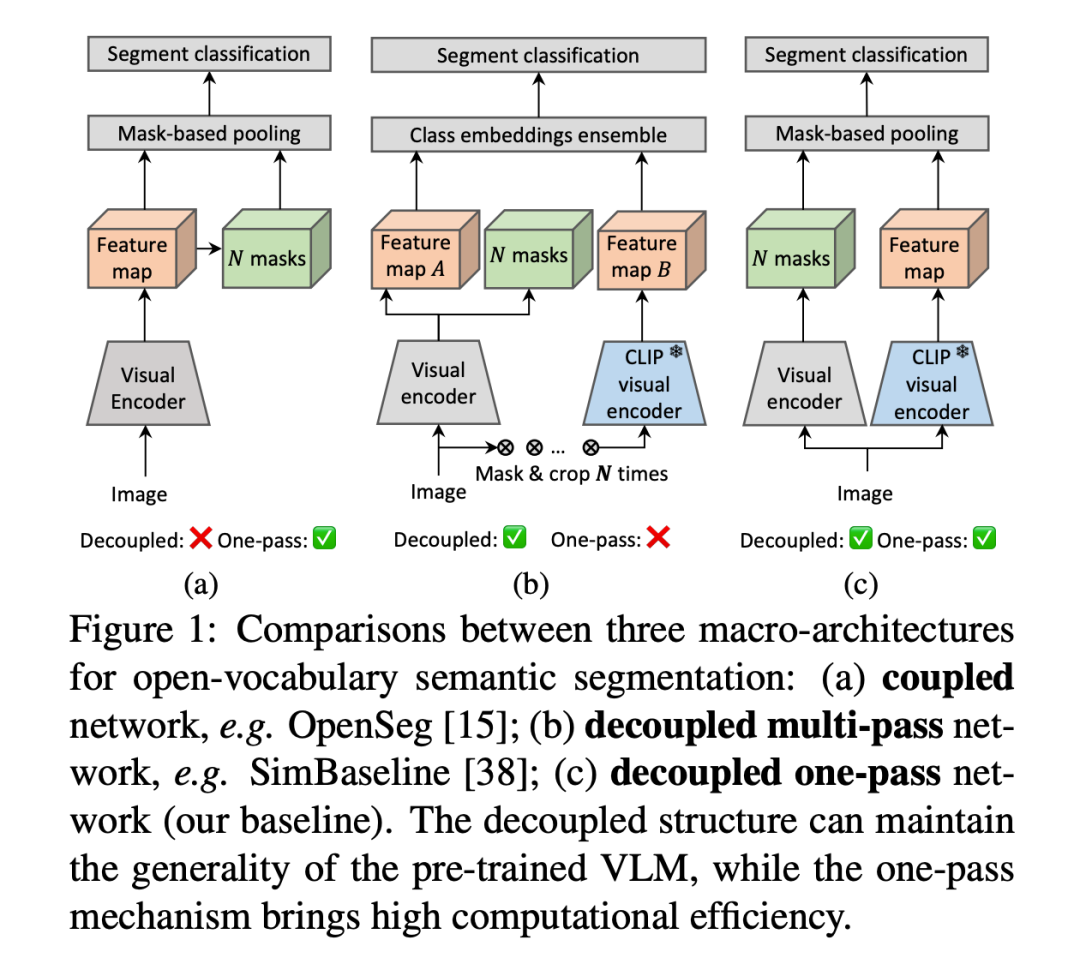

针对开放字典的语义分割任务,目前常用的方法有两种 coupled one-pass(例如 OpenSeg)和 decoupled multi-pass(例如 SimBaseline, ZegFormer, OVSeg 等),这两者的结构图可以分别对应图 1(a) 和 (b)。

耦合 (coupled) 方式直接在可见类别上训练特征提取器并得到 class-agnostic masks,然后得到基于区域的分类特征,但特征的泛化性无法保证。解耦 (decoupled) 方式利用 Maskformer/SAM 等得到 class-agnostic masks,然后将生成的 mask 和预训练的视觉语言模型(CLIP 等)结合,从而完成分割任务。

这种方法在使用过程中利用了对齐的视觉-语言特征,能够保证特征的泛化性;但解耦方式中对同一张图片的多张 masks 都需要分别叠加到原图后才能经过 CLIP,带来了巨大的计算量。总的来说,one-pass 的方法相比 multi-pass 具有计算高效的优势,但解耦 (decoupled) 方法耦合 (coupled) 方法具有更强的泛化性。我们考虑能否将两者结合起来,使用 decoupled one-pass 方法(图1(c)),使模型既拥有强大的泛化性能,又能够高效计算。

论文标题:

Open-Vocabulary Semantic Segmentation with Decoupled One-Pass Network

论文地址:

https://arxiv.org/abs/2304.01198

代码地址:

https://github.com/CongHan0808/DeOP

本文方法

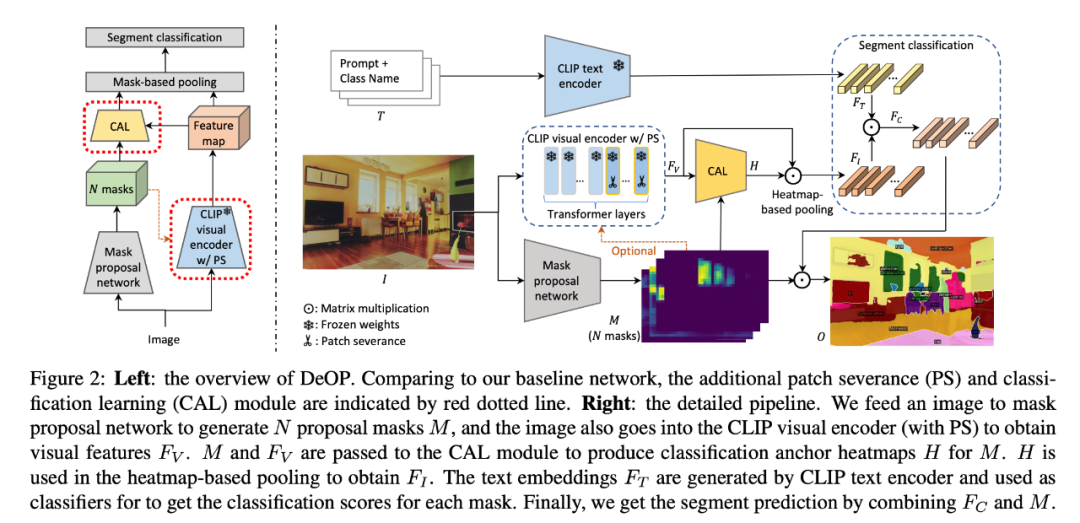

在该任务中,我们认为使用预训练的视觉语言模型 (CLIP) 来保证视觉和文本特征的对齐是非常必要的,因此我们会保留预训练的 CLIP 模型,然而直接将 masks 和经过 CLIP 的视觉特征结合进行分类效果又很差。为解决这一问题,本文提出 decoupled one-pass network,可以将 masks 作用于改进 CLIP 得到的视觉特征获取分类特征,能够在性能上超越现有方法,同时在推理速度上有 4-7 倍的提升。

本文首先提出了 Generalized Patch Severance (GPS) 方法,通过改进 CLIP 视觉模型,获得更适合分割任务的视觉特征,能够直接将 masks 和视觉特征融合,获取良好的分类特征。Generalized Patch Severance 是针对分割任务,对 CLIP 视觉模型进行的改进,是完全 training-free,可以和所有的提取 mask 的模型结合,比如 Mask2former、SAM、MaskDINO 等,更好的 mask 分割模型,也会获得更好的分类结果。

在此基础上,本文又提出可训练的网络结构 Classification Anchor Learning (CAL),使用 masks 作为引导,并添加可学习网络,从 CLIP 的视觉特征中获取更多的有助于分类的信息。

本文提出方法的整体结构如图所示:

实验结果

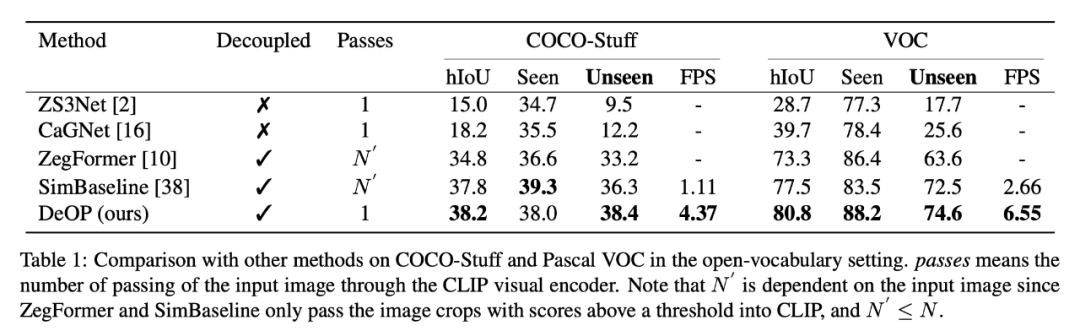

open-vocabulary 设定下,数据集内划分 seen/unseen 类别结果:

在跨数据集设定下,实验结果:

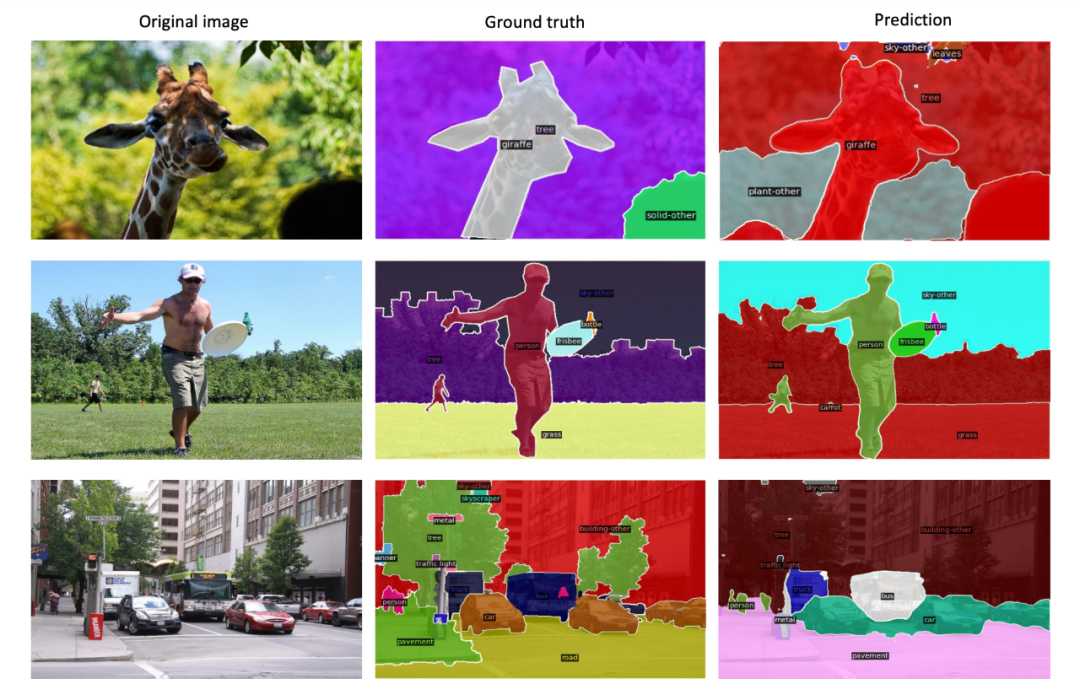

可视化分割效果:

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

·

7832

7832

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?