最近来自浙江大学和华中科技大学的研究人员提出 EVE-NeRF 模型,一种具有泛化能力神经辐射场模型用于少样本的 3D 视图合成。模型以一种纠缠的方式聚合视角-极线特征,并引入场景不变的外观连续性和几何一致性先验,在泛化性 3D 视图合成测试中达到 SOTA,并且在真实世界中具有多种应用场景。

在 AR、VR、场景设计、自动驾驶以及电影制作等多个领域中,神经辐射场 NeRF 已经成为一种革命性的技术,它通过从一组二维图像中重建高质量的三维场景,为这些领域带来前所未有的真实感和沉浸感。

然而,传统的 NeRF 通常只适用于优化单个场景,泛化到新场景需要重新训练。另外,NeRF 的优化一般需要同一场景的 50-100 张多视角高质量图片,这在某些场景中是难以获取的。

因此,跨场景训练、少量视角需求的泛化性 NeRF 方法可提高模型的应用范围和灵活性,并节约时间和资源。

以往的泛化性 NeRF,往往需要经过三个步骤:从图像中提取 2D 特征,学习与辐射场对齐的可泛化特征,以及基于体渲染的光线合成。

然而这些方法在学习可泛化特征的阶段,没有同时关注视角和极线两个维度的特征,导致信息交互不足,最终影响新视角的渲染结果。

▲ EVE-NeRF 与仅有视角维度聚合(左上)、仅有极线维度聚合(右上)对比

另外,以往模型仅仅依靠跨场景数据集提供泛化能力,难以保持 3D 场景的外观的连续性和几何的一致性。

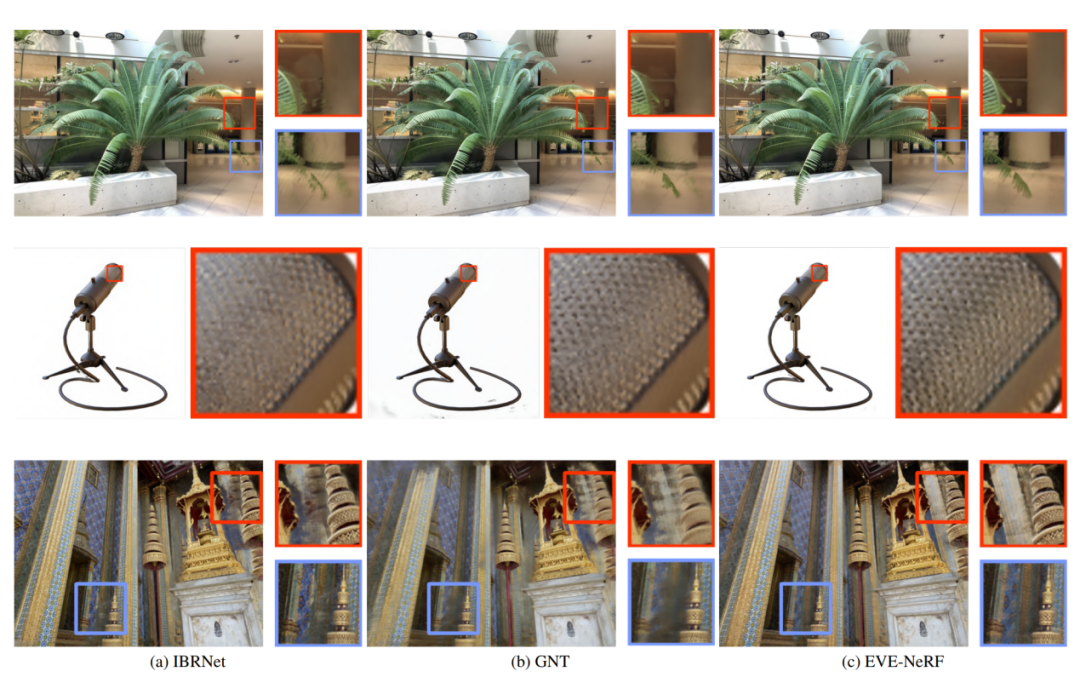

▲ EVE-NeRF 和其他泛化性 NeRF 对比

对此,来自浙江大学和华中科技大学的研究人员提出 EVE-NeRF 模型&#x

浙江大学和华中科技大学的研究团队提出了EVE-NeRF模型,该模型通过视角-极线特征的纠缠聚合,解决了传统NeRF的泛化能力和视角需求问题,仅需3-10张图片即可进行3D视图合成。EVE-NeRF在泛化性和Few-shot场景中表现出优越的渲染质量和效率。

浙江大学和华中科技大学的研究团队提出了EVE-NeRF模型,该模型通过视角-极线特征的纠缠聚合,解决了传统NeRF的泛化能力和视角需求问题,仅需3-10张图片即可进行3D视图合成。EVE-NeRF在泛化性和Few-shot场景中表现出优越的渲染质量和效率。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

360

360

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?