本文将建立多层神经网络的函数,这个函数是一个简单的通用函数,

通过最后的测试,可以建立一些多次方程的模型,并通过matplotlib.pyplot演示模型建立过程中的数据变化情况

如果你对神经网络不太了解可以参考我前面的一些文章,这里列出一些主要的参考

机器学习(1)--神经网络初探

tensorflow实例(2)--机器学习初试

tensorflow实例(6)--机器学习中学习率的实验

通过最后的测试,可以建立一些多次方程的模型,并通过matplotlib.pyplot演示模型建立过程中的数据变化情况

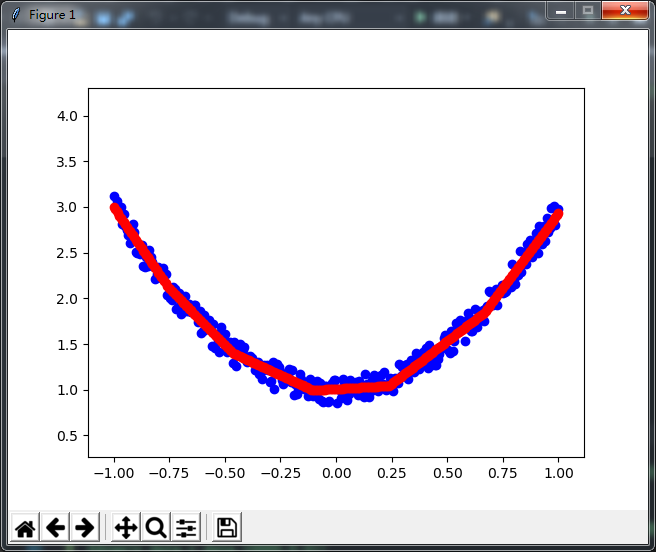

以下三张图片是生成的效果,每张图的蓝点都表示为样本值,红点表示最终预测效果,本例带有点动画效果,可以更直观的觉数值的变化

如果你对神经网络不太了解可以参考我前面的一些文章,这里列出一些主要的参考

机器学习(1)--神经网络初探

tensorflow实例(2)--机器学习初试

tensorflow实例(6)--机器学习中学习率的实验

机器学习(7)--梯度下降法(GradientDescent)的简单实现

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?