看似最小二乘估计与最大似然估计在推导得到的结果很相似,但是其前提条件必须引起大家的注意!!!

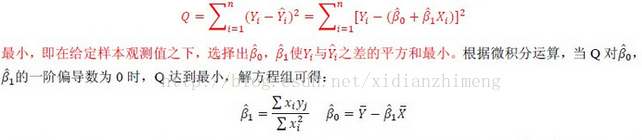

对于最小二乘估计,最合理的参数估计量应该使得模型能最好地拟合样本数据,也就是估计值和观测值之差的平方和最小,其推导过程如下所示。其中Q表示误差,Yi表示估计值,Yi'表示观测值。

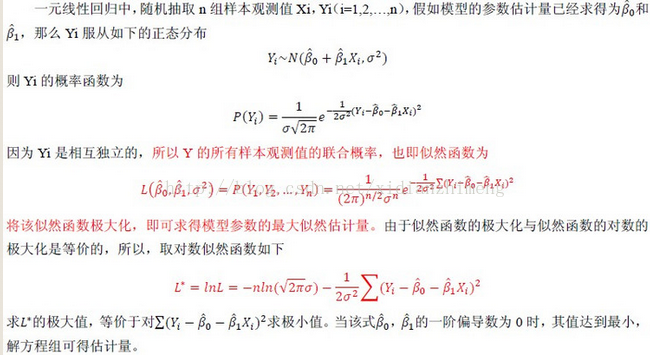

对于最大似然法,最合理的参数估计量应该使得从模型中抽取该n组样本观测值的概率最大,也就是概率分布函数或者说是似然函数最大。显然,这是从不同原理出发的两种参数估计方法。因此最大似然法需要已知这个概率分布函数,一般假设其满足正态分布函数的特性,在这种情况下,最大似然估计和最小二乘估计是等价的,也就是说估计结果是相同的,但是原理和出发点完全不同。其推导过程如下所示

最小二乘法以估计值与观测值的差的平方和作为损失函数,极大似然法则是以最大化目标值的似然概率函数为目标函数,从概率统计的角度处理线性回归并在似然概率函数为高斯函数的假设下同最小二乘建立了的联系。

链接:https://www.zhihu.com/question/20447622/answer/209839263

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

大部分回答都是用线性回归问题来举例说明的。

其实,就算不是线性回归问题,只要我们认为观察到的数据  是由模型的真实输出

是由模型的真实输出  叠加上高斯噪声

叠加上高斯噪声 得到的,即:

那么对模型参数  的最大似然估计和最小二乘估计是等价的。

的最大似然估计和最小二乘估计是等价的。

-------------------简单的推导--------------------

我们知道,模型的似然函数是

同时,有 , 那么可以得到

因此,去掉后面两项不包含  的常数项,模型参数

的常数项,模型参数  的最大似然估计

的最大似然估计  ,就等价于最小二乘估计

,就等价于最小二乘估计  。

。

-----------------有关其他答案提到的ridge,lasso正则----------------

用机器学习的语言来统一描述各种不同的正则项,那就是通常在参数估计的时候要防止出现过拟合。

假设你只有1000个数据点,但是有2000个特征,那直接做线性回归最小二乘估计,可以得到无穷种回归系数的组合(线性方程组有2000个未知数,但是只有1000个方程)。根据奥卡姆剃刀原则,我们希望取最简单的那个模型,也就是回归系数距离原点最近的那组解。

但是距离的定义不同,最优解就不同。

如果是欧式距离,那么最优解就是L2正则下的最小二乘估计,或者是ridge回归:

如果是曼哈顿距离,那么最优解就是L1正则下的最小二乘估计,或者是lasso回归:

高票答主解释过了,ridge是高斯先验下的最大后验估计,而lasso是拉普拉斯先验下的最大后验估计。我们换一种几何方法来理解,更加直观。

对于ridge回归的目标函数,看起来特别像带限制条件的凸优化问题进行拉格朗日变换之后的结果。因此我们反向变回去,还原成带限制条件的凸优化问题,那么就是

且

且

同理,lasso回归可以变化为

且

且

那么画成几何图形,就是下面的左图(ridge)和右图(lasso)。

699

699

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?