在接触机器学习算法时,无法避免的就是理解模型训练的过程,即模型为什么能够从历史数据中学习到知识,其实学习的过程就是模型训练的过程,也是模型寻找参数最优解的过程。这个过程有两种求取方式,一种称为最小二乘法,另一种称为最大似然估计,而这两种概念及其容易混淆,尤其对初学者而言,搞不懂这两个概念,很容易从入门到放弃。我接触机器学习和深度学习也有几年了,并且一直从事相关工作,前后阅读相关书籍不下于10本,每本书都是用大量数学公式来解释这两种方法,越高约复杂,我也是直到最近才真正弄明白两者到底啥意思,为什么说是等价的,来看看我的理解。

首先看我用通俗人话,归纳的基本定义:

1、最小二乘法:使误差平法之和最小的参数,最接近真实模型;

2、最大似然估计:使历史数据分布出现概率最大的参数最应该出现,即最接近真实模型;

另外,再解释下概率和似然的定义:

3、概率:已知事件模型的参数,比如连续事件的概率密度函数,离散事件的概率质量函数,去推断事件发生的可能性,这种可能性称为概率;

4、似然:在不了解某件事件模型参数的情况下,通过已发生的历史事件或事实,来反推事件模型的参数,称为似然,得到最可能的参数,叫最大似然。

通过上面几个概念,很好理解最大似然估计,这不就是通过训练集训练模型,找到最适合参数的过程吗?最合适的参数是什么,就是使得既往事实发生概率最大的一组参数,怎么衡量一组参数让事实发生的概率呢?通常,分类模型我们会用交叉熵,回归模型我们会用均方差,实际上分类模型也能用均方差,比如著名的YOLO模型,在初版的时候损失函数全是均方差,所以简单点理解,可以用均方差来定义一组参数预测的结果与事实结果之间的差异。

最小二乘法的基本原理,和似然是一致的,都是从概率出发的,准确的说是从随机出发的,为嘛这么说呢,最小二乘法的基本假设是,事实结果是模型输出和随机干扰的叠加结果,如果想从事实中获取事件的真实模型,需要考虑滤掉干扰,而干扰是不可避免的,这一点可以参考卡尔曼滤波算法的原理,我们能做的就是尽量滤除干扰,但怎么衡量一组参数滤除干扰到达本质的能力呢,同样用到均方差,实际上最初是用绝对误差来衡量的,因为不可导,不好求取结果,等价为均方误差。

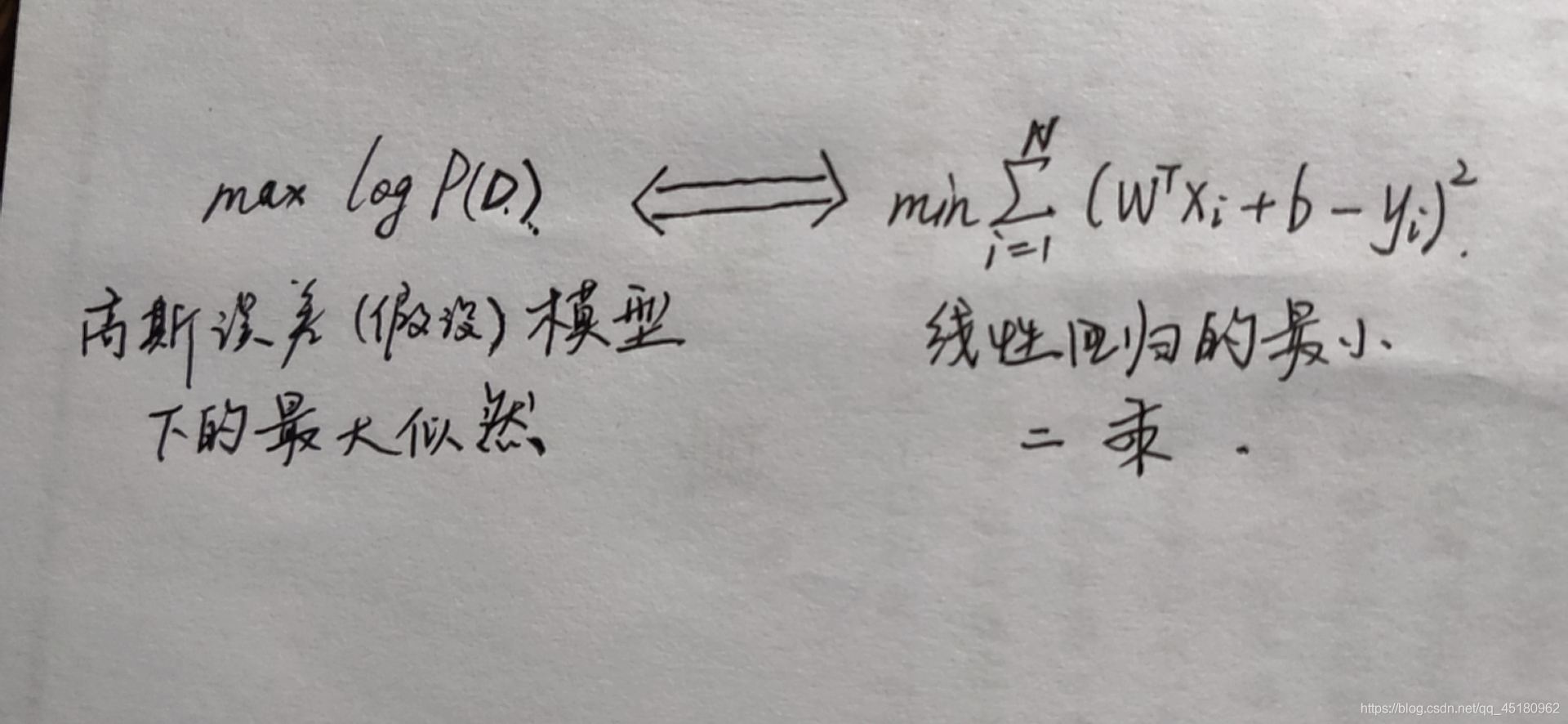

所以,你看,最小二乘法为什么和最大似然估计等价,一句话概括因为随机和概率的某种等价导致的,因为,人们尝试用某种确定的数学模型,来表达随机和概率事件,而表达的水平咋样,用到了等价的公式(有时候就是同一个),进而殊途同归。

1193

1193

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?