来源:清熙

一.大模型的推理能力

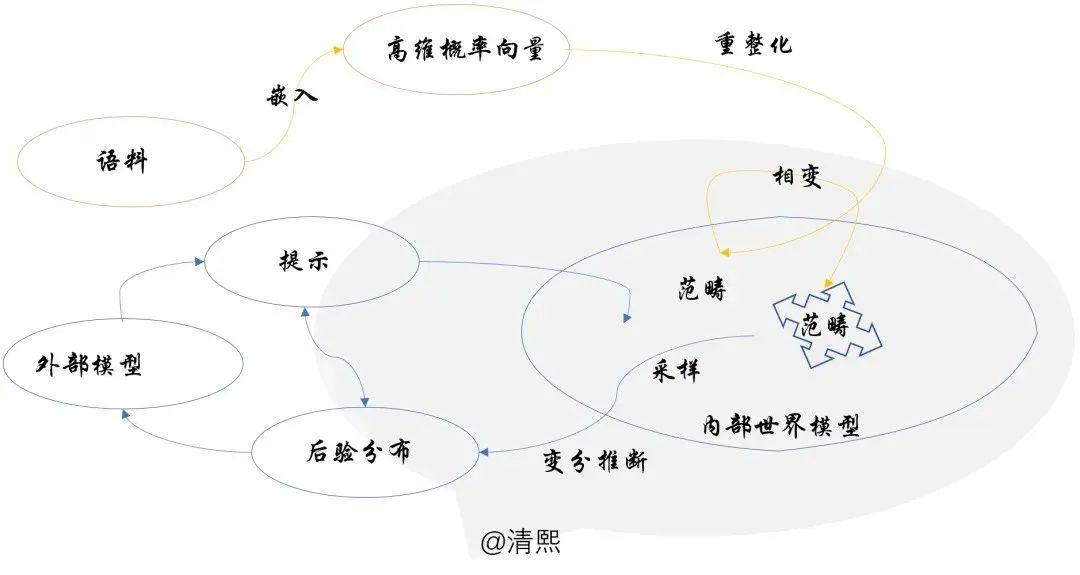

现在的大模型是茶壶里煮饺子,从预训练中学习了很多,但简单粗暴的采样推理的方式却限制了它的能力输出。

正如在降低大模型幻觉的必由之路一文中笔者建议的:大模型技术还在日新月异的发展,即使大模型永远不会停止幻觉, 在未来,专业系统会验证LLM输出,针对特定环境优化的人工智能工具将部分取代今天的通用模型。

其中最重要的改进方向就是,通过引导大模型学习人类特定的先验,更好地理解“范畴的结构和关系”,优化范畴内和跨范畴采样算法,将幻觉降低到“不可见”范围,尽管很难消除为零。

近期大模型行业的动向也印证了笔者这一判断。时代周刊全球百大AI人物& Cohere创始人接受采访时讲“AI模型还没有真正的问题解决能力,是因为训练语料里面很少有记录人类推理的过程。所以像Cohere, OpenAI 和Anthropic 等大模型领先的公司都在想尽办法搜集展示人类推理的数据”。

笔者去年年初在 ChatGPT是第一个真正意义的人工通用智能中阐释过,目前研究已经证明GPT对知识有强大的记忆能力。而增强GPT推理能力的方法:a) 提供提示语或提示样本 b) 预训练中引入代码样本。ChatGPT强大的推理能力,被认为大概率来自代码参与GPT3.5的预训练。

代码使用计算机语言,是设计完善的特殊语种,结构性强,长程关联,关系明确。可以用微语言结构的概率分布为基底,张成语言空间,程序就是该语言结构空间的点线面体。GPT 可以用自己构建的高维语言空间简单方便的学习代码。

二.释放大语言模型推理潜力

1.语言模型可以发展出自己对“现实的模拟”,并以此来提高其生成能力

MIT计算机科学和人工智能实验室(CSAIL)的学者近期分享了一个有趣的研究成果[文献1],声明语言模型可以发展出自己对“现实的模拟”,并以此来提高其生成能力。

笔者觉得学者们非常严谨的使用了“现实的模拟”的说法,而不是“世界模型”, 可能是觉得前者比后者更贴切,因为世界模型容易让人误解其无所不包。其实“世界模型”不是全世界的模拟,而是对真实世界的模拟。

在对超过100万个随机谜题进行训练后,他们发现该模型自发地发展了自己的底层模拟概念,尽管在训练过程中从未接触过这一现实。

这为我们提供了一个起点,让我们探索LLM是否真的能理解文本,现在我们看到它们的能力远远超过盲目地将单词拼接在一起。笔者发现很多“著名”的AI学者还在强调大模型是随机鹦鹉,他们可能已经很久不读Paper了。

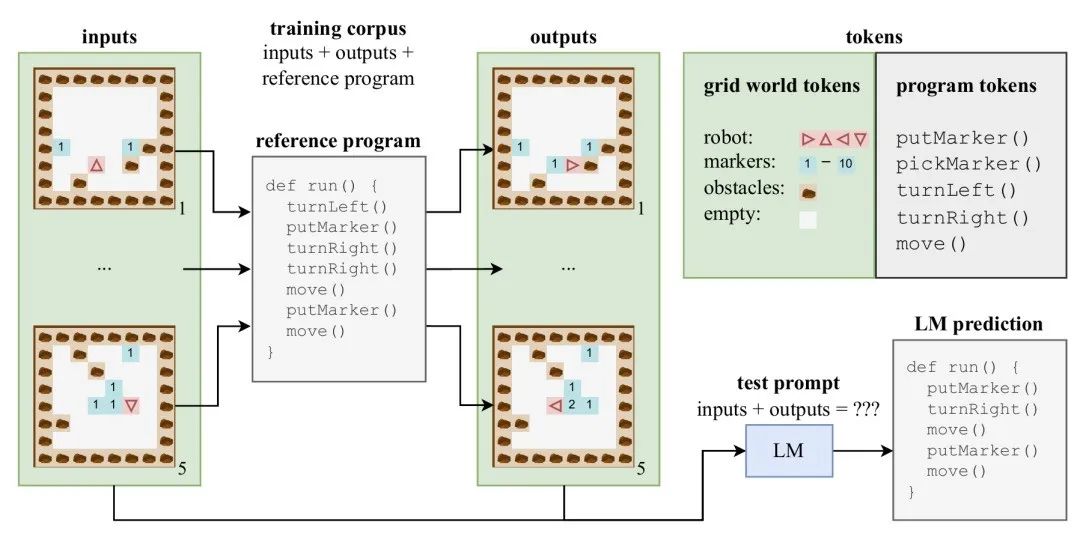

作者利用了这样一个事实,即计算机代码和自然语言一样,既有语法又有语义,但与自然语言不同的是,代码的语义可以直接被观察和操纵,用于实验目的。

实验设计是优雅的,他们的研究结果也是乐观的,表明了也许LLM能够更深入地了解语言的'含义'。

正如笔者在 ChatGPT是第一个真正意义的人工通用智能中所说的那样:代码是最好的展示人类思维推理过程的载体,这也是为什么经过了代码训练的大模型在推理能力上有了质的飞跃。

2. 大语言模型可以成为时间序列的零样本异常检测器

大语言模型能够执行各种任务,包括时间序列预测。这些模型的灵活性使它们可用于许多应用,这也是“通用”的本来意义。

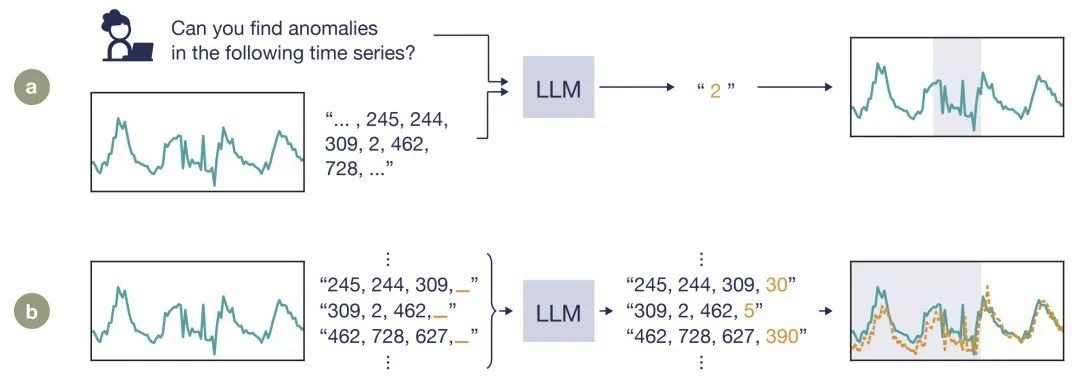

[文献2]做了一项关于大型语言模型的新研究,用于具有挑战性的时间序列异常检测任务。模型需要将输入序列的一部分(或多个部分)识别为异常;但是它需要处理时间序列数据而不是传统的文本输入。

作者设计了一个使用大语言模型直接进行时间序列异常检测的框架:包括一个时间序列到文本的转换模块,以及提示语言模型执行时间序列异常检测的端到端提示流水线。

通过对多个数据集使用多种方式的检测,作者发现虽然最先进的深度学习模型在性能上仍然更胜一筹,通过合理的运用大模型预测下一个token的生成方式,大语言模型在未经特殊训练或微调时,就能够直接发现时间序列中的异常。

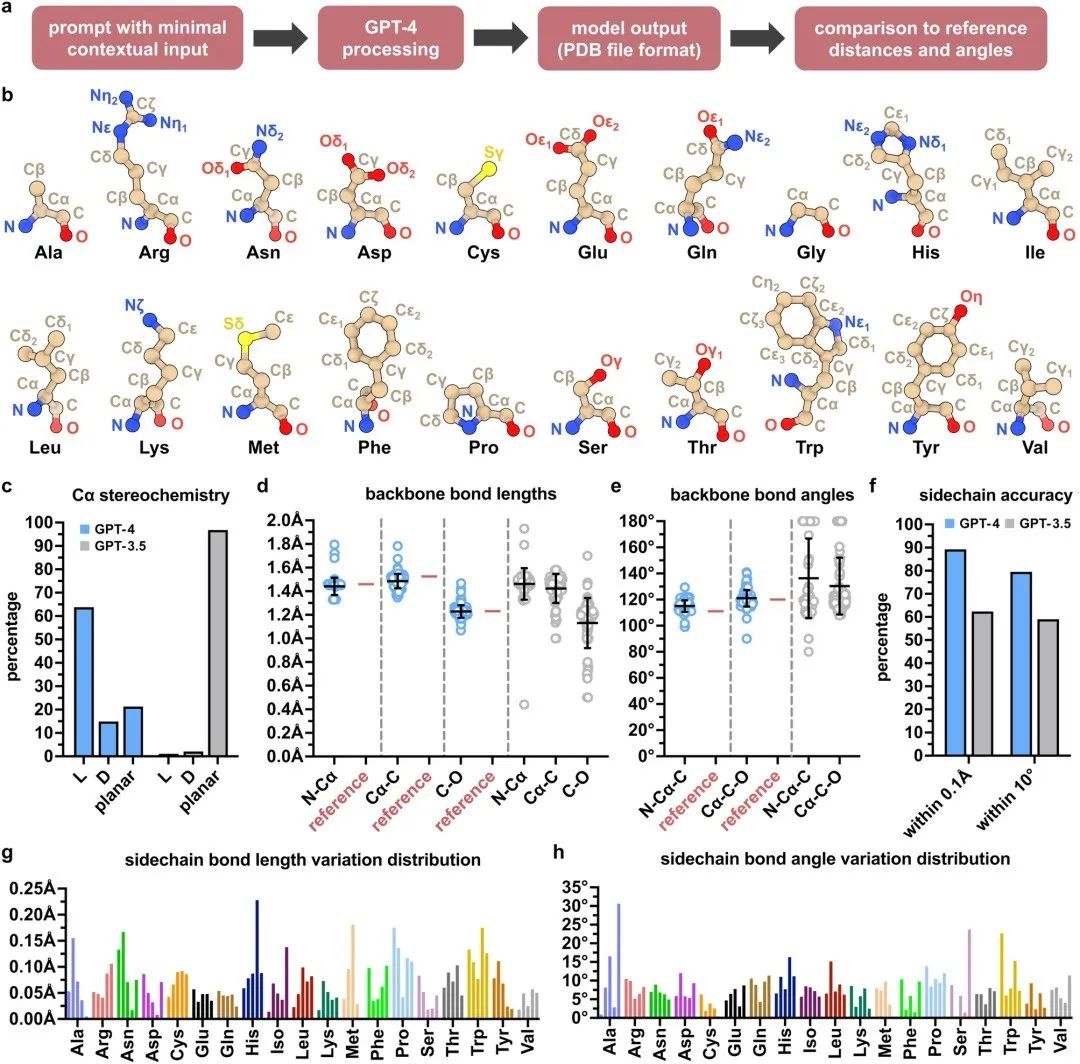

3.生成式人工智能还可以执行基本的结构生物学建模

基于自然语言的生成式人工智能 (AI) 在科学研究中也变得越来越普遍。有趣的是,GPT等大语言模型的能力实践上被证明已经超出自然语言任务范围。

[文献3]探讨了如何能够通过GPT4执行基本的结构生物学建模。作者用 GPT4 对 20 个标准氨基酸和一条α螺旋多肽链的 3D 结构进行了建模,后者还结合了 Wolfram 数学计算。另外还进行了抗病毒 nirmatrelvir 与其靶点 SARS-CoV-2 主要蛋白酶之间的结构相互作用分析。

交互分析揭示了GPT-能够识别参与配体结合的特定氨基酸残基以及相应的键距。尽管目前存在局限性,但文献展示出大语言模型目前具备了能够以原子级精度执行基本结构生物学建模和交互分析的能力。

三.使用数据因果模型进行探测

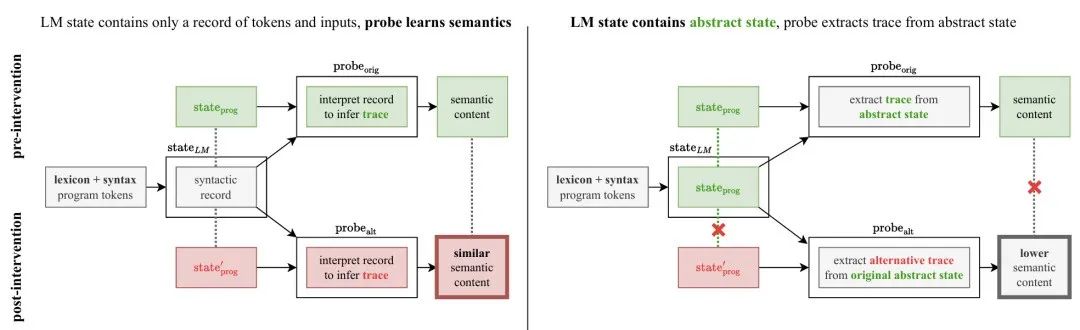

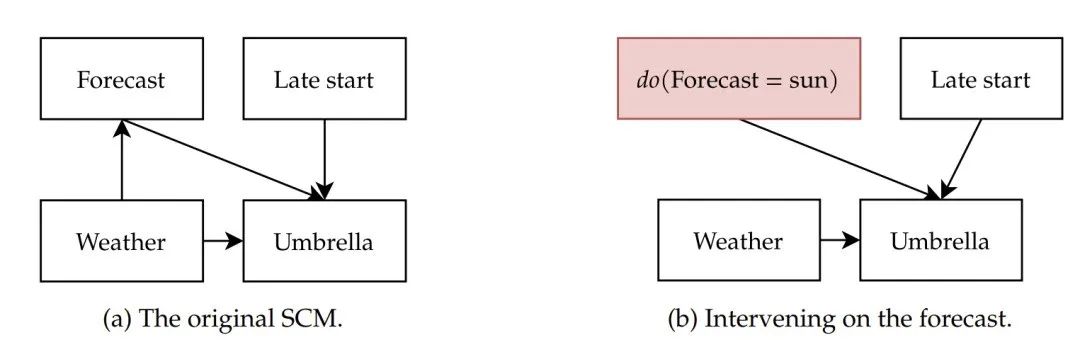

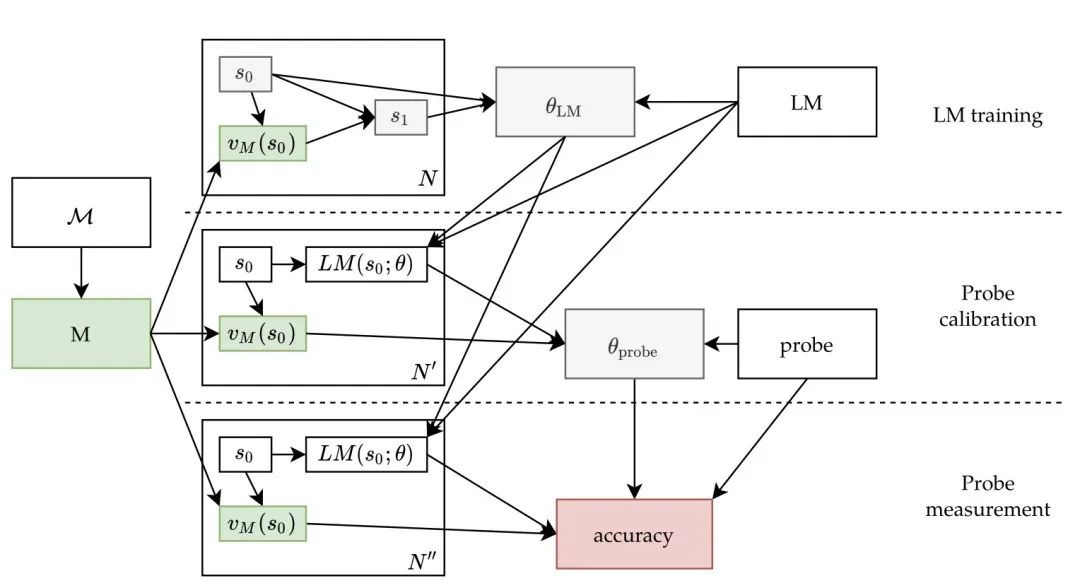

随着大语言模型 (LLM) 在一系列 NLP 任务上提供越来越高的性能,分类探测器已成为更好地理解其内部工作原理不可或缺的技术。

典型的设置包括 (1) 定义一个辅助任务,该任务由带有标签注释的文本数据集组成,然后 (2) 监督小型分类器在处理数据集时从预训练 LLM 的表征中预测标签。

高探测精度被解释为证据表明 LLM 已学会执行辅助任务,作为其原始预训练目标的无监督副产品。

[文献1]的学者们采用结构因果模型(SCM: Structure Causal Model)提出了一个正式的研究观点[文献4],称为:潜因果探测框架,从概念上讲,框架对模型的训练数据进行干预,并测量对语言模型内部表征的因果效应。

该框架为通过因果分析解释实验结果提供了强大的工具,特别是严格控制探针在学习辅助任务中的贡献。在实验上,学者们扩展了先前关于Transformer是否可以推断出一系列动作背后的中间状态的研究。

研究结果提供了强有力的经验证据,证明大语言模型可以从文本预训练中推导出潜在概念。

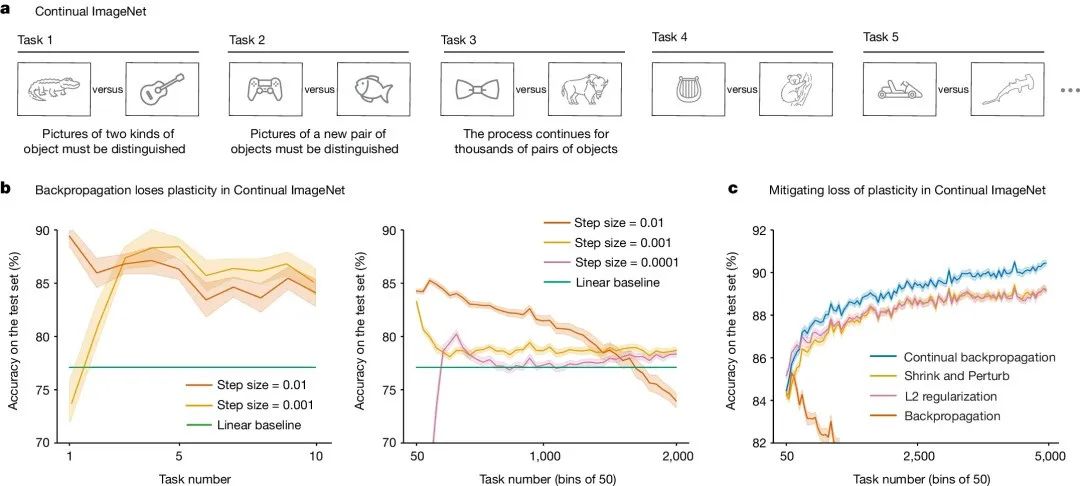

四.Nature:持续深度学习中的可塑性丧失

人的大脑就像是一块海绵,它能不断吸收新的信息,并作出改变为其腾出空间,这就是大家熟知的大脑的“可塑性”。

LLM 同样具有可塑性吗?OpenAI GPT-4o 开放了fine tune,而我们知道Fine tune 其实相当于增量训练,它总是有效的吗?有充足的计算资源的情况下,大语言模型的学习能力是无限的吗?

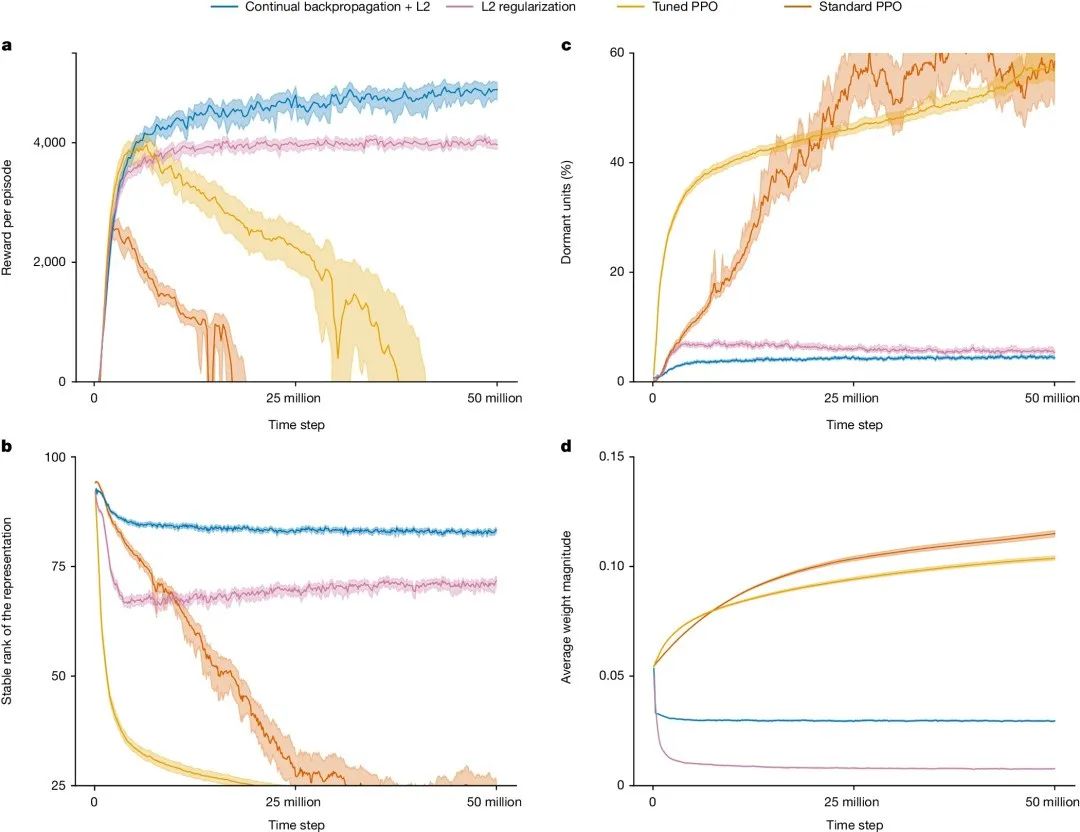

最近 Nature 自然杂志上发表了一篇来自艾伯塔大学的发现,基于深度学习的人工神经网络在对新数据进行长时间按顺序训练时会失去学习能力,即可塑性丧失[文献5],用笔者的话说就是梯度下降的边际效用递减。

学者们还为解决这个问题找到了可行方案 ——通过重置网络节点上已关联的权重。

我们知道,在人工神经网络中,权重被节点用作其强度的衡量标准——权重可以通过节点之间发送的信号来获得或失去强度,而这些信号又受到数学计算结果的影响。随着权重的增加,它所传达的信息的重要性也会增加。

研究人员建议,在训练会话之间重新初始化部分使用最少的单元的权重,并使用与初始化系统时相同的方法,能够使系统保持可塑性,并在额外的训练数据集上继续学习。学者称这个新算法为“连续反向传播”。

笔者觉得这个发现新颖有趣,其实符合学习过程的直觉。我们常说“温故而知新”,想要达到最佳的效果,温故前需要将“其中一小部分较少关注的前提不断且随机地重置”,可以更好的知新。这难道是因为重整化流中微扰带来了新的对称性破缺 ?

五.大语言模型的可解释性令人着迷

科学家们正在试图打开生成式人工智能的黑匣子并开始了解模型的内部工作原理。建议读者参考笔者的系列文章:大模型的数理认知框架。

重要性不言而喻。与使用一组规则对每个相同输入产生相同输出的计算机程序不同,GenAI 模型会在海量数据中找到模式,并为同一个输入产生多个可能的答案。

进一步的研究有可能帮助该领域开发更好的模型幻觉保护措施,并防范自主 AI 智能体的风险,例如欺骗或操纵。

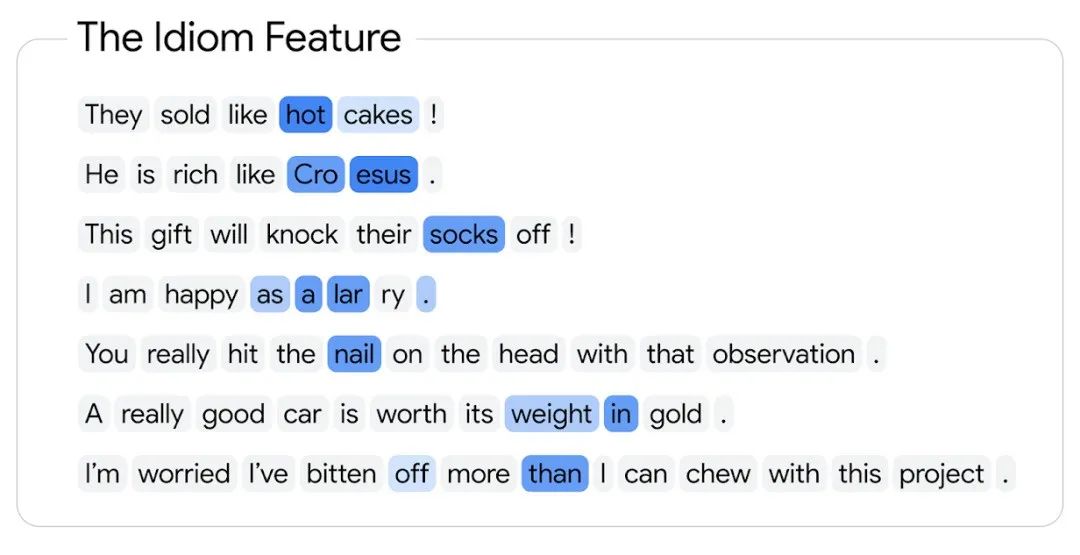

Anthropic的研究人员五月底曾宣布过该领域研究的重大突破——使我们能够更多地了解人工智能语言模型的内在工作原理。

OpenAI也做过类似研究,但两家的研究范围都受到很大限制。Google DeepMind 试图在其最近发布的 Gemma Scope 中解决这一限制,该工具可以查看他们的 Gemma 2模型版本的所有层,涵盖三千万个特征。

Gemma Scope 是数百个免费开放稀疏自动编码器 (SAE) 的集合,适用于Gemma 2 9B和Gemma 2 2B。

到目前为止,可解释性社区在理解具有稀疏自动编码器的小型模型和开发相关技术(如因果干预、自动电路分析、特征解释和评估、稀疏自动编码器)方面取得了巨大进展。

新的工具可以帮助分析更复杂的功能(如CoT思路链),并找到可解释性的实际应用,例如解决只有在较大模型中才会出现的幻觉和越狱等等问题。

总之,我们应避免将算法的学习能力与其生成信息的能力相混淆, 想尽办法搜集展示人类推理的数据(比如良好注释的代码),通过引导大模型学习人类特定的先验,更好地理解“范畴的结构和关系”,优化范畴内和跨范畴采样算法,提升大模型的推理生成能力,降低幻觉,从而在严谨性准确性要求较高的场景下尽早可以造福人类。

[文献1] Emergent Representations of Program Semantics in Language Models Trained on Programs https://arxiv.org/pdf/2305.11169

[文献2] Large language models can be zero-shot anomaly detectors for time series? https://arxiv.org/abs/2405.14755

[文献3] Generative artificial intelligence performs rudimentary structural biology modeling https://www.nature.com/articles/s41598-024-69021-2

[文献4] Latent Causal Probing: A Formal Perspective on Probing with Causal Models of Data https://arxiv.org/abs/2407.13765

[文献5]Loss of plasticity in deep continual learning

https://www.nature.com/articles/s41586-024-07711-7

[文献6] Gemma Scope: Open Sparse Autoencoders Everywhere All At Once on Gemma 2 https://storage.googleapis.com/gemma-scope/gemma-scope-report.pdf

未来智能实验室的主要工作包括:建立AI智能系统智商评测体系,开展世界人工智能智商评测;开展互联网(城市)大脑研究计划,构建互联网(城市)大脑技术和企业图谱,为提升企业,行业与城市的智能水平服务。每日推荐范围未来科技发展趋势的学习型文章。目前线上平台已收藏上千篇精华前沿科技文章和报告。

如果您对实验室的研究感兴趣,欢迎加入未来智能实验室线上平台。扫描以下二维码或点击本文左下角“阅读原文”

4734

4734

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?