自2022年11月ChatGPT发布以来,生成式大模型在全球范围内引发了广泛关注。这类模型基于深度学习技术,通过海量参数和复杂结构实现文本、图像等数据的生成,推动了自然语言处理和计算机视觉等领域的技术进步。随着其应用的不断扩展,潜在的安全风险也逐渐凸显,如隐私泄露、数据偏见、虚假信息传播等问题,对技术的安全性、合规性及社会影响提出了严峻挑战。

(方便大家直接下载,这里给大家整理好了书籍的PDF,扫码即可↓↓↓↓)

Tips 以上为节选,报告全文下载见文末

【报告要点】:

本文是一份关于生成式大模型安全评估的白皮书,由智能算法安全重点实验室(中国科学院)、公安部第三研究所和蚂蚁安全实验室联合编写。白皮书全面梳理了生成式大模型的发展现状、安全风险、安全评估方法以及实践案例分析,并对未来的发展方向提出了展望。以下是对白皮书核心内容的详细梳理:

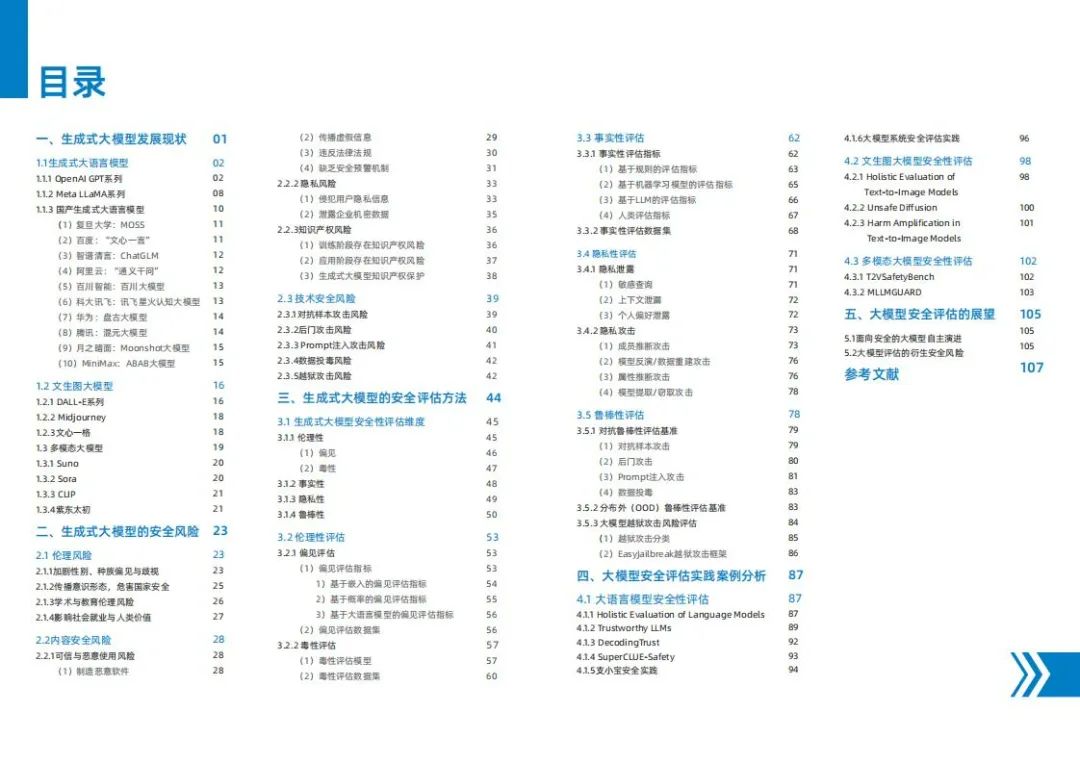

一、生成式大模型发展现状

1.1 生成式大语言模型

-

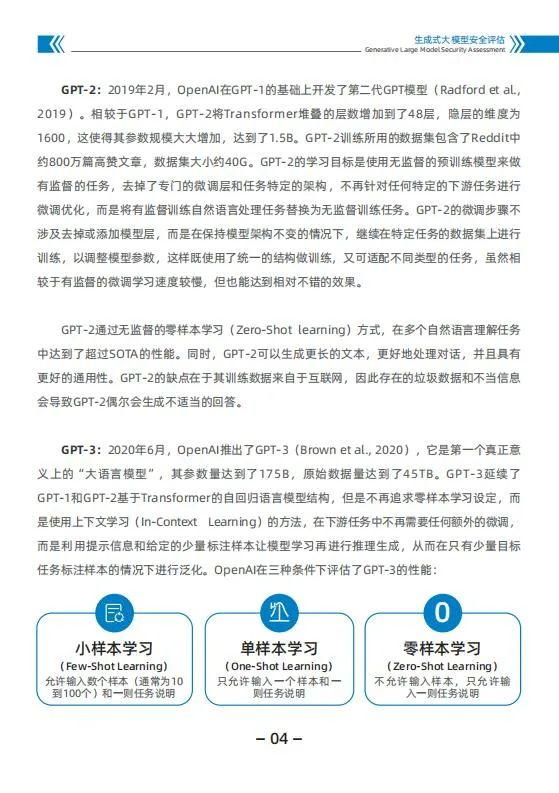

OpenAI GPT系列:从GPT-1到GPT-4,参数规模和性能不断提升,GPT-4新增图像处理能力,安全性与可靠性显著增强。

-

国产大语言模型:包括百度的“文心一言”、阿里的“通义千问”、科大讯飞的“讯飞星火”等,展现出强大的技术实力和商业化潜力。

-

其他大语言模型:如Meta的LLaMA系列、MiniMax的ABAB大模型等,各有特色和优势。

1.2 文生图大模型

-

DALL-E系列:通过文本描述生成高质量图像,DALL-E3在提示词遵循能力和图像质量上显著提升。

-

Midjourney:快速生成AI绘画,结合前沿技术实现高效创作。

-

文心一格:百度推出的中文文生图模型,优化了文本和图像之间的语义对齐。

1.3 多模态大模型

-

Sora:OpenAI发布的文生视频模型,能够根据文本提示生成复杂场景的动态模拟。

-

CLIP:通过图像和文本的联合嵌入,在跨模态匹配与零样本任务中表现出色。

-

紫东太初:中国首个多模态预训练模型,支持多模态生成并扩展到视频和3D点云。

二、生成式大模型的安全风险

2.1 伦理风险

-

加剧性别、种族偏见与歧视:模型可能内化并传播训练数据中的刻板印象和偏见。

-

传播意识形态,危害国家安全:模型可能被用于传播特定政治立场或意识形态。

-

学术与教育伦理风险:可能导致学术作弊、教育不公平等问题。

-

影响社会就业与人类价值:可能导致工作岗位减少,加剧社会分化。

2.2 内容安全风险

-

可信与恶意使用风险:模型可能被用于制造恶意软件、传播虚假信息、违反法律法规。

-

隐私风险:模型可能泄露用户隐私信息或企业机密数据。

-

知识产权风险:模型训练和应用过程中可能涉及版权、商标权或专利权的侵权。

2.3 技术安全风险

-

对抗样本攻击风险:通过微小扰动诱导模型输出错误结果。

-

后门攻击风险:模型可能被植入后门,特定输入下触发有害输出。

-

Prompt注入攻击风险:通过复杂提示引导模型生成危险内容。

-

数据投毒风险:污染训练数据,干扰模型输出。

-

越狱攻击风险:通过特定提示词绕过模型限制,输出错误或非法内容。

三、生成式大模型的安全评估方法

3.1 生成式大模型安全性评估维度

-

伦理性:评估模型是否存在偏见、毒性等问题。

-

事实性:评估模型生成内容是否符合事实。

-

隐私性:评估模型是否泄露隐私信息。

-

鲁棒性:评估模型在面对对抗攻击和分布外数据时的稳定性。

3.2 伦理性评估

-

偏见评估:使用基于嵌入、概率和生成文本的评估指标。

-

毒性评估:使用机器学习模型和毒性评估数据集。

3.3 事实性评估

-

评估指标:包括基于规则、机器学习模型、LLM和人类评估的指标。

-

评估数据集:如MMLU、TruthfulQA等。

3.4 隐私性评估

-

隐私泄露:评估模型是否泄露敏感信息。

-

隐私攻击:评估模型对成员推断、模型反演等攻击的防御能力。

3.5 鲁棒性评估

-

对抗鲁棒性:评估模型对对抗样本攻击的抵抗力。

-

分布外鲁棒性:评估模型在面对分布外数据时的表现。

-

越狱攻击风险:评估模型对越狱攻击的防御能力。

四、大模型安全评估实践案例分析

4.1 大语言模型安全性评估

-

HELM:斯坦福大学提出的语言模型整体评估基准,涵盖多个场景和指标。

-

Trustworthy LLMs:字节跳动提出的评估大语言模型可信度的框架。

-

DecodingTrust:伊利诺伊大学香槟分校和斯坦福大学提出的可信度评估框架。

-

SuperCLUE-Safety:CLUE团队提出的中文大语言模型安全基准测试。

-

支小宝安全实践:蚂蚁集团开发的应用程序,注重金融和医疗领域的安全性。

4.2 文生图大模型安全性评估

-

HEIM:斯坦福大学提出的文生图模型整体评估基准。

-

Unsafe Diffusion:研究文生图模型生成不安全图像的风险。

-

Harm Amplification:量化和评估文生图模型中的伤害放大现象。

4.3 多模态大模型安全性评估

-

T2VSafetyBench:评估文生视频模型的安全性。

-

MLLMGUARD:评估多模态大模型安全性的多维度评估套件。

五、大模型安全评估的展望

5.1 面向安全的大模型自主演进

-

构建贯穿模型全生命周期的安全框架,强调自动化监控与预警系统的集成。

-

提升模型的自我诊断与修复能力,增强动态风险评估和适应性。

5.2 大模型评估的衍生安全风险

- 评估过程中可能引发的隐私泄露和对抗性攻击风险,需要建立严格的安全机制。

白皮书强调了生成式大模型在推动人工智能技术发展的同时,也带来了诸多安全挑战。通过系统化的安全评估框架和实践案例分析,白皮书为学术研究、产业实践和政策制定提供了重要参考,旨在推动生成式大模型技术向安全、可信、可持续的方向发展。

(方便大家直接下载,这里给大家整理好了书籍的PDF,扫码即可↓↓↓↓)

1222

1222

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?