点击下方卡片,关注“3D视觉之心”公众号

第一时间获取3D视觉干货

>>点击进入→3D视觉之心技术交流群

分治策略还不够

大规模场景的高保真实时新颖视角合成在自动驾驶、虚拟现实、遥感摄影测量和具身智能等众多应用中至关重要。近年来,主流的新颖视角合成方法主要分为两类:基于神经辐射场(NeRF)的方法和基于高斯泼溅(Gaussian Splatting)的技术。

神经辐射场(NeRF)通过隐式表示实现高保真渲染,并已扩展至大规模场景重建任务。尽管Block-NeRF成功重建了旧金山街区的超大规模场景,但其基于MLP网络的最小单元表示缺乏灵活性,且渲染速度较慢。相比之下,3D高斯泼溅(3DGS)凭借显式点云场景表示和快速渲染速度,展现出更大的潜力,尤其适用于大规模场景。

受限于硬件显存资源,分治策略已成为大规模场景新颖视角合成的主流方法。通过将场景划分为子区域,多GPU并行显著提升了重建速度。该策略包含三个关键阶段:场景划分、独立块优化和块重建结果融合。这些阶段具有严格的顺序依赖性,后续阶段的输入完全依赖于前一阶段的输出,最终重建质量取决于每个阶段的有效性。尽管现有研究已建立基线方法,但这些步骤仍面临挑战,包括:

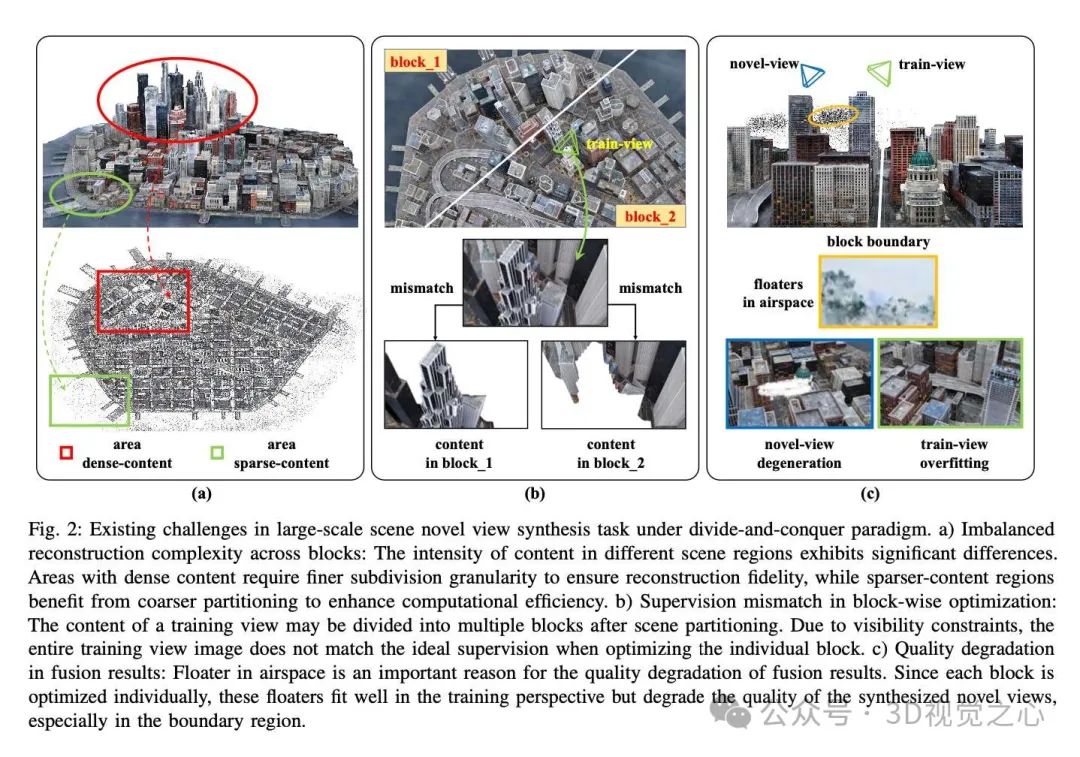

块间重建复杂度不均衡:不合理的场景划分会降低大规模场景重建效率,尤其是在多GPU设备上。如图2(a)所示,均匀网格划分忽略了不同区域的内容差异。划分时需考虑两个关键因素:

VastGaussian提出基于相机位置的渐进式数据划分策略,DOGS改进为递归方法以平衡块间计算负载。然而,基于相机位置的划分受限于视角空间分布,难以推广至更复杂的场景。CityGaussian先训练粗粒度高斯模型作为场景先验来划分网格,但该方法依赖预训练粗模型,未能完全解耦场景规模与优化过程。

块划分的粒度:需关注不同区域的复杂度,对高兴趣或高复杂度区域采用更细粒度划分。

计算负载均衡:确保各块计算负载均衡,减少多GPU训练时间。

块优化中的监督失配:导致块内伪影,降低重建质量。NeRF/高斯泼溅的端到端优化通过比较渲染图像与真实图像构建目标函数,但在分治策略下,缺乏全局场景表示会导致块优化的可见性问题。如图2(b)所示,训练视图的内容可能分布在多个块中,单个块仅对应图像部分区域。在优化当前块时,渲染图像与训练视图的损失计算存在失配,原因包括:

噪声监督会混淆高斯参数的梯度,导致重建质量下降。

当前块渲染忽略了块间遮挡关系;

未优化块表示难以计算准确边界。

无缝场景融合避免质量退化:独立块优化因缺乏精确几何监督,易在空域产生漂浮物(floaters),导致融合后渲染质量下降。如图2(c)所示,空域漂浮物可能在训练视角下拟合良好,但在新视角(尤其是块边界)会引发伪影。因此,充分的空域监督对训练至关重要。VastGaussian尝试通过增加训练视图和空域感知的可见性计算来缓解该问题,但其方法存在局限:忽略块间遮挡关系,且额外视角可能引入无关区域,导致视角选择与有效监督之间的矛盾。

为解决上述挑战,本文介绍的BlockGaussian[1],一种新的大规模新颖视角合成框架:

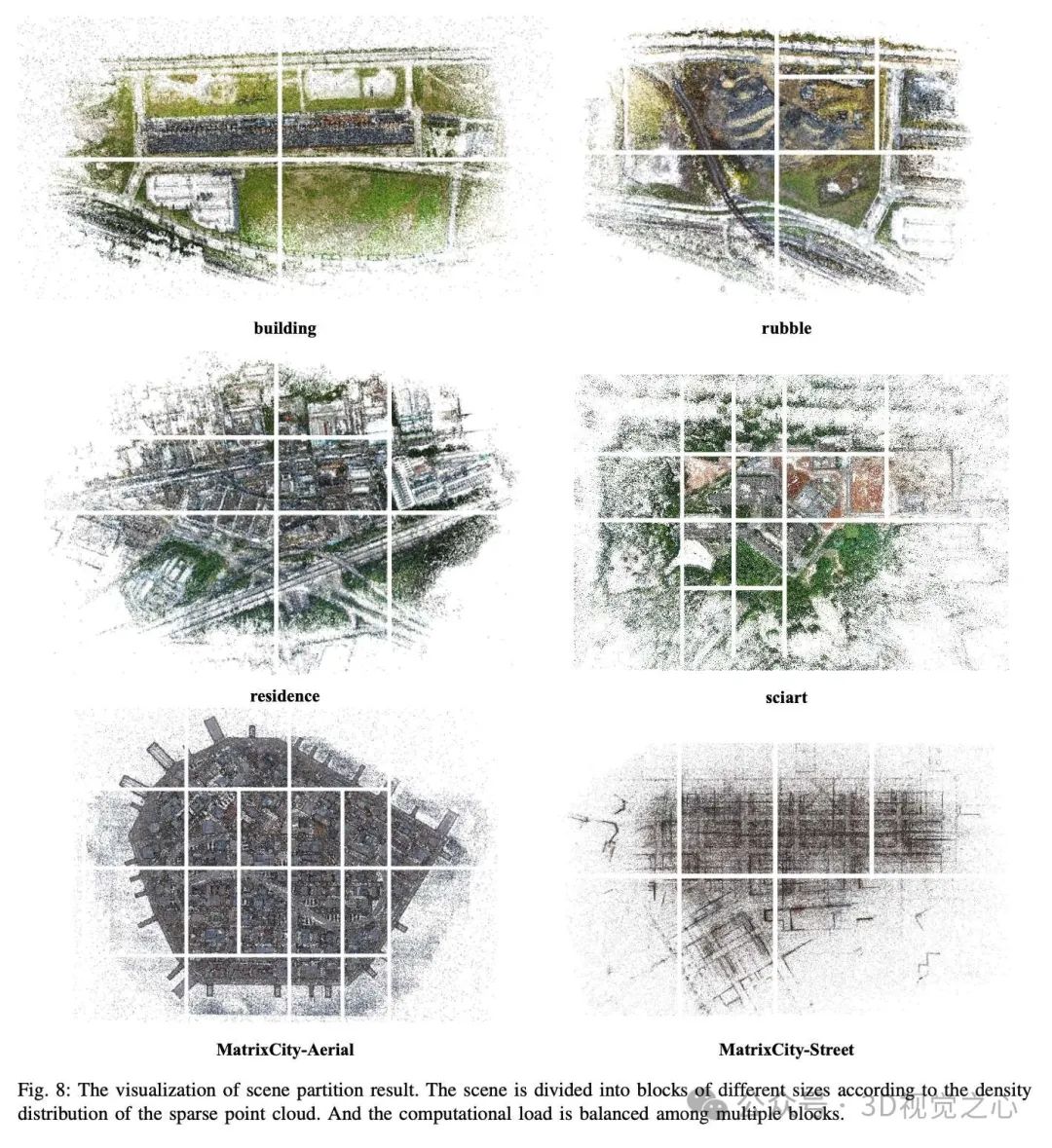

内容感知场景划分:基于运动恢复结构(SfM)输出的稀疏点云动态精细划分场景,同时均衡多块计算负载;

可见性感知块优化:引入辅助点云表示训练视图的不可见区域,缓解监督失配问题;

伪视图几何约束:通过扰动训练相机位姿生成伪视图,利用渲染深度图从原始视角扭曲真实图像,计算伪视图的损失,从而在不引入额外区域的情况下监督空域,显著提升块融合质量(尤其是交互式渲染)。

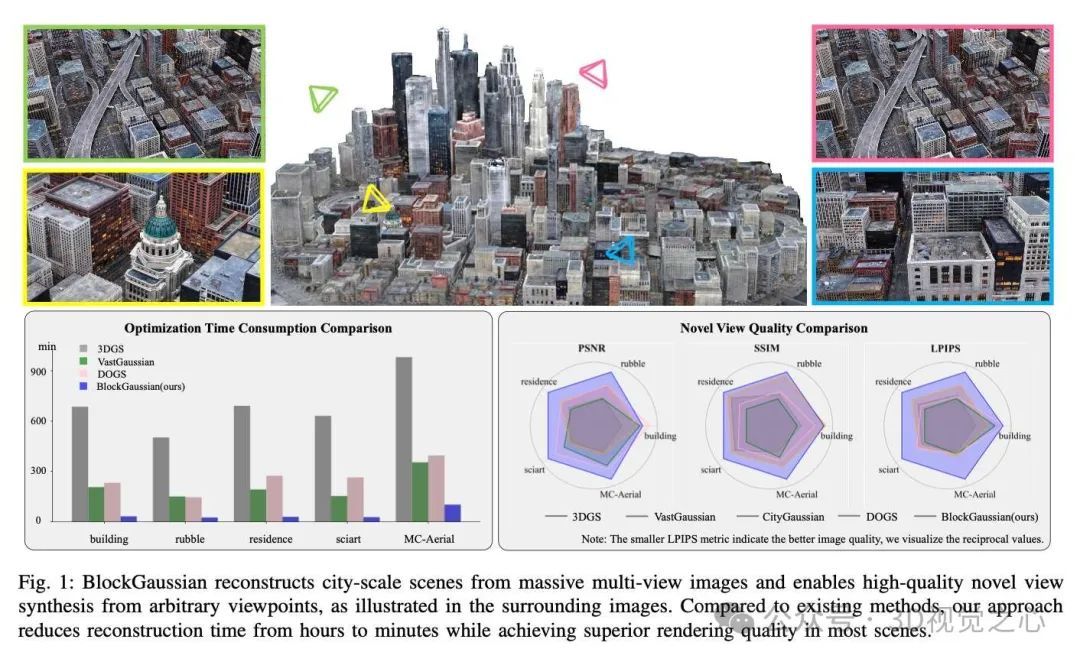

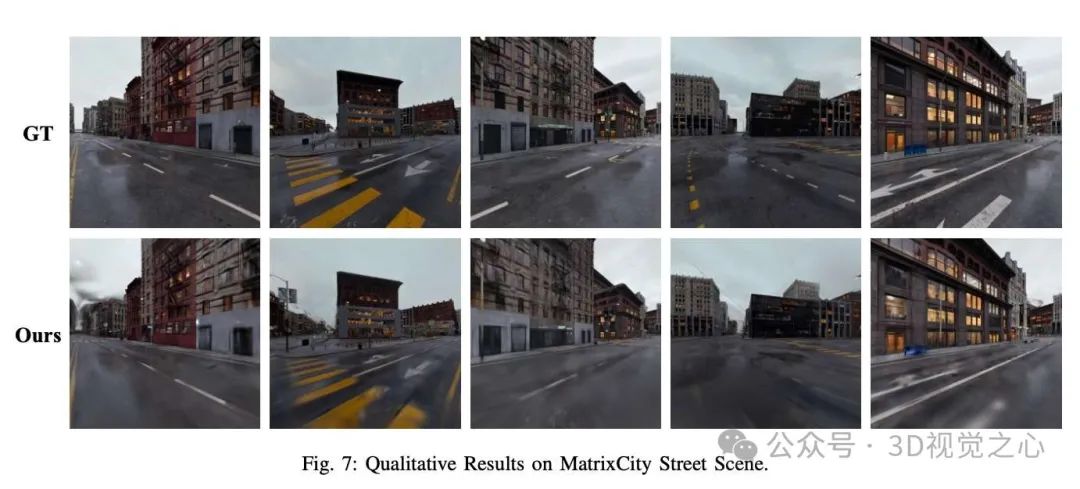

实验表明,BlockGaussian有效解决了大规模场景重建的挑战。如图1所示,在重建质量和速度上均达到最先进水平(SOTA),优化速度提升5倍,平均PSNR提高1.21 dB。在硬件需求方面,BlockGaussian可在单块24GB显存GPU上顺序执行,或跨多GPU并行运行,且在航拍和街景场景中均表现优异。

项目链接:https://github.com/SunshineWYC/BlockGaussian

主要贡献:

提出基于空间划分的大规模场景新颖视角合成框架BlockGaussian,动态平衡块划分粒度与计算负载;

重构单块训练流程,通过引入辅助点云解决渲染图像与监督视图的失配问题;

提出伪视图几何约束,有效抑制块融合时的空域漂浮物,确保无缝高质量融合。

具体方法

大规模场景重建面临数据量大、覆盖范围广的挑战。我们采用与先前工作类似的分治策略,方法流程如图3所示。给定采集的图像集合,首先通过运动恢复结构(SfM)计算各视角的相机位姿和稀疏点云。随后通过内容感知场景划分模块迭代划分场景块并为每个块分配监督视图。各分块在可见性感知块优化下独立训练,期间采用伪视图几何约束提供空域监督。最终通过无缝融合所有分块,得到完整场景表示。

内容感知场景划分

场景划分与视图分配是大规模重建的关键步骤。划分时需权衡分块粒度与并行优化速度:更高的分块粒度能提升重建质量,但会降低重建速度;反之则减少时间成本但损失重建精度。因此划分过程需满足两个目标:

基于场景复杂度的自适应划分:根据空间结构复杂度采用不同划分粒度;

计算负载均衡:确保各分块计算负载均衡,这对多GPU场景重建的耗时最小化至关重要。

场景稀疏点云的密度分布可反映内容复杂度。基于此假设,我们采用递归方式划分场景:给定场景稀疏点云 ,基于曼哈顿世界假设估计地面法向并与y轴对齐。将点云投影至x-z平面后,手动定义边界矩形作为重建感兴趣区域(RoI)。随后采用二叉树结构对RoI进行递归划分:给定二叉树最大深度 和叶节点最大点数 ,以场景RoI作为根节点递归分割。若当前节点深度$dN_b^t$,则沿分块最长边二分生成子节点,否则终止划分。迭代执行直至所有节点满足终止条件,实现空间自适应的场景划分。

视图分配过程为每个分块选择合适的监督视图。根据SfM结果获取各训练视图的可见关键点数量 ,统计分块边界内点数 。选择比例 超过阈值(0.3)的视图作为当前分块的监督视图。具体流程见算法1。

可见性感知块优化

通过精心设计的场景划分策略,各分块优化完全独立,可在多GPU上并行训练。对于单个分块优化,块内高斯基元记为 (称为块高斯),关联监督视图为 ,对应相机位姿为 。仅基于当前块高斯渲染图像 时,往往无法覆盖训练视图全区域,导致与真值图像 的损失计算存在错误监督。为此引入辅助高斯基元 (称为辅助高斯)建模当前块在监督视图中的不可见区域。此时渲染过程表示为:

块高斯初始化遵循原始3D高斯泼溅方法:位于分块空间边界内的点初始化为 。辅助高斯 从当前块监督视图关联但位于块外的稀疏点云初始化。

各视图的光度损失与3DGS相同(见第III节)。同时采用深度先验:通过DepthAnythingV2估计深度图 ,与渲染深度 在尺度对齐后计算逆空间绝对误差:

给定分块的 个监督视图,优化目标函数为:

由于辅助高斯 存在监督不足问题,直接应用3DGS优化范式会导致其退化,进而影响 优化。为此引入小批量优化策略增强稳定性:积累多个训练视图的梯度更新 属性。致密化过程仅对块内高斯点操作,有效减少优化冗余。

伪视图几何约束

如VastGaussian所述,空域监督对端到端优化至关重要。我们观察到空域漂浮物会导致分块融合后渲染质量下降。为此提出伪视图几何约束损失,在不引入额外视图的情况下有效监督空域。

具体流程如图4所示。对于参考视图(ref-view)相机参数 及其渲染深度 ,在视差空间扰动ref-view位姿生成伪视图相机位姿。给定水平视差扰动超参数 ,位置扰动 计算为:

其中 为深度中值, 为ref-view相机x轴焦距。伪视图相机参数为:

基于伪视图渲染深度 ,将伪视图渲染图像 变换至ref-view视角。对于伪视图图像像素 ,其深度值 用于计算其在ref-view的投影位置。首先通过下式恢复伪视图相机空间坐标:

随后将坐标转换至世界坐标系:

最终通过ref-view相机外参转换至其相机空间:

经相机内参变换得到ref-view图像空间坐标:

逐像素映射得到变形图像 及其有效掩码 ,伪视图几何损失为:

该约束通过间接监督渲染深度,有效消除空域漂浮物。

场景融合与渲染

完成所有分块优化后,融合各块重建结果得到完整场景表示。得益于精心设计的块优化过程和伪视图几何约束,裁剪辅助高斯 后即可直接融合场景。渲染新视角时,BlockGaussian采用与原始3D高斯泼溅相同的可微渲染管线:给定目标相机位姿和 intrinsics 参数,由所有分块高斯基元构成的场景表示被投影至像平面,按深度排序进行alpha混合合成视图(公式1)。

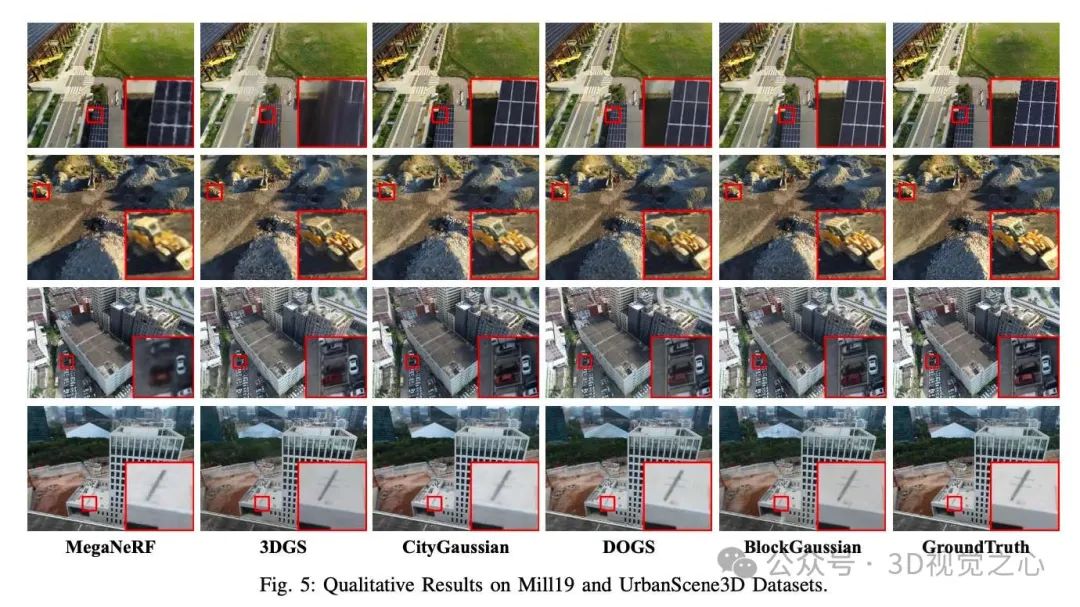

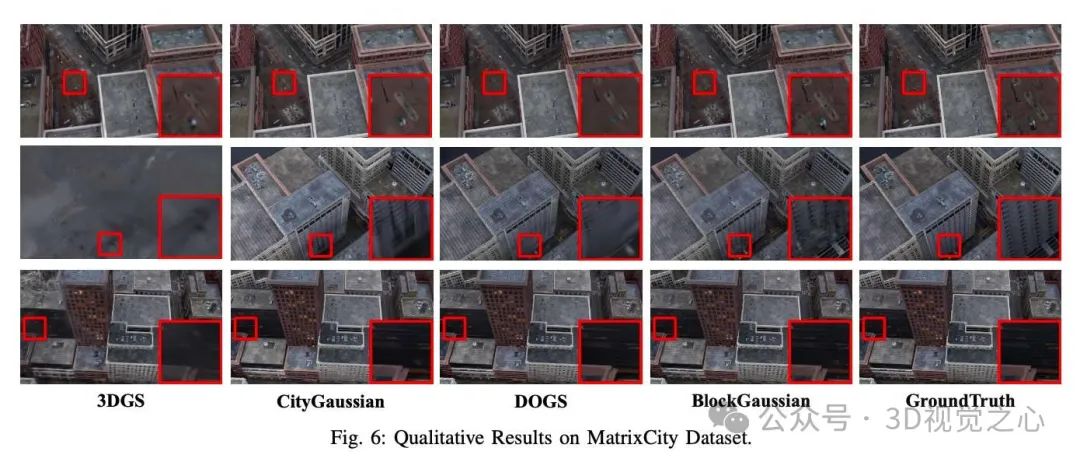

实验效果

总结一下

BlockGaussian框架是用于大规模场景的新颖视角合成。通过内容感知的场景划分策略,在考虑场景内容复杂度的同时平衡各分块的计算负载分布;可见性感知的块优化方法通过引入辅助点云解决分块重建时监督视图的不可见区域匹配问题;伪视图几何约束有效抑制空域漂浮物的生成,提升交互式渲染质量。值得注意的是,本算法可在单GPU上顺序执行或在多GPU上并行运行。BlockGaussian在多个大规模场景数据集上实现了最先进的视角合成质量。

未来工作:将进一步探索高斯表示的效率优化及动态场景地图加载的交互式渲染。

参考

[1] BlockGaussian: Efficient Large-Scale Scene Novel View Synthesis via Adaptive Block-Based Gaussian Splatting

本文仅做学术分享,论文汇总于『3D视觉之心知识星球』,欢迎加入交流!

【3D视觉之心】技术交流群

3D视觉之心是面向3D视觉感知方向相关的交流社区,由业内顶尖的3D视觉团队创办!聚焦三维重建、Nerf、点云处理、视觉SLAM、激光SLAM、多传感器标定、多传感器融合、深度估计、摄影几何、求职交流等方向。扫码添加小助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

扫码添加小助理进群

【3D视觉之心】知识星球

3D视觉之心知识星球主打3D感知全技术栈学习,星球内部形成了视觉/激光/多传感器融合SLAM、传感器标定、点云处理与重建、视觉三维重建、NeRF与Gaussian Splatting、结构光、工业视觉、高精地图等近15个全栈学习路线,每天分享干货、代码与论文,星球内嘉宾日常答疑解惑,交流工作与职场问题。

382

382

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?