首先对ReLU进行了改进,使用了参数化的ReLU自适应学习rectifier的参数提升准确率,即PReLU来拟合模型,另外使用了鲁棒的初始化方法考虑rectifier的非线性特性,使得深层网络能够收敛。top-5error 为4.94%,在ILSVRC上首次超越了人眼(感觉这么说还是很牵强的,后面也进行了解释)。

过去几年深度学习的主要关注在构建有效的模型和设计应对过拟合的策略上,通过增加网络复杂度,宽度,小步长,非线性激活和复杂的层设计,网络拟合数据的能力越来越强;另外通过数据增强和大规模数据库的使用使得网络泛化能力得到增强。

方法描述:分别介绍了PReLU,深层rectifier网络的初始化方法以及网络结构。

1. PReLU激活函数如下定义:

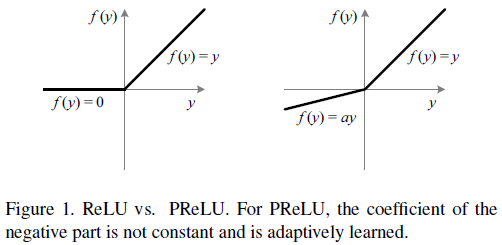

其中 ai 是控制函数负半部分的斜率, ai=0 时即为ReLU,下图为ReLU和PReLU的区别:

如果 ai 是一个比较固定的较小的值,PReLU就成了 leaky ReLU

优化:PReLU使用后向传播训练, ai 用链式法则求导并用动量方法更新。通过对比实验,PReLU的top-1 error比ReLU有1.2%的提升,第一个卷积层具有较大的系数 ai ,第一层是类似Gabor的滤波器比如边缘和纹理,这说明滤波器的正负响应都很重要。深层的网络系数逐渐降低,说明网路在低层关注信息的完整性而在高层学习分辨性能。

2.初始化滤波器权值

提出来一种更合理的初始化方法解决深层网络,如VGG的收敛问题,并于“Xavier”进行了对比。

A.前向传播情况

核心思想是分析每层响应的方差,对于卷积层,它的响应是 yl=Wlxl+bl ,假设 Wl 和 xk 相互独立,则:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

426

426

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?