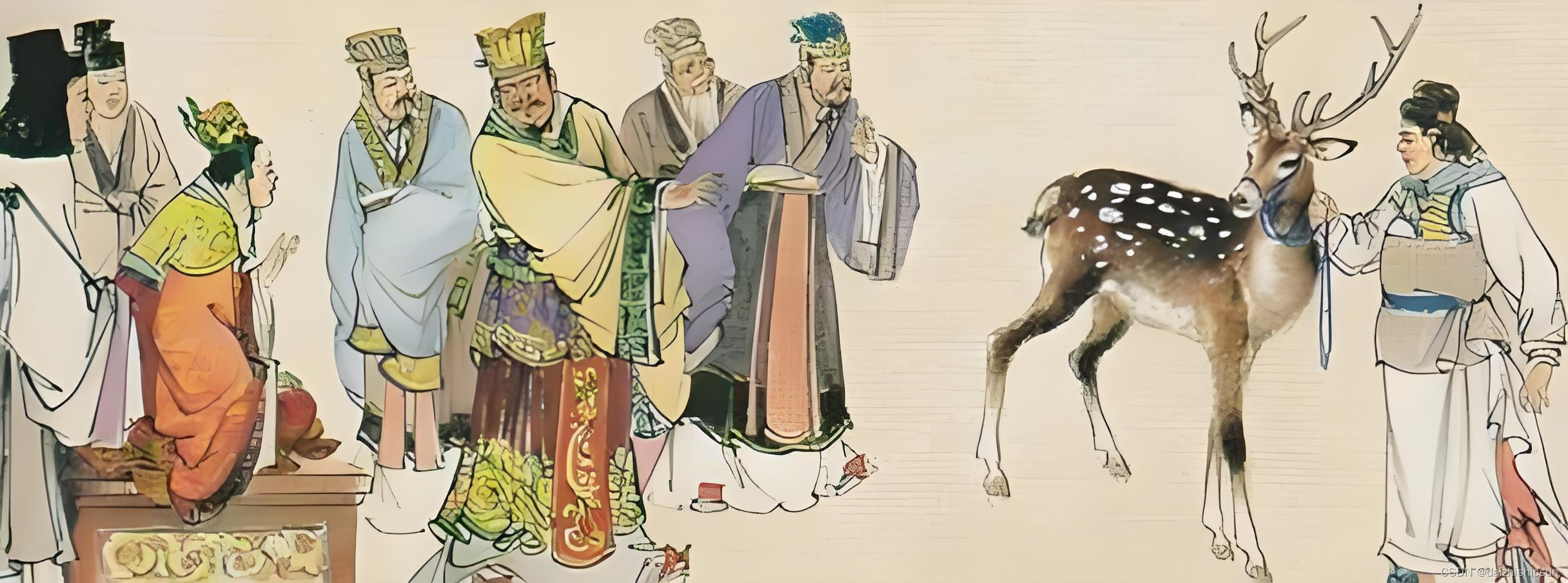

“指鹿为马”的故事家喻户晓。秦末赵高为测试大臣的忠诚,故意将鹿说成是马,许多大臣屈于赵高的淫威,都附和说这是马,也有少数不甘心屈从的大臣,结果被赵高杀害。人在面临特定的环境下,并不一定都是遵循自己真正的内心,经常会违心地做出一些行为。

AI大语言模型在这方面表现如何呢?大语言模型先是经过了海量数据的训练,形成了自己对世界的固有认知,称之为内部先验(internal prior)。而大语言模型在实际工程运用时,会得到外界强加给它的各种知识和认知。外部知识和大模型内部先验知识发生冲突,怎么办?如果应用系统给大模型发出的指令,如同赵高一般,大模型又会做何反应呢?

斯坦福大学2024年4月发表了论文《How faithful are RAG models? Quantifying the tug-of-war between RAG and LLMs’ internal prior》(《RAG模型有多忠实?量化RAG与大语言模型内部先验的拉锯战》),研究的就是大模型在面临着“指鹿为马”的上下文场景下,如何“天神交战”,艰难抉择的。这项研究很有趣,对工程应用也很有意义。论文地址:https://arxiv.org/pdf/2404.10198.pdf

本文先谈一下笔者对这篇论文的学习心得体会,然后再给出该论文的简要脑图,方便大家研究学习。

详细内容请参见:

4773

4773

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?