论文翻译

0. abstract

类别不平衡是机器学习实践中的一个普遍问题。典型的不平衡学习(IL)方法通过直观的类别重采样或重加权来平衡数据。然而,以前的研究表明,除了类别不平衡之外,内在的数据困难因素,如重叠、噪声和小的间断也起着关键作用。为了处理它们,已经提出了许多解决方案(例如,噪声去除、边界采样、困难示例挖掘),但是仍然局限于特定的因素,并且不能推广到更广泛的场景,这提出了一个有趣的问题:如何以统一的方式处理类别不可知的困难和类别不平衡?为了回答这个问题,我们考虑了类不平衡和它的正交:类内不平衡,即简单和困难样本上的不平衡分布。这种分布自然地反映了与类别无关的固有数据困难的复杂影响,从而为在学习期间识别和处理这些因素提供了新的统一观点。从这个角度来看,我们讨论了现有的IL解决方案的利弊,并进一步提出了新的平衡技术,以更加稳健和有效的IL。最后,我们将所有的解决方案打包成一个通用的集成IL框架,即DuBE(双重平衡集成)。它的特点是显式和高效的类间和类内平衡,以及使用标准化API的简单扩展。大量实验验证了DuBE的有效性。

1. introduct

多数著名的机器学习算法在平衡样本假设下工作,其中训练样本近似均匀地分布在类别上[1]. 然而,这一假设在实践中并不总是成立的。由于自然偏斜的类分布,类不平衡在许多现实应用领域中被广泛观察到,包括计算机视觉、欺诈检测、医疗诊断等[2], [3], [4]. 面对类不平衡,规范学习模型通常会遭受“多数偏见”,即在多数类表现良好,但在少数类表现不佳。这样的结果不是最佳的,因为少数类通常是最重要的[3]。

不平衡学习旨在消除“多数偏见”,长期以来一直是机器学习和数据挖掘研究的活跃领域。大多数现有的IL解决方案是在直观吸引人的策略下开发的,该策略是通过对类的重新采样或重新加权来减少类不平衡。这可以通过过采样少数类(例如,[5], [6], [7]), 欠采样多数类(例如,[8],[9],[10],[11]), 或者分配不同的误分类代价到不同的类别(例如,[12], [13], [14], [15])。然而,最近的一些成果是在没有任何类级操作的新策略下出现的。它们隐含地通过实例式纠正来促进类平衡,并取得了显著的效果。在诸如基于视觉的分类和检测(例如,[16], [17], [18], [19], [20], [21])。不用类方式操作就能减轻类不平衡偏差的事实促使我们思考一些有趣的问题:(1)除了类之间的基数差异(不平衡),样本之间的差异,甚至是同一类内的差异,是如何影响学习的?(2)数据中的哪些困难或因素导致了这种类内差异?(3)最后,我们能否找到一个统一的观点来描述和处理这两个正交的(类间和类内)差异?

图一:类间和类内不平衡的示例。图(a):不平衡的三类玩具数据集。图(b):(样本数量)类间不平衡分布。图。(c):由分类器的预测误差调整数据集大小。图(d): (预测误差)类内不平衡分布

在本文中,我们通过思考回答了上述问题。这种不平衡表现为两种,即类间的不平衡和类内的不平衡。图1给出了数据集中共存的两种不平衡类型的说明性示例。很容易观察到,图1(a)和图1(b) 显示类间不平衡,即类间样本分布不均匀。除此之外图1©和图1(d) 描述另一种与类不平衡正交的不平衡,即类内不平衡,即简单和困难样本数量的不均匀分布。我们注意到,尽管概念简单,类内不平衡可以是数据复杂性的一个重要指标,从而指导模型以更有效的方式利用监督信号。例如,许多以前的工作讨论了内在数据难度因子(DDFs)在不平衡学习中的影响,包括类重叠[22], [23],[24], 噪音的存在[25], [26], 和小析取的分解[27], [28], [29]。尽管存在异质性,但类内不平衡可以作为这些ddf存在的指标,如图2. 我们可以看到,类内不平衡不仅反映了ddf的存在,还反映了不同ddf的独特模式(请参考图2的标题)。这使得它成为描述类不平衡学习问题中的类不可知数据复杂性的有力工具。

图2所示,类内不平衡说明存在数据困难因素。在每行中,左侧显示了一个类不平衡数据集,其中包含一个特定的因子和MLPClassifier给出的决策边界。我们放大了高预测误差的数据点,以便更好地可视化。右侧显示了每个类别的误差分布(类内不平衡)。我们观察到,类内不平衡反映了不同难度因子的独特模式:第1行:线性可分数据易于分类,没有类内不平衡;第2行:重叠使得位于边界附近的实例难以分类,导致两个类的长尾误差分布;第3行:噪声样本几乎不能被模型学习,因此具有高误差,并导致“U”形误差分布;第4行:位于多数区域的少数析取在少数类误差分布中形成大的尾部。

我们注意到,有相关的工作试图从两个不同的角度来处理IL中的实例差异:(1)一些工作集中于处理特定的数据困难因素,例如通过边界实例生成来[6], [7]、噪声消除[30], [31] 和基于聚类的采样[32]。然而,在复杂的现实世界数据集中很难识别特定的DDF,并且多个DDF很可能共存。这些方法的直观设计不能概括和很好地处理不符合他们对DDF的假设的任务。此外,它们中的大多数严重依赖于邻域计算(例如,[6], [7], [30], [33]), 这需要明确定义的距离度量和高达

O

(

n

2

)

O(n^2)

O(n2)的计算开销。(2)其他工作侧重于挖掘困难样本,他们认为这些困难样本信息量更大,需要在训练中予以强调[16], [34]。 然而,这可能使模型容易受噪声和异常值的影响,它们也会具有大的误差,并且在训练中被错误地强调(例如,图2的第3行)。 此外,最近的工作大多是设计用于训练深度神经网络[16], [17],[20] 因此缺乏对其他学习模型和任务的通用性。更重要的是,没有现有的工作明确考虑类间和类内的不平衡,并对它们进行工作。

基于这些,我们提出DuBE(dupe-Balanced Ensemble)从类间和类内不平衡的角度来处理IL。如上所述,这两个概念描述了在不平衡数据集中共存的两个正交不平衡,其中类间不平衡指的是倾斜的类分布,而类内不平衡提供了对类不可知的数据难度因子和任务复杂性的统一视图。对于类间平衡,我们发现平衡欠采样是对倾斜 P ( Y ) P(Y) P(Y)的无偏校正,但由于信息丢失而不稳定,而过采样则相反。然而,我们进一步发现,过采样可以从适当的数据扩充中受益更多,因此混合采样和自适应数据扩充机制被引入以实现更准确和稳定的类间平衡。对于类内平衡,我们讨论了为什么朴素困难样本挖掘不能处理噪声/异常值,并提出了一种简单有效的平衡策略,用于快速和鲁棒的困难样本挖掘。最后,我们将所有的平衡策略封装到DuBE中,并通过大量的实验和分析验证了它们的有效性。我们强调,DuBE是一个多功能的学习框架,通过模块化设计执行明确的类间和类内平衡,新的平衡策略可以使用其标准API轻松集成。

综上所述,本文做出了以下贡献:

- 据我们所知,我们进行了第一次明确的探索类间和类内不平衡的IL问题。我们讨论了这两种类型的不平衡如何与固有的数据困难因素以及现有的IL解决方案相联系。

- 我们对不同IL解决方案的优缺点进行了详细的讨论和分析,在此基础上,我们进一步提出了几种快速和鲁棒的类间和类内平衡技术。

- 我们提出了DuBE,一个通用的、高效的、模块化的集成不平衡学习框架。它具有明确的类间和类内平衡,以及平衡算法的简单集成、组合和扩展。大量实验验证了DuBE的有效性。

本文的其余部分组织如下:第2节介绍符号和问题定义。第3节描述DUBE框架,以及详细的分析,包含的类间/类内平衡策略。第4节给出了实验结果和相关讨论。第5节回顾相关工作。最后,第6节论文得出结论。

2. preliminaries

表1 基本符号的定义

符号:形式上,假设

N

N

N表示数据集中样本的数量,

d

d

d表示输入维度,即输入特征的数量。我们可以定义特征空间

x

:

R

d

\mathrm x: \mathbb R^d

x:Rd和标签空间

y

:

c

1

,

c

2

,

.

.

.

,

c

m

\mathrm y : {c_1,c_2,...,c_m}

y:c1,c2,...,cm,其中

m

m

m是

类的数量。那么数据样本是

s

:

(

x

,

y

)

s : (x,y)

s:(x,y)其中

x

∈

x

,

y

∈

y

x \in\mathrm x,y\in \mathrm y

x∈x,y∈y。同样,数据集

D

D

D可以表示为

D

:

{

s

i

}

i

=

1

,

2

,

.

.

.

N

D : \{s_i\}_{i=1,2,...N}

D:{si}i=1,2,...N分类器由

F

(

⋅

)

F(·)

F(⋅)表示,

F

(

⋅

)

F(·)

F(⋅)是从特征空间到标签空间的投影,即

F

:

x

→

y

F: \mathrm x \to\mathrm y

F:x→y。此外,我们使用

f

(

⋅

)

f(·)

f(⋅)来表示集成分类器的一个基学习器,而

F

k

F_k

Fk作为具有

k

k

k个基学习器的集成分类器。表1总结了本文中的主要符号定义。

问题定义:注意,大多数现有的工作是基于不平衡学习的二进制情况[1], [2], [3].进行的,即 m = 2 m = 2 m=2。不失一般性,我们在这一节中描述二进制IL问题及其扩展到多类场景是很简单的。在这种情况下,我们考虑多数类 c m a j c_{maj} cmaj和少数类 c m i n c_{min} cmin。让我们将类 c c c中的数据样本集表示为 D c : { ( x , y ) ∣ y = c } D_c: \{(x, y)|y = c\} Dc:{(x,y)∣y=c}。那么类不平衡是指 ∣ D c m a j ∣ |D_{c_{maj}}| ∣Dcmaj∣, ∣ D c m i n ∣ |D_{c_{min}}| ∣Dcmin∣。也就是说,样本在不同的类上不是均匀分布的,即底层类(边缘)分布 P ( Y ) P(Y) P(Y)是倾斜的。在这种类不平衡的情况下,由于面向精度的学习目标[1],经典机器学习方法的学习过程很可能由大多数类例主导。这通常会导致少数类的预测表现不佳。因此,不平衡学习(IL)的目标是从倾斜数据集 D D D中学习一个无偏分类器 F : x → y F: \mathrm x \to\mathrm y F:x→y。有了上面的符号和定义,我们现在提出了我们的DuBE框架和相关的分析。

3. analysis & methodlogy

图3 DuBE框架概述。

- RQ1:不同类间再平衡策略(如欠采样/过采样)的优缺点是什么?(3.1)

- RQ2:数据增强如何帮助减少不平衡学习中的决策偏差?(3.2)

- RQ3:为什么困难样本挖掘易受噪声和离群值的影响,如何基于类内平衡的概念设计更健壮的挖掘规则?(3.3)

请注意,本节中讨论的所有技术都是DuBE(双重平衡系综)框架的组成部分。如前所述,DuBE同时执行明确的类间和类内平衡。这是通过在迭代集成训练中执行双重平衡重采样来实现的。具体来说,在第 t 次迭代中,类间平衡策略确定按类重采样的目标分布,类内平衡策略根据当前学习状态(拟合集成模型) F t − 1 ( ⋅ ) F_{t-1}(·) Ft−1(⋅)分配样本采样概率。然后使用双重平衡重采样数据集 D ′ D' D′训练新的基本分类器 f t ( ⋅ ) f_t(·) ft(⋅),并将其添加到集成中以形成 F t ( ⋅ ) F_{t}(·) Ft(⋅)。图3 显示了DuBE的概述。我们现在讨论分析和技术细节。

3.1 类间平衡

我们首先介绍了DuBE中考虑的三种类间平衡策略,即欠采样、过采样和混合采样,然后讨论了它们对类间平衡有效的原因。

(1)欠采样:包含最少样本的类被认为是少数类 c m i n c_{min} cmin,所有其他的都被视为多数类。然后对多数类进行欠采样,直到它们的大小与 c m i n c_{min} cmin相同,即 ∀ c ∈ Y , ∣ D c ′ ∣ = ∣ D c m i n ∣ ∀c∈ \mathrm Y, |D'_c| = |D_{c_{min}}| ∀c∈Y,∣Dc′∣=∣Dcmin∣,其中 D ′ D' D′表示重新采样的数据集。然后对大多数类进行低采样,直到它们的大小与 c m i n c_{min} cmin相同,即 ∀ c ∈ Y , ∣ D c ′ ∣ = ∣ D c m i n ∣ ∀c∈Y, |D'_c| = |D_{c_{min}}| ∀c∈Y,∣Dc′∣=∣Dcmin∣,其中 D ′ D' D′表示重新采样的数据集。(2)过采样:相反,包含最多的样本的类被认为是多数类。其他类通过实例复制进行过采样,直到它们的大小与 c m a j c_{maj} cmaj相同,即 ∀ c ∈ Y , ∣ D c ′ ∣ = ∣ D c m a j ∣ ∀c∈ \mathrm Y, |D'_c| = |D_{c_{maj}}| ∀c∈Y,∣Dc′∣=∣Dcmaj∣。(3)混合采样:我们进一步考虑上述策略的组合,即混合抽样。多数类和少数类由它们是否包含超过平均样本数来区分。然后,我们对多数类/少数类进行下采样/过采样,使其大小一致,即 ∀ c ∈ Y , ∣ D c ′ ∣ = ∑ i = 1 m ∣ D c i ∣ / m = ∣ D ∣ m ∀c∈ \mathrm Y, |D'_c| = \sum_{i=1}^m|D_{c_i}|/m=\frac {|D|}m ∀c∈Y,∣Dc′∣=∑i=1m∣Dci∣/m=m∣D∣

图4 一个简单不平衡分类问题 包含3个少数样本×和15个多数样本•,即不平衡比例$|D_{c_{max}}|/|D_{c_{min}}| = 5$。这两类的基本分布也包括在图中(彩色实线),它们是不同µ的一维高斯分布N(µ,σ2)。黑色实线表示相对于底层分布的最佳决策边界ζ*;虚线表示采样数据集上的最大边距边界^ζ。类不平衡引起的偏差定义为|ζ∗−^ζ|。

一个示例问题。在本节中,我们使用一个示例来说明上面描述的不同类间不平衡策略的有效性。请注意,下面的讨论旨在直观地说明不同的方法如何帮助IL,而不是分析它们的理论性质。

考虑到这一前提,我们考虑一个简单的不平衡分类设置,如图4所示。这是一个一维的两类不平衡数据集,其中3个样本来自少数类,15个样本来自多数类。在不失一般性的前提下,我们假定少数类为正数,并将少数/多数类记为

c

+

/

c

−

c_+/c_−

c+/c−。即

c

m

i

n

:

=

c

+

=

1

c_{min}:= c_+ = 1

cmin:=c+=1和

c

m

a

j

:

=

c

−

=

−

1

c_{maj}:= c_−=−1

cmaj:=c−=−1。不平衡比率(IR)为

∣

D

c

−

∣

/

∣

D

c

+

∣

=

15

/

3

=

5

|D_{c_−}|/|D_{c_+}| = 15/3 = 5

∣Dc−∣/∣Dc+∣=15/3=5。每个类都从正态(高斯)分布

N

(

µ,

σ

2

)

\mathcal N(µ,σ^2)

N(µ,σ2)中采样,具有相同的

σ

=

1

σ=1

σ=1,但不同的

µ

µ

µ,其中

µ

−

−

µ

+

=

4

µ_−−µ_+ = 4

µ−−µ+=4。很明显,最佳决策边界

ζ

∗

ζ^∗

ζ∗相对于底层分布

P

(

X

∣

Y

)

P (X|Y)

P(X∣Y)应该是

(

µ

+

+

µ

−

)

/

2

(µ_++_µ−)/2

(µ++µ−)/2(图4中的实线)。也就是说,如果

X

<

(

µ

+

+

µ

−

)

/

2

X <(µ_++µ_−)/2

X<(µ++µ−)/2,则最佳分类器预测样本为正,否则为负。然而,由于不平衡的边缘分布

P

(

Y

)

P(Y)

P(Y),不能从采样数据集中学习

ζ

∗

ζ^∗

ζ∗。让我们考虑一个简单的硬最大边距分类器

f

(

x

)

:

s

i

g

n

(

x

−

b

)

f(x): sign(x−b)

f(x):sign(x−b),它最大化了相对类的最近点之间的边距,可以通过求解得到:

a

r

g

m

a

x

ζ

γ

s

.

t

.

∣

x

i

−

ζ

∣

≥

γ

,

∀

(

x

i

,

y

i

)

∈

D

.

−

y

i

(

x

i

−

ζ

)

≥

0

,

∀

(

x

i

,

y

i

)

∈

D

.

(1)

argmaxζ \qquad \gamma\qquad\qquad \qquad \qquad \qquad \qquad \\s.t.\qquad|x_i-ζ|\ge\gamma,\quad\forall(x_i,y_i)\in D.\\ \qquad-y_i(x_i-ζ)\ge0,\quad\forall(x_i,y_i)\in D.\tag1

argmaxζγs.t.∣xi−ζ∣≥γ,∀(xi,yi)∈D.−yi(xi−ζ)≥0,∀(xi,yi)∈D.(1)

在简单不平衡数据集上学习的最大边距分类器的决策边界

ζ

^

\hat ζ

ζ^由图4中的虚线黑线表示。可以看出,与最优边界

ζ

∗

ζ^*

ζ∗相比,学习过的

ζ

^

\hatζ

ζ^向少数类倾斜。这是由于在少数类中缺乏更接近决策边界的支持向量样本。我们可以看到,接近决策边界的样本在这两类的基础分布

P

(

X

∣

Y

)

P (X|Y)

P(X∣Y)中都是罕见的模式。然而,由于类分布

P

(

Y

)

P(Y)

P(Y)是倾斜的,多数类更有可能被数据很好地表示,并且包含稀有样本,在学习过程中作为更强的支持向量(例如,图4中最左边的多数样本)。

形式上,对于类

c

c

c,我们用

d

c

m

a

x

d^{max}_c

dcmax表示类分布中心

µ

c

µ_c

µc与支持向量(采样数据集中距离

µ

c

µ_c

µc最远的点)之间的距离,即:

d

c

m

a

x

=

m

a

x

(

∣

x

−

µ

c

∣

)

,

∀

(

x

,

y

)

∈

D

c

,

x

∼

N

(

µ

c

,

1

)

.

(2)

d^{max}_c = max(|x − µ_c|), ∀(x, y) ∈ D_c, x ∼ \mathcal N (µ_c, 1). \tag2

dcmax=max(∣x−µc∣),∀(x,y)∈Dc,x∼N(µc,1).(2)

那么少数类的支持向量可以写成

s

+

s

u

p

:

(

x

+

s

u

p

,

c

+

)

s^{sup}_+:(x^{sup}_+,c_+)

s+sup:(x+sup,c+)(例如图4中最右边的

c

+

c_+

c+实例),其中

x

+

s

u

p

=

µ

+

+

d

c

+

m

a

x

x^{sup}_+ =µ_++d^{max}_{c_+}

x+sup=µ++dc+max。类似地,我们有多数类支持向量

s

−

s

u

p

:

(

x

−

s

u

p

,

c

−

)

,

x

−

s

u

p

=

µ

−

−

d

c

−

m

a

x

s^{sup}_−:(x^{sup}_−,c_−),x^{sup}_- =µ_--d^{max}_{c_-}

s−sup:(x−sup,c−),x−sup=µ−−dc−max。那么最大边距分隔符

ζ

^

=

(

x

+

s

u

p

+

x

−

s

u

p

)

/

2

\hat ζ = (x^{sup}_+ + x^{sup}_−)/2

ζ^=(x+sup+x−sup)/2。因此,决策偏差的期望为:

E

P

(

X

Y

)

[

∣

ζ

∗

−

ζ

^

∣

]

=

E

P

(

X

Y

)

∣

[

(

x

+

s

u

p

+

x

−

s

u

p

)

/

2

−

(

µ

+

+

µ

−

)

/

2

]

∣

=

∣

[

E

P

(

X

Y

)

(

x

+

s

u

p

−

µ

+

)

+

E

P

(

X

Y

)

(

x

−

s

u

p

−

µ

−

)

]

/

2

∣

=

∣

E

P

(

X

∣

Y

=

c

+

)

[

d

c

+

m

a

x

]

−

E

P

(

X

∣

Y

=

c

−

)

[

d

c

−

m

a

x

]

2

∣

(3)

\begin{aligned} E_{P(XY)}[|ζ^∗ − \hatζ|] &= E_{P(XY)}|[(x^{sup}_+ + x^{sup}_−)/2 − (µ_+ + µ_−)/2]| \\ & = |[E_{P(XY)}(x^{sup}_+ - µ_+) + E_{P(XY)}(x^{sup}_- - µ_-)]/2| \\ & =|\frac{E_{P(X|Y=c_+)}[d^{max}_{c_+}] − E_{P(X|Y=c_-)}[d^{max}_{c_-}]}2| \tag3 \end{aligned}

EP(XY)[∣ζ∗−ζ^∣]=EP(XY)∣[(x+sup+x−sup)/2−(µ++µ−)/2]∣=∣[EP(XY)(x+sup−µ+)+EP(XY)(x−sup−µ−)]/2∣=∣2EP(X∣Y=c+)[dc+max]−EP(X∣Y=c−)[dc−max]∣(3)

由于类分布

P

(

Y

)

P(Y)

P(Y)是倾斜的,我们可以期望

E

D

[

d

c

−

m

a

x

]

E_D[d^{max}_{c_−}]

ED[dc−max]的期望大于

E

D

[

d

c

+

m

a

x

]

E_D[d^{max}_{c_+}]

ED[dc+max]的期望,即:

E

D

[

d

c

−

m

a

x

]

>

E

D

[

d

c

+

m

a

x

]

,

i

f

∣

D

c

−

∣

>

∣

D

c

−

∣

.

(4)

E_D[d^{max}_{c_-}] > E_D[d^{max}_{c_+}], if |D_{c_−}| > |D_{c_−}|. \tag4

ED[dc−max]>ED[dc+max],if∣Dc−∣>∣Dc−∣.(4)

注意

E

D

[

d

m

a

x

]

E_D[d^{max}]

ED[dmax]没有闭形式表达式,但它的下界和上界与

l

o

g

n

\sqrt {logn}

logn[35]线性相关。将公式(3)和公式(4)放在一起,我们得到|

D

c

−

∣

>

D

c

+

∣

⇒

E

D

[

d

c

−

m

a

x

]

>

E

D

[

d

c

+

m

a

x

]

⇒

E

D

[

∣

ζ

∗

−

ζ

^

∣

]

>

0

D_{c_−}|>D_{c_+}|⇒E_D[d^{max}_{c_-}]> E_D[d^{max}_{c_+}]⇒E_D[|ζ^∗−\hatζ|] > 0

Dc−∣>Dc+∣⇒ED[dc−max]>ED[dc+max]⇒ED[∣ζ∗−ζ^∣]>0,这表明了类不平衡如何导致偏误进入分类器学习。

然后,我们将上述的类间策略应用于这个示例数据集,以直观地证明它们在减轻类不平衡引起的决策偏差 ∣ ζ ∗ − ζ ^ ∣ |ζ^∗−\hatζ| ∣ζ∗−ζ^∣方面的有效性。结果如图5所示。请注意,为了最小化随机性的影响,对于每种策略,我们展示了10次独立运行的结果,包括重新采样结果、在重新采样数据集上学习到的新决策边界 ζ ^ \hatζ ζ^(红线)以及相应的偏差(均值±方差)。

图5所示。不同类间平衡策略的比较。每个子图显示了相应方法在10次独立运行中的重采样结果。最优边界ζ* (实线),原始学习的^ζD(虚线),以及从重新采样的D'学习的新边界^ζD'(红线)。

欠采样:如图5(a)所示,随机欠采样(RUS)在减少对少数类的偏差方面非常有效。平均而言,它将决策偏差从0.706降低到0.283。背后的原因是:从多数类 c − c_− c−中随机丢弃实例,直到 ∣ D c − ∣ = ∣ D c + ∣ |D_{c_−}| = |D_{c_+}| ∣Dc−∣=∣Dc+∣等价于从大多数底层分布中只采样 ∣ D c + ∣ |D_{c_+}| ∣Dc+∣样本。因此,RUS可以被视为对倾斜的边缘分布 P ( Y ) P (Y) P(Y)的无偏修正。通过将 ∣ D c − ∣ |D_{c_−}| ∣Dc−∣降为 ∣ D c − ′ ∣ = ∣ D c + ∣ |D'_{c_−}| = |D_{c_+}| ∣Dc−′∣=∣Dc+∣, RUS使 E D ′ [ d c − m a x ] 和 E D ′ [ d c + m a x ] E_{D'}[d^{max}_{c_-}]和E_{D'}[d^{max}_{c_+}] ED′[dc−max]和ED′[dc+max]相等,从而降低了重采样数据集 D ′ D' D′上的期望偏差 E D ′ [ ∣ ζ ∗ − ζ ^ ∣ ] E_{D'} [|ζ^∗−\hatζ|] ED′[∣ζ∗−ζ^∣]。

然而,不利的一面是,我们注意到决策偏差在多次运行中变化很大(在所有竞争对手中方差最高为0.045),这表明RUS的性能并不稳定。这是由一个很明显的原因造成的:随机丢弃多数类样本中的大部分会引入显著的信息损失[3],[36],特别是当数据集高度不平衡时。从图5(a)可以看出,RUS虽然可以降低对 c + c_+ c+的偏向,但有时过于激进,甚至会带来对 c − c_− c−的相反偏向。直观地说,RUS也与数据挖掘的普遍做法相矛盾,即收集更多的数据并利用所有可用的信息。

过采样和SMOTE。图5(b)显示了随机过采样(ROS)的结果。我们可以观察到,尽管ROS也像RUS一样使重样本数据集 D ′ D' D′中的 ∣ D c − ′ ∣ = ∣ D c + ′ ∣ |D'_{c_−}| = |D'_{c_+}| ∣Dc−′∣=∣Dc+′∣,但它并不能帮助缓解决策偏差,即 ∣ ζ ∗ − ζ ^ D ∣ = ∣ ζ ∗ − ζ ^ D ′ ∣ |ζ^∗−\hat ζ_D| = |ζ^∗−\hat ζ_D'| ∣ζ∗−ζ^D∣=∣ζ∗−ζ^D′∣。ROS和RUS之间的关键区别等价于目标类的“重采样”和“从原始分布中采样”。如上所述,RUS后的多数类等价于从原始分布 P ( X ∣ Y = c − ) P (X|Y = c_−) P(X∣Y=c−)中采样,只是它包含的样本更少。然而,ROS却不是这样。ROS通过复制现有的少数类样本(由图5(b)中少数类样本上的数字表示)来执行过采样。这意味着新的合成样本是从现有少数样本 D c + D_{c_+} Dc+上的均匀分布中采样的,而不是从真正的底层分布 P ( X ∣ Y = c + ) P (X|Y = c_+) P(X∣Y=c+)(未实践)。因此,ROS不会改变 E D [ d c + m a x ] E_D[d^{max}_{c_+}] ED[dc+max]和预期偏差,尽管它扩大了少数类的大小 ∣ D c + ∣ |D_{c_+}| ∣Dc+∣,即 E D [ ∣ ζ ∗ − ζ ^ ∣ ] = E D ′ [ ∣ ζ ∗ − ζ ^ ∣ ] E_D[|ζ^∗−\hatζ|] = E_{D'} [|ζ^∗−\hatζ|] ED[∣ζ∗−ζ^∣]=ED′[∣ζ∗−ζ^∣]。此外,由于基于重复的设计,ROS也会导致分类器过拟合少数类样本[1],[3]的模式。

合成少数类过采样技术[5] (SMOTE)是预防ROS引起过拟合风险的最常用方法之一。它通过为所有少数样本找到k近邻(knn)并在种子例子和它的一个近邻之间执行线性插值来改进原始ROS。在许多实际应用中,SMOTE已被证明可以有效地防止过拟合和提高少数类表示的质量[2]。然而,从图5©中我们可以观察到,尽管SMOTE平滑了过采样的少数类的分布,但 E D [ d c + m a x ] E_D[d^{max}_{c_+}] ED[dc+max]仍然保持不变,期望偏差 E D [ ∣ ζ ∗ − ζ ^ ∣ ] E_D[|ζ^∗−\hatζ|] ED[∣ζ∗−ζ^∣]也是如此。因此,SMOTE只能解决ROS中存在的部分问题。

随机混合抽样:最后,我们考虑一个RUS和ROS简单的组合,称为随机混合抽样(RHS)。结果如图5(d)所示。我们可以看到,RHS也可以有效地降低决策偏差(减少51%,0.706→0.346),因为它包含了RUS。与严格欠采样 ∣ D c − ∣ ⟶ R U S ∣ D c − ∣ |D_{c_−}|\stackrel{RUS}{\longrightarrow}|D_{c_−}| ∣Dc−∣⟶RUS∣Dc−∣相比,RHS的平均目标欠采样攻击性较弱,从而防止了RUS中对 c − c_− c−的相反偏差的引入。因此,RHS在多次运行中产生更稳定的决策边界,其中RHS的方差(0.035)低于RUS的方差(0.045)。在过采样方面,RHS采用原生ROS,但产生较少的新样本以缓解潜在的过拟合问题。不使用更先进的过采样技术(例如SMOTE[5]及其变体[6],[7])的原因是:(1)如上所述,这些技术不能帮助减少决策偏差,(2)它们以定义良好的距离度量为前提,并引入额外的计算成本,(3)通过适当的处理(即§3.2中描述的基于摄动的数据增强),基于重复的ROS有可能增加 E D [ d c + m a x ] E_D[d^{max}_{c_+}] ED[dc+max],从而减少偏差。

从前面的讨论中,我们可以得出结论,减轻决策偏差的关键是能够平衡 E [ d c + m a x ] E[d^{max}_{c_+}] E[dc+max]和 E [ d c − m a x ] E[d^{max}_{c_-}] E[dc−max]。这可以通过缩小 E [ d c − m a x ] E[d^{max}_{c_-}] E[dc−max]和/或扩大 E [ d c + m a x ] E[d^{max}_{c_+}] E[dc+max]来实现。前者可以通过RUS实现,但存在较大的信息损失和方差。后者是一个困难的问题,因为在实践中底层的少数类分布是未知的,现有的方法如ROS和SMOTE基本上是在现有的例子中生成新的例子,因此不能改变 E [ d c + m a x ] E[d^{max}_{c_+}] E[dc+max]。RHS结合了RUS和ROS,实现了更稳健的 E [ d c − m a x ] E[d^{max}_{c_-}] E[dc−max]校正,但仍需要新的技术来增加 E [ d c + m a x ] E[d^{max}_{c_+}] E[dc+max]。

图6所示。不同类间平衡策略与数据增强的比较。每个子图显示了10次独立运行中相应方法的结果。与图5相同,还包括最优边界ζ*(实线)、原始学习的边界^ζD(虚线)和新的边界^ζD'aug(红线)。

3.2 基于扰动的数据增强(PBDA)

基于上述分析,我们提出了一种简单的调整

E

[

d

c

+

m

a

x

]

E[d^{max}_{c_+}]

E[dc+max]的方法,即基于扰动的数据增强(PBDA). 在这种情况下,我们向重新采样的数据集

D

′

D'

D′添加随机高斯噪声

x

p

x^p

xp,得到增强数据

D

a

u

g

′

D'_{aug}

Daug′.

D

a

u

g

′

:

(

x

+

x

p

,

y

)

,

x

p

∼

N

(

0

,

σ

p

)

,

(

x

,

y

)

∈

D

′

(5)

D'_{aug} : {(x + x^p, y)}, x^p ∼ \mathcal N (0, σ^p), (x, y) ∈ D'\tag5

Daug′:(x+xp,y),xp∼N(0,σp),(x,y)∈D′(5)

其中

σ

p

σ^p

σp是控制扰动强度的超参数。但是为什么它有助于增加

E

[

d

c

+

m

a

x

]

E[d^{max}_{c_+}]

E[dc+max]呢?

为什么PBDA有效?回想一下,我们定义了少数类

s

+

s

u

p

:

(

x

+

s

u

p

,

c

+

)

s^{sup}_+:(x^{sup}_+,c_+)

s+sup:(x+sup,c+)和多数类

s

−

s

u

p

:

(

x

−

s

u

p

,

c

−

)

s^{sup}_−:(x^{sup}_−,c_−)

s−sup:(x−sup,c−)的支持向量。在不丧失一般性的前提下,我们总是可以假设最优决策边界在坐标轴的原点,即

ζ

∗

=

0

ζ^∗= 0

ζ∗=0且

µ

−

+

µ

+

=

0

µ_−+µ_+ = 0

µ−+µ+=0,因此偏置

∣

ζ

∗

−

ζ

^

∣

=

∣

(

x

+

s

u

p

+

x

−

s

u

p

)

/

2

∣

,

x

+

s

u

p

<

0

|ζ^∗−\hat ζ| = |(x^{sup}_+ + x^{sup}_-)/2|,x^{sup}_+ < 0

∣ζ∗−ζ^∣=∣(x+sup+x−sup)/2∣,x+sup<0。因此,为了降低偏差,我们希望增加

x

+

s

u

p

x^{sup}_+

x+sup,这是不能直接使用前面讨论的过采样混合采样方法来实现的。但需要注意的是,基于重复的过采样之后,会出现多个

x

+

s

u

p

x^{sup}_+

x+sup的重复。假设重复次数为

n

r

e

p

n^{rep}

nrep,应用PBDA后,这些重复可以看作来自

N

(

x

+

s

u

p

,

σ

p

)

\mathcal N (x^{sup}_+,σ^p)

N(x+sup,σp)的

n

r

e

p

n^{rep}

nrep个独立同分布样本。因此,增强数据上的新支持向量

x

+

n

e

w

s

u

p

=

m

a

x

(

x

+

s

u

p

x^{newsup}_+= max(x^{sup}_+

x+newsup=max(x+sup的增强复制)。由[35]证明,

E

[

x

+

n

e

w

s

u

p

−

x

+

s

u

p

]

(

E

[

∆

x

+

s

u

p

]

)

E[x^{newsup}_+−x^{sup}_+] (E[∆x^{sup}_+])

E[x+newsup−x+sup](E[∆x+sup])的边界为:

0

≤

1

π

l

o

g

2

σ

p

l

o

g

n

r

e

p

≤

E

[

∆

x

+

s

u

p

]

≤

2

σ

p

l

o

g

n

r

e

p

.

(6)

0≤\frac1{\sqrt{πlog2}}σ^p\sqrt{logn^{rep}}≤E[∆x^{sup}_ +]≤\sqrt2σ^p\sqrt{logn^{rep}}.\tag6

0≤πlog21σplognrep≤E[∆x+sup]≤2σplognrep.(6)

这表明基于重复的PBDA过采样在增加

x

+

s

u

p

x^{sup}_+

x+sup方面是有效的,因此产生的决策边界偏差较小。请注意,期望的偏差减少受到与超参数

σ

p

σ^p

σp和少数类支持向量复制数量

n

r

e

p

n^{rep}

nrep相关的项的限制。

我们进一步进行实验验证上述分析,结果如图6所示。具体来说,我们扩展了图5中的实验,对重采样数据应用PBDA, σ p σ^p σp设置为0.2。首先,从图6(a)可以看出,PBDA与RUS联合使用是没有帮助的。由于RUS的 n r e p = 1 n^{rep}=1 nrep=1,结果并不奇怪,代入式(6),有 E [ ∆ x + s u p ] ≤ 2 σ p l o g 1 = 0 E[∆x^{sup}_ +]≤\sqrt2σ^p\sqrt{log1} = 0 E[∆x+sup]≤2σplog1=0,即当 n r e p = 1 n^{rep}=1 nrep=1时,PBDA并没有降低预期偏差。此外,由于PBDA引入了额外的不确定性,RUS的性能变得更加不稳定(方差从0.045增加到0.065)。对于 n r e p > 1 n^{rep}>1 nrep>1的ROS, PBDA显著降低决策偏差0.164(0.706→0.542,图6(b))。同样,由于与ROS相比,SMOTE的 n r e p n^{rep} nrep更小,其偏差也降低了,但幅度较小(0.133)(图6©)。最后,我们发现RHS与PBDA合作的效果最好(图6(d)),它产生最小的偏差(0.209±0.038),因为它是双向工作的:用RUS调整 E [ d c − m a x ] E[d^{max}_{c_−}] E[dc−max],用ROS+PBDA调整 E [ d c + m a x ] E[d^{max}_{c_+}] E[dc+max]。

我们注意到,除了每个基分类器的分类错误外,集成成员之间的多样性也是影响集成模型[37],[38]性能的关键因素。因此,在减少决策偏差的同时,PBDA在丰富DuBE的基分类器方面也发挥着重要作用。它还可以作为一种技术来防止基于重复的过采样带来的过拟合风险。

形式化:在实践中,条件基础分布

P

(

X

∣

Y

)

P (X|Y)

P(X∣Y)可能在不同的类别中有所不同,因此从单个高斯分布

N

(

0

,

σ

p

)

N (0,σ^p)

N(0,σp)中采样扰动信号

x

p

x^p

xp是不够的。为此,我们在DuBE中为每个类别独立地添加不同的扰动,强度由单个超参数

α

α

α控制:

D

a

u

g

′

:

(

x

+

α

⋅

x

p

,

c

i

)

,

x

p

∼

N

(

0

,

Σ

c

i

)

,

∀

c

i

∈

Y

(7)

D'_{aug}: {(x+α·x^p, c_i)}, x^p∼\mathcal N(0,Σ_{c_i}),∀c_i∈\mathrm Y\tag7

Daug′:(x+α⋅xp,ci),xp∼N(0,Σci),∀ci∈Y(7)

其中

Σ

c

i

Σ_{c_i}

Σci是由

D

c

i

D_{c_i}

Dci估计的协方差矩阵:

Σ

c

i

=

1

n

i

−

1

∑

j

=

1

n

i

(

x

j

−

μ

i

)

(

x

j

−

μ

i

)

⊤

.

(8)

Σ_{c_i} =\frac1{n_i−1} \sum ^{n_i}_{j=1} (x_j−μ_i) (x_j−μ_i)^⊤.\tag8

Σci=ni−11j=1∑ni(xj−μi)(xj−μi)⊤.(8)

式(8)中,

n

i

=

∣

D

c

i

∣

n_i = |D_{c_i}|

ni=∣Dci∣,

µ

i

µ_i

µi为类

c

i

c_i

ci的质心,即

µ

i

=

∑

j

=

1

n

i

(

x

j

)

/

n

i

,

x

j

∈

D

c

i

µ_i = \sum^{n_i}_{j=1} (x_j) /n_i,x_j∈D_{c_i}

µi=∑j=1ni(xj)/ni,xj∈Dci。通过这样做,我们使用基类的统计数据校准扰动。

3.3 类内平衡

我们现在讨论不同的类内策略对DuBE的影响。DuBE中的类内平衡是通过对分类器 f f f根据预测误差为每个实例 ( x , y ) (x, y) (x,y)分配不同的抽样概率 w w w来实现的,即类内不平衡策略对应于函数 g ( ⋅ ) : X × Y × F → R g(·):\mathrm {X ×Y×F}→\mathbb R g(⋅):X×Y×F→R,其中 F \mathrm F F为假设(模型)空间。

困难样本挖掘:让我们首先介绍DuBE中考虑的困难样本挖掘(HEM)。形式上,对于一个标签空间为

Y

:

{

c

1

,

c

2

,

⋅

⋅

⋅

,

c

m

}

\mathrm Y: \{c_1, c_2,···,c_m\}

Y:{c1,c2,⋅⋅⋅,cm}的输入

x

x

x,给定一个分类器

f

(

⋅

)

f(·)

f(⋅),估计概率为

f

(

x

)

=

p

=

[

p

1

,

p

2

,

…

,

p

m

]

⊤

f(x) = \mathrm p = [p_1, p_2,…, p_m]^⊤

f(x)=p=[p1,p2,…,pm]⊤,其中第

i

i

i个分量

p

i

∈

[

0

,

1

]

p_i∈[0,1]

pi∈[0,1]是估计的

P

(

y

=

c

i

∣

x

)

P (y = c_i|x)

P(y=ci∣x)。对于一个标签

y

=

c

i

y = c_i

y=ci,我们定义了独热二元标签向量

y

=

[

y

1

,

y

2

,

…

,

y

m

]

⊤

\mathrm y = [y_1, y_2,…, y_m]⊤

y=[y1,y2,…,ym]⊤,其中

y

i

=

1

y_i = 1

yi=1,其他分量为

0

0

0。则预测误差定义为

∑

i

=

0

m

∣

p

i

−

y

i

∣

\sum^m_{i=0} |p_i - y_i|

∑i=0m∣pi−yi∣。为了简单起见,我们使用

e

r

r

(

f

(

x

)

,

y

)

err(f(x),y)

err(f(x),y)来表示

(

x

,

y

)

(x, y)

(x,y)关于

f

f

f的误差。然后在DuBE的第

t

t

t次迭代中,给定当前的集成分类器

F

t

−

1

(

⋅

)

F_{t−1}(·)

Ft−1(⋅),困难样本挖掘对应于以下加权函数:

g

H

E

M

(

x

,

y

,

F

t

−

1

)

=

e

r

r

(

F

t

−

1

(

x

)

,

y

)

,

(9)

g_{HEM}(x, y, F_{t−1})= err(F_{t−1}(x),y), \tag9

gHEM(x,y,Ft−1)=err(Ft−1(x),y),(9)

也就是说,具有较大预测误差的困难样本更有可能被采样并用于后续学习。

图7。是否存在少数类噪声的分类误差(y轴)分布。预测误差(概率)是从对应数据训练的逻辑回归分类器中获得的。

当数据集不包含噪声(即具有更好的可分离性)时,我们表明,通过基于重复的过采样和PBDA, HEM在进一步降低决策偏差方面是有效的。如图7(a)所示,少数类支持向量 x + s u p x^{sup}_+ x+sup在所有少数类样本中误差最大,因为它位于决策边界的最近位置。假设我们想要将少数类的规模从 n + n_+ n+扩大到 n + ′ n'_+ n+′,其中 n + ′ > n + n'_+>n_+ n+′>n+。对于ROS, x + s u p x^{sup}_+ x+sup复制的期望数量是 E R O S [ n r e p ] = n + ′ / n + \mathbb E_{ROS}[n^{rep}] = n'_+/n_+ EROS[nrep]=n+′/n+。当ROS+HEM时,此期望变为 E R O S + H E M [ n r e p ] = ( e + s u p ⋅ n + ′ ) / ( ∑ s + ∈ D c + e + ) \mathbb E_{ROS+HEM}[n^{rep}] = (e^{sup}_+·n'_+)/(\sum_{ s_+∈D_{c_+}} e_+) EROS+HEM[nrep]=(e+sup⋅n+′)/(∑s+∈Dc+e+),其中 e e e表示样本 s s s的误差。很明显,由于 e + s u p ≥ e + , ∀ s + ∈ D c + e^{sup}_+≥e_+,∀s_+∈D_{c_+} e+sup≥e+,∀s+∈Dc+, E R O S + H E M [ n r e p ] > E R O S [ n r e p ] \mathbb E_{ROS+HEM}[n^{rep}] > \mathbb E_{ROS}[n^{rep}] EROS+HEM[nrep]>EROS[nrep]。那么根据公式(6),我们可以预期在PBDA之后 E R O S + H E M [ x + s u p ] > E R O S [ x + s u p ] \mathbb E_{ROS+HEM}[x^{sup}_+] > \mathbb E_{ROS}[x^{sup}_+] EROS+HEM[x+sup]>EROS[x+sup],因此产生较小的偏差。

然而,在处理有噪声的数据集时,HEM可能会错误地强化噪声/异常值。在图7(b)中,我们对图7(a)中的数据进行修改,加入少数类噪声样本。可以观察到,这几个噪声样本贡献了少数类的大部分预测误差。因此,这些异常值将主导HEM的重采样过程。在这种情况下,异常值将被重复多次,而包括真实支持向量 x + s u p x^{sup}_+ x+sup在内的其他样本将被HEM忽略。这显然不是一个好的策略,因为提取的数据将主要包含有噪声的实例,这将极大地干扰后续的学习过程。

软困难样本挖掘:然而,我们发现这可以通过考虑误差密度分布来防止。仔细观察图7中的分类误差分布(Y轴)后,我们有一些有趣的发现:(1)困难样本很可能稀疏分布在决策边界附近的区域(例如X轴上的“困难样本”区域),其中估计概率P(Y|X)也发生了剧烈变化。所有这些导致困难样本的误差分布更加稀疏(例如,y轴上的“低密度”区域);(2)相比之下,简单样本和噪声样本在分类误差方面都是密集分布的(例如y轴上的“高密度”区域)。这主要是因为 P ( Y ∣ X ) P (Y |X) P(Y∣X)在“简单样本”和“噪声样本”区域变化很小,因为分类器对这些样本的预测有很高的置信度。

基于上述分析,我们建议通过简单地反演分类误差密度来执行鲁棒HEM。通过这样做,简单和有噪声的高误差密度的样本将降低权重。直观地说,这将防止噪声样本的过度权重,同时仍然强调困难样本重要性。估计误差分布

E

E

E的方法有很多种,这里我们使用直方图来近似

E

E

E,因为它简单高效。形式上,考虑一个有

b

b

b个方块的直方图,然后近似误差分布由向量

E

^

D

=

[

E

^

D

1

,

E

^

D

2

,

…

E

^

D

b

]

∈

R

b

\hat E_D = [\hat E_D^1, \hat E_D^2,…\hat E_D^b]∈\mathbb R^b

E^D=[E^D1,E^D2,…E^Db]∈Rb,其中第

i

i

i个分量

E

^

D

i

\hat E_D^i

E^Di表示第

i

i

i个方块

(

B

i

)

(B^i)

(Bi)中的样本数量占总数的比例,即:

E

^

D

i

=

∣

B

i

∣

∣

D

∣

;

B

i

=

s

j

∣

i

−

1

b

∣

≤

e

j

<

i

b

,

∀

s

j

∈

D

.

(10)

\hat E_D^i = \frac{|B^i|}{|D|} ; B^i = {s_j|\frac{i − 1}b| ≤ e_j < \frac i b, ∀s_j ∈ D}. \tag{10}

E^Di=∣D∣∣Bi∣;Bi=sj∣bi−1∣≤ej<bi,∀sj∈D.(10)

这里

e

j

e_j

ej是

s

j

s_j

sj的误差,即

e

j

=

e

r

r

(

F

t

−

1

(

x

j

)

,

y

j

)

e_j = err(F_{t−1}(x_j),y_j)

ej=err(Ft−1(xj),yj)。通过式(10),我们现在可以在DuBE中正式定义软困难样本挖掘(SHEM):

g

S

H

E

M

(

x

,

y

,

F

t

−

1

)

=

1

/

E

^

D

⌈

e

r

r

(

F

t

−

1

(

x

)

,

y

)

/

b

⌉

.

(11)

g_{SHEM}(x, y, F_{t−1}) = 1/ \hat E^{⌈err(F_{t−1}(x),y)/b⌉}_D . \tag{11}

gSHEM(x,y,Ft−1)=1/E^D⌈err(Ft−1(x),y)/b⌉.(11)

公式(11)中的

⌈

e

r

r

(

F

t

−

1

(

x

)

,

y

)

/

b

⌉

⌈err(F_{t−1}(x),y)/b⌉

⌈err(Ft−1(x),y)/b⌉表示(x, y)所属的方块,即实例被赋予与其分类误差密度的倒数相应的采样权重。在这一点上,我们可以在算法1中总结DuBE。实现1和文档2是开源的。更多相关结果和讨论请参见§4.2.3。

算法1 双重平衡集成训练

要求:训练集 D D D,集合大小 k k k,扰动超参数 α α α,误差直方图中的方块 b b b

1:推导协方差矩阵 Σ c 1 , Σ c 2 , … , Σ c m Σ_{c_1}, Σ_{c_2},…,Σ_{c_m} Σc1,Σc2,…,Σcm。 ▹ \triangleright ▹公式(8)

2:在 D D D上训练第一个基分类器 f 1 ( ⋅ ) f_1(·) f1(⋅)

3:for t = 2 t=2 t=2 to k k k do

4: 更新当前集成 F t − 1 ( x ) = 1 t − 1 ∑ i = 1 t − 1 f i ( x ) F_{t−1}(x) =\frac1 {t−1}\sum^{ t−1}_{i=1} f_i(x) Ft−1(x)=t−11∑i=1t−1fi(x)。

5: # 类间平衡(RUS/ROS/RHS) ▹ \triangleright ▹§3.1

6: 为重新采样设置目标类大小 n n n。

7: # 类内平衡(HEM/SHEM) ▹ \triangleright ▹§3.3

8: 设置 F t − 1 ( ⋅ ) F_{t−1}(·) Ft−1(⋅)实例权重 w w w。

9: # 双平衡重采样

10: 初始化: D ′ ⇐ ∅ D '⇐∅ D′⇐∅

11: for i = 1 i=1 i=1 to m m m do

12: 从 D c i D_{c_i} Dci中根据 w w w采样 D ′ c i ⇐ n D'c_i⇐n D′ci⇐n实例。

13: #数据增强 ▹ \triangleright ▹§3.2

14: D c i , a u g ′ ⇐ ( x + α ⋅ x p , c i ) x p ∼ N ( 0 , Σ c i ) D'_{c_i,aug}⇐{(x + α·x^p, c_i)}x^p∼\mathcal N (0,Σc_i) Dci,aug′⇐(x+α⋅xp,ci)xp∼N(0,Σci) ▹ \triangleright ▹公式(7)

15: D ′ ⇐ D ′ ∪ D c i , a u g ′ D'⇐D' \cup D'_{c_i,aug} D′⇐D′∪Dci,aug′

16: 用 D ′ D' D′训练一个新的基分类器 f t ( ⋅ ) f_t(·) ft(⋅)。

17:返回集合分类器 F k ( ⋅ ) F_k(·) Fk(⋅)

4. experiments

在本节中,我们对合成和现实世界的任务进行了实验,以回答以下研究问题:

- RQ1:DuBE的行为与现有的IL技术有何不同?

- RQ2:DuBE在现实任务中有效吗?

- RQ3:DuBE是否比基于重采样(第4.2.1节)和基于集成(第4.2.2节)表现出性能/效率优势?

- RQ4:类间和类内平衡策略和超参数的不同选择如何影响DuBE的性能?(第4.2.3节)

4.1合成数据集实验

图8。DuBE与8种有代表性的重采样方法的比较(欠采样:RUS, TOMEKLINK [9], NEARMISS [8], CONDENSE [39], 过采样:ROS、SMOTE[5]、ADASYN[6]和BORDERSMOTE[7])在3个基础类分布重叠程度不同的合成不平衡数据集上(第1/2/3行的低/中/高重叠)。不透明的点是(重采样的)训练集,半透明的点代表测试集。每个子图右上方的数字是分类器获得的测试宏AUROC。

设置细节:为了直观地演示不同的IL方法如何在IL问题中工作,我们首先在一系列合成数据集上展示了一些可视化。我们从2个类中抽取1100个样本,创建3个二维分类任务,类分布为1000/100,即不平衡比(IR) = 10。注意,合成数据集中存在类重叠,如图8所示。本实验将DuBE与8种具有代表性的重采样方法进行比较,其中4种为欠采样(RUS、TOMEKLINK[9]、NEARMISS[8]、CONDENSE[39]), 4种为过采样(ROS、广泛使用的SMOTE[5]及其变体ADASYN[6]和BORDERSMOTE[7])。本实验中的所有方法都以决策树作为基本分类器进行部署。DuBE的集成数量为5。我们对每个数据集进行50%/50%的训练/测试分割,并使用半透明点表示图8中的测试集。对于每个IL算法,我们在图8中绘制了重新采样的训练数据集、学习的决策边界和测试集上的宏观平均AUROC(类平衡度量)得分。

可视化和分析:如前所述,RUS随机移除多数类样本,这有助于减轻决策偏差,但会导致严重的信息丢失。这可能导致分类器对所选子集过拟合,产生不稳定的学习边界。TOMEKLINK[9]通过检测“TomekLinks”来进行欠采样,如果两个不同类别的样本是彼此最近的邻居,则存在“TomekLinks”,即去除位于重叠区域的大多数样本。但我们可以看到,只有少量多数类样本被丢弃,这无助于减轻决策偏差。因此,它的性能优于RUS,特别是在高度重叠的数据集上(例如,第3行)。与TOMEKLINK相比,NEARMISS[8]和CONDENSE[39]都是为了选择最接近少数样本的多数样本。他们假设这些样本很可能是帮助分类的支持向量。然而,当数据集重叠时,这个假设显然不成立:两种方法最终都会丢弃反映原始分布的大多数样本,这极大地干扰了学习过程。

与欠采样相比,过采样方法通常会产生更稳定的决策边界,因为它们只添加新的样本,而不影响原始数据集。ROS通过简单地复制现有的少数实例来工作,这可能会导致学习过度拟合少数类样本的模式,如[第一行,随机过采样]子图所示。先进的过采样技术通过执行基于邻域的插值而不是重复来防止这种情况。SMOTE[5]的工作原理是在少数类中反复选择种子实例,然后在种子与其最近邻居之一之间的连接线上生成合成样本。这有效地平滑了过采样后的少数类分布。ADASYN[6]和BORDERSMOTE[7]通过关注用于插值的边缘少数例进一步改进了SMOTE。然而,这种策略可能会导致在少数离群值附近生成大量实例(例如,第一个数据集的“∪”型分布的左上角的数据点)。

最后,我们可以观察到DuBE (k = 5,RHS, SHEM和PBDA)在三个任务中都达到了最好的性能。与严格欠采样相比,混合采样基本保持了数据原有的分布结构。另一方面,与ADASYN和BORDERSMOTE相比,SHEM的使用避免了DuBE在少数离群点附近生成合成实例。此外,PBDA提高了少数类在特征空间中的覆盖率,从而减轻了决策偏差。它还支持数据级正则化并稳定DuBE的决策边界。

4.2 在真实世界数据集上的实验

数据集:为了验证DuBE在实际应用中的有效性,我们将实验扩展到来自UCI存储库[41]的真实IL任务。这些数据来自不同的应用领域,包括生物信息学、社会人口统计学、临床医学等。为了确保全面的评估,这些数据集(10个)的性质差异很大。具体数据统计见表2。

评估标准:对于IL问题,分类精度不是一个公平的性能指标,因为它不能反映分类器如何在少数类上工作。因此,在IL中通常使用基于真/假阳性/阴性预测数的无偏评价标准。对于综合评价,我们考虑3个无偏指标:宏观平均F1score,MCC(马修斯相关系数)和AUROC(受试者工作特征曲线下面积)[42]。对于每个数据集,我们报告5次分层交叉验证的结果,并使用不同的随机种子执行5次独立运行以消除随机性。

4.2.1与重采样IL方法的比较

我们首先比较DuBE与基于重采样的IL结果。它们已被广泛应用于类不平衡数据[2]的预处理。从基于重采样的IL的4个主要分支中选择了10种具有代表性的方法:欠采样和过采样以及带有清洗后处理的过采样(在一些文献中也称为混合采样,为了防止混淆,我们不使用这个名称)。所有方法都在失衡率最高的臭氧水平数据集(IR=33.75)上进行了测试,以测试其效率和有效性。包括SHEM和PBDA的DuBE的集成大小设置为10。五种不同的分类器,即多层感知器(MLP), K近邻(KNN),决策树(DT),自适应增强(BST)和Bagging (BAG),用于与这些方法协作。同时还报告了训练样本的数量和用于执行重采样的时间,以证明计算效率。

实验结果如表3所示。我们表明,通过显式地执行类间和类内平衡,DuBE的性能显著优于规范的重采样方法。在这样一个高度不平衡的数据集中,少数类很可能代表性不佳,缺乏清晰的结构。因此,依赖于距离计算和少数目标之间的邻域关系的高级重采样方法可能会降低分类性能,特别是在使用大容量模型(如BST和BAG)时。过度采样+清洗方法通常比其他基线表现更好,因为它们结合了欠采样(US)和过采样(OS)。但这种组合也引入了更多的距离计算开销,使重采样时间相当高。我们还注意到,基于距离的US通常比OS成本更高,因为它涉及到计算多数类样本和少数类样本之间的距离(例如,CONDENSE重采样需要12157.64 ms),而OS只考虑少数类内的距离。相比之下,DuBE的重采样不涉及任何距离计算,因此计算效率高。

4.2.2 与集成IL方法的比较

我们进一步将DUBE与8个有代表性的集成IL解决方案在10个真实的不平衡分类任务上进行了比较。基线包括4种基于欠采样的方法(RUSBST[43]、UNDERBAG[44]、CASCADE[34]、SPE[19])和4种基于过度采样的方法(OVERBST[37]、SMOTEBST[45]、OVERBAG[37]、SMOTEBAG[46])。“BST”/“BAG”表示该方法基于Adaptive Boosting/Bootstrap Aggregating (Boosting/ bagging)集成学习框架。为了公平的比较,所有测试方法的集成大小都设置为10。DuBE采用RHS、SHEM和PBDA实现。我们使用C4.5决策树作为所有集合的基础学习器,遵循之前大部分工作[2]的设置。

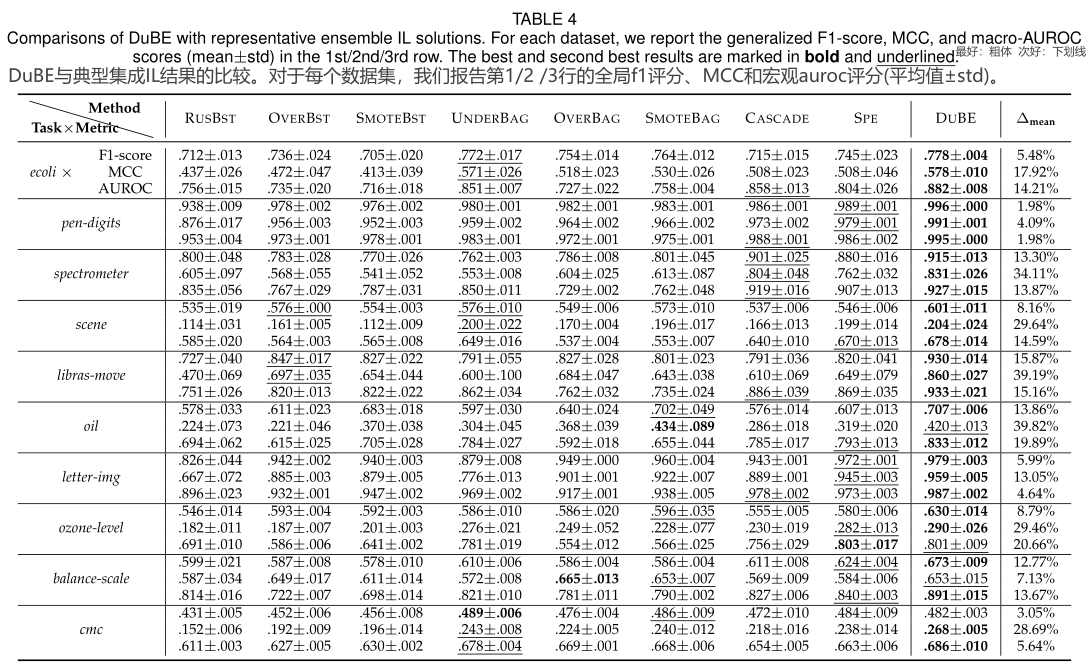

结果如表4所示。我们还报告了DuBE相对于所有基线的平均性能改善(∆平均值)的百分比。可以观察到,DuBE在各种现实世界的IL任务中取得了具有竞争力的性能。在10×3个任务-度量对中,有26个优于所有其他8种集成方法。平均而言,通过明确考虑类间和类内的不平衡,DuBE比现有的集成IL基线带来了显著的性能改进(1.98%/15.22%/39.82% min/ave/max∆mean)。我们还可以看到,基于bagging的方法通常比基于增强的方法表现得更好(例如,在所有30个任务指标对上,SMOTEBAG的性能比SMOTEBST好6.54%)。与仅操纵样本权重的boosting相比,bagging中的bootstrap抽样引入了额外的数据级多样性,这有助于防止IL的过拟合,特别是在少数类(es)上。注意,boost是一种通过重新加权实现HEM的方法。另一方面,CASCADE和SPE也结合了HEM的思想,但通过重新采样。我们发现后两种基于重采样的方法通常也优于基于增强的方法(均值(CASCADE, SPE)比均值(RUSBST, OVERBST, SMOTEBST)好10.87%),这进一步验证了数据级多样性在IL中的重要性。在DuBE中,除了减少决策偏差外,RHS和PBDA在使基分类器多样化和防止过拟合方面也发挥了重要作用。

4.2.3 消融研究与讨论

我们进行了进一步的实验来验证不同类间(RUS/ROS/RHS)和类内平衡(HEM/SHEM)以及基于扰动的数据增强(PBDA)的贡献。

图9 不同噪声比下的IntraCB策略比较。

类内平衡(IntraCB)。正如前面在§3.3中讨论的,HEM通过关注信息丰富的高误差样本来帮助缓解类内的不平衡,但容易受到噪声/异常值的影响。因此,SHEM是为鲁棒的HEM设计的。在这个实验中,我们测试了它们对噪声的鲁棒性。在实践中,由于众包等标注过程中的错误,训练数据经常包含损坏的标签。在这里,我们通过引入翻转噪声来模拟这一点,即当噪声比为

r

r

r时,

r

⋅

n

m

i

n

o

r

i

t

y

r·n_{minority}

r⋅nminority个少数样本将被分配相反的标签,反之亦然。使用最大的letter-img数据集作为代表。我们用HEM/SHEM和不带IntraCB(均匀)对0-50%损坏的数据进行DuBE10,RUS测试,如图9所示。我们可以观察到,当数据不含噪声(r=0)时,HEM和SHEM的性能都明显优于均匀采样。 但随着

r

r

r的增大,HEM的性能迅速下降,当

r

≥

0.2

r≥0.2

r≥0.2时,HEM的性能甚至不如均匀重采样。相比之下,SHEM在不同噪声水平下的鲁棒性和一致性优于均匀重采样,这验证了其有效性。

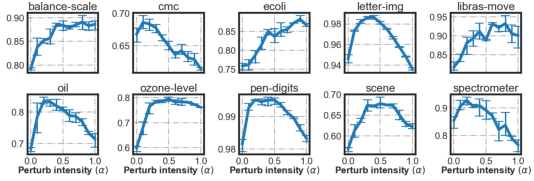

图10 不同扰动强度α下的interCB策略比较,∆为PBDA的相对性能增益,即(max(scoreα>0)−scoreα=0 ) / scoreα=0。

类间平衡(interCB)和PBDA。在§3.1中,我们讨论了RUS、RHS和ROS的区别。具体来说,我们发现RUS在缓解决策偏差方面非常有效,因为它可以被视为对倾斜的边际分布

P

(

Y

)

P(Y)

P(Y)的无偏校正。另一方面,RHS和ROS中基于复制的过度采样并不等同于从基础分布

P

(

X

∣

Y

=

c

m

i

n

)

P (X|Y = c_{min})

P(X∣Y=cmin)重新采样,因此无助于减轻偏差。但是回想一下,在§3.2中,我们进一步介绍了PBDA,它可以通过增加重复的少数样本来改善RHS和ROS。为了验证不同interCB策略和PBDA的有效性,我们用RUS、RHS、ROS和不同扰动强度α测试了DUBE10,SHEM。结果如图10所示。可以观察到,在没有PBDA的情况下(α = 0),纯RUS优于RHS和ROS,特别是在AUROC评分方面,因为它能够自然地减轻偏倚。然而,我们也注意到,与RHS和ROS相比,RUS从PBDA获得的性能收益明显较弱,如图10中的∆s所示。通过适当的数据增强,RHS&ROS可以获得更好的性能。这些发现与我们在§3.2和§3.1中的讨论一致。我们还发现,指标对PBDA有不同的响应,例如,对于RHS,F1-score和MCC的最佳

α

=

0.2

α = 0.2

α=0.2,而AUROC为

α

=

0.4

α =0.4

α=0.4。

图11 方块b的影响(宏AUROC)。

图12 扰动系数α(宏观AUROC)的影响。

参数分析。DuBE有两个主要参数:直方图中的方块

b

b

b和扰动系数

α

α

α。在本节中,我们将基于真实的IL任务讨论它们的影响。首先,

b

b

b决定了误差分布近似的详细程度,我们在图11中显示了它的影响。我们可以看到,设置较小的

b

b

b可能会导致较差的性能,例如,

b

=

1

b=1

b=1会使SHEM降级为均匀采样。使用较大的

b

b

b(例如,≥10)也不一定会带来更好的性能,因为许多方块可能是空的。基于这些原因,我们建议将

b

b

b设置为5,这也是我们在实验中使用的设置。在处理大型数据集时,可以尝试增加

b

b

b。另一方面,

α

α

α决定了基于扰动的增强的强度。图12显示了它在现实任务中的影响。我们可以看到,在适当的

α

α

α条件下,PBDA对泛化有显著的帮助,但继续增加

α

α

α会引入过多的扰动,降低性能。在我们的DuBE实现中,

α

α

α可以使用一个小的验证子集自动调优。

实现细节:我们的DuBE实现基于Python 3.8.5。我们使用开源软件包balanced-learn[47]和balanced-ensemble[48]来实现所有基线重采样和集成IL方法。基本学习模型(MLP、KNN、DT等)来自scikit-learn[49]包。重采样次数是基于Intel CoreTM i7-10700KF CPU和32GB RAM上运行的结果获得的。

复杂性分析:DuBE (Alg.1)的复杂性主要来自于类内平衡(第8行),这需要当前集成估计的最新预测概率。假设基分类器 f ( ⋅ ) f(·) f(⋅)在数据集 D D D上预测的复杂度为 C f , D p r e d C^{pred}_{ f,D} Cf,Dpred。那么训练k-分类器DuBE的总重采样成本为 k p r e d ⋅ C f , D p r e d k^{pred}·C^{pred}_{f,D} kpred⋅Cf,Dpred,其中 k p r e d k^{pred} kpred为用 f ( ⋅ ) f(·) f(⋅)进行预测的次数。根据Alg.1,通常有 k p r e d = ∑ t = 1 k − 1 t = k ( k − 1 ) 2 k^{pred}= \sum^{k−1}_{t=1} t= \frac {k(k−1)}2 kpred=∑t=1k−1t=2k(k−1),即重采样复杂度为 O ( k 2 C f , D p r e d ) O(k^2C^{pred}_ {f,D}) O(k2Cf,Dpred)。但由于DuBE是一个加性集成,我们可以通过缓冲每个拟合 f ( ⋅ ) f(·) f(⋅)的预测概率( N × m N × m N×m矩阵)将 k p r e d k^{pred} kpred减少到 k k k。加上训练成本,DuBE的最终复杂度为 O ( k ( C f , D p r e d + C f , D ′ t r a i n ) ) O(k(C^{pred}_{f,D}+ C^{train}_{f,D'})) O(k(Cf,Dpred+Cf,D′train)),请注意, C f , D ′ t r a i n C^{train}_{f,D'} Cf,D′train项取决于所使用的interCB策略,因为 ∣ D R U S ′ ∣ < ∣ D R H S ′ ∣ < ∣ D R O S ′ ∣ |D'_{RUS}|<|D'_{RHS}|<|D'_{ROS}| ∣DRUS′∣<∣DRHS′∣<∣DROS′∣。最后,对相关工作进行了回顾。

5. related works

He等[1],[3],Guo等[2]和Krawczyk等[36]对类不平衡学习的算法和应用进行了系统的调查。在本节中,我们回顾了与本文密切相关的研究课题。

5.1 类别再平衡

如前所述,绝大多数现有的IL解决方案都属于这一类。它们可以分为两种情况:重采样和重加权。重采样方法侧重于直接修改训练集以平衡类分布(例如,过采样SMOTE[5],ADASYN[6],BRODERSMOTE[7]和欠采样NEARMISS[8],TOMEKLINK[9],Nearest Neighbor Rule ENN[10],One-Sided Selection OSS[11])。除了简单解决方案,以前的工作采用了不同的启发式来指导他们的重新采样过程。例如,[7],[8]的目的是生成或保留靠近边界/重叠区域的实例。而[10],SMOTERSB[30],SMOTEENN[33]则认为位于重叠区域的例子不利于学习,因此将它们从训练集中丢弃。这些方法通常依赖于探索基于距离的邻域信息,例如SMOTE过采样[5]及其变体[6],[7],[50],许多去噪过采样技术[9],[10],[11],以及它们的混合使用[30],[33],[40]。另一方面,重加权方法将不同的错误分类代价分配给不同的类(例如代价敏感学习[14],[15]),从而迫使模型关注少数类的模式。

然而,这些方法在设计中没有明确地解释类间和类内的不平衡,并且性能不理想,计算成本高,适用性差。基于距离的重采样需要一个定义良好的距离度量,这在实践中可能不可用,因为数据可能包含分类特征和缺失值[19]。此外,其中一些算法在大规模数据集上运行极其缓慢,因为计算每个实例之间距离的成本会随着数据集的大小呈二次增长。重新加权,即代价敏感学习,通常需要对学习算法[2]进行有针对性的修改。更重要的是,在大多数情况下,很难得到领域专家[51]给出的合适的成本矩阵。

5.2 困难样本挖掘

该组中的大部分工作都是近年来随着深度学习方法的蓬勃发展而提出的,特别是在图像分类和物体检测[52],[53]等计算机视觉应用中。他们(隐式地)根据样本的困难或损失重新加权样本的梯度更新,即降低分类良好的例子的权重,并为困难的例子分配更多的权重。这种困难样本挖掘方法在许多领域都取得了显著的成功。例如,Qi等[20]提出了Class rectified Hard Mining来处理不平衡的图像分类。为了解决目标检测中的背景前景不平衡问题,Online HEM[16]在训练后期仅对困难样本进行反向传播梯度。Lin等[17]进一步提出了统一的HEM损失函数FocalLoss用于目标检测。

我们注意到,有一些类间平衡解决方案也包含HEM的思想。例如Liu等[34]在集合训练中进行欠采样时迭代丢弃分类良好的多数样本。基于adaptive boosting (AdaBoost)的IL方法(如[43],[45],[54])也可以被认为包含HEM,因为AdaBoost强调了那些被之前的分类器错误分类的实例。然而,这并不意味着HEM是类内平衡的最佳解决方案。当数据是干净的,没有噪音存在时,它可能工作得很好。但在一个有噪声的数据集上,大多数硬例子可能是异常值。它们会被直接HEM错误地加强,从而降低泛化性能。因此,需要一种自适应的方法来实现更健壮的类内平衡。

5.3 数据复杂性因素

一些研究工作讨论了类不平衡学习中存在的数据复杂性因素。这些因素被认为广泛存在于不平衡的数据集中,并导致分类性能差。具体而言,Garcia et al[25]和Koziarski et al[26]讨论了噪声示例在不平衡学习中的影响。[22],[23],[24]说明类重叠/可分离性是导致分类器性能下降的主要问题。其他一些工作关注小分离[27],[28]的问题,即存在小型集群(称为子概念),其中包含来自一个类的示例,位于另一个类的区域。然而,我们注意到,这些数据复杂性因素彼此密切相关:严重的类重叠可以产生更多的异常值,这些异常值与噪声示例[55]的作用相似,噪声量的增加也可以诱导更多的小分离[29],反之亦然。与之相比,本文引入的类内不平衡是一个更高层次的任务复杂性指标。它考虑了学习难度方面的数据分布(相对于给定的模型),这反映了这些数据复杂性对分类器学习过程的最终影响。

5.4 集成不平衡学习

通过合并多个分类器的输出,集成不平衡学习(EIL)可以有效地改进典型的IL解决方案(例如,SPE[19],CASCADE[34],RUSBST[43],SMOTEBST[45],SMOTEBAG[46])。这些EIL解决方案越来越受欢迎,并在许多IL任务中表现出具有竞争力的性能。但其中大多数是重采样/重加权方案和集成学习框架的直接组合,例如SMOTE [5]+ADABOOST [56]=SMOTEBOOST[45]。这意味着这些方法继承了现有类间平衡策略的相同缺点,例如依赖基于距离计算的邻域关系。因此,尽管EIL技术有效地降低了重采样/重加权引入的方差,但它们并没有从本质上改善平衡策略,因此仍然有很大的改进空间。请注意,DuBE也是一个通用的迭代集成学习框架,它利用了分类器集成和迭代训练过程的优势,从而实现了困难样本挖掘。

6. conclusion & limitations

在本文中,我们讨论了IL本质中存在的两种类型的不平衡,即类间和类内不平衡,以及它们如何隐式地对应于现有的IL策略。为了在统一的学习框架中明确地处理它们,提出了DuBE,并系统地讨论了现有Inter/IntraCB解决方案的优点和缺点。大量的比较研究证实了DuBE的有效性。在本文的讨论之外,我们认为还需要更深入的理论分析来找到更好的类间和类内平衡的解决方案。综上所述,这项工作为理解IL的类间和类内不平衡做出了初步的努力,我们希望这项工作能够为寻找IL的新解决方案提供一些启示。

论文简述

1. introduct

- 除了类之间的基数差异(不平衡),样本之间的差异,甚至是同一类内的差异,是如何影响学习的?

样本之间的差异,包括内在数据难度因子(DDFs),例如类重叠,噪音,小聚类(析取);类不平衡(图1)分为类间不平衡,即类间样本分布不均匀和类内不平衡,即简单和困难样本数量的不均匀分布,类内不平衡不仅反映了DDF的存在,还反映了不同DDF的独特模式(图2)。

现有解决角度:(1)处理特定的数据困难因素,比如噪声消除[30], [31] 和基于聚类的采样[32];(2)挖掘困难样本

DuBE:类间平衡:通过混合采样和自适应数据扩充机制实现准确和稳定的类间平衡;类内平衡:软困难样本挖掘;将平衡策略封装到DuBE中。 - 数据中的哪些困难或因素导致了这种类内差异?

通过图2,观察重叠、噪声、小析取,这些DDF对类内不平衡的影响。 - 最后,我们能否找到一个统一的观点来描述和处理这两个正交的(类间和类内)差异?

集成封装的方法,分别解决类内和类间不平衡并封装到DuBE框架中。

2. preliminaries

各种符号定义,以二元分类进行数学分析。

3. analysis & methodlogy

图3 DuBE框架概述。

图3 显示了DuBE的过程,在第 t 次迭代中,类间平衡策略确定按类重采样的目标分布,类内平衡策略根据当前学习状态(拟合集成模型) F t − 1 ( ⋅ ) F_{t-1}(·) Ft−1(⋅)分配样本采样概率。然后使用双重平衡重采样数据集 D ′ D' D′训练新的基本分类器 f t ( ⋅ ) f_t(·) ft(⋅),并将其添加到集成中以形成 F t ( ⋅ ) F_{t}(·) Ft(⋅)。

- 不同类间再平衡策略(如欠采样/过采样)的优缺点是什么?(3.1)

最优边界 ζ ∗ ζ^* ζ∗,学习的决策边界 ζ ^ \hatζ ζ^,决策偏差 ∣ ζ ∗ − ζ ^ ∣ |ζ^∗−\hatζ| ∣ζ∗−ζ^∣,减轻决策偏差的关键:缩小 E [ d c − m a x ] E[d^{max}_{c_-}] E[dc−max]:RHS & 扩大 E [ d c + m a x ] E[d^{max}_{c_+}] E[dc+max]:?

| 优点 | 缺点 | |

|---|---|---|

| 欠采样 | 对分布 P ( Y ) P (Y) P(Y)的无偏修正,降低了重采样数据集 D ′ D' D′上的期望偏差 E D ′ [ ∣ ζ ∗ − ζ ^ ∣ ] E_{D'}[|ζ^∗-\hatζ|] ED′[∣ζ∗−ζ^∣],减少决策边界对少数类的偏差 | 信息丢失造成性能不稳定、对多数类的相反偏向 |

| 过采样/SMOTE | - | 不能帮助缓解决策偏差、过拟合少数类样本/预防过拟合 |

| 混合采样 | 有效地减少决策偏差,产生更稳定的决策边界、防止相反偏向、缓解潜在的过拟合 |

- 数据增强如何帮助减少不平衡学习中的决策偏差?(3.2)

向重新采样的数据集 D ′ D' D′添加随机高斯噪声 x p x^p xp,得到增强数据 D a u g ′ D'_{aug} Daug′。在过采样之后应用PBDA可以将看作 n r e p n^{rep} nrep个来自 N ( x + s u p , σ p ) \mathcal N (x^{sup}_+,σ^p) N(x+sup,σp)的独立同分布样本,增加了 x + s u p x^{sup}_+ x+sup,减小了决策边界偏差。

在DuBE中为每个类别独立地添加不同 α α α的扰动,详见公式7。 - 为什么困难样本挖掘易受噪声和离群值的影响,如何基于类内平衡的概念设计更健壮的挖掘规则?(3.3)

如公式9所示,具有较大预测误差的困难样本更有可能被采样。在处理有噪声的数据集时,HEM可能会错误地强化噪声/异常值,占据了少数类的大部分预测误差,这些异常值将主导HEM的重采样过程。在这种情况下,异常值将被重复多次,而包括真实支持向量 x + s u p x^{sup}_+ x+sup在内的其他样本将被HEM忽略。

考虑误差密度分布,困难样本:低密度区域;简单样本和噪声样本密集分布区域。因此,高误差密度的简单样本和噪声样本将降低权重。

算法1 双重平衡集成训练

要求:训练集 D D D,集合大小 k k k,扰动超参数 α α α,误差直方图中的方块 b b b

1:推导协方差矩阵 Σ c 1 , Σ c 2 , … , Σ c m Σ_{c_1}, Σ_{c_2},…,Σ_{c_m} Σc1,Σc2,…,Σcm。 ▹ \triangleright ▹公式(8)

2:在 D D D上训练第一个基分类器 f 1 ( ⋅ ) f_1(·) f1(⋅)

3:for t = 2 t=2 t=2 to k k k do

4: 更新当前集成 F t − 1 ( x ) = 1 t − 1 ∑ i = 1 t − 1 f i ( x ) F_{t−1}(x) =\frac1 {t−1}\sum^{ t−1}_{i=1} f_i(x) Ft−1(x)=t−11∑i=1t−1fi(x)。

5: # 类间平衡(RUS/ROS/RHS) ▹ \triangleright ▹§3.1

6: 为重新采样设置目标类大小 n n n。

7: # 类内平衡(HEM/SHEM) ▹ \triangleright ▹§3.3

8: 设置 F t − 1 ( ⋅ ) F_{t−1}(·) Ft−1(⋅)实例权重 w w w。

9: # 双平衡重采样

10: 初始化: D ′ ⇐ ∅ D '⇐∅ D′⇐∅

11: for i = 1 i=1 i=1 to m m m do

12: 从 D c i D_{c_i} Dci中根据 w w w采样 D ′ c i ⇐ n D'c_i⇐n D′ci⇐n实例。

13: #数据增强 ▹ \triangleright ▹§3.2

14: D c i , a u g ′ ⇐ ( x + α ⋅ x p , c i ) x p ∼ N ( 0 , Σ c i ) D'_{c_i,aug}⇐{(x + α·x^p, c_i)}x^p∼\mathcal N (0,Σc_i) Dci,aug′⇐(x+α⋅xp,ci)xp∼N(0,Σci) ▹ \triangleright ▹公式(7)

15: D ′ ⇐ D ′ ∪ D c i , a u g ′ D'⇐D' \cup D'_{c_i,aug} D′⇐D′∪Dci,aug′

16: 用 D ′ D' D′训练一个新的基分类器 f t ( ⋅ ) f_t(·) ft(⋅)。

17:返回集合分类器 F k ( ⋅ ) F_k(·) Fk(⋅)

4. experiments

-

DuBE的行为与现有的IL技术有何不同?

DuBE (k = 5,RHS, SHEM和PBDA)在三个任务中都达到了最好的性能。与严格欠采样相比,混合采样基本保持了数据原有的分布结构。另一方面,与ADASYN和BORDERSMOTE相比,SHEM的使用避免了DuBE在少数离群点附近生成合成实例。此外,PBDA提高了少数类在特征空间中的覆盖率,从而减轻了决策偏差。它还支持数据级正则化并稳定DuBE的决策边界。 -

DuBE在现实任务中有效吗?

数据集:10个现实数据集,见表2

评价指标:宏观平均 F 1 s c o r e = 2 p r e c i s i o n × r e c a l l p r e c i s i o n + r e c a l l F1score=2\frac{precision\times recall}{precision + recall} F1score=2precision+recallprecision×recall, M C C = T P × T N − F P × F N ( T P + F P ) ( T P + F N ) ( T N + F P ) ( T N + F N ) MCC=\frac{TP\times TN-FP\times FN}{\sqrt{(TP+FP)(TP+FN)(TN+FP)(TN+FN)}} MCC=(TP+FP)(TP+FN)(TN+FP)(TN+FN)TP×TN−FP×FN(马修斯相关系数)和AUROC(受试者工作特征曲线下面积)[42]

有效,与基于重采样(第4.2.1节)的方法相比,显著优于规范的重采样方法;与基于集成(第4.2.2节)的方法相比,最优占比为26/30。 -

DuBE是否比基于重采样(第4.2.1节)和基于集成(第4.2.2节)表现出性能/效率优势?

第4.2.1节,见表3。通过显式地执行类间和类内平衡,DuBE的性能显著优于规范的重采样方法。其中,高级重采样方法可能会降低分类性能,过度采样+清洗方法通常比其他基线表现更好,基于距离的US通常比OS成本更高,DuBE的重采样不涉及任何距离计算,因此计算效率高。

第4.2.2节,见表4。在10×3个任务-度量对中,有26个优于所有其他8种集成方法。其中,基于bagging的方法通常比基于增强的方法表现得更好,基于重采样的方法(CASCADE和SPE)也优于基于增强的方法。 -

类间和类内平衡策略和超参数的不同选择如何影响DuBE的性能?(第4.2.3节)

DuBE使用的类内平衡策略为SHEM,考虑超参数噪声比 r r r的影响,如图9所示,SHEM在不同噪声水平下的鲁棒性和一致性优于HEM和均匀重采样。

DuBE使用的类间平衡策略RHS和PBDA,考虑不同采样策略RUS、RHS和ROS和PBDA的超参数扰动强度α的影响,如图10所示,RHS总体性能最优,RHS的 α = 0.2 α = 0.2 α=0.2时最优F1-score和MCC的, α = 0.4 α =0.4 α=0.4最优AUROC。

DuBE中的超参数,误差分布直方图中的方块 b b b和扰动系数 α α α的影响,如图11,12所示。建议令 b = 5 b=5 b=5,取适当的 α α α决定基于扰动的数据增强的强度, α α α过大会降低性能。

5. related works

- 类别再平衡

边界相邻匹配:Tomek Links, NearMiss

聚类:Condensed Nearest Neighbor (CNN),Edited Nearest Neighbor (ENN)

-

RUS:随机排除多数类的样本

-

Tomek Links:它是一个最近邻的增强规则。Tlink的算法如下:

①取不同类的两个观察点 x , y x,y x,y

②用 d ( x , y ) d(x,y) d(x,y)表示这两个观察点

③如果不存在一个观察点 z z z满足 d ( x , z ) < d ( x , y ) d(x,z)<d(x,y) d(x,z)<d(x,y)或者 d ( z , y ) < d ( x , y ) d(z,y)<d(x,y) d(z,y)<d(x,y),对子 ( x , y ) (x,y) (x,y)称为TLink,

如果两个观察点是Tlink,要么其中一个是噪音,要么两个位于类边界。因此我们可以使用Tlink来指导下采样,或者数据清洗的方法。首先,大类的观察值会被移动,然后,两类的观察值会被放弃。

-

NearMiss:利用KNN试图挑选那些最具代表性的多数类样本。首先计算出每个样本点之间的距离,通过一定规则来欠采样多数类样本点。因此该方法的计算量通常很大。

①首先找到多数类的所有实例与少数类的实例之间的距离。

②然后,选择与少数类中距离最小的多数类的 n n n个实例。

③如果少数类中有 k k k 个实例,则最近的方法将导致多数类的 k ∗ n k*n k∗n个实例。

版本 1:与少数类的 k k k 个最近实例的平均距离最小的 多数类实例。

版本 2 :与少数类的 k k k 个最远实例的平均距离最小的 多数类实例。

版本 3:首先,对于每个少数类实例,将存储它们的 M M M 个最近邻。最后,选择与 N N N 个最近邻的平均距离最大的多数类实例。 -

Condensed Nearest Neighbor:用于寻找样本集合的子集,而不会导致模型性能损失(称为最小一致性集)

通过1NN来压缩多数类, 就是找到训练集T的一个子集U,使得T中每个点, 它在U中1NN点都属于同一个类别。 -

ROS:复制少数类样本,从而增加少数类的比例。

-

SMOTE:在现存的少数类数据上进行插值以便生成新的样本点。

①对于每一个少数类观察值 x x x , 找到它的k近邻样本点。

②随机选择一些近邻数量(取决于过采样的比率)

③沿着 x x x和其近邻的沿线,增加人造的观察点。 -

ADASYN:根据平衡程度的不同,对不同的少数类的样本使用加权分布。其中,更难平衡的少数类样本比那些更容易学习的少数类的样本要产生更多的合成数据(为每个少数类样本x计算分布比例)。

减少由于类别不平衡带来的偏差;自适应地将分类决策边界转移到困难的例子。 -

BORDERSMOTE:只在少数类的边界处进行过采样。

①首先,a图表示原始数据集,黑色点是大类数据,而红色点是小类数据

②然后,用蓝色标记出所有位于边界的小类数据

③最后,应用SMOTE在所有蓝色数据中。

- 困难样本挖掘

- 正样本:包含我们想要识别类别的样本,例如,我们在做猫狗分类,那么在训练的时候,包括猫或者狗的图片就是正样本

- 负样本:在上面的例子中,不包含猫或者狗的其他所有的图片都是负样本

- 难分正样本(hard positives):易错分成负样本的正样本,对应在训练过程中损失最高的正样本,loss比较大(label与prediction相差较大)。

- 难分负样本(hard negatives):易错分成正样本的负样本,对应在训练过程中损失最高的负样本

- 易分正样本(easy positive):容易正确分类的正样本,该类的概率最高。对应在训练过程中损失最低的正样本

- 易分负样本(easy negatives):容易正确分类的负样本,该类的概率最高。对应在练过程中损失最低的负样本

当数据是干净的,没有噪音存在时,HEM是类内平衡的一种方案。

- 数据复杂性因素

噪声、类重叠、小析取/小聚类

严重的类重叠可以产生更多的异常值,这些异常值与噪声示例[55]的作用相似,噪声量的增加也可以产生更多的小聚类[29], - 集成不平衡学习

boosting:通常考虑同质弱学习器。它以一种高度自适应的方法顺序地学习这些弱学习器(每个基础模型都依赖于前面的模型),并按照某种确定性的策略将它们组合起来。

bagging:通常考虑同质弱学习器,相互独立地并行学习这些弱学习器,并按照某种确定性的平均过程将它们组合起来。

stacking:通常考虑异质弱学习器,并行地学习它们,并通过训练一个「元模型」将它们组合起来,根据不同弱模型的预测结果输出一个最终的预测结果。

RUSBST:将Adaboost.M2算法的每轮迭代,在训练弱分类器之前,使用RUS方法抽取训练数据集,用于弱分类器训练

OVERBST:

SMOTEBST:SMOTEBoost方法在每次Boost迭代过程中使用合成数据的方法。因此,每一次迭代过程中的分类器都会集中到更多的少数类样本。

UNDERBAG:

OVERBAG:SMOTEBAG:

CASCADE、SPE:使用欠采样+集成策略进行boosting-like的串行训练,最终得到一个加性模型

6. conclusion & limitations

讨论了IL中存在的两种类型的不平衡:类间和类内不平衡,提出了DuBE,在统一的学习框架中明确地处理它们。

1057

1057

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?