本文仅从HHHL相同网卡角度对比。

要点

- BF2搭载CX6DX,BF3搭载CX7

- BF2 70亿晶体管,BF3 220亿晶体管,BF4 640亿晶体管(和A100类似)参考兄弟篇:more

- BF2 200G,BF3 400G, BF4 800G

- BF2 算力0.7T,BF3 1.5T,BF4 1000T?

| 硬件模块 | 升级_代数 | 升级_量容量数量 | 增加 | 删除 | 移动 | 相同_量容量数量 |

|---|---|---|---|---|---|---|

| 【升G】CPU | Gen: A72到A78(指令V8到V8.2) | - | - | - | - | Cap: 不变8核 |

| 【升G】NIC网卡 | Gen:从CX6DX到CX7 | Cap:双口200G 到 400G | ||||

| 【升G】PCIe | Gen: 4.0 -> 5.0 | Cap: 双口 256T/s 到 512T/s | - | - | - | Cap: lanes不变最大x16 |

| 【升G】DDR | Gen: DDR4 -> DDR5 | Cap: 双通道;速率3200MT/s到5200甚至5600。容量多了32G版本 | - | - | 移动向中间靠近CPU | Cap: 均有16G版本 |

| 【升C】eMMC | - | Cap:从64Gor128G 到 固定128G | - | - | - | - |

| 【增】SSD | - | - | 新增(128G) | - | 中上靠近CPU,紧邻DDR | - |

| 【增】集成BMC | - | - | 新增 | - | 中右上,原来DDR位置 - | |

| 【移】USB4.0 | - | - | - | - | 从靠机内到靠机外和NC-SI靠近 | - |

| 【移】RTC电池 | - | - | - | - | 从内底部到内顶部,依然在边缘 | - |

| 【同】最大功率 | - | - | - | - | - | Cap: 不变,均最大支持150W |

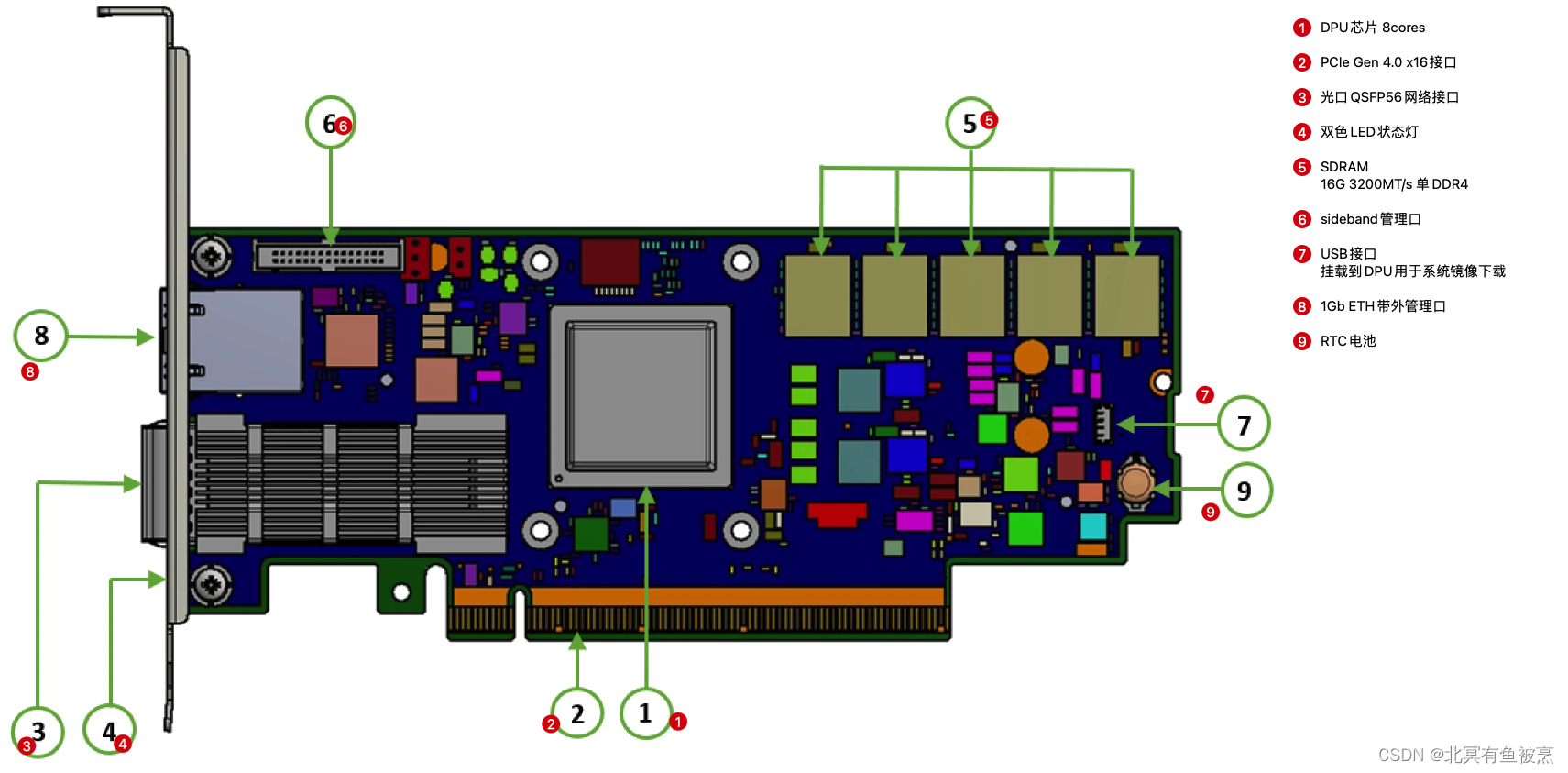

1. BF2硬件布局模块图

本文主要记录HHHL规格的BF2。图片来源 NV官网。

1.1 正面

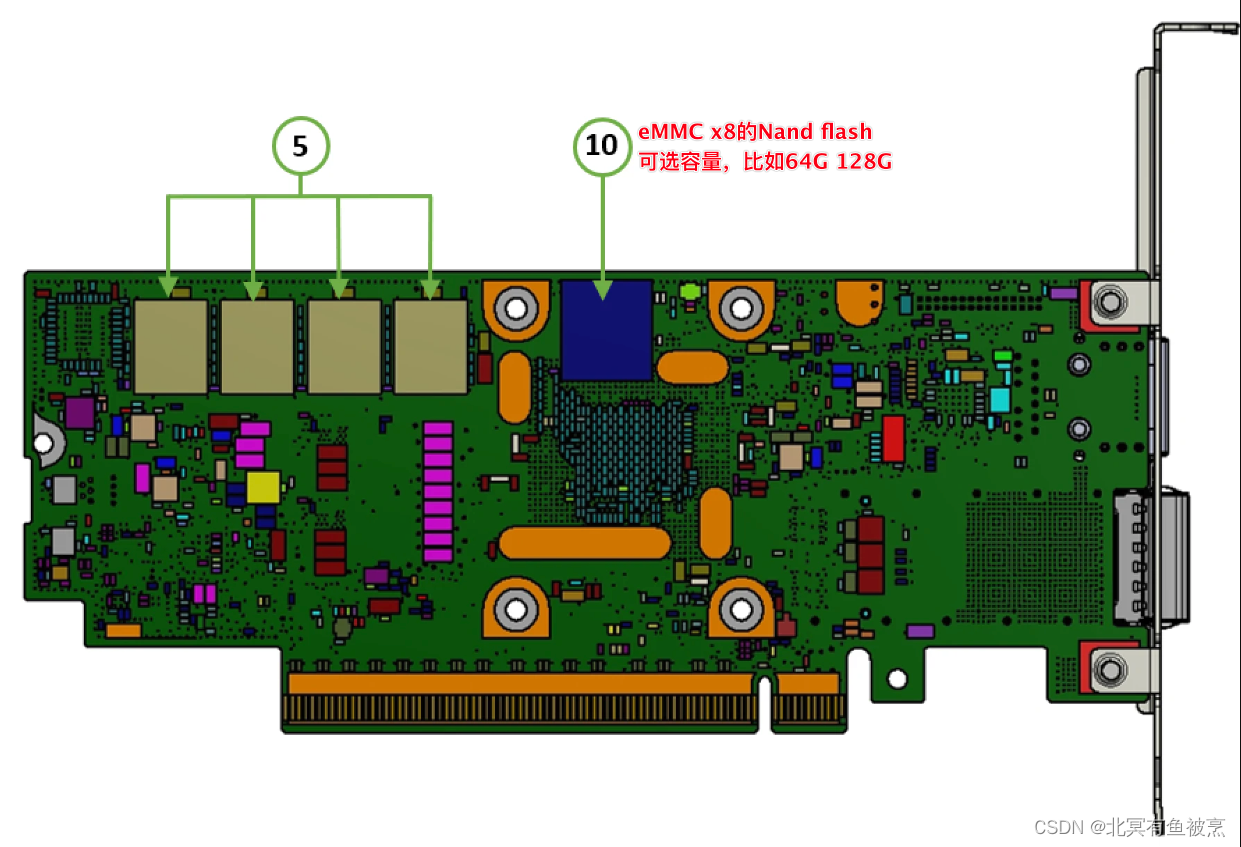

1.2 背面

1.3 其他要点

- DPU 芯片: 8核 ARM v8 A72 + CX6DX + PCIe Switch

- 支持铜缆和光纤以及SR4模块

- 内存全系列都是单通道 DDR4 3200MT/s。位宽64bit,和ECC 8bit。大小全系16GB。

- 端口LED 2种颜色(黄、绿)

- NC-SI管理接口支持UART调试接口,详细参考:more

- USB接口用来加载OS image

- OOB接口不支持10Mb/s和100Mb/s模式

- 总功率:150w(金手指75w,标准 PCIe ATX 电源6针 75w)

1.4 实卡效果

正面:

背面:

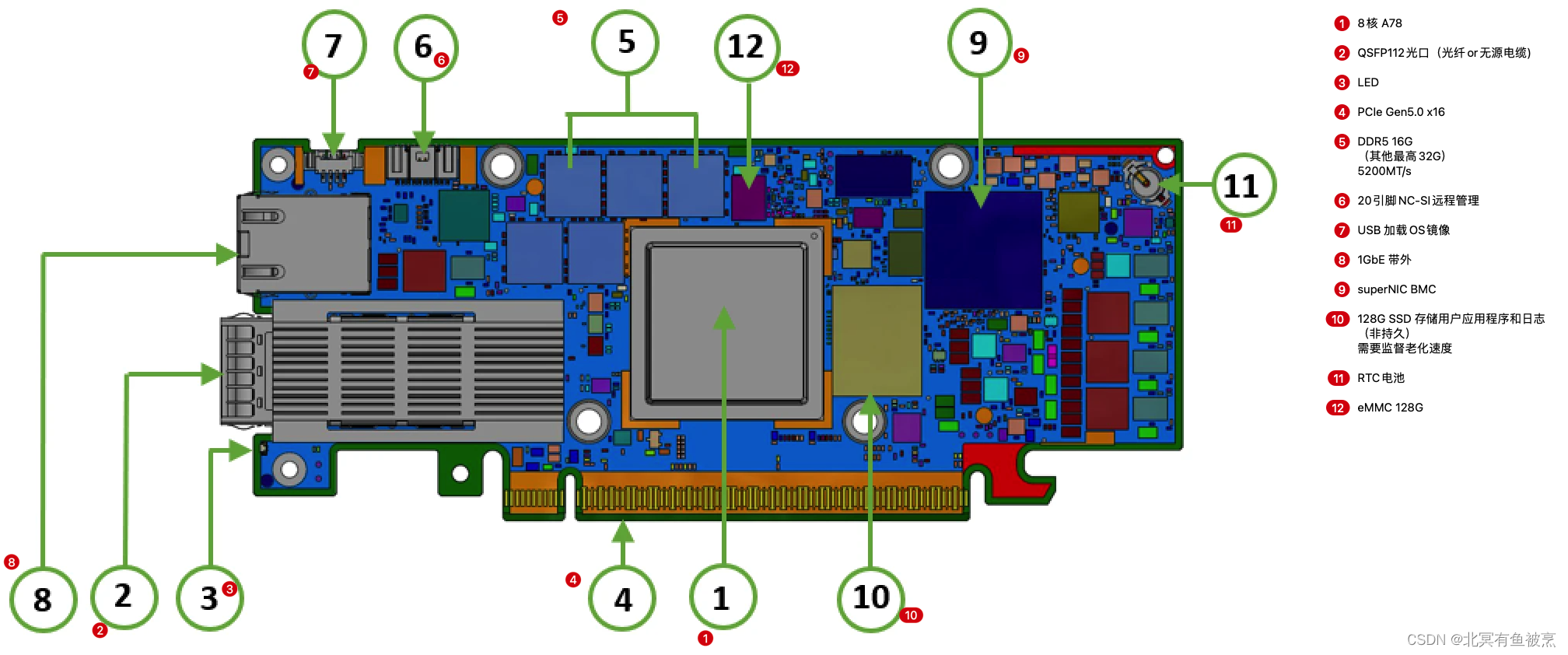

2. BF3硬件布局模块图

本文主要记录HHHL规格的BF3。图片来源 NV官网。

2.1 正面

2.2 背面

2.3 其他要点

- DPU 芯片: 8核 ARM v8.2 A78 + CX7 + PCIe Switch

-

- 内存从DDR4到DDR5。单通道和双通道。单通道是位宽64bit,和ECC 8bit,容量是16GB,这三个子参数同BF2,但速度从3200MT/s升级到DDR5的5200MT/s。 双通道ECC位宽128bit校验,ECC16位;容量都是32GB,速率是5600MT/s。

- 端口LED 2种颜色(黄、绿)

- NC-SI管理接口支持UART调试接口,详细参考:more

- USB接口用来加载OS image

- 最大总功率:150w(金手指75w,标准 PCIe ATX 电源6针 75w)。最好同源

- CPU电源线与BF3 ATX电源不要连接,可能损坏BF3

- eMMC 128G。

- SSD 128G。(新增)(注意BF3的SSD老化问题需要客户自行维护)

- 集成BMC。(新增)

3. 其他

- 从硬件单元和布局角度主要5大类对比:升增删移同(升级 增加 删除 移动 相同(不变))

- 升级分为2类:技术迭代类generation升级的升级(比如CPU从A72到A78,DDR4到5,PCIe从4.0到5.0一般伴随xx代)和容量数量的capacity升级(比如容量升级,比如DDR、eMMC等)。后面简称为Gen和Cap。GC升级对比视角查看。

从BF2到BF的对比:

结论:4个升级,2个新增,0个删除,2个移动位置。

细节:

| 硬件模块 | 升级_代数 | 升级_量容量数量 | 增加 | 删除 | 移动 | 相同_量容量数量 | 备注 |

|---|---|---|---|---|---|---|---|

| 【升G】CPU | Gen: A72到A78(指令V8到V8.2) | - | - | - | - | Cap: 不变8核 | 其他型号可支持16核 |

| 【升G】NIC网卡 | Gen:从CX6DX到CX7 | Cap:双口200G 到 400G | |||||

| 【升G】PCIe | Gen: 4.0 -> 5.0 | Cap: 双口 256T/s 到 512T/s | - | - | - | Cap: lanes不变最大x16 | |

| 【升G】DDR | Gen: DDR4 -> DDR5 | Cap: 双通道;速率3200MT/s到5200甚至5600。容量多了32G版本 | - | - | 移动向中间靠近CPU | Cap: 均有16G版本 | |

| 【升C】eMMC | - | Cap:从64Gor128G 到 固定128G | - | - | - | - | |

| 【增】SSD | - | - | 新增(128G) | - | 中上靠近CPU,紧邻DDR | - | |

| 【增】集成BMC | - | - | 新增 | - | 中右上,原来DDR位置 - | ||

| 【移】USB4.0 | - | - | - | - | 从靠机内到靠机外和NC-SI靠近 | - | |

| 【移】RTC电池 | - | - | - | - | 从内底部到内顶部,依然在边缘 | - | |

| 【同】最大功率 | - | - | - | - | - | Cap: 不变,均最大支持150W |

其他:

- BF2 70亿晶体管,BF3 220亿晶体管,BF4 640亿晶体管(和A100类似)

- BF2 200G,BF3 400G, BF4 800G

- BF2 算力0.7T,BF3 1.5T,BF4 1000T?

- 从移动位置层面看有2点变化:

-

- 缩短高频信号传输距离:BF3将DDR、eMMC、SSD均放到了离CPU最近的位置。估计是考虑到性能损失、电磁干扰、散热等方面。也体现了BF3对极致性能的要求。

-

- 聚拢接口类功能单元:BF3将USB接口和NC-SI接口,都逐渐聚拢并且靠机外部分,将RJ45、光口等多个接口逐渐聚拢。这点估计是BF2在实测环境中各种server结构不便于USB插拔。也体现了NV在DPU结构层面逐渐领先其他厂商的一个nowhow的point。

-

- (YY)另外BF系列DPU的散热在实际工况环境,在数据中心的server中被动散热相对较好,但是非server场景很容易过热(就当一个150w的灯泡被罩在一个封闭盒子中甚至没有风扇)。希望后期迭代系列能够固化提供风扇相关接口,标准化模块化起来。

- (YY)目前DPU从功耗、结构层面的发展,逐渐走着GPU显卡的路子(甚至生态DOCA建设更加类似)。预估未来随着offload能力的逐渐增强,大风扇、多U占用结构、多接口、独立供电都要来。DPU越来越像一台高性能网络的家用主机,期待越来越像一套高性能网络的数据中心主机。未来大模型训练分布式节点似乎都不需要CPU参与了,DPU配GPU作为分布式节点直接全量offload。

- (YY)随着性能需求的提升,本质上数据搬运的能量密度越来越高,机房的风火水电需求越来越高,数据中心也因为业务进入新的一轮revolution。而不是iteration了。比如GTC2024发布个DGX GB200 NVL72对机房功耗、冷却都是一个挑战(单机柜风冷极限20Kw,势必转化为液冷。目前数据中心普遍的单机柜100Kw功耗极限都将改造)。随着GPU的发展推动数据中心机房功耗、冷却的迭代,DPU的发展道路上功耗、冷却也将不是绊脚石而是垫脚石。期待20年后的数据中心将会是多么蓬勃的一番景象。

- (YY) 随着液冷的到来,估计未来更换硬件设施也会变得麻烦起来。对可靠性设计、运维都会带来进一步的挑战,值得关注起来。

参考:

https://docs.nvidia.com/networking/display/bf3dpu/supported+interfaces

https://docs.nvidia.com/networking/display/bluefield2dpuvpi/supported+interfaces

1646

1646

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?