高斯模型

这章节主要围绕着多元高斯模型展开,它会是之后咱们看到的很多模型的基础。

多元高斯模型

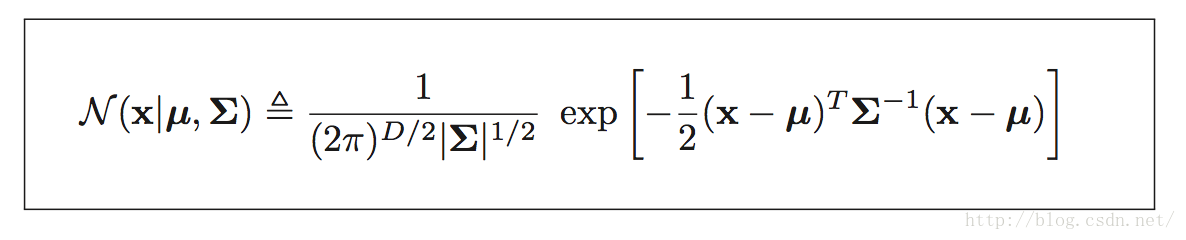

多元高斯模型和一元高斯模型很类似,只是均值变为了均值向量,方差变为了协方差,一维衡量距离的norm 2,在高位扩展成为了Mahalanobis 距离(x−μ)TΣ−1(x−μ)

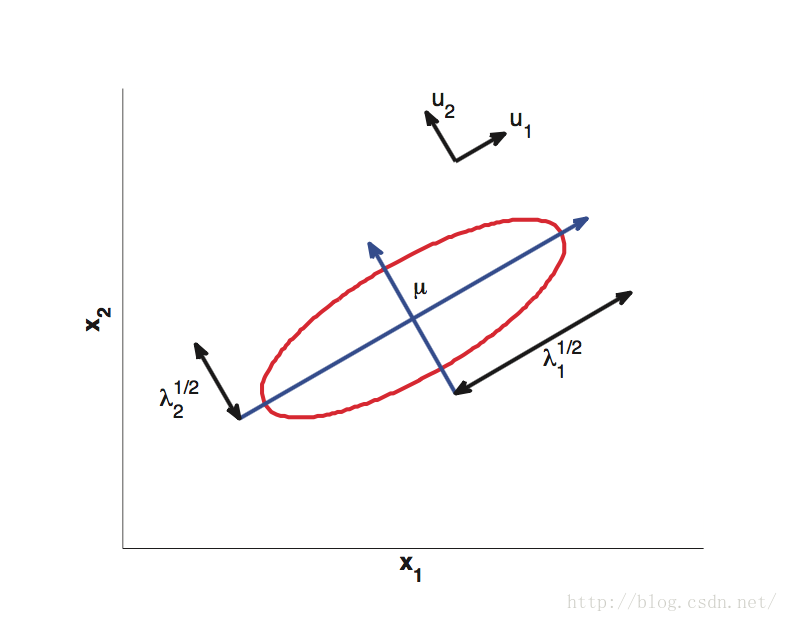

接下来咱们想形象直观的理解高斯模型,首先从多元高斯模型的公式入手推导,由于协方差矩阵是对称的,所以它可以分解为特征向量正交矩阵的样式:Σ = UΛUT

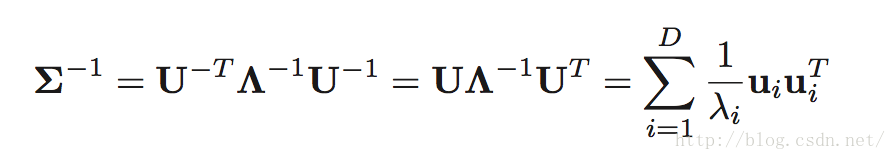

且有:UT U = I ,Λ是其特征值组成的对角矩阵,进而:

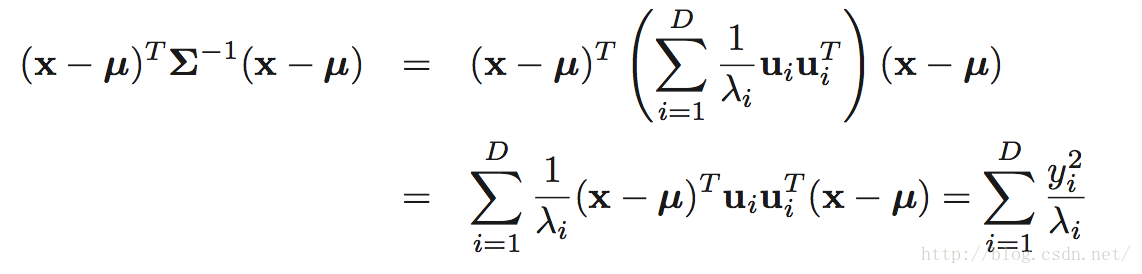

将上公式结果带入多元高斯模型:

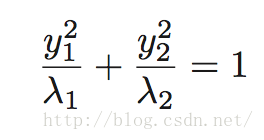

回想椭圆的表达式:

所以这边lamda决定了椭球的各个轴长,而向量u决定了椭球的旋转方向。

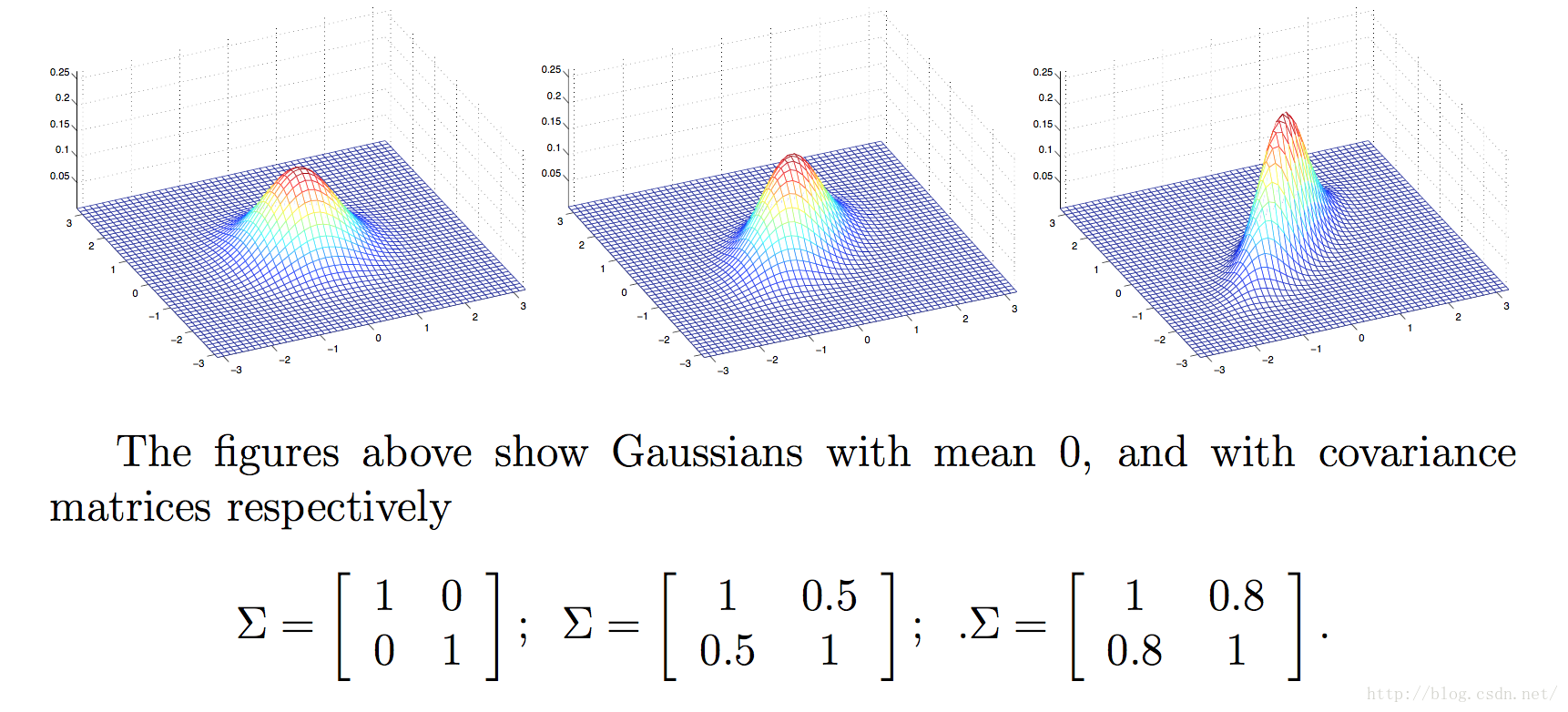

下面来看几个二元高斯模型的实例:

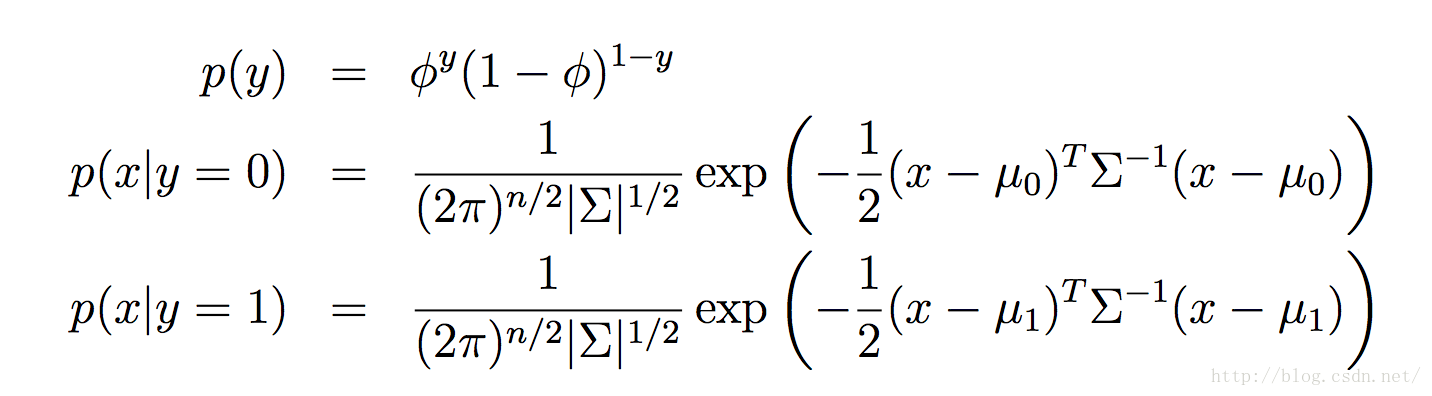

MLE for an MVN (GDA model)

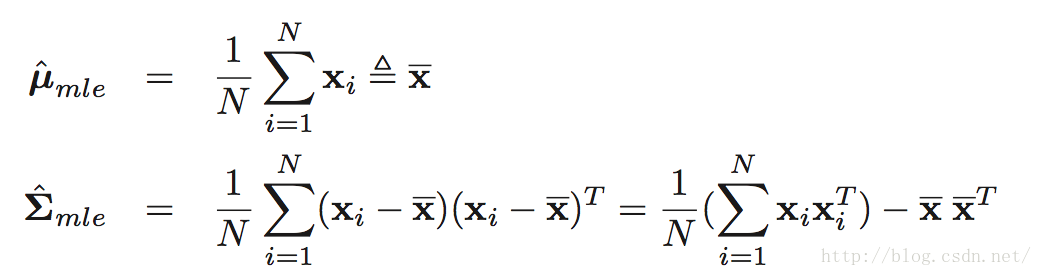

即:

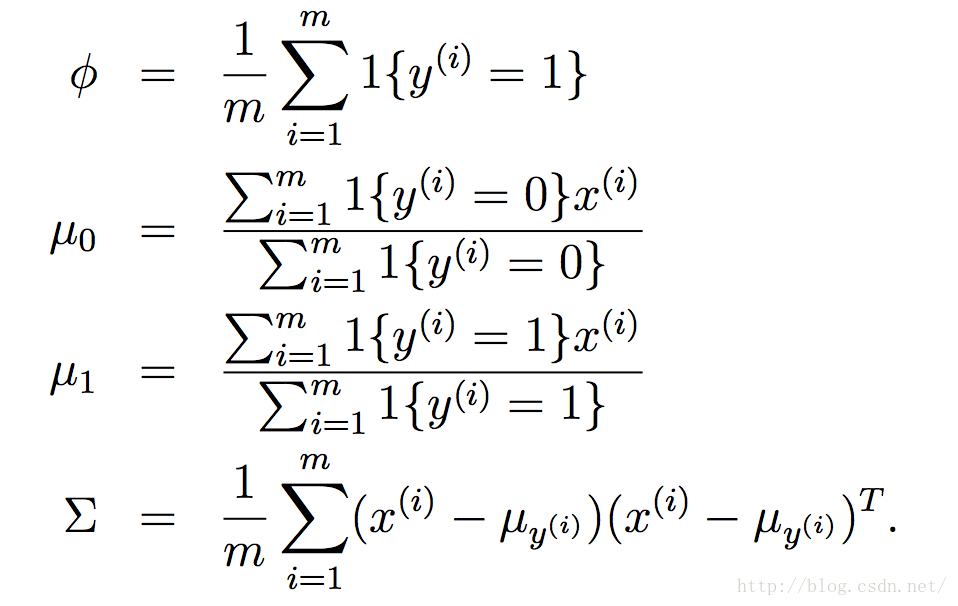

这里咱们的模型中有参数:φ, Σ, μ0 and μ1

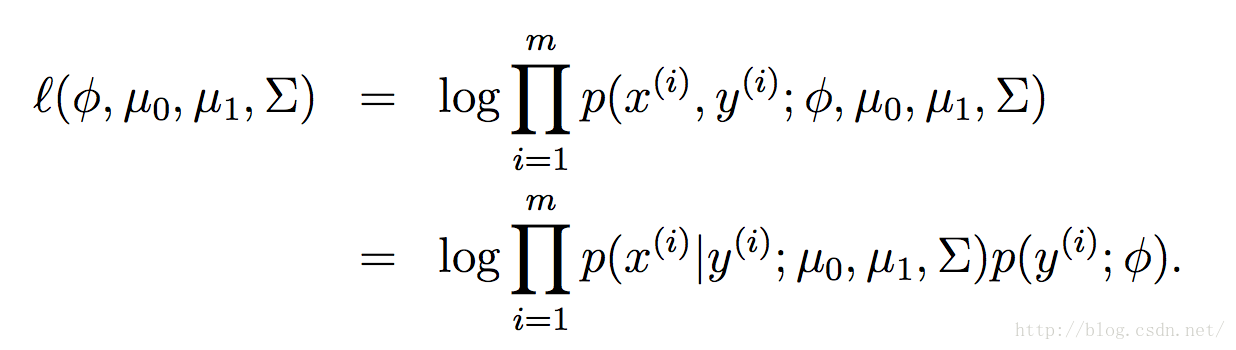

似然函数的log表示为以下形式:

通过最大化似然函数的log,最终咱们可以得到(证明过程较繁琐,省去):

即:

所以最大似然的结果就是,均值和协方差都可以从已有的样本中得到,这样咱们就能够建立两个多元高斯模型了:

接下来咱们的GDA分类器要做的是将新的数据x分别代入到两个模型中,计算出最后的概率,谁大就选谁。咱们进一步仔细观察两个多元高斯模型发现,分类器最终衡量的就是新数据分别到两个模型的Mahalanobis distance ,所以可以表示如下:

所以这也可以叫做最邻近中心分类器。

Quadratic discriminant analysis (QDA)

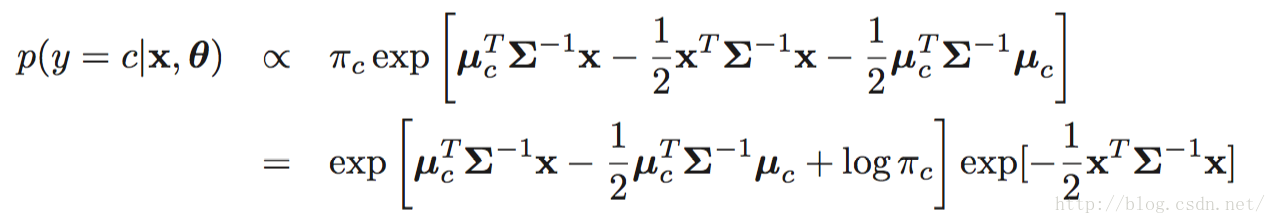

仔细观察发现就是目标类别发生概率占所有类别发生概率的比例,但是这里需要注意的是他们每个多元高斯模型的协方差不一样。

Linear discriminant analysis (LDA)

因为:xT Σ−1x与类别c无关,且分子分母都有,所以可以省去。

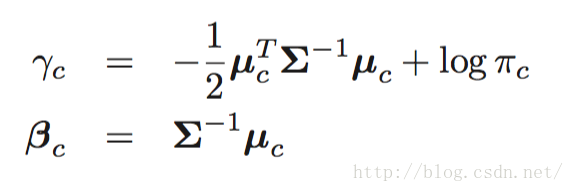

设:

所以原公式可以转化为:

where:

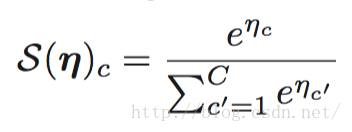

S叫做soft max函数,定义如下:

References

MLAPP

CS229

2646

2646

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?