权值初始化问题

在对神经网络权值初始化时,大家都会选择将其随机初始,如果全赋值为相同数,则会破坏不对称,不应该这样。但如果我们偏要初始化一样,那么会发生什么呢?

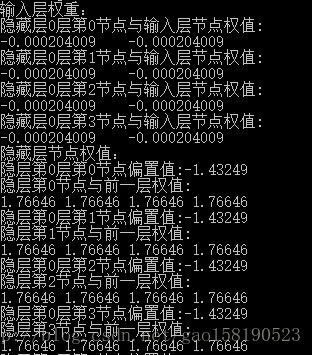

从传递公式上,可以明确,前向传播中,每层的神经网络节点输出值都一样【权值初始化为0比较特殊,我在下文中会对这种情况做详细分析】(这里有个前提:BP网络为全连接,且加入了激活函数,激活函数为sigmod函数),那反向传递时,其权值偏导值应该也是相同的,那么就可以得出:会使每层节点对前一层的所有权值全部相同!但层与层的权值会不相同,做了下实验,将权值全部置为1,偏置置为0,实验结果也证实了这点,如下:

本文探讨了神经网络中权重初始化为相同值的情况。这样做会破坏不对称性,导致前向传播时各层节点输出相同,反向传播时权值偏导值一致,进而使每层节点对前一层的所有权重趋同。实验表明,初始化权重为1,偏置为0时,收敛速度显著减慢。若权重全初始化为0,则因节点输出恒为1/2,反向传播中权值偏导始终为0,无法通过梯度下降法更新权重,从而使得训练无法进行。

本文探讨了神经网络中权重初始化为相同值的情况。这样做会破坏不对称性,导致前向传播时各层节点输出相同,反向传播时权值偏导值一致,进而使每层节点对前一层的所有权重趋同。实验表明,初始化权重为1,偏置为0时,收敛速度显著减慢。若权重全初始化为0,则因节点输出恒为1/2,反向传播中权值偏导始终为0,无法通过梯度下降法更新权重,从而使得训练无法进行。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

295

295

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?