【深度学习基础之激活函数】ReLU、ReLU6 和 GELU 是三种常见的激活函数,它们各自的特点、优缺点和适用场景你了解多少呢?

【深度学习基础之激活函数】ReLU、ReLU6 和 GELU 是三种常见的激活函数,它们各自的特点、优缺点和适用场景你了解多少呢?

文章目录

前言

ReLU、ReLU6 和 GELU 是三种常见的激活函数,它们各有特点、优缺点和适用场景:

1. ReLU (Rectified Linear Unit)

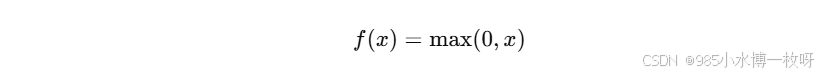

定义:

- 输出为输入值的非负部分,负值部分变为 0。

特点:

- 简单、高效:计算复杂度低,仅需一个阈值判断。

- 稀疏激活:将输入中小于 0 的部分置零,有助于减少过拟合。

- 无梯度消耗:大于 0 的输入梯度始终为 1,减少梯度弥散问题。

优点:

- 计算简单高效。

- 通常在深度网络中收敛速度快。

- 稀疏激活特性有助于提高模型表达能力。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

93

93

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?