SparkShell

简介:spark-shell是Spark自带的交互式Shell程序,方便用户进行交互式编程,用户可以在该命令行下用scala编写spark程序。

spark shell的流程

-

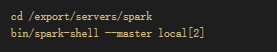

启动 Spark shell

-

进入Spark 安装目录后执行 spark-shell --master master 就可以提交Spark 任务

-

Spark shell 的原理是把每一行 Scala 代码编译成类, 最终交由 Spark 执行

Master的地址可以有如下几种设置方式

具体操作

- 在虚拟机中创建文件

/export/data/wordcount.txt

- 启动Spark shell

- 执行如下代码

本文介绍SparkShell的基本使用方法及如何通过它访问HDFS上的文件。包括启动SparkShell、使用内置的SparkContext对象sc进行基本的数据处理操作,如读取文件、单词计数等,并详细解释了不同方式访问HDFS的具体步骤。

本文介绍SparkShell的基本使用方法及如何通过它访问HDFS上的文件。包括启动SparkShell、使用内置的SparkContext对象sc进行基本的数据处理操作,如读取文件、单词计数等,并详细解释了不同方式访问HDFS的具体步骤。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

525

525

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?