[1] Large Margin Deep Networks for Classification

Gamaleldin F. Elsayed, Dilip Krishnan, Hossein Mobahi, Kevin Regan , Samy Bengio

Google Research

https://papers.nips.cc/paper/7364-large-margin-deep-networks-for-classification.pdf

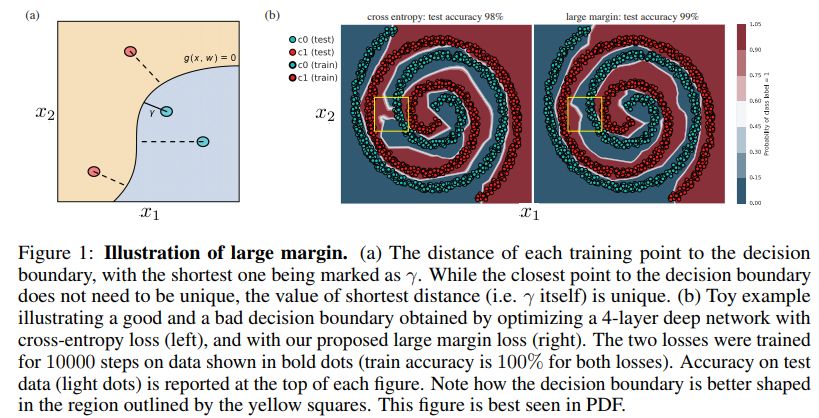

这篇论文提出利用深度学习来产生大间隔分类器。间隔,即最小化决策边界的最小距离,可以成功用于分类和回归任务中。但是,大部分大间隔算法适用于特征表示事先设计好的浅层模型,传统的神经网络中的间隔方法只能使得输出层的间隔较大。因此,这些方法不适合深层网络。

这篇文章提出一种新的损失函数,这种损失函数可以作用于深层网络中的任意一层的间隔,其中包含输入层和隐含层。这种方法中,度量间隔时可以选择任意阶(大于等于1)的范数。

大间隔示例如下

代码地址

https://github.com/google-research/google-research/tree/master/large_margin

![]() 我是分割线

我是分割线![]()

[2] DropMax: Adaptive Variational Softmax

Hae Beom Lee, Juho Lee, Saehoon Kim , Eunho Yang, Sung Ju Hwang

KAIST , AItrics2 , University of Oxford

https://papers.nips.cc/paper/7371-dropmax-adaptive-variational-softmax.pdf

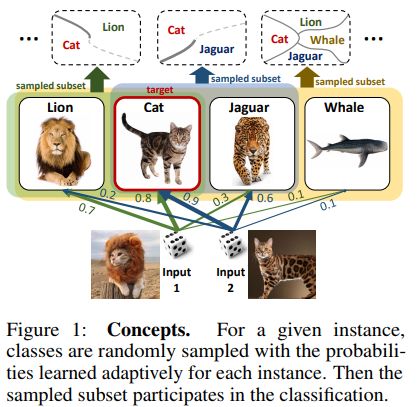

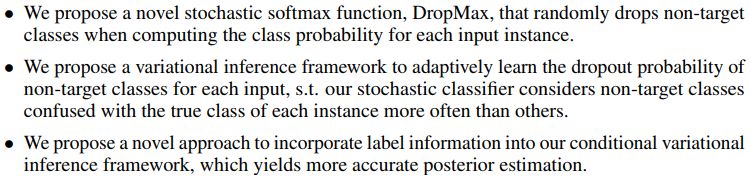

这篇文章提出了DropMax,这种方法是对softmax分类器的一种随机化版本,在每次迭代中都对每个样本对应的自适应dropout概率丢弃掉非目标类别。在类别输出概率中,加入二值掩变量,这些变量是通过变分推理得到的,并且依赖于输入样本自适应学习得到的。这种随机化正则法方便基于具有不同决策面的很多分类器来构建组合分类器。另外,对于非目标列别,在每个样本中dropout率的学习使得分类器更加集中在更难分的类别上。

Concepts示例如下

这篇文章的主要贡献有以下三点

模型结构示例如下

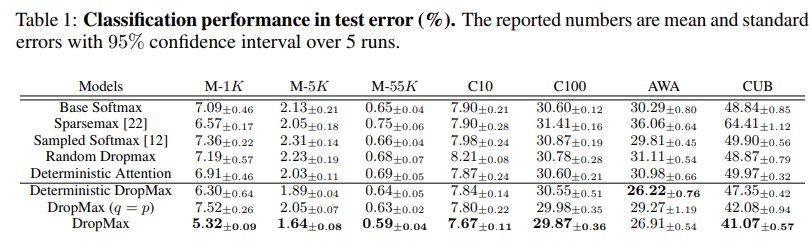

几种方法的效果对比如下

其中sparsemax对应的论文为

From Softmax to Sparsemax: A Sparse Model of Attention and Multi-Label Classification, ICML 2016

代码地址

https://github.com/gokceneraslan/SparseMax.torch

sampled softmax对应的论文为

On Using Very Large Target Vocabulary for Neural Machine Translation, ACL 2015

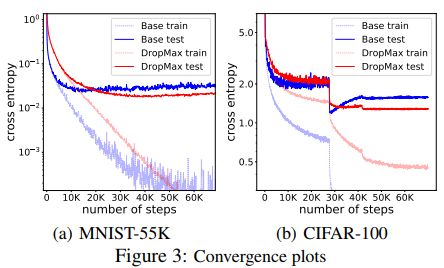

不同情况的收敛对比如下

代码地址

https://github.com/haebeom-lee/dropmax

![]() 我是分割线

我是分割线![]()

[3] FD-GAN: Pose-guided Feature Distilling GAN for Robust Person Re-identification

Yixiao Ge, Zhuowan Li, Haiyu Zhao, Guojun Yin, Shuai Yi, Xiaogang Wang, Hongsheng Li

The Chinese University of Hong Kong, SenseTime Research, Johns Hopkins University, University of Science and Technology of China

https://papers.nips.cc/paper/7398-fd-gan-pose-guided-feature-distilling-gan-for-robust-person-re-identification.pdf

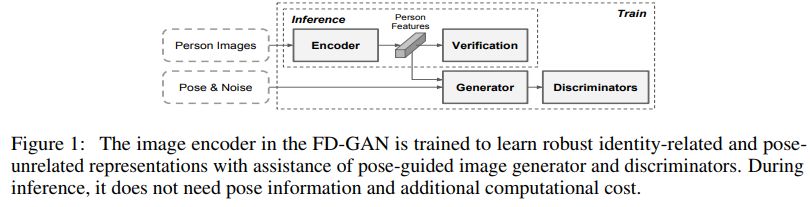

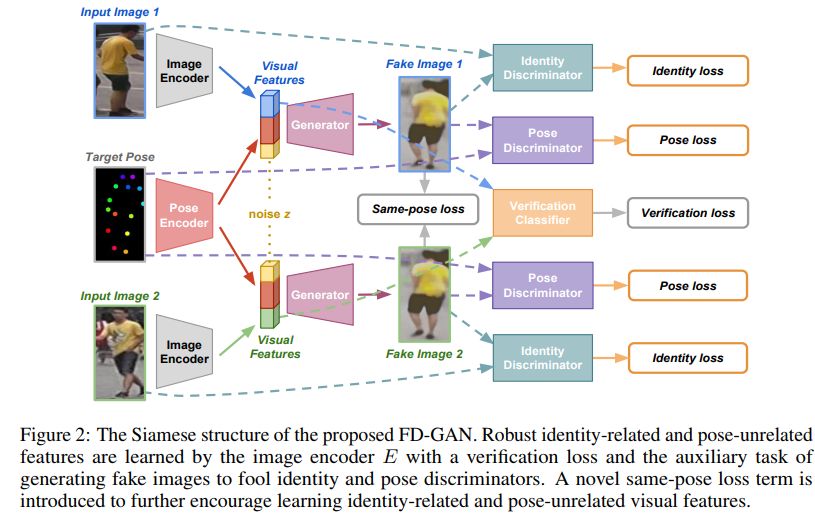

这篇文章提出一种特征精炼的GAN,FD-GAN,用于学习身份相关的和姿势无关的特征表示。这种框架基于姿势和身份特性在多个判别器中学到的Siamese结构。除了判别器之外,还集成了一种新的同姿势的损失函数,这种损失函数要求同一个人生成的图像是相似的。学到姿势无关的特征之后,测试时不需要辅助的姿势信息,也不需要额外的计算损耗。

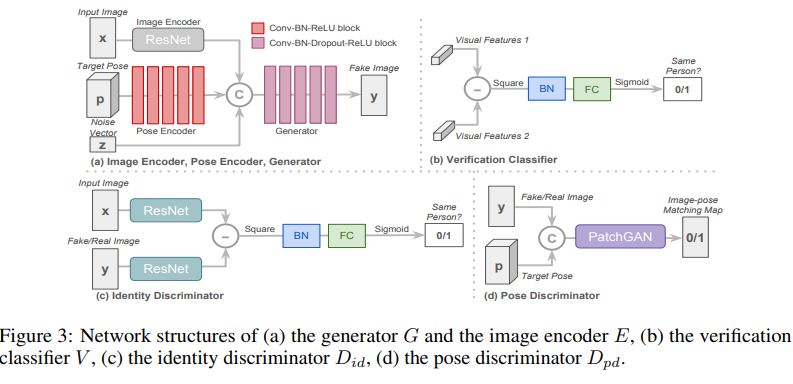

FD-GAN结构示例如下

FD-GAN中的Siamese结构示例如下

FD-GAN的几个组件的结构示例如下

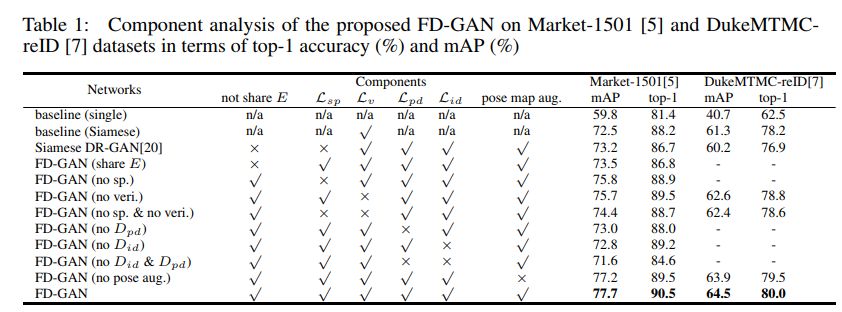

不同情形的成分分析如下

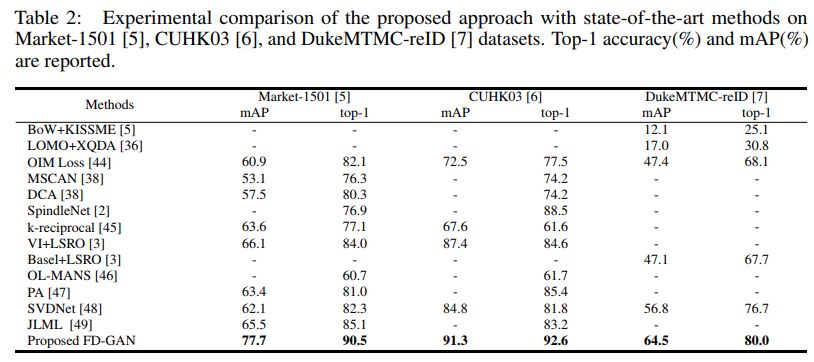

几种方法的效果对比如下

其中BoW+KISSME对应的论文为

Scalable person re-identification: A benchmark,CVPR 2015

LOMO+XQDA对应的论文为

Person re-identification by local maximal occurrence representation and metric learning,CVPR 2015

OIM loss对应的论文为

Joint detection and identification feature learning for person search, CVPR 2017

代码地址

https://github.com/ShuangLI59/person_search

MSCAN对应的论文为

Learning deep context-aware features over body and latent parts for person re-identification, CVPR 2017

相关论文集推荐

https://github.com/cupwater/awesome-person-ReID

Spindlenet对应的论文为

Spindle net: Person re-identification with human body region guided feature decomposition and fusion, CVPR 2017

K-reciprocal对应的论文为

Re-ranking person re-identification with k-reciprocal encoding, CVPR 2017

代码地址

https://github.com/zhunzhong07/person-re-ranking

VI+LSRO 对应的论文为

Unlabeled samples generated by gan improve the person re-identification baseline in vitro, ICCV 2017

代码地址

https://github.com/layumi/Person-reID_GAN

OL-MANS 对应的论文为

Efficient online local metric adaptation via negative samples for person reidentification, CVPR 2017

PA对应的论文为

Deeply-learned part-aligned representations for person re-identification, ICCV 2017

代码地址

https://github.com/zlmzju/part_reid

svdnet对应的论文为

Svdnet for pedestrian retrieval, ICCV 2017

代码地址

https://github.com/syfafterzy/SVDNet-for-Pedestrian-Retrieval

JLML对应的论文为

Person re-identification by deep joint learning of multi-loss classification, IJCAI 2017

代码地址

https://github.com/yxgeee/FD-GAN

![]() 我是分割线

我是分割线![]()

您可能感兴趣

383

383

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?