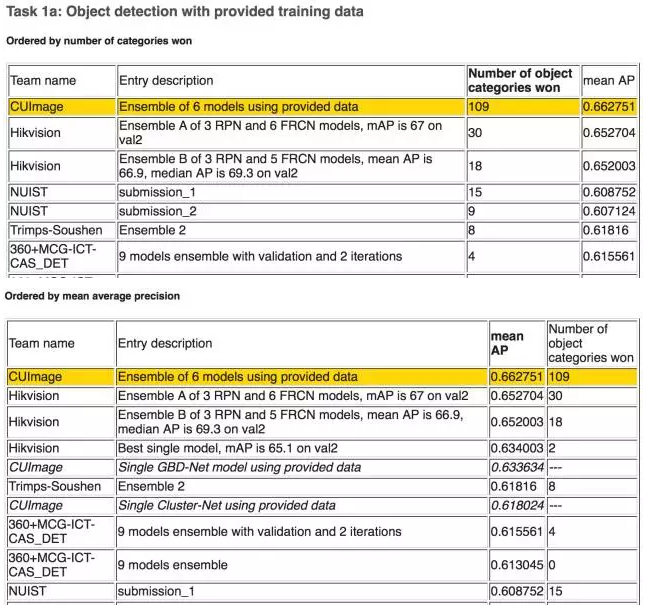

计算机视觉领域权威评测——ImageNet大规模图像识别挑战赛(Large Scale Visual Recognition Challenge)自2010年开始举办以来,一直备受关注。2016年,在该比赛的图像目标检测任务中,国内队伍大放异彩,包揽该任务前五名(如图1所示)。我们将根据前五名参赛队伍提交的摘要与公开发表的论文或技术文档,简析比赛中用到的图像目标检测方法。

总体上说,参赛队伍大多采用ResNet/Inception网络+Faster R-CNN框架,注重网络的预训练,改进RPN,并利用Context信息,测试时结合普遍被使用的多尺度测试、水平翻转、窗口投票等方法,最终融合多个模型得到结果。

下面我们将细数参赛方法中的诸多亮点。

利用Context信息

GBD-Net

GBD-Net(Gated Bi-Directional CNN [1])是CUImage团队的成果,也是今年DET任务中的一大亮点。该方法利用双向门控的CNN网络在不同尺度的上下文窗口中选择性地传递信息,以此对context建模。

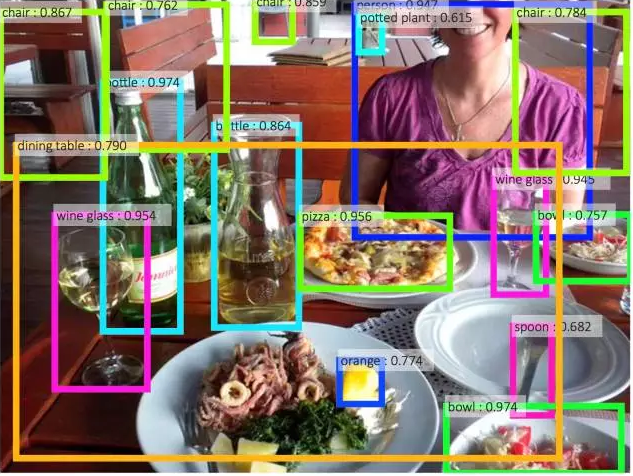

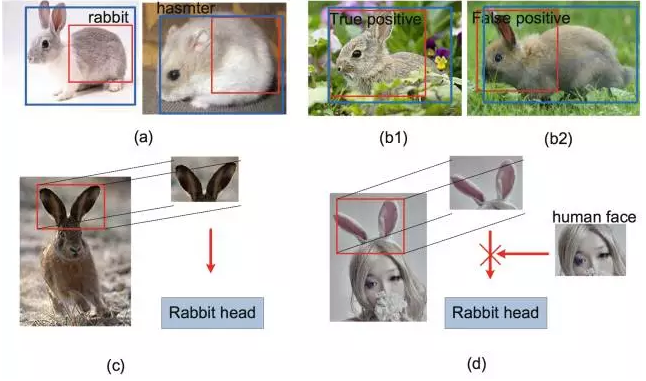

GBD-Net的研究动机源于对context信息在候选窗口分类过程中起到的作用的仔细分析。首先,Context信息在对窗口分类时能起到关键的作用,如图2(a)(b)所示,图中的红框必须结合Context信息才能准确判断其类别(包括判断为背景)。所以很多时候,我们可以利用context信息作出如图1(c)所示的判断。但是如图1(d)所示,并不是所有的context信息都能给我们正确的指导,所以context信息需要选择性的利用。

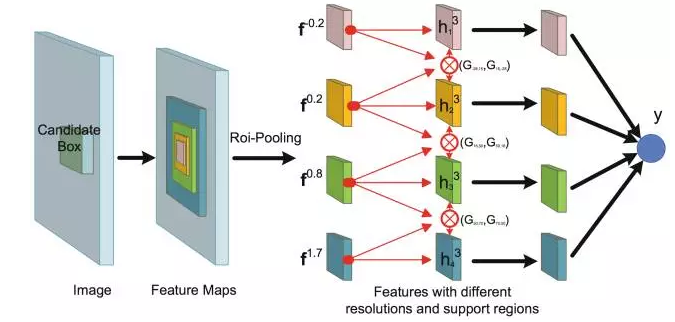

基于这一点,CUImage提出了GBD-Net。如图3所示,GBD-Net采集Context信息的方式与[2][3]一脉相承,直接在目标窗口基础上放大窗口以获得更多的context信息,或缩小窗口以保留更多的目标细节,以此得到多个support region,双向连接的网络让不同尺度和分辨率的信息在每个support region之间相互传递,从而综合学习到最优的特征。然而如研究动机中所说,并非所有的上下文信息都能给决策带来“正能量”,所以在双向互通的连接上都加了一个“门”,以此控制context信息的相互传播。GBD-Net在ImageNet DET数据集上,在ResNet-269为基础网络,带来了2.2%的mAP提升。

Dilation as context

360+MCG-ICG-CAS_DET团队[12]将[4]中提出的用膨胀卷积获取context信息的方法迁移至目标检测任务,将[4]中的8个膨胀卷积层削减到3层,在ROI pooling前就组织好每个像素点对应的context信息,如图4,省去了对每个ROI反复提取conte

本文回顾了2016年ILSVRC图像目标检测任务,国内队伍采用ResNet/Inception+Faster R-CNN,重点关注Context信息、分类损失改进和RPN优化。GBD-Net利用双向门控CNN处理Context,360+MCG-ICG-CAS_DET团队应用膨胀卷积,Hikvision团队引入全局Context。改进的分类损失包括背景子类别和sink类别。RPN改进策略包括级联结构和样本比例调整。预训练、多尺度测试和模型融合等技巧提升检测性能。

本文回顾了2016年ILSVRC图像目标检测任务,国内队伍采用ResNet/Inception+Faster R-CNN,重点关注Context信息、分类损失改进和RPN优化。GBD-Net利用双向门控CNN处理Context,360+MCG-ICG-CAS_DET团队应用膨胀卷积,Hikvision团队引入全局Context。改进的分类损失包括背景子类别和sink类别。RPN改进策略包括级联结构和样本比例调整。预训练、多尺度测试和模型融合等技巧提升检测性能。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

406

406

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?