1 问题:

构造一个输入图像X,令它有水平方向的边缘。如何设计卷积核K来检测图像中水平边缘?如果是对角方向的边缘呢?

解答:

我的理解:检验水平就水平方向上不同

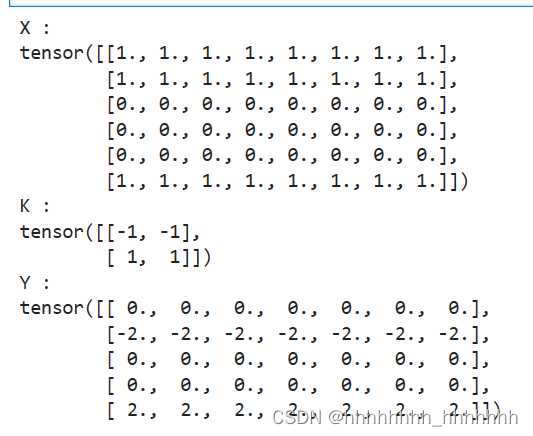

X = torch.ones(6, 8)

X[2:5,:] = 0

print('X :')

print(X)

K = torch.tensor([[-1, -1] ,[1, 1]])

print('K :')

print(K)

Y = corr2d(X, K)

print('Y :')

print(Y)

------------------------------------------------------

X = torch.ones(6, 8)

X[:, 2:6] = 0

X

K = torch.tensor([[1, -1]])

K

Y = corr2d(X, K)

Y在图像处理和计算机视觉中,卷积神经网络(Convolutional Neural Networks, CNNs)通过使用卷积核(或滤波器)来检测图像中的特定特征。卷积核是一个小的矩阵,用于与输入图像的局部区域进行点乘操作,从而提取图像的特征。

水平方向的边缘检测

要检测图像中的水平边缘,你需要设计一个卷积核,该卷积核能够响应水平变化。水平边缘可以通过检测图像行中的亮度变化来识别。一个简单的卷积核,用于检测水平边缘,可能如下所示:

[-1, 0, 1]

这个卷积核也被称为Sobel Gx核。它在中间列的权重为0,而在两边列的权重分别为-1和1。当你将这个卷积核应用于图像时,它会在边缘像素处产生高响应,因为边缘像素的亮度与相邻像素的亮度有显著差异。

对角方向的边缘检测

对于对角方向的边缘,你需要一个能够检测图像对角线方向变化的卷积核。一个简单的卷积核,用于检测45度对角边缘,可能如下所示:

[-1, -1, -1] [ 0, 0, 0] [ 1, 1, 1]

这个卷积核也被称为Prewitt核或Sobel Gy核。它在对角线上的权重为-1和1,而在非对角线上的权重为0。当这个卷积核应用于图像时,它会在对角线方向的边缘像素处产生高响应。

应用卷积核

在实际应用中,卷积核的大小和形状可以根据需要进行调整。例如,使用3x3或5x5的卷积核可以提供更精细的边缘检测。此外,还可以使用多个卷积核来检测不同方向的边缘,然后将结果合并以获得更全面的边缘信息。

在卷积神经网络中,这些卷积核通常是通过学习得到的,网络会在训练过程中自动调整卷积核的权重,以便更好地检测和识别图像中的特征。然而,对于简单的边缘检测任务,上述手工设计的卷积核可以作为一个很好的起点。

2

问题:

试着对我们自己构造的Conv2D类进行自动求梯度,会有什么样的错误信息?在该类的forward函数里,将corr2d函数替换成nd.Convolution类使得自动求梯度变得可行。

解答:

element 0 of tensors does not require grad and does not have a grad_fn

虽然我们之前构造了Conv2D类,但由于corr2d使用了对单个元素赋值([i, j]=)的操作因而无法自动求梯度。

在 PyTorch 中,corr2d 函数是 nn.Conv2d 模块的一个低级接口,它执行二维卷积操作。然而,corr2d 函数通常不推荐用于大多数任务,因为它不会自动处理自动微分和梯度计算,这在神经网络的训练过程中是必需的。

nd.Convolution 类是 PyTorch 中用于二维卷积的高级接口,它提供了自动梯度计算的功能。当你使用 nd.Convolution 类时,PyTorch 能够自动计算关于输入数据的梯度,这对于神经网络的反向传播至关重要。

import torch import torch.nn as nn class Conv2D(nn.Module): def __init__(self, in_channels, out_channels, kernel_size, stride=1, padding=0): super(Conv2D, self).__init__() # 初始化卷积层 self.conv = nn.Conv2d(in_channels, out_channels, kernel_size, stride, padding, bias=True) def forward(self, x): # 使用卷积层进行前向传播 return self.conv(x)

在这个修改后的类中,我们使用 nn.Conv2d 来创建一个卷积层,它接受以下参数:

in_channels: 输入数据的通道数。out_channels: 输出数据的通道数,也就是卷积核的数量。kernel_size: 卷积核的大小,可以是一个整数或者一个由两个整数组成的元组,分别表示卷积核的高度和宽度。stride: 卷积时滑动的步长,默认为1。padding: 在输入数据周围填充的零的层数,默认为0。bias: 是否添加偏置项,默认为True。

使用 nn.Conv2d 的好处是,它会自动创建并更新权重和偏置参数,同时在训练过程中自动计算梯度。这意味着你不需要手动实现卷积操作和梯度计算,PyTorch 会为你处理这些细节。

此外,nn.Conv2d 还提供了更多的功能和选项,比如不同的填充方式、扩张卷积、分组卷积等,这些都可以帮助你构建更复杂和高效的神经网络模型。因此,在实际应用中,使用 nn.Conv2d 是更好的选择。

3 如何通过变化输入和核数组将互相关运算表示成一个矩阵乘法?

互相关运算可以通过矩阵乘法来表示,这是一种在卷积神经网络中常用的技巧,称为快速傅里叶变换(FFT)加速卷积。这种方法利用了卷积定理,即卷积在时域中可以通过在频域中进行元素乘法来实现。

以下是将互相关运算转换为矩阵乘法的步骤:

1. **准备输入和卷积核**:

- 假设你有一个输入数组 `x`,它代表了一个二维信号或图像。

- 假设你有一个卷积核 `h`,它代表了一个二维卷积核。2. **计算尺寸**:

- 确定输出矩阵的尺寸。这通常是根据输入数组和卷积核的尺寸以及步长(stride)和填充(padding)来计算的。3. **创建互相关矩阵**:

- 初始化一个输出矩阵 `y`,其尺寸根据步骤2计算得出。

- 对于输出矩阵中的每个位置 `(i, j)`,计算输入数组 `x` 和卷积核 `h` 在该位置的互相关。4. **使用FFT转换为频域**:

- 对输入数组 `x` 和卷积核 `h` 使用快速傅里叶变换(FFT)来获得它们在频域中的表示 `X` 和 `H`。

- 注意:为了使矩阵乘法有效,`x` 和 `h` 需要填充(padding)到足够的尺寸,以便在频域中进行元素乘法。5. **执行元素乘法**:

- 在频域中,将 `X` 和 `H` 的共轭转置(`H*`)进行元素乘法,得到频域中的输出 `Y`。6. **使用IFFT转换回时域**:

- 对 `Y` 应用逆快速傅里叶变换(IFFT)来获得最终的输出矩阵 `y`。这种方法的优点是,矩阵乘法通常比逐元素的互相关运算更快,特别是在使用现代优化库和硬件加速时。此外,FFT算法的时间复杂度是 O(n log n),其中 n 是输入数据的尺寸,这比直接计算互相关的 O(n^2) 时间复杂度要快得多。

需要注意的是,这种方法要求输入数组和卷积核的尺寸能够被FFT算法的优化尺寸整除,例如2的幂次。如果尺寸不是最优的,可能需要进行填充以获得更好的性能。此外,这种方法在处理边界效应时也需要特别注意,因为填充会影响最终的输出结果。

例子:

让我们通过一个简单的例子来说明如何将互相关运算表示为矩阵乘法。假设我们有一个小的一维信号 `x` 和一个一维卷积核 `h`。

1. **定义输入信号和卷积核**:

```

x = [1, 2, 3, 4]

h = [1, 0, -1]

```

这里,`x` 是我们的输入信号,`h` 是我们的卷积核。2. **计算互相关**:

互相关运算可以表示为:

```

y = [(x[0]*h[0]) (x[0]*h[1]) (x[0]*h[2]) (x[1]*h[0]) (x[1]*h[1]) (x[1]*h[2]) (x[2]*h[0]) (x[2]*h[1]) (x[2]*h[2]) (x[3]*h[0]) (x[3]*h[1]) (x[3]*h[2])]

```

这将得到输出 `y`:

```

y = [1, 2, 1, 2, 0, -1, 0, -1, 0, -1]

```3. **转换为矩阵乘法**:

为了将这个过程转换为矩阵乘法,我们需要构建两个矩阵。第一个矩阵是输入信号 `x` 的扩展,它重复了每个元素以匹配卷积核的长度。第二个矩阵是卷积核 `h` 翻转后形成的矩阵。扩展的输入信号矩阵 `X`:

```

X = [[1, 1, 1],

[2, 2, 2],

[3, 3, 3],

[4, 4, 4]]

```卷积核矩阵 `H`(注意 `h` 被翻转了):

```

H = [[ 1, 0, -1],

[ 1, 0, -1],

[ 1, 0, -1]]

```4. **执行矩阵乘法**:

现在我们可以执行矩阵乘法来得到相同的输出 `y`:

```

y = X * H

```

这里 `*` 表示矩阵乘法。计算结果将是:

```

y = [1*1 + 1*0 + 1*(-1) + 2*1 + 2*0 + 2*(-1) + 3*1 + 3*0 + 3*(-1) + 4*1 + 4*0 + 4*(-1)]

= [1 + 0 - 1 + 2 + 0 - 2 + 3 + 0 - 3 + 4 + 0 - 4]

= [1, 2, 1, 2, 0, -1, 0, -1, 0, -1]

```

这与直接计算互相关得到的结果相同。这个例子展示了如何将一维信号的互相关运算转换为矩阵乘法。对于二维信号(如图像),这个过程类似,但涉及到构建更大的矩阵,并且卷积核的翻转需要在两个维度上进行。在实际应用中,这种转换可以利用现代计算库中的优化矩阵乘法来加速卷积运算。

4 问题:如何构造一个全连接层来进行物体边缘检测?

全连接层(Fully Connected Layer,简称FC层)通常用于神经网络中的分类或回归任务,而不是直接用于边缘检测。边缘检测通常是卷积神经网络(Convolutional Neural Networks,简称CNN)中卷积层的任务。然而,如果你想要使用全连接层来进行简单的边缘检测,你需要构建一个特殊的网络结构,并采用一些创造性的方法。

以下是一个可能的方法来构造一个包含全连接层的网络进行边缘检测:

1. **预处理**:

- 首先,你需要一个预训练的卷积神经网络,该网络在大型数据集上进行了图像分类或特征提取的训练。

- 使用这个网络作为特征提取器,对输入图像进行前向传播,以获取高级特征图。

2. **特征选择**:

- 从卷积层的输出中选择一些特征图,这些特征图应该能够捕捉到边缘信息。通常,较低层的特征图可能更适合捕捉边缘和纹理信息。

3. **池化层**:

- 使用池化层(如最大池化或平均池化)来降低特征图的空间维度,这样可以减少全连接层的参数数量,同时保留重要的边缘特征。

4. **全连接层**:

- 添加一个或多个全连接层来处理池化后的特征。这些全连接层可以学习特征之间的复杂关系,并将这些关系映射到边缘检测任务上。

- 全连接层的输出维度应该与边缘检测任务的类别数相匹配。例如,如果你的任务是二分类(有边缘或无边缘),那么全连接层的输出维度应该是1。

5. **激活函数**:

- 使用适当的激活函数,如Sigmoid或Softmax,根据任务的性质将输出转换为概率。

6. **损失函数和优化**:

- 定义一个损失函数,如二元交叉熵损失(对于二分类任务),并使用优化算法(如Adam或SGD)来训练网络。

7. **训练和评估**:

- 使用带有标签的边缘检测数据集来训练网络。标签可以是二值图像,其中边缘像素标记为1,非边缘像素标记为0。

- 在训练过程中,网络应该学习如何从输入图像中提取边缘特征,并通过全连接层输出边缘存在的概率。

需要注意的是,这种方法并不是边缘检测的标准做法。通常,边缘检测是通过卷积层直接在图像上应用滤波器来完成的,而不是通过全连接层进行特征映射。全连接层在边缘检测中的应用通常需要额外的创新和实验来验证其有效性。在实际应用中,你可能会发现直接使用专门为边缘检测设计的卷积神经网络(如Canny边缘检测器的深度学习版本)会更加高效和准确。

《动手学深度学习》-学习笔记-5.1. 二维卷积层_构造一个输入图像x,令它有水平方向的边缘。如何设计卷积核k来检测图像中水平边缘?-CSDN博客

3335

3335

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?