Batch Normalization

BN主要解决了Internal Covariate Shift问题,该问题的意思是在深度神经网络中,每层的参数都在不断的更新,导致了隐含层的输入分布一直不断的变化,不符合监督学习的IID条件。同时,分布的不断变化,会导致收敛的难度增大,收敛速度变慢。BN的思想,是把mini-batch输入的分布尽量保持一致,降低收敛难度,提升收敛速度。同时,当同一个样本处在不同mini-batch中时,会经过不同的转换,变相进行了数据增强。在测试时,使用的是训练集得到的统计数据进行转换。

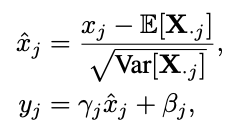

和

表示一个神经网络的输入和输出,

表示第j列输入数据,

和

表示两个可学习的参数。

Batch 顾名思义是对一个batch进行操作。假设我们有 10行 3列 的数据,即我们的batchsize = 10,每一行数据有三个特征,假设这三个特征是【身高、体重、年龄】。那么BN是针对每一列(特征)进行缩放,例如算出【身高】的均值与方差,再对身高这一列的10个数据进行缩放。体重和年龄同理。这是一种“列缩放”。

转自: https://zhuanlan.zhihu.com/p/74516930

Layer Normalization

BN存在两个缺陷:

1. batch size的设置,影响训练过程,过小的batch size,并不能反映整体数据集的数据分布。

2. BN对RNN不定长的sequence不友好,若出现个别较深时,计算统计信息较麻烦。

而layer方向相反,它针对的是每一行进行缩放。即只看一笔数据,算出这笔所有特征的均值与方差再缩放。这是一种“行缩放”。

在BN的论文中有提到,理论上来说,几乎所有归一化技术,都能起到平滑损失平面的作用,加速收敛,所以LN也能降低ICS问题。

Instance normalization

BN是对一个mini-batch中所有图片的同一通道进行归一化,而IN是对每个feature map的单一通道进行归一化。

IN适用于风格迁移任务,每张图片对应一种风格,而一个batch中存在多张图片,一起归一化并不合适。

https://zhuanlan.zhihu.com/p/57875010

其中和

相对每个channel是不同的

还有一种CIN (conditional instance normalization)

一组对应一种风格,训练s种风格,新风格需要重新训练模型

Adain normalization

AdaIN(Adaptive Instance Normalization)直接使用一张图片计算和

,直接应用在领一张图片上,完成风格迁移

Group Normalization

GN、IN、LN和BN相比,不依赖与batch size,其中LN可以看做group=1的GN,IN可以看做group=C的GN。

Switchable Normalization

计算均值时,可以使用instance的结果作为中间变量

5759

5759

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?