Test-Time Scaling(TTS)正以其强大的推理扩展能力,引领着大型语言模型(LLM)的新潮流。通过合理的推理计算扩展,TTS 能够显著提升 LLM 在复杂任务中的表现,为实际应用带来前所未有的机遇。这是第一篇关于 Test-Time Scaling 的综述论文。

大家好,我是肆〇柒。今天,我们来聊一个在人工智能领域备受瞩目的新兴技术方向 ——Test-Time Scaling(TTS)。之所以要给大家介绍这篇关于 Test-time scaling 的综述,是因为其具备极为重要的现实落地意义与学习价值。这个方向的核心在于如何在推理阶段进一步挖掘大型语言模型(LLM)的潜力,使其在各种实际应用场景中表现出更强的推理能力和问题解决能力。在现实落地方面,随着大型语言模型在众多领域逐渐承担起关键角色,模型推理能力的强弱直接关乎工作效率与质量。Test-time scaling 技术能够针对性地优化模型在复杂推理任务中的表现,使其更精准、更可靠地完成任务,为实际应用带来更显著的效益提升。而在学习层面,对于研究人员、开发者以及渴望深入了解该领域前沿技术的学习者而言,这篇综述系统地梳理了 Test-time scaling 的各类核心概念、技术手段、应用场景及评估方法,将碎片化的知识点整合成一套完整的知识体系。这非常有助于大家快速构建对该技术的全面认知框架,还可以让大家深入理解不同技术细节背后的原理与逻辑,为进一步工作、学习、创新应用或进行模型开发优化打下坚实基础。无论是初学者希望入门了解,还是专业人士意图拓展视野、挖掘潜在的研究方向,阅读这篇综述都能极大地提高学习效率,避免在海量信息中盲目摸索,使大家站在前人的经验积累之上,更高效地实现知识的汲取。

在过去的几年里,大型语言模型通过数据和参数扩展在预训练阶段取得了巨大的成功,比如 GPT-3、GPT-4 等模型展现了惊人的语言理解和生成能力。然而,随着研究的深入,人们逐渐意识到,仅仅依靠预训练阶段的扩展已经无法满足复杂任务的需求。于是,研究热点逐渐转向了如何在推理阶段进一步提升模型的表现,这就是 Test-Time Scaling(TTS)的由来。

预训练阶段与 Test-time 阶段的缩放范式比较

上图展示了预训练扩展与测试时扩展的对比,我们可以看到 TTS 是如何在推理阶段通过不同的策略来提升模型性能的。

TTS 的重要性体现在它能够直接提升 LLM 在推理阶段的表现,尤其是在那些需要复杂推理和长期规划的任务中,比如数学推理、代码生成、科学问题求解等。通过合理的推理计算扩展,模型能够生成更准确、更可靠的解决方案,从而更好地服务于实际应用。

Pretraining -> Test-time

本文的目标是为大家提供一份全面而系统的 TTS 调研报告。这篇报告由来自香港城市大学、麦吉尔大学、中国人民大学、香港中文大学、Salesforce AI Research、麦格理大学、斯坦福大学和加州大学圣塔芭芭拉分校的研究人员共同撰写。文中将会阐述 TTS 的核心概念,包括它的不同维度(What to Scale、How to Scale、Where to Scale 和 How Well to Scale),探讨它们在实际应用中的方法、优势以及相关研究案例。同时,还会分析 TTS 面临的挑战和未来的发展方向,帮助大家全面了解这一领域。

Test-Time Scaling 的核心维度

下图展示了 TTS 的四维分类体系,包括 What to Scale、How to Scale、Where to Scale 和 How Well to Scale,这为我们后续的讨论提供了一个清晰的框架

测试时扩展研究的分类体系,包括扩展什么(What)、如何扩展(How)、在何处扩展(Where)以及扩展效果如何(How Well)

What to Scale:扩展的形式与内容

随着人工智能领域对大型语言模型(LLM)推理能力要求的不断提高,Test-Time Scaling(TTS)作为一种新兴技术方向,正逐渐受到广泛关注。TTS 在推理阶段对 LLM 的性能进行提升,其核心在于 “What to Scale”,即确定扩展的具体形式与内容。接下来,让我们深入探讨 TTS 中的几种主要扩展形式。

1. 并行扩展(Parallel Scaling)

概念与原理

并行扩展是一种通过生成多个输出并进行聚合来提升模型性能的方法。它可以通过单个模型多次采样或多个模型采样来生成多个输出,然后通过一个聚合函数从这些输出中得出最终答案。这种方法的性能依赖于两个关键因素:覆盖度和聚合质量。

覆盖度指的是模型生成至少一个正确答案的概率。为了增强覆盖度,我们可以通过调整超参数(如采样温度)和输入修改(如提示词重述)来增加解决方案的多样性和可靠性。例如,在数学问题求解中,可以通过不同的采样策略生成多个解法,然后通过投票或其他方式选择最合适的答案。

并行扩展(Parallel Scaling)

实际应用与优势

并行扩展适用于那些需要快速生成多个候选答案的场景,比如在编程任务中尝试不同的实现方式。这种方法的优势在于能够显著提高正确答案出现的概率,尤其是在面对复杂问题时。

在实际应用中,并行扩展的效果显著。例如,在解决复杂数学问题时,通过并行扩展方法生成多个解法,然后通过聚合函数选择最优解,模型的准确性和效率都得到了显著提升。同样,在代码生成任务中,通过并行扩展生成多个代码实现,然后选择最合适的代码,可以显著提高代码的质量和可执行性。

多样性与冗余的关键作用

多样性与冗余是并行扩展的两个关键特性。多样性确保模型能够探索不同的解决方案路径,从而增加正确答案的概率。冗余则通过多个独立尝试来提高正确答案的出现频率。这种特性使得并行扩展在处理高复杂度任务时表现出色。

为了进一步提高并行扩展的效果,可以通过调整采样策略来增强解决方案的多样性。例如,降低采样温度可以减少输出的随机性,生成更一致的解法;而提高采样温度则可以增加输出的随机性,生成更多样化的解法。此外,输入修改(如提示词重述)也可以帮助模型生成不同的解决方案。通过这些方法,可以确保并行扩展在生成多个输出时保持多样性和可靠性,从而提高最终答案的正确性。

2. 序贯扩展(Sequential Scaling)

概念与原理

序贯扩展是 Test-Time Scaling 的一种重要形式,它通过迭代更新中间状态来逐步完善解决方案。这种方式模仿了人类在面对复杂问题时的深思熟虑过程,即先形成初步想法,再不断细化和验证,直到得出最终答案。

工作原理

在序贯扩展中,模型从一个初始状态开始,逐步生成中间结果或初步草稿。这些中间结果会作为下一步推理的输入,模型根据它们不断调整和优化输出。例如,在数学推理任务中,模型可能先生成一个大致的解题思路,然后逐步验证每个步骤的正确性,调整思路以纠正错误或填补遗漏,最终得到完整的解题过程和答案。这种迭代过程允许模型在推理过程中进行自我纠正和自我改进,从而提高问题解决的准确性。

序贯扩展(Sequential Scaling)

序贯扩展的步骤分解

序贯扩展的步骤分解如下:

- 初始状态生成:模型根据输入问题生成一个初步的回答或解决方案。这个初始状态可能是一个不完整的答案、一个大致的思路或一个初步的假设。

- 中间状态更新:模型将初步结果作为新的输入,进一步推理并生成更详细或更准确的中间结果。这一步骤可能涉及对初步结果的验证、细化或修正。

- 迭代推进:重复中间状态更新的过程,直到达到预设的停止条件(如达到最大迭代次数、输出结果稳定等)。在每次迭代中,模型都基于前一次的结果进行优化,逐步接近最终答案。

- 最终结果生成:当满足停止条件时,模型输出最终的答案或解决方案。这个最终结果经过多轮迭代和优化,通常比初始状态更加准确、完整。

序贯扩展的优势

序贯扩展的优势主要体现在以下几个方面:

- 处理复杂推理任务的能力:序贯扩展特别适合那些需要多步骤推理的问题,如数学证明、代码调试和复杂的逻辑推理任务。以数学证明为例,模型可以通过序贯扩展逐步构建证明过程,每一步都验证前一步的正确性并进行必要的调整,从而确保整个证明的严谨性和完整性。

- 自我纠正和改进:在迭代过程中,模型有机会识别并纠正错误。比如在代码生成任务中,序贯扩展可以让模型先生成一个基本的代码框架,然后在后续迭代中检查语法错误、逻辑漏洞并进行修复,最终生成高质量的代码。

- 适应不同问题的灵活性:序贯扩展可以根据问题的复杂程度自动调整推理的深度和广度。对于简单问题,可能只需要少数几次迭代即可得到答案;而对于复杂问题,模型可以进行更深入的探索和推理。

序贯扩展的实际应用

在数学问题求解方面,序贯扩展能够使模型逐步生成详细的解题步骤,并对每一步进行验证和调整,从而提高解题的准确性和完整性。在处理逻辑推理任务时,序贯扩展有助于模型逐步构建严谨的推理链条,确保每一步推理都基于正确的逻辑,最终得到可靠的结论。而在语言推理应用中,序贯扩展可以让模型先理解问题的大致语义,然后逐步深入分析句子结构和语义关系,从而更准确地回答问题。

3. 混合扩展(Hybrid Scaling)

概念与原理

混合扩展是 Test-Time Scaling 领域中一种极具潜力的策略,它巧妙地融合了并行扩展与序贯扩展的优势,打造一个既能广泛探索又能深入挖掘的推理模式。这种策略的核心在于,在每次迭代过程中,模型先并行地生成一批候选解,随后通过序贯筛选的方式,挑选出最有潜力的候选解进行下一步的深入探索,如此循环往复,直到达到预设的迭代次数或找到满意的答案为止。

“混合扩展(Hybrid Scaling)

实际应用与优势

混合扩展特别适用于那些对多样性和深度推理都有较高要求的复杂场景。例如在处理一些多步骤的科学问题求解时,模型首先通过并行扩展生成多种可能的解决方案思路,这就好比在科研初期的头脑风暴阶段,尽可能多地罗列出各种潜在的研究方向和假设。随后,模型借助序贯扩展的筛选机制,对这些思路进行评估和筛选,剔除那些明显不可行或效率低下的方案,对较为有前景的方案则进一步展开深入分析和验证。

这种策略的优势在于,它既避免了单纯并行扩展可能导致的 “浅尝辄止” 问题,又克服了单纯序贯扩展容易陷入 “思维窄巷” 的风险。通过在探索与利用之间动态平衡,混合扩展能够更高效地引导模型进行复杂推理。在处理复杂游戏策略规划任务时,基于混合扩展的方法能够使模型在众多可能的游戏策略中快速筛选出最优解,大幅提高了游戏 AI 的决策质量和效率;在数学证明领域,混合扩展策略帮助模型更高效地探索多种证明思路,提升了证明过程的完整性和正确性。

4. 内部扩展(Internal Scaling)

定义与原理

内部扩展是一种让模型在内部参数中自主确定推理时的计算分配方式,无需依赖外部人类引导策略。这种方式的核心在于通过训练,使模型能够根据任务的复杂性和需求,动态调整自身的推理过程,从而在推理阶段实现更高效、更自主的计算资源利用。内部扩展通常借助结果导向的奖励建模和强化学习(RL)来实现。模型通过与环境的交互不断学习,优化自身的策略,以在推理时生成更长、更复杂的推理链,或者在必要时进行自我评估和修正,进而提升推理的准确性和效率。

实现方式

在实现内部扩展时,模型会经历一个特殊的训练过程。训练数据通常包括多步骤推理任务的示例,如长链式思考(CoT)样本。这些样本展示了如何逐步解决复杂问题,模型通过模仿这些示例来学习推理模式。在训练过程中,模型的参数被调整,以便在推理阶段能够根据任务的需要自主地分配计算资源。例如,当面对一个数学问题时,模型会学习如何逐步分解问题、进行中间计算,并验证每一步的正确性。

应用场景与优势

内部扩展的应用场景非常广泛,尤其在需要快速响应和自主决策的场景中具有显著优势。例如,在实时问答系统中,内部扩展可以使模型在有限的时间内快速生成准确的答案;在自动化智能体任务中,模型能够根据环境的变化实时调整策略,做出最优决策。此外,内部扩展还能提高模型的推理效率,因为它减少了对外部提示或多次调用的依赖,模型能够在一次推理过程中完成更多的思考步骤。

技术细节

内部扩展的技术细节涉及到模型训练和推理过程的优化。在训练阶段,模型需要处理大量的多步骤推理任务,这要求训练数据具有足够的多样性和复杂性。模型通过强化学习不断优化其策略,学习如何在推理过程中动态调整计算资源。这涉及到对模型奖励机制的设计,使得模型能够在推理时获得即时反馈,并根据反馈调整自己的行为。

案例

以一个具体的数学推理任务为例,模型在训练过程中学习了如何逐步解决代数方程。在推理阶段,面对一个新的方程,模型能够自主地进行变量替换、方程变形等操作,并在每一步之后进行自我验证,确保推理的正确性。这种自主推理能力使得模型在处理类似任务时更加高效和准确,同时也展示了内部扩展在提升模型推理能力方面的潜力。

How to Scale:实现方式与技术手段

刚才,我们探讨了 Test-Time Scaling(TTS)中 “What to Scale” 的核心概念,了解了并行扩展、序贯扩展、混合扩展和内部扩展等不同形式及其在提升大型语言模型(LLM)推理能力方面的重要作用。接下来,本文将聚焦于 “How to Scale”,即实现这些扩展的具体方式与技术手段,进一步探索 TTS 技术。

1. 基于调优训练的方法(Tuning-based Approaches)

(1)监督微调(Supervised Finetuning - SFT)

在 Test-Time Scaling(TTS)的实现方式中,基于调优的方法是一类关键的技术手段。它通过直接调整模型的参数或利用外部反馈来增强模型在推理阶段的表现。这类方法主要包括监督微调(Supervised Finetuning - SFT)和强化学习(Reinforcement Learning - RL)。

监督微调是一种通过在特定数据集上进一步训练模型来提升其推理能力的技术。它利用合成或蒸馏的长链式思考(Chain-of-Thought,CoT)数据进行训练,使模型能够学习并模仿专家级的推理过程。

SFT 的核心在于逐步引导模型生成结构化的推理步骤。例如,在数学推理任务中,模型会接触到一系列带有详细解题步骤的问题和答案对。通过模仿这些示例,模型学会如何逐步分解复杂问题,并生成连贯且逻辑严密的推理路径。这种模仿学习的方式对于提升模型在复杂任务中的表现至关重要。

SFT 的优势在于它可以显著提高模型在特定任务上的性能。以数学推理为例,经过监督微调的模型能够更准确地处理涉及多步骤逻辑的问题,如代数方程求解或几何证明。此外,SFT 还可以减少模型在推理过程中出现幻觉(即生成与任务无关或不准确内容)的可能性,因为模型在训练过程中已经学习到了符合任务要求的输出模式。

(2)强化学习(Reinforcement Learning - RL)

强化学习则是一种更为动态和自适应的调优方法。它允许模型在推理过程中通过试错来学习最优的行为策略。在 TTS 的背景下,强化学习通过奖励模型(Reward Model)为模型的推理步骤提供即时反馈,从而指导模型调整其推理策略。

基于奖励模型的 RL 方法利用人类偏好的反馈来训练奖励模型,进而引导模型的推理过程。例如,在代码生成任务中,奖励模型可以评估生成代码的质量和正确性,并根据这些评估结果调整模型的策略。这使得模型能够逐渐学会生成更高效、更准确的代码。

无奖励模型的 RL 方法则侧重于通过探索和利用的平衡来提升模型的推理能力。例如,cDPO 方法通过聚焦于关键或易错区域来提高模型的探索效率,而 FPL 方法则强调通过动态调整采样策略来优化推理路径。这些方法在特定任务中展现了显著的性能提升,尤其是在需要模型进行长期规划和复杂决策的场景中。

RL 的优势在于它能够使模型在缺乏明确指导的情况下自主学习最优策略。与监督微调不同,RL 不依赖于预定义的示例,而是通过与环境的交互来动态调整行为。这种方法特别适用于那些任务目标明确但实现路径多样的场景,如游戏策略规划或科学问题求解。

2. 基于推理的方法(Inference-based Approaches)

在 Test-Time Scaling(TTS)的广阔领域中,基于推理的方法(Inference-based Approaches)占据着举足轻重的地位。这类方法的核心在于,它们并非依赖于离线的模型参数调整,而是在模型实际部署和推理的过程中,动态地分配和利用计算资源。这种动态性使得模型能够根据具体任务的需求,灵活地调整其推理策略,从而在复杂多变的实际应用场景中实现性能的显著提升。

(1) 激励(Stimulation)

激励技术的目的在于激发模型在推理阶段生成更长、更详细的输出,或者产生多个候选输出以供后续处理。这种技术能够促使模型进行更深入的思考,从而提高其解决复杂问题的能力。

在 提示词策略(Prompt Strategy) 方面,一个典型的例子是向模型提供明确的指令,如 “请逐步思考后再作答”("Please think step by step.")。这样的提示词能够引导模型在生成输出时遵循一种逐步推理的方式,从而提高其分解复杂问题的能力。在实际应用中,这种方式对模型进行复杂任务的指导具有显著效果,使模型能够更清晰地展示其推理过程,并生成更具逻辑性和条理性的答案。

解码策略(Decode Strategy) 则通过修改模型的解码过程来实现更长、更详细的输出。例如,注入占位符(Pfau et al., 2024)和预算强制(Muennighoff et al., 2025)等技术,能够让模型在输出过程中逐步构建其答案,而不仅仅是生成一个简单的最终结果。这种方式使得模型的推理过程更加透明,同时也能帮助模型在处理复杂任务时避免遗漏关键步骤。

自我重复策略(Self-Repetition Strategy) 可以通过反复提示模型生成多个输出,从而增加输出的多样性和可靠性。一个常见的策略是在解码阶段多次提示模型,以模拟细化过程。这种方式能够帮助模型从不同角度审视问题,从而提高其生成答案的准确性和完整性。

模型混合策略(Mixture-of-Model Strategy) 则利用多个大型语言模型(LLM)的协同工作,以提高答案的覆盖度和系统的鲁棒性。这些模型可以以并行的方式生成输出,或者在过程中进行协作,从而整合各自的优点。通过这种方式,模型混合策略能够提供更全面的解决方案,增强系统在面对复杂任务时的稳定性和可靠性。

激励技术的总结

上表总结了一些激励技术,这些技术在实际应用中可以通过不同的方式激发模型的推理能力。

(2) 验证(Verification)

验证技术致力于确保模型输出的正确性和可靠性。在推理过程中,验证步骤可以有效过滤错误答案,提升模型的准确性和可信度。

结果验证(Outcome Verification) 主要关注验证模型输出的最终结果。一种常见的方法是使用独立的验证模型对多个候选答案进行评分。这些验证模型通常基于人类反馈或监督数据进行训练,能够对每个候选答案的正确性或质量进行评估。除了直接的模型评分外,还有一种方法是利用自我一致性投票(Wang et al., 2023),即从多个采样输出中选择多数一致的答案作为最终结果。此外,在特定领域如数学和代码生成中,还可以使用工具辅助或启发式检查来进行验证。例如,数学问题的答案可以通过代入原始方程进行验证,而代码则可以通过执行测试用例来确保其正确性。

过程验证(Process Verification) 更注重验证推理过程和中间结果的正确性。基于 LLM 的状态评估器可以对推理过程的每一步进行评估,而自我评估反馈则允许模型在每一步骤后进行自我检查和修正。通过这种方式,过程验证确保了模型的推理过程的最终答案正确,而且每一步骤都符合逻辑和准确性要求。

一些验证技术的总结

上表总结了一些验证技术,这些技术在确保模型输出正确性和可靠性方面发挥着关键作用。

(3) 搜索结果(Search)

搜索技术通过系统性地探索可能的解决方案空间,帮助模型找到最优答案。蒙特卡洛树搜索(MCTS)是一种在 TTS 中广泛应用的搜索算法。MCTS 通过平衡探索和利用,在搜索过程中逐步构建一个搜索树。这一过程包括选择、扩展、模拟和回溯四个阶段,使模型能够在有限的计算资源内找到最优解。MCTS 的优势在于它能够集中计算资源于最有潜力的分支,从而在复杂任务中实现高效的推理。

除了 MCTS,其他搜索算法如深度优先搜索、广度优先搜索和 beam search 等也在 TTS 中有着重要的应用。这些算法的变体和改进能够适应不同的任务需求,在不同的场景下展现出各自的优势。例如,在处理需要长期规划的任务时,深度优先搜索能够深入探索特定路径;而在需要广泛覆盖解空间的任务中,广度优先搜索则能确保不遗漏任何可能的解。

(4) 聚合(Aggregation)

聚合技术通过整合多个模型输出,提升模型决策的可靠性和准确性。选择方法(如多数投票、最佳选择等)和融合方法(如加权融合、生成式融合等)是聚合技术的两种主要类型。

多数投票是一种简单而有效的方法,它通过统计多个模型或采样输出中出现频率最高的答案作为最终结果。这种方法能够提高模型决策的稳定性,尤其在面对不确定性较高的任务时表现出色。最佳选择则侧重于从多个候选答案中挑选出质量最高的一个,这需要一个可靠的评分或排名机制来确保选择的准确性。

加权融合则更进一步,通过为不同的模型输出分配权重,能够更精细地整合信息。这种方式能够充分发挥每个模型的优势,从而生成更高质量的综合答案。生成式融合则利用模型进一步整合多个采样输出,例如通过提示另一个 LLM 将多个候选答案合并为一个更全面的最终答案。

一些聚合技术概述。BoN代表“最佳N选”

上表总结了一些聚合技术,这些技术通过整合多个模型输出,提升模型决策的可靠性和准确性。

下图总结了从 What to Scale 到 How to Scale 的视觉映射和比较,其中也展示了混合扩展如何结合并行和序贯扩展的优势。

从“要做什么”到“如何规模化”

Where to Scale:应用场景与任务领域

上面我们探讨了 Test-Time Scaling(TTS)的 “What to Scale” 和 “How to Scale”,即扩展的形式与内容以及实现这些扩展的具体方式与技术手段。现在,让我们将视角转向 “Where to Scale”,即 TTS 技术在不同应用场景与任务领域中的实践与价值体现。这一部分将为我们展示 TTS 如何在多样化的实际任务中大显身手,解决复杂问题,提升模型性能。

1. 推理密集型任务(Reasoning-intensive Tasks)

推理密集型任务是 TTS 大展身手的关键领域,这类任务要求模型进行深度、结构化的多步推理,对逻辑性、精确性有着严苛的要求,就像让模型在复杂迷宫中找到唯一正确的出口。从数学的抽象推理到科学的跨域整合,TTS 在其中扮演着不可或缺的角色。

数学推理(Mathematical Reasoning)

数学推理是 TTS 的核心战场之一,它是对模型逻辑能力的终极考验,更关乎其在实际场景中的实用性。像 AIME 2024、MATH-500 这样的基准测试,涵盖了从代数几何到微积分的广泛领域,每一个问题都像是一座座需要攀登的高峰。模型需要生成精准的分步解决方案,每一步都必须经得起推敲,容不得半点马虎。

TTS 的并行扩展能够在多个采样中生成不同的解法假设,再经由序贯扩展逐步验证和修正,模型能够更接近正确答案。例如,面对复杂的代数几何问题,模型通过并行扩展生成多个解法假设,再利用序贯扩展逐步验证和修正,从而更接近正确答案。在数学竞赛场景中,TTS 的优势尤为明显。它能够模拟人类数学家的思考方式,逐步拆解问题,验证中间结果,最终得出令人信服的结论。这种能力让模型在解决那些需要高度创造性和逻辑严谨性的问题时,表现得如同经过专业训练的数学专家。

编程与代码生成(Programming & Code Generation)

编程任务是另一片 TTS 大显身手的天地。代码生成不仅仅是语法的堆砌,更是逻辑与创造性的完美结合。在 Codeforces、SWE-bench 等数据集中,模型需要生成语法准确、逻辑严谨且可执行的代码,这背后需要强大的推理能力支撑。

在编程任务中,TTS 的并行扩展能够生成多种可能的代码实现方式,为复杂问题提供多样化的解决方案。序贯扩展则通过迭代调试和优化,逐步修复代码中的错误,提升代码的质量和效率。例如,在一个需要根据图表生成数据处理代码的任务中,TTS 可以先通过并行扩展生成多种可能的代码结构,再利用序贯扩展对代码进行逐步调试和优化,最终生成符合要求的代码。这种能力让模型在编程领域展现出惊人的潜力,为自动化编程和代码优化提供了全新的解决方案。

游戏与策略推理(Game Playing and Strategic Reasoning)

游戏场景是 TTS 展现推理深度的绝佳舞台。像 SysBench 这样的基准测试,要求模型在复杂的游戏环境中进行多轮推理和动态决策。每一步的选择都可能影响最终的胜负,模型需要在有限的时间内做出最优决策。

TTS 的混合扩展在这里发挥着关键作用。它能够在并行生成多个游戏策略后,通过序贯筛选逐步优化策略,最终选择最优的行动方案。例如,在多人在线战术游戏中,TTS 能够实时分析游戏局势,生成多种可能的策略路径,并通过快速验证和筛选,选择最有可能获胜的策略。这种高效的推理能力既提升了模型的游戏表现,又为智能体在复杂环境中的决策提供了有力支持。

科学推理(Scientific Reasoning)

科学推理任务要求模型整合多学科知识,从物理、化学到生物学,进行跨领域的推理和验证。GPQA Diamond、MR-Ben 等基准测试为模型提供了展示其科学推理能力的舞台。

在科学推理任务中,TTS 的价值在于,它能够让模型在面对复杂的科学问题时,逐步分解问题,调用不同领域的知识进行推理,最终得出准确的答案。例如,在解决一个涉及物理和化学的跨学科问题时,模型可以先通过并行扩展生成多个可能的解决方案,再利用序贯扩展对每个方案进行逐步验证和优化,最终得出符合科学原理的答案。这种能力让模型在科学研究和教育领域展现出巨大的潜力,为复杂科学问题的解决提供了新的思路和方法。

一些基准评测集

上表列出了各种基准测试集,这些基准测试涵盖了 TTS 在不同任务领域中的应用场景,为我们提供了丰富的评估依据。

2. 通用任务(General-purpose Tasks)

通用任务涵盖了基础任务、开放性任务、智能体任务、知识密集型任务和多模态任务等多种类型。这些任务的共同特点是需要模型具备广泛的推理能力和适应性,以应对各种不同的应用场景。

(1)基础任务(Basics)

基础任务主要涵盖教育领域的考试和评估,如大学入学考试、研究生入学考试等。这些任务的特点是需要模型在广泛的学科知识基础上进行推理和回答,涵盖数学、语言、科学等多个领域。例如,在中国的高考和研究生入学考试中,模型需要理解复杂的考试题目,进行多步骤推理,并生成符合考试标准的答案。

TTS 在基础任务中的应用能够显著提升模型的准确性和效率。通过并行扩展,模型可以生成多个可能的答案,然后通过多数投票或其他聚合方法选择最合适的答案。序贯扩展则可以帮助模型逐步完善答案,通过自我修正和验证提高正确性。在实际应用中,TTS 方法在基础任务中表现出色。例如,在 AGIEval 和 MMLU-Pro 等基准测试中,TTS 方法显著提高了模型的准确性和效率。模型能够更好地理解和生成符合考试标准的答案,从而在这些任务中取得优异的成绩。

(2)开放性任务(Open-Ended Tasks)

开放性任务主要涉及评论生成、创意写作、问答系统等场景,要求模型生成具有高度多样性和创造性的输出。这些任务的特点是缺乏明确的正确答案,模型需要在生成过程中平衡创造力和逻辑性。

TTS 在开放性任务中的应用主要体现在通过并行扩展生成多个候选答案,然后通过选择或融合方法挑选最合适的输出。例如,在评论生成任务中,模型可以通过并行采样生成多个评论,然后通过多数投票或加权融合选择最具代表性和创造性的评论。序贯扩展在开放性任务中同样发挥重要作用。模型可以通过逐步细化和修正生成的内容,确保输出在逻辑性和连贯性方面达到较高水平。例如,在创意写作任务中,模型可以通过序贯扩展逐步构建故事的框架和细节,最终生成一个完整且富有创意的作品。在实际应用中,TTS 方法在开放性任务中展现了强大的能力。例如,在 AlpacaEval2.0 和 ArenaHard 等基准测试中,TTS 方法显著提高了模型的输出多样性和质量。模型能够生成更具创造性和逻辑性的内容,从而在这些任务中取得优异的表现。

(3)智能体任务(Agentic Tasks)

智能体任务主要涉及在线购物、科学实验、网页导航等需要复杂规划和迭代推理的场景。这些任务的特点是模型需要在与环境的交互中进行多步骤决策,并根据反馈不断调整策略。

TTS 在智能体任务中的应用主要体现在通过序贯扩展和混合扩展来实现复杂规划和动态调整。例如,在在线购物任务中,模型可以通过序贯扩展逐步构建购物策略,从浏览商品到选择商品,再到完成购买,每一步都进行自我修正和优化。混合扩展在智能体任务中也发挥着重要作用。模型可以通过并行扩展生成多个可能的策略,然后通过序贯筛选选择最优的策略进行实施。例如,在科学实验任务中,模型可以通过混合扩展生成多个实验方案,然后逐步验证和优化,最终选择最佳方案进行实施。在实际应用中,TTS 方法在智能体任务中表现出色。例如,在 WebShop 和 WebArena 等基准测试中,TTS 方法显著提高了模型的规划能力和任务完成率。模型能够更好地应对复杂的交互环境,做出更优的决策。

(4)知识密集型任务(Knowledge-intensive Tasks)

知识密集型任务主要涉及从外部知识库检索和合成信息,如问答系统、事实验证、新闻生成等。这些任务的特点是需要模型具备广泛的知识储备,并能够准确地从海量信息中提取和整合有用的知识。

TTS 在知识密集型任务中的应用主要体现在通过并行扩展生成多个可能的答案,然后通过验证和聚合方法确保答案的准确性和可靠性。例如,在问答系统任务中,模型可以通过并行采样生成多个答案,然后通过工具辅助验证和自我一致性检查选择最准确的答案。序贯扩展在知识密集型任务中同样重要。模型可以通过逐步细化和验证生成的内容,确保答案的准确性和完整性。例如,在事实验证任务中,模型可以通过序贯扩展逐步检查和验证生成的事实,最终生成一个准确且可靠的验证结果。在实际应用中,TTS 方法在知识密集型任务中展现了强大的能力。例如,在 SimpleQA 和 C-SimpleQA 等基准测试中,TTS 方法显著提高了模型的答案准确性和知识整合能力。模型能够更好地从外部知识库中提取和整合信息,生成高质量的答案。

(5)多模态任务(Multimodal Tasks)

多模态任务主要涉及视觉数学推理、视觉问答、图像描述生成等需要处理和整合多种类型数据的场景。这些任务的特点是需要模型具备跨模态理解和推理能力,能够有效整合视觉和文本信息。

TTS 在多模态任务中的应用主要体现在通过并行扩展和混合扩展来实现跨模态的有效集成和迭代推理。例如,在视觉数学推理任务中,模型可以通过并行扩展生成多个可能的解决方案,然后通过模态融合方法整合视觉和文本信息,最终选择最准确的答案。序贯扩展在多模态任务中也发挥着重要作用。模型可以通过逐步细化和验证生成的内容,确保输出的准确性和连贯性。例如,在视觉问答任务中,模型可以通过序贯扩展逐步构建答案,从理解图像到生成文本,每一步都进行自我修正和优化。在实际应用中,TTS 方法在多模态任务中表现出色。例如,在 MMMU 和 MathVista 等基准测试中,TTS 方法显著提高了模型的跨模态推理能力和任务表现。模型能够更好地整合视觉和文本信息,生成高质量的答案。

How Well to Scale:评估维度与指标

在前文中,我们深入探讨了 Test-Time Scaling(TTS)的 “What to Scale”“How to Scale” 以及 “Where to Scale”,即扩展的形式与内容、实现这些扩展的具体方式与技术手段,以及 TTS 技术在不同应用场景与任务领域中的实践与价值体现。现在,让我们将视角转向 “How Well to Scale”,即如何评估 TTS 方法的有效性与性能表现。这一部分将为我们提供一套全面的评估框架,以量化和衡量 TTS 方法在各个维度上的表现。

1. 性能(Performance)

在 Test-Time Scaling(TTS)的研究与实践中,性能评估是衡量 TTS 方法有效性最关键的部分。性能指标直接反映了模型在任务上的表现,为研究者提供了优化方向和技术改进的依据。以下是几种核心的性能评估指标,它们共同构成了对 TTS 方法全方位的衡量体系。

Pass@1 是衡量模型在首次输出时生成正确答案能力的指标。它关注的是模型在无任何修正或额外推理步骤的情况下,能否直接输出正确的解决方案。这一指标在需要快速、确定性输出的场景中尤为重要,比如数学推理任务中的单次解法生成或代码生成任务中的初次实现。例如,在 AIME 2024 数学推理竞赛中,模型需要在限定时间内直接输出正确答案,Pass@1 能够精准评估模型的即时正确率,为模型在高压环境下的表现提供直接反馈。

Pass@k(覆盖度) 指标将视野扩展到模型的多次尝试,衡量在 k 次采样输出中至少有一个正确答案的概率。它体现了模型在面对复杂问题时,通过多样本采样提高正确率的能力。在实际应用中,这一指标对于理解模型的探索能力和鲁棒性至关重要。以程序合成为例,模型可能需要尝试多种实现路径才能找到正确的代码逻辑,Pass@k 能够有效评估模型在这一过程中的表现。同时,它也反映了模型在面对不确定性时的应对策略,即通过增加采样次数来提升成功的概率。

Cons@k(一致性 @k) 通过观察 k 次独立采样输出的多数表决结果来评估模型的性能。它既关注答案的正确性,又强调模型输出的一致性和稳定性。在多轮对话系统或需要持续输出的任务中,Cons@k 能够揭示模型是否能够在不同推理路径下保持一致的决策逻辑。例如,当模型在多次推理中都得出相似结论时,这就增加了答案的可信度,也表明模型具有较强的内在一致性。这一指标对于提升用户对模型输出的信任度具有重要意义。

基于竞技场的评估(Pairwise Win Rate)在开放性任务或生成任务中,模型输出的质量往往难以通过单一标准衡量。此时,基于竞技场的评估方法通过比较模型输出与基线或其他模型输出的相对性能来评估模型优劣。例如,在文本生成任务中,可以通过人类评估或自动指标比较模型生成文本与参考文本的流畅性、连贯性和相关性。这种方法可以捕捉模型在特定任务中的优势,还可以揭示其在与其他模型竞争中的相对位置,为模型的进一步优化提供方向。

任务特定指标(Task-Specific Metrics) 对于某些特定领域或任务,如编程竞赛或科学推理,存在一系列独特的评估指标。以编程任务为例,Codeforces 百分位数和 Elo 评分能够精准反映模型在编程能力上的表现,包括代码的正确性、效率以及对复杂算法的掌握程度。这些指标能衡量模型在具体任务中的表现,还能与领域内已有的评价体系接轨,为模型的实际应用提供直接的参考依据。

2. 效率(Efficiency)

在 Test-Time Scaling(TTS)的评估体系中,效率(Efficiency)是一个至关重要的维度。它关系到模型在推理阶段的性能表现,还直接影响到实际应用中的成本效益和可扩展性。效率评估的核心在于量化模型在有限资源下的推理能力,确保其在实际部署中既高效又经济。

(1)Token 成本:精细衡量推理粒度

Token 成本是评估 TTS 方法效率的基础指标,它反映了模型生成每个输出单元(Token)所需的计算资源。在实际应用中,Token 成本直接影响到推理的响应时间和计算开销。例如,一个模型如果在生成详细推理步骤时产生了大量无关或冗余的 Token,其 Token 成本就会显著增加,进而影响整体效率。

优化 Token 成本的关键在于平衡输出的详细程度和信息密度。通过引入针对性的解码策略,如提前终止无关生成、动态调整生成长度等,可以有效减少冗余 Token 的产生。同时,结合提示词优化,明确指定输出格式和内容重点,也能引导模型更高效地生成目标信息。例如,在数学推理任务中,要求模型仅输出关键步骤和公式,而非冗长的解释性文字,从而降低 Token 成本。

(2)基于 FLOPs 的效率分析:全局计算视角

FLOPs(Floating Point Operations)分析从全局视角量化了模型的计算复杂度,它衡量了模型完成一次推理所需的浮点运算次数。对于 TTS 方法而言,FLOPs 分析能够揭示不同扩展策略在计算资源利用上的差异。例如,并行扩展方法由于同时生成多个输出分支,其 FLOPs 消耗通常较高;而序贯扩展方法则通过逐步细化,可能在前期步骤中保持较低的 FLOPs 开销。

在优化基于 FLOPs 的效率时,一方面可以通过模型结构优化,如采用更高效的注意力机制或网络架构,减少单次推理的计算量;另一方面,结合计算资源的动态分配策略,如根据任务难度调整推理步骤数量、在满足精度要求的前提下提前终止计算等,也能显著降低整体 FLOPs 消耗。此外,对于混合扩展方法,合理分配并行和序贯部分的计算预算,使其在探索多样性和利用深度之间达到最佳平衡,也是提升 FLOPs 效率的重要途径。

(3)Underthinking 评分:洞察推理深度与效率的平衡

Underthinking 评分专注于评估模型在推理过程中的思考深度与效率匹配程度。它衡量了模型在生成早期正确思路后,是否能够持续跟进并最终得出正确答案。如果模型在早期阶段就已经产生了关键的正确思路,但却在后续的推理或输出过程中偏离了正确方向,导致最终答案错误,那么其 Underthinking 评分就会较高,表明存在推理深度不足或效率低下的问题。

降低 Underthinking 评分需要从两方面入手:一是强化模型对早期正确思路的识别和锁定能力,通过优化奖励建模或引入自我验证机制,使模型能够更加敏锐地感知到关键思路的价值;二是在推理过程中增加对早期思路的追溯和校验环节,例如在序贯扩展的每一步都回溯到早期关键节点进行一致性检查,确保推理方向的连贯性和正确性。同时,对于内部扩展方法,通过调整模型内部的奖励信号和计算分配策略,鼓励其在早期正确思路的基础上进行更深入且高效的推理拓展,从而减少 Underthinking 现象。

(4)KV 缓存优化:提升存储与检索效率

KV 缓存优化关注的是模型在推理过程中对历史信息存储和检索的效率。在 TTS 方法中,尤其是涉及多步骤推理和多次迭代的场景,KV 缓存的合理管理对于维持推理效率至关重要。例如,在处理长文本推理任务时,如果 KV 缓存不能有效地存储和检索关键信息,就会导致模型反复重新计算或丢失重要上下文,从而增加推理时间和资源消耗。

优化 KV 缓存的策略包括采用更高效的存储结构,如基于重要性排序的缓存更新机制,优先保留对当前推理任务至关重要的信息;同时,结合注意力机制的优化,使模型能够更精准地定位和提取缓存中的相关内容,减少无意义的检索操作。此外,对于混合扩展方法,协调不同推理分支之间的 KV 缓存共享与同步,避免重复存储相似信息,也能有效提升缓存的利用效率,进而增强整个 TTS 过程的效率表现。

3. 可控性(Controllability)

在 Test-Time Scaling(TTS)的应用中,可控性是一个关键的评估维度。它衡量了模型在推理过程中对计算资源和输出行为的控制能力,确保模型能够在指定的约束条件下稳定运行并产生符合预期的结果。

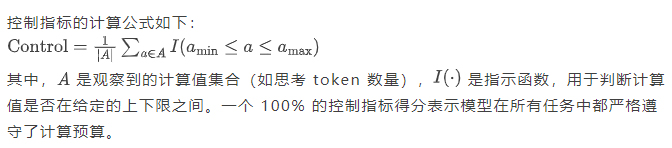

控制指标(Control Metric)

控制指标量化了模型在指定计算预算范围内的执行情况。它通过计算模型在预算范围内的执行比例来评估模型的可控性。例如,在一个固定的 token 预算下,控制指标可以衡量模型是否能够在预算内完成推理任务并生成答案。

在实际应用中,控制指标对于确保模型的高效运行至关重要。例如,在一个实时问答系统中,模型需要在有限的时间内生成答案。通过控制指标,我们可以评估模型是否能够在规定的时间内完成推理任务,从而确保系统的响应速度和用户体验。

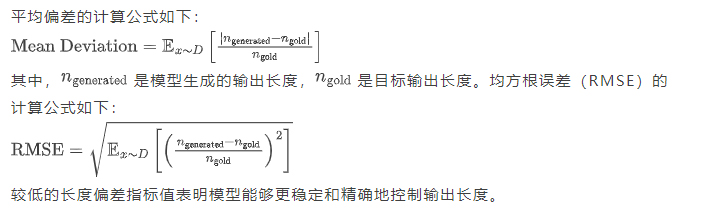

长度偏差指标(Length Deviation Metrics)

长度偏差指标衡量了模型输出长度与目标长度之间的差异。它通过计算平均偏差和均方根误差(RMSE)来评估模型的输出长度控制能力。例如,在一个需要生成固定长度答案的任务中,长度偏差指标可以衡量模型生成答案的长度是否符合预期。

在实际应用中,长度偏差指标对于确保模型输出的格式和规范性非常重要。例如,在一个需要生成固定长度报告的任务中,通过长度偏差指标,我们可以评估模型生成报告的长度是否符合要求,从而确保输出的规范性和一致性。

k–ϵ 可控性(k–ϵ Controllability)

k–ϵ 可控性量化了模型在有界提示长度和允许偏差内产生目标输出的能力。它通过计算模型在提示长度和偏差约束下的输出概率来评估模型的可控性。例如,在一个需要生成特定长度答案的任务中,k–ϵ 可控性可以衡量模型在提示长度和偏差约束下的表现。

k–ϵ 可控性的定义如下:一个模型在提示长度和偏差内是可控的,如果存在一个提示满足,使得模型生成目标输出的概率至少为。

在实际应用中,k–ϵ 可控性对于评估模型的提示响应能力和可转向性具有重要意义。例如,在一个需要生成特定风格和长度文本的任务中,通过 k–ϵ 可控性,我们可以评估模型在提示长度和偏差约束下的输出质量,从而优化提示设计和模型参数。

通过这些可控性评估指标,我们可以全面衡量 TTS 方法在实际应用中的稳定性和可靠性。这些指标可以帮助我们理解模型在计算资源和输出行为方面的表现,也为优化模型的推理过程提供了重要的指导。

4. 可扩展性(Scalability)

在 Test-Time Scaling(TTS)的评估体系中,可扩展性(Scalability)是一个关键的维度。它衡量了 TTS 方法在增加计算资源时提升模型性能的能力。这一维度关乎技术效能,又会直接影响到实际部署中的成本效益分析。

扩展指标(Scaling Metric)

扩展指标是评估可扩展性的核心工具。它通过量化模型性能提升与计算资源增加之间的关系,帮助研究者和工程师理解 TTS 方法的效率。具体而言,扩展指标通常定义为性能提升与计算量增加的比率。例如,在数学推理任务中,如果模型在增加一定量的推理步骤后,准确率提升了特定百分比,这个比率就构成了扩展指标的基础。这一指标的价值在于,它允许我们对不同 TTS 方法进行横向比较,识别出在资源投入与性能回报之间取得最佳平衡的方法。在实际操作中,研究者发现,当计算资源增加到一定程度后,性能提升会逐渐趋于平缓,这就是所谓的 “性能饱和点”。识别这一临界点对于优化资源分配至关重要,因为它告诉我们何时应该停止增加计算量,转而寻求其他优化手段。

扩展曲线(Scaling Curves)

扩展曲线是可视化扩展指标的工具。它以计算资源(如 token 预算、迭代深度或采样数量)为横轴,以性能指标(如准确率、通过率或 EM)为纵轴,绘制出模型性能随计算资源变化的趋势图。通过分析扩展曲线,我们可以直观地观察到模型在不同计算预算下的表现,以及性能提升的边际效应。例如,一条平缓上升的曲线表明模型对计算资源的利用效率较高,即使在资源增加时也能稳定提升性能;而一条逐渐趋于平缓的曲线则提示我们接近了性能饱和点。研究实践中,扩展曲线可用于评估单个 TTS 方法的效率,也可以用于比较不同方法在相同计算预算下的相对优势。这种比较能够帮助我们确定在特定任务和资源条件下,哪一种方法能够提供最优的性能回报。

实际应用中的可扩展性优化

在实际部署 TTS 时,可扩展性的优化是一个复杂而关键的任务。它要求我们在模型性能和计算成本之间找到最佳平衡点。以云服务提供商为例,他们需要在满足用户对智能服务高精度需求的同时,控制运营成本。通过精细调整 TTS 方法的参数,如并行扩展中的采样数量、序贯扩展中的迭代步数等,服务提供商能够在保证服务质量的前提下,显著降低计算开销。此外,结合扩展曲线的分析,他们可以预测在不同负载下的性能表现,提前规划资源分配,避免在计算资源上的过度投资。这种基于数据驱动的资源管理策略,提升了服务的经济效益,增强了系统的响应速度和稳定性,为用户带来更流畅的体验。

可扩展性对 TTS 未来发展的意义

可扩展性评估不仅是对现有 TTS 方法的衡量,更为未来的研究方向提供了重要指引。随着人工智能技术的不断发展,模型规模和复杂度持续增长,如何设计出在大规模计算资源下仍能高效扩展的 TTS 方法,成为了研究的前沿课题。当前的研究趋势显示,混合扩展和内部扩展方法在可扩展性方面展现出较大的潜力。例如,混合扩展通过结合并行和序贯扩展的优势,在处理复杂任务时能够更灵活地分配计算资源;而内部扩展则通过强化学习等技术,使模型能够自主学习最优的推理路径和资源分配策略。这些方法的进一步发展和完善,有望在未来突破现有性能瓶颈,实现 TTS 在更广泛领域的高效应用。

Test-Time Scaling 实际应用建议与指导

上面,我们探讨了 Test-Time Scaling(TTS)的四个核心维度:What to Scale、How to Scale、Where to Scale 和 How Well to Scale。我们了解了 TTS 的不同扩展形式及其应用场景,学习了实现这些扩展的具体技术手段,并认识到 TTS 在提升大型语言模型(LLM)推理能力方面的重要性和潜力。现在,让我们将理论付诸实践,探讨如何将 TTS 技术应用于实际场景,以提升模型在特定任务上的表现,并探索其在新领域的应用潜力。

明确 TTS 适用场景

TTS 的强大之处在于其广泛的适用性,从需要严谨逻辑推理的数学问题到允许创造性表达的开放性任务,TTS 均能发挥作用。在数学推理领域,TTS 可帮助模型探索多种解题路径,验证中间步骤,确保解题过程的严谨性与答案的准确性。例如,面对复杂的代数几何问题,通过并行扩展生成多个解法假设,再经由序贯扩展逐步验证和修正,模型能够更接近正确答案。在代码生成任务中,TTS 能够生成语法正确且逻辑合理的代码片段,并通过自我调试和优化提升代码质量。对于开放性任务,如评论生成或创意写作,TTS 则能激发模型的创造力,生成风格多样、内容丰富的文本,同时保持逻辑连贯性和语义准确性。

快速实施 TTS 流程的路径

对于希望以最低成本快速实现 TTS 的场景,可从以下三种路径入手:

- 推理时的审慎推理程序:引入多步骤推理和验证机制,让模型在推理阶段进行自我检查和修正。例如,要求模型在生成答案前,按照既定的逻辑步骤逐步推导,并在每一步骤后进行自我验证,确保推理过程的合理性。

- 模仿复杂推理轨迹:利用高质量的推理示例对模型进行微调。这些示例可以是领域专家的解决方案或经过验证的优质推理路径。通过模仿这些轨迹,模型能够学习到处理复杂问题的有效方法。

- 基于 RL 的激励机制:使用强化学习激励模型在推理过程中进行自我优化。设定合适的奖励函数,当模型生成符合预期的推理步骤或答案时给予正向反馈,引导模型不断改进推理策略。

如果目标是快速了解 TTS 的潜力上限,建议优先尝试基于 RL 的方法,问题它可以在较短时间内显著提升模型性能。而如果开发 TTS 基线,可以从模仿复杂推理轨迹起步,逐步构建模型的推理能力。

TTS 流程的集成与前沿策略设计

TTS 的真正威力在于其组件的协同工作。以 R1 模型为例,它巧妙地结合了监督微调(SFT)、合成 CoT 方法和结构化推理策略。首先,通过 SFT 让模型学习专家的推理模式,然后利用合成 CoT 方法生成多样化的推理路径,最后借助结构化推理策略对这些路径进行筛选和优化。在实际应用中,你可以根据任务特点灵活组合不同 TTS 方法。例如,在处理复杂游戏策略任务时,可将并行扩展与序贯扩展相结合,先生成多种可能的游戏策略,再逐步评估和优化每种策略,最终确定最优方案。

常用 TTS 方法作为基线

以下是几种常用 TTS 方法及其适用场景,可作为实际应用的参考基线:

- Parallel–Self-Consistency:适用于需要快速生成多个候选答案并进行验证的场景,如多解数学问题或代码生成任务中的不同实现方式探索。通过并行采样生成多个输出,再利用自我一致性聚合机制筛选出最可靠的答案。

- Best-of-N:在需要从多个选项中挑选最佳答案的场景中表现出色,例如在问答系统或分类任务中。生成 N 个候选答案后,依据质量评分函数选择得分最高的答案作为最终输出。

- Sequential–STaR:针对需要逐步完善解决方案的任务,如复杂推理或长文本生成。模型先生成初始草案,再通过序贯推理逐步细化和完善内容,确保输出的完整性和准确性。

- Self-Refine:适合处理模型输出易出现偏差或错误的任务,如文本摘要或数据解读。模型在生成初步结果后,对其进行自我评估和修正,提升输出的质量和可信度。

- PRM:在强调推理过程正确性的任务中具有优势,如数学证明或逻辑推理。过程奖励模型(PRM)对每一步推理进行评估,确保整个推理过程的逻辑性和严谨性。

- Hybrid–MCTS:对于需要在大规模搜索空间中寻找最优解的任务,如围棋 AI 或复杂规划问题,蒙特卡洛树搜索(MCTS)结合并行和序贯扩展,高效探索可能的解决方案。

- ToT:在面对多路径推理问题时,如科学实验设计或复杂系统诊断,Tree-of-Thoughts(ToT)方法通过构建推理树,同时探索多个方向,避免陷入单一错误路径。

- Internal–Distilled-R1:当目标是提升模型的推理效率和自主性时,如实时交互系统或自动化决策场景,内部扩展方法让模型在内部参数中自主确定计算分配,减少对外部提示的依赖。

- R1:在需要综合运用多种 TTS 技术以应对高度复杂任务的场景中,R1 模型的强化学习方法能够有效整合不同 TTS 组件,实现性能的全面提升。

在现有文献中进行推理扩展时常用的组合方式

上表展示了在现有文献中进行推理扩展时常用的组合方法,这些组合方法为我们实际应用 TTS 提供了参考。

关于 TTS 最优解决方案的思考

追求 TTS 的最优解决方案需考虑任务特性、资源限制和性能需求。对于简单任务,过度复杂的 TTS 方法可能导致资源浪费和效率下降。而对于复杂任务,单一方法往往难以满足需求,需综合运用多种 TTS 技术。例如,在处理实时交互任务时,内部扩展方法能快速响应,但在面对需要长期规划的问题时,序贯扩展又不可或缺。因此,最优解决方案是根据具体任务特点和资源条件,通过实验和迭代找到的平衡点。

评估 TTS 方法时,需综合考虑多个维度。性能指标如准确率是核心评估标准,但在实际应用中,效率同样关键。以数学推理任务为例,不仅要关注模型答案的正确性,还需考量其生成答案所需的时间和计算资源。此外,鲁棒性、安全性、偏见和可解释性等次级属性也不可忽视。例如,在医疗诊断任务中,模型的可解释性直接影响医生对诊断结果的信任度,进而影响实际应用效果。

Test-Time Scaling 的局限性与挑战

TTS 的局限性

尽管 Test-Time Scaling(TTS)在提升大型语言模型(LLM)推理能力方面展现出巨大潜力,但它并非万能解决方案。在实际应用中,TTS 面临着一系列局限性和挑战,这些限制影响了性能,还可能在某些场景下导致效率降低或结果质量下降。以下从几个关键方面深入探讨 TTS 的局限性,并结合具体实现细节进行分析。

1. 性能瓶颈

并行扩展的采样噪声问题:并行扩展通过生成多个输出并进行聚合来提升性能,但这种方法存在一个显著的性能瓶颈 —— 采样噪声。由于模型在采样过程中引入的随机性,生成的多个输出可能包含大量噪声,这些噪声会干扰最终答案的选择。例如,在数学推理任务中,模型可能生成多个解法,但其中一些解法可能因采样噪声而偏离正确路径。这种噪声累积效应会降低模型的整体性能,尤其是在采样数量较大时。

序贯扩展的任务迁移难题:序贯扩展通过迭代更新中间状态来逐步完善解决方案,但其性能瓶颈在于任务迁移的难度。不同任务对推理步骤的要求差异很大,模型在一种任务中学习到的推理策略可能无法直接迁移到另一种任务中。例如,在数学证明任务中,模型通过序贯扩展学会了如何逐步验证和调整中间步骤,但当任务切换到哲学推理时,这些策略可能完全失效。这种任务迁移难题导致模型在面对新任务时需要重新学习推理过程,增加了训练成本和时间。

混合扩展的资源分配困境:混合扩展结合了并行和序贯扩展的优点,可平衡探索和利用。然而,这种方法在资源分配上面临困境。由于需要同时管理多个并行候选解和序贯筛选过程,模型的计算资源分配变得极为复杂。例如,在复杂游戏策略规划任务中,模型需要在每一步生成多个候选策略并进行筛选,但如何动态调整资源分配以确保每个候选策略都得到充分评估是一个难题。这种资源分配困境可能导致模型在某些情况下无法充分利用计算资源,从而影响整体性能。

2. 成本效益问题

并行扩展的计算资源消耗:并行扩展通过生成多个输出来提高正确答案的概率,但这种方法对计算资源的需求呈指数级增长。例如,在代码生成任务中,模型需要生成多个代码实现并进行验证,这不仅增加了计算时间,还显著提高了硬件成本。对于资源有限的实际应用场景,这种高计算成本可能使得并行扩展方法难以大规模部署。

序贯扩展的时间成本:序贯扩展通过迭代更新中间状态来逐步完善解决方案,但这种方法的时间成本较高。例如,在科学问题求解任务中,模型需要进行多步骤推理和验证,每一步都需要消耗一定的时间。对于实时性要求较高的应用场景,如自动化智能体的决策任务,这种时间延迟可能严重影响系统的响应速度和用户体验。

混合扩展的实现复杂性:混合扩展结合了并行和序贯扩展的优点,但其实现复杂性较高。需要同时管理多个并行候选解和序贯筛选过程,这增加了模型的开发和维护成本。例如,在多步骤科学问题求解任务中,模型需要在每一步生成多个候选解并进行筛选,同时还要动态调整资源分配。这种复杂的实现过程可能导致开发周期延长和维护成本增加。

3. 实际案例分析

数学推理任务中的错误积累:在数学推理任务中,TTS 方法通过生成多个推理路径并进行筛选来提升性能。然而,模型在生成推理路径时可能会出现错误积累的问题。例如,在解决复杂数学问题时,模型可能在早期步骤中出现错误,这些错误会在后续步骤中逐步放大,最终导致整个推理路径失效。尽管通过自我验证和修正可以部分解决这一问题,但仍然需要进一步优化模型的推理过程。

编程任务中的代码幻觉:在编程任务中,TTS 方法通过自我调试和优化来提升代码生成的准确性和效率。然而,模型可能会生成代码幻觉,即生成的代码在语法上正确但逻辑上有误。例如,在生成复杂算法代码时,模型可能无法正确处理边界条件或异常情况,导致代码在实际运行中出现错误。通过代码验证和测试可以减少幻觉,但这也增加了计算成本和开发时间。

多模态任务中的模态融合难题:在多模态任务中,TTS 方法通过跨模态有效集成和迭代推理来提升模型的性能。然而,模型在融合不同模态信息时可能会遇到模态融合难题。例如,在视觉数学推理任务中,模型需要同时处理图像和文本信息,但如何有效地融合这两种模态的信息是一个挑战。模型可能在图像特征提取或文本语义理解方面存在不足,从而影响最终的推理结果。

局限性小节

TTS 的局限性主要体现在性能瓶颈、成本效益问题和实际应用中的具体挑战。这些局限性会影响模型的性能,还可能在某些场景下导致效率降低或结果质量下降。为了克服这些局限性,需要进一步优化 TTS 方法,提升模型的推理能力,同时降低计算成本和开发复杂性。通过深入研究和实践,TTS 有望在未来实现更广泛的应用和更高的性能表现。

技术细节探讨

在深入了解 Test-Time Scaling(TTS)的各种方法及其应用场景后,我们不得不面对一个现实问题:这些方法在实际应用中并非没有局限性。为了更好地利用 TTS 提升大型语言模型(LLM)的推理能力,我们有必要深入探讨其技术细节,包括强化学习算法和搜索算法的具体实现和优化。

强化学习算法

强化学习(RL)在 TTS 中扮演着至关重要的角色,它使模型能够在推理过程中自主优化其行为,以最大化长期奖励。以 PPO(Proximal Policy Optimization)算法为例,这是一种广泛应用于 TTS 的 RL 算法,因其在策略更新机制和优势函数计算方面的优势而备受青睐。

策略更新机制:PPO 算法通过在策略更新时引入一个信任区域(trust region),确保策略的更新不会过于剧烈,从而避免性能的大幅波动。这种机制在 TTS 中尤为重要,因为模型需要在推理过程中逐步调整其行为,以适应不同任务的需求。

优势函数的计算:优势函数(advantage function)衡量了某个动作相对于平均策略的优劣。在 TTS 中,优势函数可以帮助模型识别哪些推理步骤对最终结果有积极影响,从而指导模型优化其推理路径。

与其他强化学习算法(如 A3C、DDPG)相比,PPO 在 TTS 中具有更好的稳定性和适应性。例如,在数学推理任务中,PPO 能够更有效地引导模型探索不同的推理路径,而不会陷入局部最优解。然而,PPO 的实现也面临一些挑战,如如何选择合适的超参数(如学习率、折扣因子等)以及如何在探索与利用之间取得平衡。

在实际代码实现中,开发人员需要仔细调试这些参数,以确保模型能够在不同的任务中取得最佳性能。例如,学习率过高可能导致模型更新过快,无法稳定收敛;而过低的学习率则可能导致训练过程过于缓慢,影响效率。

以蒙特卡洛树搜索(MCTS)为代表的搜索算法

搜索算法是 TTS 中的另一个关键组件,它通过系统性地探索可能的解决方案空间来提升模型的推理能力。蒙特卡洛树搜索(MCTS)作为一种经典的搜索算法,其在 TTS 中的应用尤为广泛。

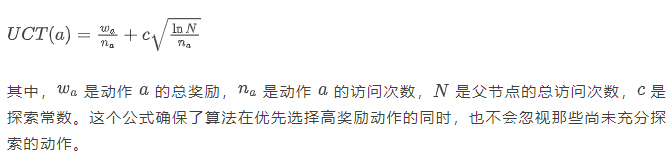

算法流程:MCTS 包括四个主要阶段 —— 选择、扩展、模拟和回溯。在选择阶段,算法根据某种策略(如 UCT 公式)选择最有希望的节点进行扩展。扩展阶段创建新的子节点,模拟阶段进行随机采样以估计节点的价值,最后在回溯阶段更新节点的统计信息。

数学原理:UCT(Upper Confidence Bound for Trees)公式是 MCTS 中的核心数学工具,用于在探索和利用之间取得平衡。公式如下:

优化策略:为了提高 MCTS 在 TTS 中的效率,研究人员提出了一系列优化策略。例如,可以通过并行化搜索过程来减少计算时间,或者利用领域知识来引导搜索方向,从而提高搜索的针对性和效率。

MCTS 在不同任务中的表现也有所不同。在数学推理任务中,MCTS 能够显著提高模型的搜索效率,帮助模型快速找到正确的解决方案。然而,在需要高度创造性的问题中,MCTS 可能表现不佳,因为它倾向于选择那些已经被证明有效的路径,而忽视了可能带来突破性解决方案的探索性路径。

此外,MCTS 的实现也面临一些技术挑战,如如何设计有效的启发式函数来引导搜索,以及如何在大规模搜索空间中高效地管理内存和计算资源。开发人员需要根据具体任务的特点,对 MCTS 算法进行定制化调整,以充分发挥其优势。

实际应用案例

尽管 Test-Time Scaling(TTS)在提升大型语言模型(LLM)推理能力方面展现出巨大潜力,但在实际应用中仍面临诸多挑战和局限性。通过对具体案例的深度剖析,我们可以更好地理解这些问题,并探索解决方案。

数学推理案例(AIME 2024)

在 AIME 2024 数学推理任务中,TTS 的应用主要集中在生成和验证复杂的数学公式以及多步骤推理过程。模型通过并行扩展生成多个可能的解法路径,然后利用序贯扩展逐步细化和验证每个路径的正确性。

具体实现上,模型首先通过提示词引导生成初步的推理步骤:

复制

def generate_initial_steps(problem):

prompt = f"Problem: {problem}\nPlease generate initial reasoning steps:\nStep 1:"

return model.generate(prompt)- 1.

- 2.

- 3.

生成的初始步骤会被进一步扩展和验证:

复制

def refine_and_verify_steps(initial_steps, problem):

refined_steps = []

for step in initial_steps:

verification_prompt = f"Verify if the following step is correct for problem '{problem}': {step}"

verification_result = verifier.generate(verification_prompt)

if verification_result == "Correct":

refined_steps.append(step)

return refined_steps- 1.

- 2.

- 3.

- 4.

- 5.

- 6.

- 7.

- 8.

尽管这种方法显著提高了模型的准确性,但在处理某些复杂数学概念时,模型仍可能出现理解偏差,导致推理过程中的错误积累。例如,在涉及高阶代数几何的问题中,模型可能难以准确理解和应用特定的数学定理。此外,生成和验证多个推理路径会增加计算成本,尤其是在需要实时响应的场景中。

为缓解这些问题,研究者尝试通过提示词优化和链式思考(CoT)策略来增强模型的推理能力。例如,通过在提示词中加入更详细的指导信息:

复制

def optimized_prompt(problem):

return f"Problem: {problem}\nGuidelines: Use the following steps to solve the problem:\n1. Identify the key mathematical concepts.\n2. Apply relevant theorems.\n3. Verify each step.\nPlease generate detailed reasoning steps:"- 1.

- 2.

这种优化方法在一定程度上提高了模型的推理效率和准确性,但仍需进一步研究以实现更高效的推理过程。

编程案例(Codeforces)

在 Codeforces 编程竞赛任务中,TTS 的应用主要集中在生成和调试代码片段,以及优化代码结构以提高执行效率。模型通过并行扩展生成多个可能的代码实现,然后利用序贯扩展逐步调试和优化代码。

具体实现上,模型首先生成初步的代码片段:

复制

def generate_initial_code(problem):

prompt = f"Problem: {problem}\nGenerate initial code solution:\n"

return model.generate(prompt)- 1.

- 2.

- 3.

生成的代码片段会被进一步调试和优化:

复制

def debug_and_optimize_code(initial_code, problem):

debugged_code = []

for code in initial_code:

debugging_prompt = f"Debug the following code for problem '{problem}':\n{code}\nIdentify and fix errors:"

debugged_code.append(debugger.generate(debugging_prompt))

return debugged_code- 1.

- 2.

- 3.

- 4.

- 5.

- 6.

尽管这种方法显著提高了代码生成的准确性和效率,但模型仍可能生成在语法上正确但逻辑上有误的代码(即代码幻觉)。此外,调试和优化过程可能需要多次迭代,增加了计算成本。

为减少代码幻觉问题,研究者引入了代码验证和测试机制。例如,通过生成测试用例并验证代码输出:

复制

def validate_code(code, problem):

test_cases = generate_test_cases(problem)

for test_case in test_cases:

input_data = test_case["input"]

expected_output = test_case["output"]

actual_output = execute_code(code, input_data)

if actual_output != expected_output:

return False

return True- 1.

- 2.

- 3.

- 4.

- 5.

- 6.

- 7.

- 8.

- 9.

这种验证机制有效减少了代码幻觉,但同时也增加了计算开销。未来研究方向包括优化验证机制以提高效率,以及探索更高效的调试策略。

通过这些案例,我们看到 TTS 在实际应用中面临的挑战主要集中在性能瓶颈、成本效益问题以及模型对特定领域知识的理解能力。解决这些问题需要进一步的技术创新和优化,例如通过提示词优化、链式思考策略以及高效的验证机制来提升模型的推理能力和效率。这些努力将推动 TTS 技术在更多领域的应用和发展。

Test-Time Scaling 的发展趋势、挑战与未来方向

在前文中,我们深入探讨了 Test-Time Scaling(TTS)的四个核心维度,包括其扩展形式、实现方式、应用场景以及性能评估等关键内容。现在,让我们将目光投向未来,分析 TTS 技术的发展趋势、面临的挑战以及未来的研究方向。这一部分将为我们提供对 TTS 技术前景的深刻洞察,帮助我们把握技术发展的脉络,为未来的研究和应用做好准备。

发展趋势

1. 深度融合与协同优化

TTS 的发展正朝着深度融合多种扩展方式的方向迈进。并行扩展、序贯扩展、混合扩展以及内部扩展不再是孤立的技术路径,而是逐渐呈现出相互补充、协同优化的趋势。例如,并行扩展能够快速生成多样性的候选解,为序贯扩展提供了丰富的初始素材;而序贯扩展则通过深度推理对并行扩展的结果进行精细化加工,二者结合能够在保证解的多样性的基础上提升解的质量。混合扩展进一步整合了两者的优点,并通过智能的筛选和引导机制,让模型在面对复杂问题时能够更灵活地切换和融合不同的推理策略。内部扩展则从模型的内在机制出发,与上述扩展方式相结合,使模型能够自主地根据任务需求动态调整自身的推理模式,从而实现更高效、更智能的 TTS。

2. 跨领域与多任务的泛化能力增强

随着研究的深入,TTS 正在突破特定领域的限制,逐渐展现出强大的跨领域与多任务泛化能力。这意味着经过在某一领域或任务上的 TTS 训练和优化的模型,能够将所学到的推理策略和扩展技巧迁移到其他相关或不相关的领域和任务中。例如,一个在数学推理任务上经过充分 TTS 锻炼的模型,可以更容易地适应和解决编程中的逻辑问题,甚至在科学推理和游戏策略规划等任务中也能发挥出较高的性能水平。这种泛化能力的提升,得益于 TTS 对模型推理机制的深度挖掘和优化,使模型能够提炼出更具通用性的推理模式和解决问题的策略,从而在面对多样化的任务时能够快速做出适应和调整。

3. 与模型架构创新的协同发展

TTS 的发展与大型语言模型架构的创新紧密相连、相互促进。一方面,新型的模型架构为 TTS 提供了更强大的基础能力和更多的操作空间。例如,具有层次化注意力机制、记忆增强组件或特定任务适配模块的模型,能够更好地支持并行扩展、序贯扩展等 TTS 策略的实施,使得推理过程更加高效、精准。另一方面,TTS 的需求和实践也推动了模型架构的不断创新。研究人员为了更好地实现 TTS 的效果,会针对性地设计和优化模型的内部结构,如引入专门用于推理扩展的神经网络分支、开发可动态调整计算资源分配的模型组件等,从而进一步提升模型在 TTS 过程中的表现和潜力。

挑战与未来方向

1. 进一步扩展 TTS(More Scaling is the Frontier)

(1)并行扩展的改进方向

智能覆盖扩展:传统的并行扩展主要依赖于简单的重复采样或随机采样策略,这种方式虽然能够在一定程度上增加解的多样性,但往往效率较低,容易产生大量的冗余或低质量的候选解。未来的发展方向是引入智能的采样算法和覆盖策略,例如基于模型对问题的理解和分析,有针对性地生成多样化的推理路径和解的变体。可以通过对问题进行特征提取和聚类分析,将相似的问题模式进行归类,并为每一类问题设计专门的采样模板和规则,从而确保生成的候选解能够覆盖问题的不同侧面和可能的解空间区域,同时减少无意义或重复的采样。

验证增强型并行扩展:为了提高并行扩展的质量和效率,在生成候选解的过程中引入实时的验证和筛选机制至关重要。我们可以在每次采样生成一批候选解后,立即使用轻量级的验证模型或预设的验证规则对这些解进行初步的评估和过滤,快速剔除明显错误或低质量的解,保留具有潜在正确性和价值的解进入后续的聚合和进一步推理阶段。验证模型可以根据任务的特点进行设计和训练,例如在数学推理任务中,验证模型可以侧重于检查解的逻辑连贯性、公式语法正确性以及与已知数学原理的符合程度;在代码生成任务中,验证模型则可以关注代码的语法完整性、基本的编译错误检查以及与问题需求的功能匹配度等。通过这种方式,能够在并行扩展的早期阶段就提高解的质量,减少后续处理的负担,同时也能够更有效地利用计算资源,提升整个 TTS 流程的效率。

(2)序贯扩展的改进方向

结构化自我细化:目前的序贯扩展大多采用较为简单直接的迭代修正方式,即在每一步根据上一步的结果进行局部的调整和优化。然而,这种方式在处理复杂的、多步骤的推理任务时,可能会出现修正方向不明确、容易陷入局部最优解等问题。未来的研究需要探索更加结构化的自我细化方法,将推理过程划分为多个有明确目标和逻辑关联的阶段,每个阶段都采用特定的细化策略和操作。例如,在数学证明任务中,可以将推理过程分为问题理解与分解阶段、初步推理与假设生成阶段、假设验证与修正阶段以及最终结论归纳阶段。在每个阶段,模型都根据该阶段的目标和已有的中间结果,运用不同的推理技巧和知识进行细化和推进,从而确保整个推理过程具有清晰的结构和逻辑脉络,逐步逼近正确的答案。同时,为了提高细化过程的有效性,可以在每个阶段引入外部的知识源或辅助工具,为模型提供更多的信息和指导,帮助其更好地理解和解决问题,避免在复杂的推理路径中迷失方向或陷入无效的修正循环。

验证增强型迭代扩展:在序贯扩展中引入验证机制是提高推理准确性和可靠性的关键。具体措施包括在每一步迭代之后,对当前的中间结果进行详细的验证和评估,根据验证结果决定是否继续进行下一步的迭代以及如何调整迭代的方向和策略。验证的方式可以多样化,例如可以使用专门设计的验证模型对中间结果进行评分和反馈,也可以通过与已有的知识库或规则库进行比对来检查中间结果的合理性和一致性。如果验证发现中间结果存在问题或风险,可以及时触发报警机制,提醒模型重新审视之前的推理步骤,分析可能出错的原因,并采取相应的补救措施,如回溯到之前的某个状态重新进行推理、调整当前的推理策略或引入新的知识和信息等。通过这种方式,能够使序贯扩展过程更加稳健和可控,减少错误积累和传播的风险,提高模型在复杂推理任务中的表现。

(3)混合扩展的改进方向

通用混合扩展架构的设计:目前的混合扩展方法往往针对特定的任务或问题类型进行定制化设计,缺乏通用性和可移植性。未来的研究重点之一是构建通用的混合扩展架构,能够适用于各种不同类型的推理任务和模型结构。这样的架构需要具备高度的灵活性和可配置性,能够根据任务的特点和模型的需求,动态地调整并行扩展和序贯扩展的比例、方式以及相互之间的协作关系。例如,可以设计一种模块化的混合扩展框架,将并行扩展模块、序贯扩展模块以及它们之间的交互控制模块进行独立封装和参数化配置。在面对不同的任务时,只需通过调整各模块的参数和配置文件,就能快速搭建出适合该任务的混合扩展流程,而无需对整个架构进行大规模的改造和重新设计。同时,通用架构还需要提供丰富接口和工具,方便研究人员和开发者进行扩展和定制,以满足特定应用场景下的个性化需求。

多智能体与交互式扩展:多智能体系统的引入为 TTS 带来了新的思路和机遇。在混合扩展中,可以模拟多个智能体共同协作解决问题的过程,通过智能体之间的信息交流、观点碰撞和协同推理,提高解的质量和多样性。例如,在解决复杂的科学问题时,可以设计多个具有不同专业知识和推理风格的智能体,它们分别从不同的角度对问题进行分析和推理,并通过交互式的通信机制分享各自的中间结果和见解。在每个迭代周期中,智能体们根据其他智能体的反馈和建议调整自己的推理方向和策略,从而逐步形成一个完整、准确且具有深度的解决方案。为了实现有效的多智能体交互式扩展,需要解决智能体之间的通信协议设计、信息融合机制以及冲突解决策略等关键问题,确保多个智能体能够高效、协调地共同工作,充分发挥混合扩展的优势。

(4)内部扩展的改进方向

有效计算分配策略:内部扩展的关键挑战之一是如何在模型内部实现有效的计算资源分配,确保推理过程既高效又精准。目前的内部扩展方法在计算分配方面还存在一定的局限性,例如可能会过度分配计算资源导致推理速度下降,或者分配不足使得模型无法充分展开推理过程。未来的研究需要开发更加精细、动态的计算分配策略,能够根据推理任务的难度、当前的推理状态以及模型的内部反馈,实时地调整计算资源的投入。例如,可以采用基于强化学习的计算分配机制,模型通过不断地尝试和学习,掌握在不同类型任务和不同推理阶段下最优的计算资源分配模式。同时,也可以结合模型的注意力机制和记忆状态,对需要重点关注和深入推理的部分分配更多的计算资源,而对于相对简单或已得到明确结论的部分则减少资源投入,从而实现计算资源的高效利用和推理过程的精细化控制。

逻辑一致性与稳定性保障:内部扩展过程中,模型自主进行推理扩展时容易出现逻辑漂移、幻觉等问题,导致推理结果的可靠性和稳定性下降。为了应对这一挑战,需要建立一套完善的逻辑一致性检查和稳定性保障机制。这包括在模型内部引入逻辑验证模块,对每一步推理过程进行实时的逻辑检查,确保推理的连贯性和合理性。例如,可以利用形式化逻辑规则或预训练的逻辑验证模型,对模型生成的推理步骤进行评估和筛选,及时发现并纠正逻辑错误或不一致的地方。此外,还可以采用稳定性增强训练方法,通过在训练过程中加入专门设计的正则化项和约束条件,引导模型在推理扩展时保持逻辑的稳定性和结果的可重复性,从而提高内部扩展的整体质量和可信度。

2. 明确 TTS 技术的本质(Clarifying the Essence of Techniques in Scaling is the Foundation)

(1)理论空白的填补

核心技术的贡献分析:目前对于 TTS 中的核心技术如监督微调(SFT)、强化学习(RL)、奖励建模等,虽然在实践中有广泛的应用,但在理论上对其在推理扩展中的具体贡献和作用机制还缺乏深入、系统的研究。未来需要开展更加严谨的理论分析工作,从数学建模、信息论、认知科学等多个角度,对这些技术在 TTS 过程中的作用进行量化和阐释。例如,建立 SFT 对模型推理能力提升的数学模型,分析其在不同任务类型和模型架构下对推理路径搜索空间、解的质量分布等方面的影响;研究 RL 在 TTS 中的探索与利用平衡机制,以及奖励信号如何引导模型的推理策略进化等。通过这些理论研究,能够更清晰地理解 TTS 的工作原理,为优化和改进 TTS 技术提供坚实的理论基础。

技术组合的协同效应研究:除了对单个技术的深入分析外,还需要研究不同 TTS 技术组合之间的协同效应。当多种技术联合应用于 TTS 时,它们之间可能会产生复杂的相互作用和协同效应,从而对模型的推理性能产生显著影响。例如,SFT 和 RL 的结合使用在某些情况下可以取得优于单独使用任一技术的效果,但目前尚不完全清楚这种协同效应的具体产生机制和影响因素。未来的研究需要通过大量的实验和理论分析,探索不同技术组合的最优搭配方式和协作模式,揭示它们之间的协同作用原理,从而为构建更高效的 TTS 系统提供指导。

(2)奖励建模的重新评估

PRM 的有效性验证:过程奖励模型(PRM)在 TTS 中被广泛用于对推理过程进行评估和引导,但其实际有效性在不同的任务和模型配置下可能存在差异。需要开展更加全面、深入的研究来验证 PRM 在提升多步骤推理性能方面的作用。例如,设计对比实验,在相同的模型架构和任务设置下,比较使用 PRM 和不使用 PRM 的 TTS 方法在推理准确率、推理步骤合理性、解的质量等多个维度上的差异;分析 PRM 的奖励信号与模型推理过程之间的相关性和因果关系,评估 PRM 是否能够真正捕捉到推理过程中的关键信息和有价值的中间结果。通过这些研究,可以更准确地判断 PRM 在 TTS 中的实际价值,并为改进 PRM 的设计和应用提供依据。

经典奖励模型的优化:经典奖励模型可能存在噪声和不必要的复杂性,这会影响其对模型推理的引导效果。未来的研究方向包括对经典奖励模型进行优化和改进,例如采用更先进的降噪算法和特征提取技术,提高奖励信号的质量和准确性;简化奖励模型的结构和计算过程,在保证奖励信号有效性的前提下降低模型的训练和推理成本;探索新的奖励信号设计方法,使其能够更好地与模型的推理目标和任务特点相匹配,从而提高 TTS 的整体性能和效率。

(3)TTS 的数学特性研究

推理性能的量化分析:目前对于 TTS 的推理性能如何随推理步骤增加而变化的理解还不够精确和全面。未来需要建立更加准确的数学模型来量化分析推理性能与推理步骤之间的关系。例如,通过收集大量不同任务和模型在不同推理步骤下的性能数据,运用统计分析和机器学习方法建立回归模型或预测模型,揭示推理性能随推理步骤增加的规律和趋势。这将有助于确定在不同任务类型和模型配置下,推理步骤的增加对性能提升的边际效应,从而为合理设置推理步骤的数量和深度提供科学依据。

最佳停止标准的确定:确定 TTS 中的最佳停止标准是一个关键问题,目前还没有一种通用且有效的方法来解决这个问题。研究人员需要从理论上探索 TTS 的收敛条件和性能瓶颈,结合实际任务的需求和模型的特点,设计出能够动态判断推理过程是否达到最优状态的停止标准。例如,可以基于模型的性能变化趋势、推理过程的稳定性指标以及解的质量评估结果等多方面的信息,构建一个综合的停止判断模型,使其能够在推理过程中实时地判断是否应该停止推理,以避免过度推理导致的资源浪费和性能下降,同时确保模型能够达到最佳的推理效果。

推理性能提升的基本限制研究:了解 TTS 在推理性能提升方面的基本限制对于合理期望和优化 TTS 技术至关重要。这需要从模型的架构、训练数据、推理算法等多个层面进行深入研究,分析影响 TTS 性能提升的各种因素及其相互作用关系。例如,探讨模型的表达能力对 TTS 性能提升的上限约束,分析训练数据的多样性和质量如何影响模型在 TTS 过程中的泛化能力和推理性能提升空间;研究不同推理算法在面对不同类型的推理任务时的适用性和局限性,以及它们对 TTS 性能提升的潜在贡献。通过这些研究,可以为 TTS 技术的发展设定合理的预期,并为突破现有的性能瓶颈提供新的思路和方法。

(4)链式思考推理的优先级研究

关键因素的识别:在有效 TTS 中,链式思考推理的某些方面可能比其他方面更为关键。需要通过大量的实验和案例分析,识别出在不同任务类型和模型配置下,对 TTS 效果具有决定性影响的关键链式思考因素。例如,在数学推理任务中,可能问题分解能力、中间结果的验证能力以及推理路径的选择能力等是影响 TTS 性能的关键因素;而在编程任务中,代码结构的设计能力、变量的管理能力以及逻辑控制流程的优化能力等则更为重要。通过对这些关键因素的深入研究和精准识别,可以为优化 TTS 过程中的链式思考推理提供明确的方向和重点。

针对性的优化策略:根据识别出的关键链式思考因素,制定针对性的优化策略。例如,对于问题分解能力这一关键因素,可以通过在训练过程中引入更多的问题分解示例和练习,引导模型学习如何将复杂的问题分解为多个子问题,并逐步解决每个子问题;对于中间结果的验证能力,可以设计专门的验证模块或奖励机制,鼓励模型在每一步推理后对中间结果进行自我检查和验证,提高推理过程的可靠性和准确性。通过这种方式,能够更有针对性地提升 TTS 的效果,充分发挥链式思考推理在 TTS 中的优势。

(5)自适应 TTS 的探索

自动推理过程调整机制:目前的 TTS 方法大多需要人工设定推理步骤的数量、扩展方式等参数,缺乏根据问题的难易程度和特点自动调整推理过程的能力。未来的研究需要探索如何使模型能够自动感知问题的复杂性,并根据当前问题的特点动态调整推理过程。例如,开发一种基于问题特征分析的自适应 TTS 系统,该系统能够自动提取问题的特征(如问题长度、关键词、语义复杂度等),并根据预设的规则或模型的自我学习经验,调整推理步骤的数量、并行扩展和序贯扩展的比例以及内部扩展的强度等参数,从而实现对推理过程的精细化、自动化控制,提高 TTS 的智能化水平和适应性。

避免盲目扩展的策略:在实现自适应 TTS 的过程中,需要避免模型盲目地进行推理扩展,导致资源浪费和性能下降。为此,需要设计有效的策略来引导模型在合适的时候停止推理扩展。例如,可以引入一种基于推理过程评估的动态停止机制,该机制在每次推理扩展后对当前的解质量和推理过程的进展进行评估,如果发现继续扩展的预期收益低于某个阈值,或者推理过程已经陷入停滞状态(如解的质量长时间没有显著提升),则自动触发停止命令,终止推理扩展过程。同时,可以通过对模型进行元学习训练,使其能够学习到在不同情况下最优的推理扩展策略和停止时机,从而实现更加智能、高效的自适应 TTS。

3. 优化 TTS 是关键(Optimizing Scaling is the Key)

随着 TTS 方法的不断丰富和应用场景的日益复杂,系统评估和优化成为了推动 TTS 进一步发展的关键因素。未来需要从以下几个方面加强 TTS 的优化工作:

多维度评估指标体系的完善:目前常用的 TTS 评估指标主要集中在性能(如准确率、通过率)和效率(如计算成本、推理速度)两个维度,但在实际应用中,模型的鲁棒性、安全性、偏见、可解释性等其他次级属性也同样重要。未来需要构建更加全面、完善的多维度评估指标体系,综合考虑 TTS 方法在各个方面的表现。例如,在评估 TTS 的鲁棒性时,可以设计一系列具有对抗性的测试用例,考察模型在面对输入噪声、恶意攻击或极端情况下的稳定性和可靠性;在评估安全性时,可以分析模型输出是否符合相关的安全标准和规范,是否存在潜在的安全风险;对于偏见问题,可以通过对模型在不同群体、不同领域的数据上的表现进行评估,检测是否存在系统性的偏见和不公平现象;在可解释性方面,可以研究如何将 TTS 过程中的推理步骤和决策逻辑以直观、易懂的方式呈现给用户,提高模型的透明度和可信度。通过综合运用这些多维度的评估指标,能够更全面地了解 TTS 方法的优缺点,为其优化提供更充分的依据。

优化算法与工具的开发:为了实现 TTS 的优化,需要开发更加高效的优化算法和工具。例如,在模型训练阶段,可以采用基于梯度下降的优化算法对 TTS 相关的参数进行联合优化,同时引入正则化项来防止过拟合和提高模型的泛化能力;在推理阶段,可以利用贝叶斯优化、遗传算法等全局优化方法对 TTS 的超参数(如推理步骤数量、采样策略、奖励权重等)进行自动调优,寻找最优的参数组合以提升 TTS 的性能。此外,还需要开发相应的可视化工具和调试工具,帮助研究人员和开发者直观地观察 TTS 过程中的模型行为、性能变化以及潜在的问题,从而更加快速、准确地进行优化决策。

数据驱动的优化策略:数据在 TTS 优化过程中具有至关重要的作用。通过收集和分析大量的 TTS 实践数据,包括模型在不同任务、不同数据集上的性能表现、推理过程中的中间结果、用户的反馈信息等,可以挖掘出影响 TTS 性能的关键因素和优化方向。例如,可以运用数据挖掘技术对 TTS 数据进行聚类分析,将相似的任务或模型表现归为一类,并针对每一类的特点制定专门的优化策略;或者通过关联规则挖掘,发现 TTS 过程中不同参数设置与模型性能之间的关联关系,从而为参数优化提供指导。同时,可以利用生成式对抗网络(GAN)等数据增强技术,生成更多样化、更具代表性的 TTS 训练数据和测试数据,进一步提高 TTS 方法的鲁棒性和泛化能力,为其优化提供更丰富的数据支持。

4. 跨领域泛化是主流(Generalization across Domains is the Mainstream)

TTS 在跨领域泛化方面的潜力巨大,但也面临着诸多挑战。以下是未来在这方面的研究重点和发展方向:

成本与精度的平衡策略:在跨领域应用 TTS 时,需要在计算成本和推理精度之间找到平衡。不同领域的任务对计算资源的需求和对推理精度的要求可能存在显著差异。例如,医学推理任务可能对精度要求极高,但同时也能够承受较高的计算成本;而一些实时性要求较高的应用场景(如智能客服、在线教育等)则需要在有限的计算资源下快速给出相对准确的答案。未来的研究需要针对不同领域的特点,开发相应的成本与精度平衡策略。例如,可以采用动态资源分配算法,根据任务的优先级和实时性要求,灵活调整 TTS 过程中计算资源的投入;或者设计自适应的推理精度控制机制,在保证满足领域最低精度要求的前提下,尽可能降低计算成本。同时,还可以探索利用领域迁移学习技术,通过在计算资源相对充裕的源领域进行充分的 TTS 训练,然后将所学到的推理知识和技能迁移到计算资源受限的目标领域,从而实现成本与精度的平衡优化。

领域特定可解释性的保障:在一些专业领域(如法律、金融、医疗等),模型的输出既需要准确,又需要具备良好的可解释性,以便专业人士能够理解和信任模型的决策过程。然而,TTS 过程中的复杂推理扩展可能会增加模型的黑箱性,降低其可解释性。为此,需要研究如何在跨领域 TTS 中保障领域特定的可解释性。例如,可以开发针对不同领域的专用解释器,将 TTS 过程中的推理步骤和逻辑以领域专业人士能够理解的方式进行转换和呈现;或者在模型训练过程中引入领域特定的解释性约束和正则化项,引导模型生成具有更高可解释性的推理路径和结果。此外,还可以探索结合领域知识图谱和专家系统的 TTS 方法,通过利用领域内已有的结构化知识和规则,增强模型推理的透明度和可解释性,使其更符合领域内的专业标准和习惯。

外部知识与现实约束的整合方法:跨领域 TTS 的另一个关键挑战是如何有效地整合外部知识和现实约束。不同领域拥有各自独特的知识体系和约束条件,这些信息对于模型在该领域的推理和决策至关重要。未来需要开发更加有效的知识整合方法,使 TTS 能够充分利用外部知识和现实约束来提升模型的表现。例如,可以构建领域知识库与模型之间的动态交互接口,让模型在 TTS 过程中能够实时查询和调用相关的领域知识,为推理提供支持;或者设计基于约束满足的 TTS 优化算法,将现实约束转化为模型推理过程中的约束条件,引导模型生成符合领域要求的解。同时,还需要研究如何对整合的外部知识和现实约束进行质量评估和验证,确保其准确性和可靠性,避免错误或过时的知识对模型推理产生负面影响。

总结与展望

综上所述,Test-Time Scaling(TTS)从理论研究到实际应用,都展现出巨大的潜力与价值,它为大型语言模型(LLM)的推理能力提升提供了多维度的有效路径。TTS 能够显著提升大型语言模型在复杂任务中的推理能力。从并行扩展到序贯扩展,从混合扩展到内部扩展,每一种方法都有其独特的应用场景和优势。通过合理的推理计算扩展,模型能够更好地应对各种复杂的任务,从数学推理到代码生成,从游戏策略到科学问题求解,TTS 在各个领域都展现出强大的能力。

然而,我们也要认识到 TTS 面临的挑战和局限性。性能瓶颈、成本效益问题以及实际应用中的各种挑战都需要我们进一步探索。总之,这篇论文作为首个通过层级分类提供结构化视角的综述,对理论研究和实际应用都具有重要意义。它帮助研究者深入理解 TTS 的各个维度及其相互关系,为未来研究提供了坚实的基础。基于 TTS 分类体系的实际指导方针,对 TTS 部署的实用性和有效性提升具有重要贡献。

Test-Time Scaling 的演变路径

上图展示了 TTS 从出现到未来前沿的演变路径,这为我们未来的研究和应用提供了方向。下面总结了一些关键的Test-time scaling不同方法的论文,非常值得的精准研读和收藏!为了方便大家使用,我没有贴图片,而是做成了纯文本形式的表格来渲染,辛苦大家左右滑动一下,里面总结了一些信息,可以十分方便大家从不同维度的需求来检索。

| Method (Papers Titles) | What | How → | Where | How Well | |||||

| Scaling llm test-time compute optimally can be more effective than scaling model parameters.(https://arxiv.org/abs/2408.03314) | Parallel, Sequential | ✗ | ✗ | ✗ | Beam, LookAhead | Verifier | (Weighted) Best-of-N, Stepwise Aggregation | Math | Pass@1, FLOPsMatched Evaluation |

| Multi-agent verification: Scaling test-time compute with goal verifiers(https://arxiv.org/abs/2502.20379) | Parallel | ✗ | ✗ | Self-Repetition | ✗ | Multiple-Agent Verifiers | Best-of-N | Math, Code, General | BoN-MAV (Cons@k), Pass@1 |

| Evolving Deeper LLM Thinking([2501.09891] Evolving Deeper LLM Thinking) | Sequential | ✗ | ✗ | Self-Refine | ✗ | Functional | ✗ | Open-Ended | Success Rate, Token Cost |

| Meta-reasoner: Dynamic guidance for optimized inference-time reasoning in large language models(https://arxiv.org/abs/2502.19918) | Sequential | ✗ | ✗ | CoT + Self-Repetition | ✗ | Bandit | ✗ | Game, Sci, Math | Accuracy, Token Cost |

| START: Self-taught reasoner with tools(https://arxiv.org/abs/2503.04625) | Parallel, Sequential | Rejection Sampling | ✗ | Hint-infer | ✗ | Tool | ✗ | Math, Code | Pass@1 |

| “Well, Keep Thinking”: Enhancing LLM Reasoning with Adaptive Injection Decoding([2503.10167] "Well, Keep Thinking": Enhancing LLM Reasoning with Adaptive Injection Decoding) | Sequential | ✗ | ✗ | Adaptive Injection Decoding | ✗ | ✗ | ✗ | Math, Logical, Commonsense | Accuracy |

| Chain of draft: Thinking faster by writing less(https://arxiv.org/abs/2502.18600) | Sequential | ✗ | ✗ | Chain-of-Draft | ✗ | ✗ | ✗ | Math, Symbolic, Commonsense | Accuracy, Latency, Token Cost |

| rStar-Math: Small LLMs Can Master Math Reasoning with Self-Evolved Deep Thinking(https://arxiv.org/abs/2501.04519) | Hybrid | imitation | ✗ | ✗ | MCTS | PRM | ✗ | Math | Pass@1 |

| Can 1B LLM Surpass 405B LLM? Rethinking Compute-Optimal Test-Time Scaling(https://arxiv.org/abs/2502.06703) | Parallel, Hybrid | ✗ | ✗ | ✗ | DVTS, Beam Search | PRM | Best-of-N | Math | Pass@1, Pass@k, Majority, FLOPS |

| Tree of thoughts: Deliberate problem solving with large language models(https://arxiv.org/abs/2305.10601) | Hybrid | ✗ | ✗ | Propose Prompt, Self-Repetition | Tree Search | Self-Evaluate | ✗ | Game, Open-Ended | Success Rate, LLM-as-a-Judge |

| Mindstar: Enhancing math reasoning in pre-trained llms at inference time(https://arxiv.org/abs/2405.16265) | Hybrid | ✗ | ✗ | ✗ | LevinTS | PRM | ✗ | Math | Accuracy, Token Cost |

| Inference Scaling Laws: An Empirical Analysis of Compute-Optimal Inference for LLM Problem-Solving([2408.00724] Inference Scaling Laws: An Empirical Analysis of Compute-Optimal Inference for Problem-Solving with Language Models) | Hybrid | ✗ | ✗ | ✗ | Reward Balanced Search | RM | ✗ | Math | Test Error Rate, FLOPs |

| Reasoning-as-Logic-Units: Scaling Test-Time Reasoning in Large Language Models Through Logic Unit Alignment(https://arxiv.org/abs/2502.07803) | Hybrid | ✗ | ✗ | Self-Refine | Control Flow Graph | Self-Evaluate | Prompt Synthesis | Math, Code | Pass@1 |

| PlanGEN: A Multi-Agent Framework for Generating Planning and Reasoning Trajectories for Complex Problem Solving(https://arxiv.org/abs/2502.16111) | Parallel, Hybrid | ✗ | ✗ | MoA | ✗ | Verification Agent | Selection Agent | Math, General, Finance | Accuracy, F1 Score |

| A Probabilistic Inference Approach to Inference-Time Scaling of LLMs using Particle-Based Monte Carlo Methods(https://arxiv.org/abs/2502.01618) | Hybrid | ✗ | ✗ | ✗ | Particle-based Monte Carlo | PRM + SSM | Particle Filtering | Math | Pass@1, Budget vs. Accuracy |

| Archon: An Architecture Search Framework for Inference-Time Techniques(https://arxiv.org/abs/2409.15254) | Hybrid | ✗ | ✗ | MoA, Self-Repetition | ✗ | Verification Agent, Unit Testing (Ensemble) | Fusion | Math, Code, Open-Ended | Pass@1, Win Rate |

| Wider or deeper? scaling llm inference-time compute with adaptive branching tree search(https://arxiv.org/abs/2503.04412) | Hybrid | ✗ | ✗ | Mixture-of-Model | AB-MCTS-(M,A) | ✗ | ✗ | Code | Pass@1, RMSLE, ROC-AUC |

| Thinking llms: General instruction following with thought generation([2410.10630] Thinking LLMs: General Instruction Following with Thought Generation) | Internal, Parallel | ✗ | DPO | Think | ✗ | Judge Models | ✗ | Open-Ended | Win Rate |

| Self-Evolved Preference Optimization for Enhancing Mathematical Reasoning in Small Language Models(https://arxiv.org/abs/2503.04813) | Internal, Hybrid | ✗ | DPO | Diversity Generation | MCTS | Self-Reflect | ✗ | Math | Pass@1 |

| MA-LoT: Multi-Agent Lean-based Long Chain-of-Thought Reasoning enhances Formal Theorem Proving([2503.03205] MA-LoT: Model-Collaboration Lean-based Long Chain-of-Thought Reasoning enhances Formal Theorem Proving) | Internal, Sequential | imitation | ✗ | MoA | ✗ | Tool | ✗ | Math | Pass@k |

| Offline Reinforcement Learning for LLM Multi-Step Reasoning(https://arxiv.org/abs/2412.16145) | Internal, Sequential | ✗ | OREO | ✗ | Beam Search | Value Function | ✗ | Math, Agent | Pass@1, Success Rate |

| DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning(https://arxiv.org/abs/2501.12948) | Internal | warmup, GRPO, Rule-Based | ✗ | ✗ | ✗ | ✗ | Math, Code, Sci | Pass@1, cons@64, Percentile, Elo Rating, Win Rate | |

| s1: Simple test-time scaling(https://arxiv.org/abs/2501.19393) | Internal | distillation | ✗ | Budget Forcing | ✗ | ✗ | ✗ | Math, Sci | Pass@1, Control, Scaling |

| O1 Replication Journey: A Strategic Progress Report – Part 1(https://arxiv.org/abs/2410.18982) | Internal | imitation | ✗ | ✗ | Journey Learning | PRM, Critique | Multi-Agents | Math | Accuracy |

| From drafts to answers: Unlocking llm potential via aggregation fine-tuning(https://arxiv.org/abs/2501.11877) | Internal, Parallel | imitation | ✗ | ✗ | ✗ | Fusion | ✗ | Math, Open-Ended | Win Rate |

| Towards System 2 Reasoning in LLMs: Learning How to Think With Meta Chain-of-Though(https://arxiv.org/abs/2501.04682) | Internal, Hybrid | imitation, meta-RL | Think | MCTS, A* | PRM | ✗ | Math, Open-Ended | Win Rate | |

| ReasonFlux: Hierarchical LLM Reasoning via Scaling Thought Templates(https://arxiv.org/abs/2502.06772) | Internal, Sequential | ✗ | PPO, Trajectory | Thought Template Retrieve | ✗ | ✗ | Math | Pass@1 | |

| L1: Controlling how long a reasoning model thinks with reinforcement learning([2503.04697] L1: Controlling How Long A Reasoning Model Thinks With Reinforcement Learning) | Internal | ✗ | GRPO, Length-Penalty | ✗ | ✗ | ✗ | ✗ | Math | Pass@1, Length Error |

| Marco-o1: Towards Open Reasoning Models for Open-Ended Solutions(https://arxiv.org/abs/2411.14405) | Internal, Hybrid | distillation, imitation | ✗ | Reflection Prompt | MCTS | Self-Critic | ✗ | Math | Pass@1, Pass@k |

128

128

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?