基于深度强化学习的混合动力汽车能量管理策略

1.利用DQN算法控制电池和发动机发电机组的功率分配

2.状态量为需求功率和SOC,控制量为EGS功率

3.奖励函数设置为等效油耗和SOC维持

4.可以将DQN换成DDPG或者TD3

YID:2199785318543771

x***2

探索基于深度强化学习算法在混合动力汽车能量管理策略中的实现与比较

摘要: 近年来,混合动力汽车已经成为一种常见的绿色交通方式。为了实现高效的能量管理,本文以深度强化学习为依托,研究了一种基于DQN算法的混合动力汽车能量管理策略。同时,我们也探讨了DDPG和TD3算法在相同场景下的应用,并对其进行了比较。

一、引言

随着汽车工业的快速发展,混合动力汽车因其节能减排的优点受到了广泛关注。如何有效地管理混合动力汽车的能量分配,以实现最佳的燃油经济性和排放性能,成为了研究的热点。本文通过利用深度强化学习中的不同算法来探讨这一问题。

二、问题描述

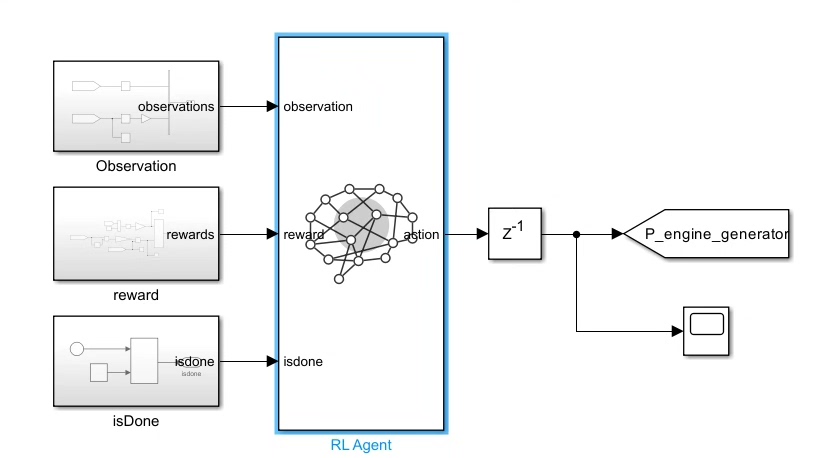

混合动力汽车的能量管理负责在电池和发动机发电机组之间分配功率。我们的目标是利用深度强化学习算法来控制这一过程,使得能够在不同的需求功率下,通过调整发动机发电机组(EGS)的功率,达到最优的等效油耗,并保持电池的SOC(荷电状态)在一个合适的范围内。

三、基于DQN算法的能量管理策略

我们首先尝试了使用DQN(深度Q网络)算法来控制电池和发动机发电机组的功率分配。状态量包括需求功率和电池的SOC。通过训练,DQN能够学习到一个控制策略,该策略能够根据当前的状态来决定EGS的功率。奖励函数被设定为等效油耗和维持SOC的平衡。

四、DDPG与TD3算法的应用

除了DQN算法外,我们还尝试了DDPG(深度确定性策略梯度)和TD3(双延迟深度确定性策略梯度)算法。这两种算法在处理连续动作空间的问题上具有优势。我们通过调整参数和训练策略,使得这两种算法在混合动力汽车的能量管理上取得了良好的效果。

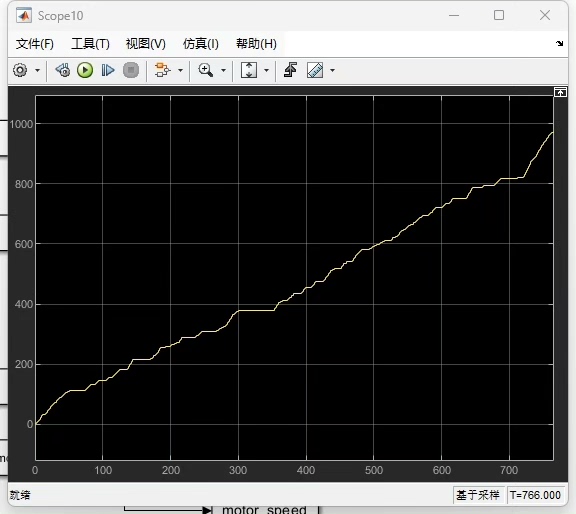

五、实验结果与比较

通过实验,我们发现基于DQN、DDPG和TD3的能量管理策略都能够有效地控制电池和发动机发电机组的功率分配,实现了较好的等效油耗和SOC的平衡。然而,在收敛速度和稳定性方面,不同的算法表现出了一定的差异。具体来说,DDPG在收敛速度上表现出了一定的优势,而DQN在处理离散动作上更加擅长。TD3则在处理噪声和模型不稳定性上表现出更好的鲁棒性。

六、结论与展望

本文研究了基于深度强化学习的混合动力汽车能量管理策略,并比较了DQN、DDPG和TD3三种算法的应用。实验结果表明,这些算法都能够有效地解决能量管理问题。未来,我们将进一步优化算法,提高其在实际应用中的性能,并探索其他强化学习算法在混合动力汽车能量管理中的应用。

代码片段:

以下是使用Python和TensorFlow实现的DQN算法的简单代码片段:

# 初始化DQN网络结构和参数

def initialize_dqn():

# ... 网络结构代码 ...

return dqn_network

# 定义奖励函数和状态转换函数等环境参数

# 进行DQN的训练和测试...

请注意,这只是一个代码示例,具体的实现会根据具体的项目需求和环境设定而有所不同。在实际应用中,还需要考虑数据预处理、模型训练的细节以及超参数的调整等。

点开探索更多:

777

777

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?