具体运算了解logistic回归神经网络计算过程

回顾一下logistic回归的几个重要公式:

其中y帽表示预测值,是sigmod函数,sigmod的变量z是第一行公式;第三行的损失函数表示只有

一个样本的情况。

如果对这些公式不理解的话可以参考我的另外一一篇博客关于logistic回归模型

https://blog.csdn.net/jmu_sxc/article/details/84634029

下面将要讲述的是logistic回归在神经网络的计算传播过程:我们知道神经网络的计算过程分为两部分,

一个是前向传播,另一个是反向传播,大家亦可以参考博客,通过简单例子讲述了神经网络的两个计算

过程。https://blog.csdn.net/jmu_sxc/article/details/84627997

如图所示:该logistic回归模型的输入是x和参数w和b,x1,x2这里表示x的内容,比如图片的特征x1,x2;

w1,w2 表示权值,跟输入x有关。箭头的指向就表示前向传播的过程,计算出z,a,j的值,该过程通过

输入最后极端了损失函数的函数值

反向传播的目的是调整参数值(这里是w和b),重新计算损失函数,优化损失函数,使得损失函数

收敛其计算内容就是计算各个参数的偏导数(da,dz,dx1,dx2,dw1,dw2,db)如下图:

之后在通过梯度下降法调整参数,如上图的右侧,调整损失函数的参数w,b,将调整好的参数再次传入

计算,使损失函数的值往减小的方向移动。

以上是logistic回归模型计算过程:

神经网络计算过程分为前向传播和反向传播,前向传播计算损失函数,反向传播计算参数的偏导数,

而logistic回归模型前向传播和反向传播分别在计算loss 和偏导数,上面只是针对于一个样本的计算,

对于m个样本的计算会在下面说明。

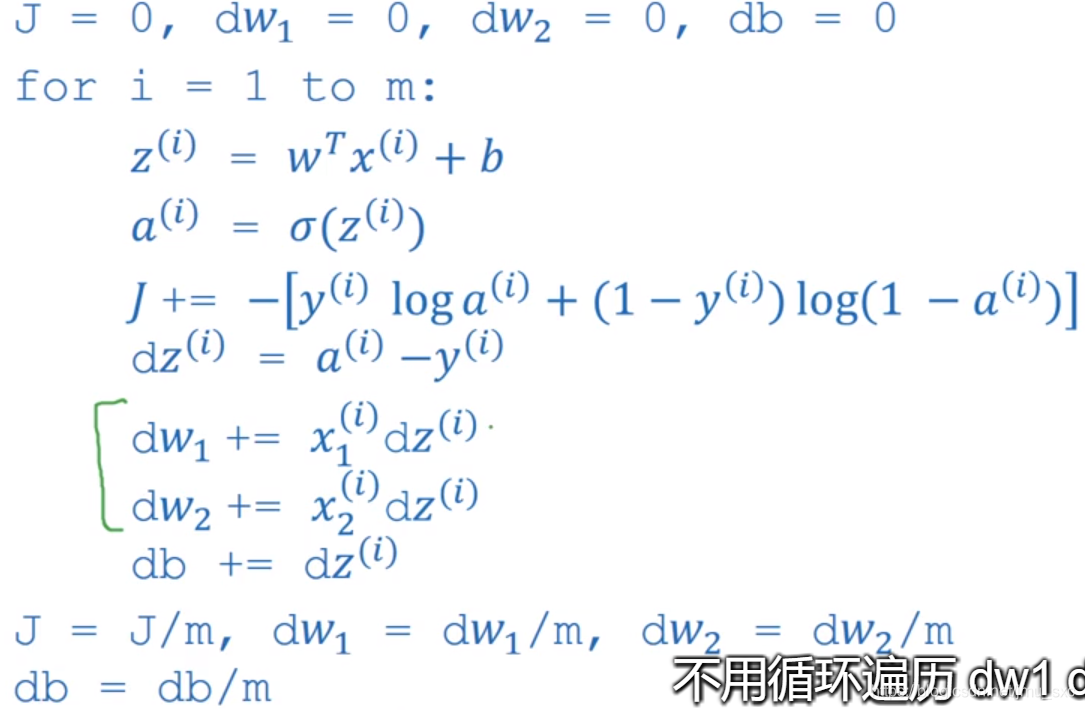

m个样本的logistic回归模型计算过程

很自然的要计算m个样本我们会想到用for循环遍历样本来实现:

初始化累加器dw1,dw2,db分别存储m个样本的参数的偏导数和最后求平均值,为之后的参数的调整(dw1,dw2,db)

做准备;J变量最后完成循环表示成本函数。

完成这样的一个循环后就表示完成了m个样本的前向传播的计算过程和反向传播偏导数的计算。如果再完成右图

的梯度下降法调整参数后,就完成神经网络的一次迭代。通常神经网络要进行多次迭代,最外层的循环是迭代的次数。

以上就是logistic回归在进行神经网络计算的过程(前向传播和反向传播),分别是对一个样本和m个样本的计算。

我们发现如果训练集很大的情况下,for循环是不利于运算速度的,下节将会对以上的计算进行向量化,提高运算速度。

108

108

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?