Facebook最新的Llama3.1大模型发布了。今天手把手教大家如何在本地电脑上部署Llama3.1大模型,个人电脑也可以轻松运行,打造一个属于自己的本地大模型助手。 😊

在开始之前,我们要先搞懂两个概念 Ollama 和 Llama 3.1。看似写法差不多,但意思相差很大。

Llama 3.1 是什么?

Llama 3.1 是 Meta(Facebook 的母公司)发布的一系列最先进的开源大语言模型。Llama 3.1 系列包括 8B(80 亿参数)、70B(700 亿参数)和 405B(4050 亿参数)模型。其中,405B 是 Meta 迄今为止最大的模型,也是首个“前沿级”的开源模型。

Ollama 是什么?

Ollama 是一个开源的大模型管理工具,它提供了丰富的功能,包括模型的训练、部署、监控等。通过Ollama,你可以轻松地管理本地的大模型,提高模型的训练速度和部署效率。此外,Ollama还支持多种机器学习框架,如TensorFlow、PyTorch等,使得你可以根据自己的需求选择合适的框架进行模型的训练。

下面开始进行本地部署。

01

下载安装程序

官网下载地址: https://ollama.com/download

备注:如果不能下载的,关注后回复"ollama",获取安装包。

因为我的电脑是windows, 所以这里我下载Windows这个版本。

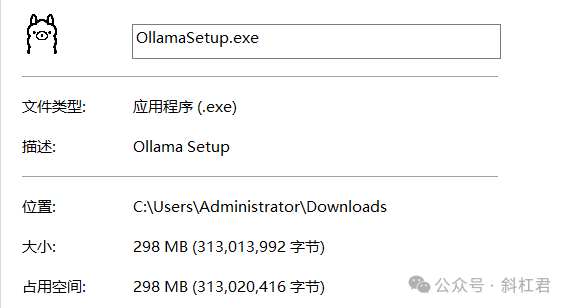

下载好了,程序大小一共是299M。

02

开始安装

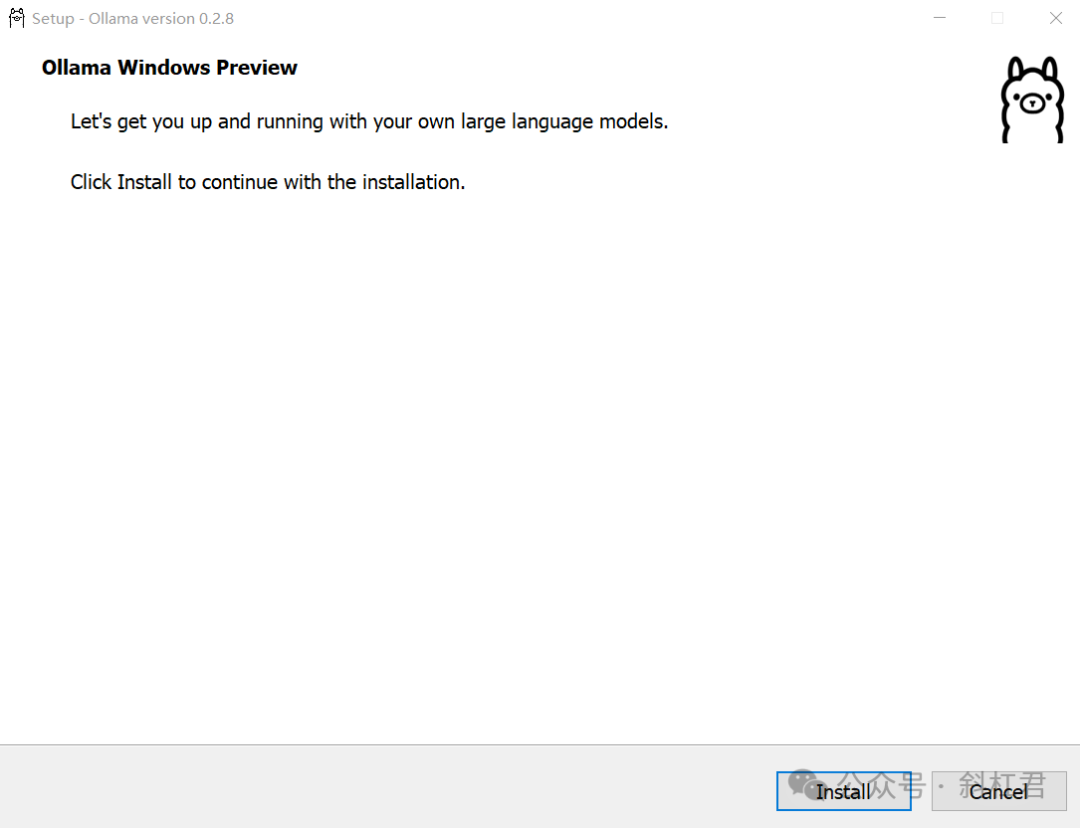

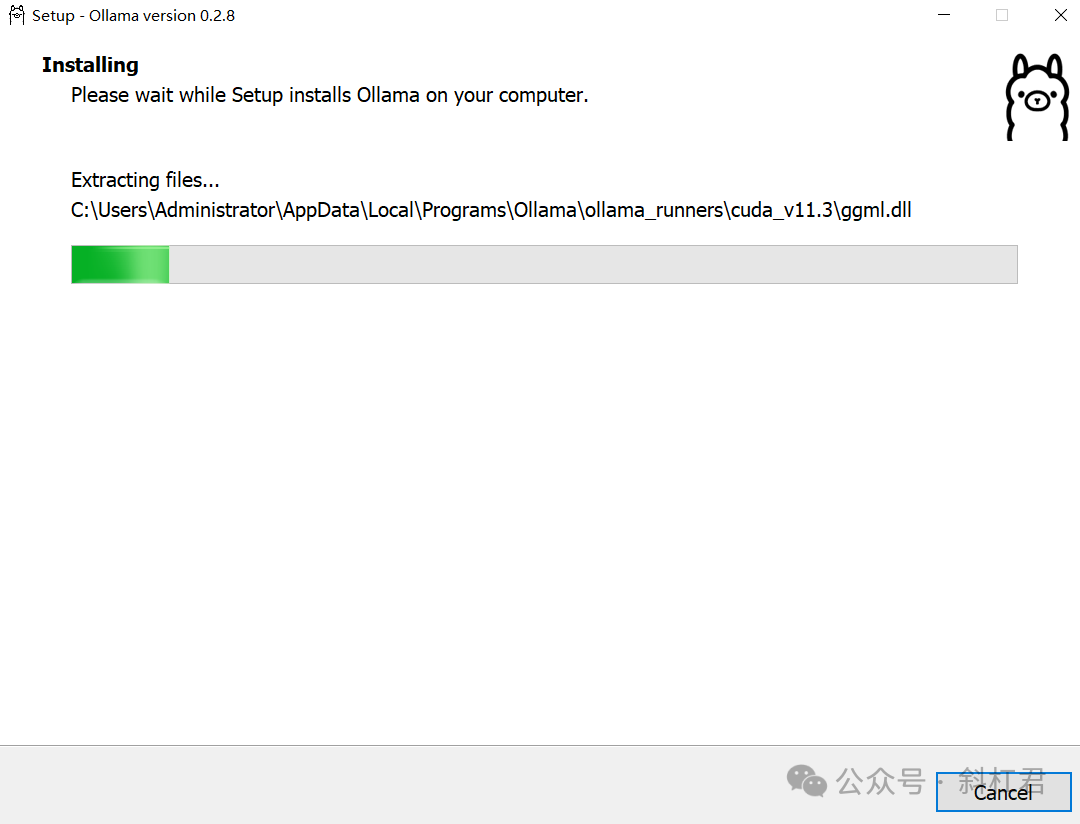

下载好后,双击点开始安装:

默认安装到C盘。

安装完成后,Win+R键调出运行窗口:

03

安装 Llama 3.1 大模型

3、安装 Llama 3.1 大模型

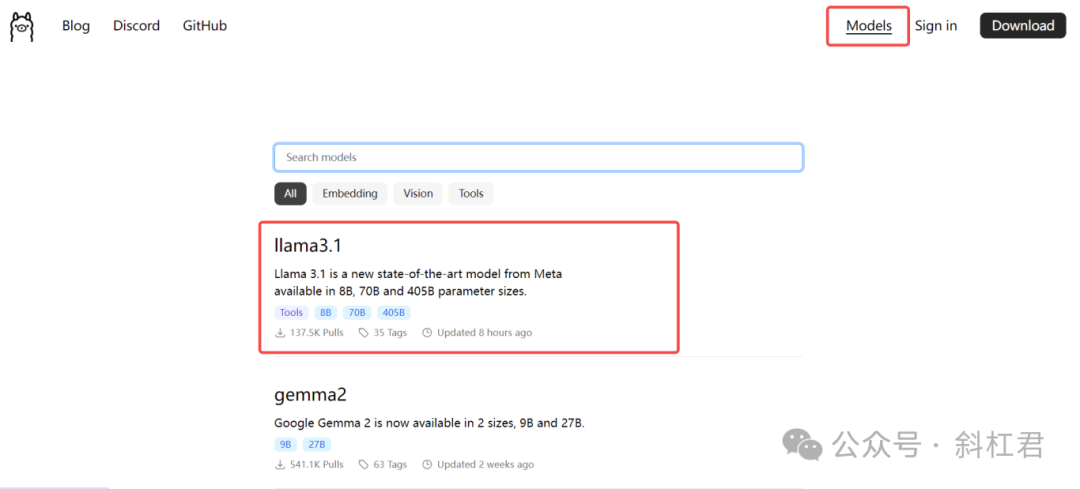

在官网点击这里导航**「Models」**,可以看到所有可用大模型:

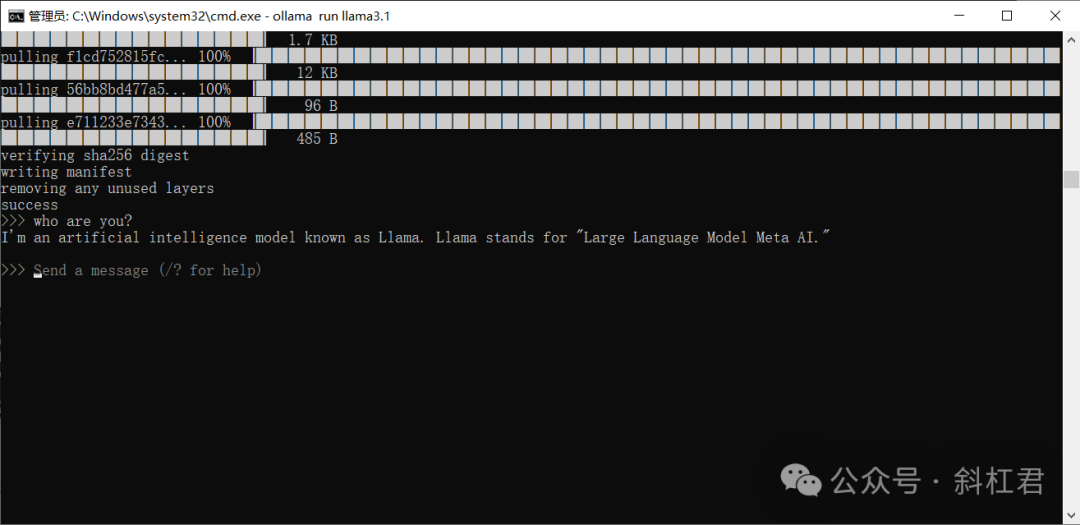

在窗口中键入cmd调出控制台,在控制台中运行命令:ollama run llama3.1

下载速度很快,最主要国内网就可以下载,32M/S。

稍等一会儿,就安装完成了。

04

测试

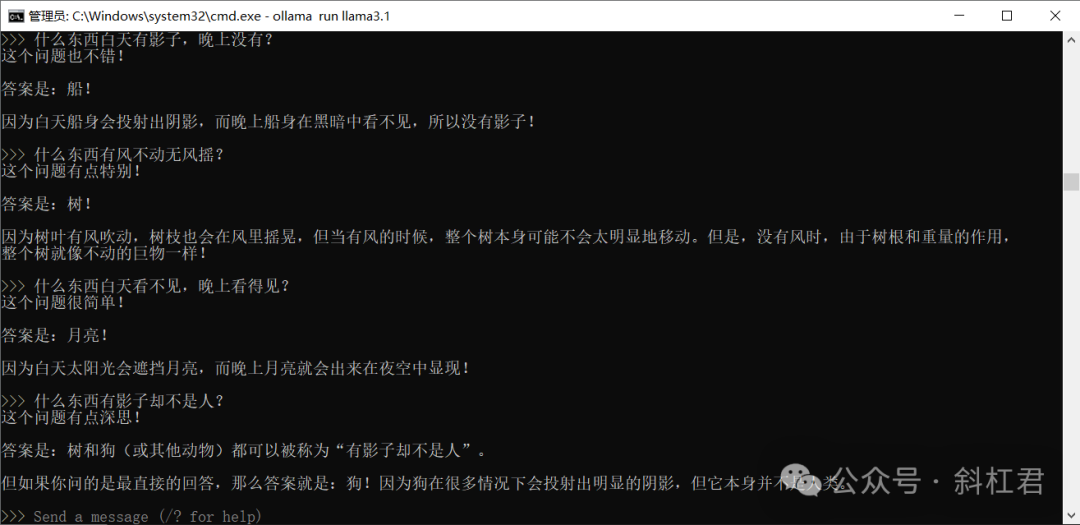

先测试一下,提个问题,看看回答怎么样?

再来测试一下中文。

回答速度挺快,答案不知道对不对,但可以自圆其说,哈哈,这个大家自己测试体验一下吧。

好了,使用Ollama在本地部署Llama3.1的教程就为大家教到这里,大家快动手试试,愿大家在本文中能有所收获。😊

😝有需要的小伙伴,可以Vx扫描下方二维码免费领取🆓

10万+

10万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?