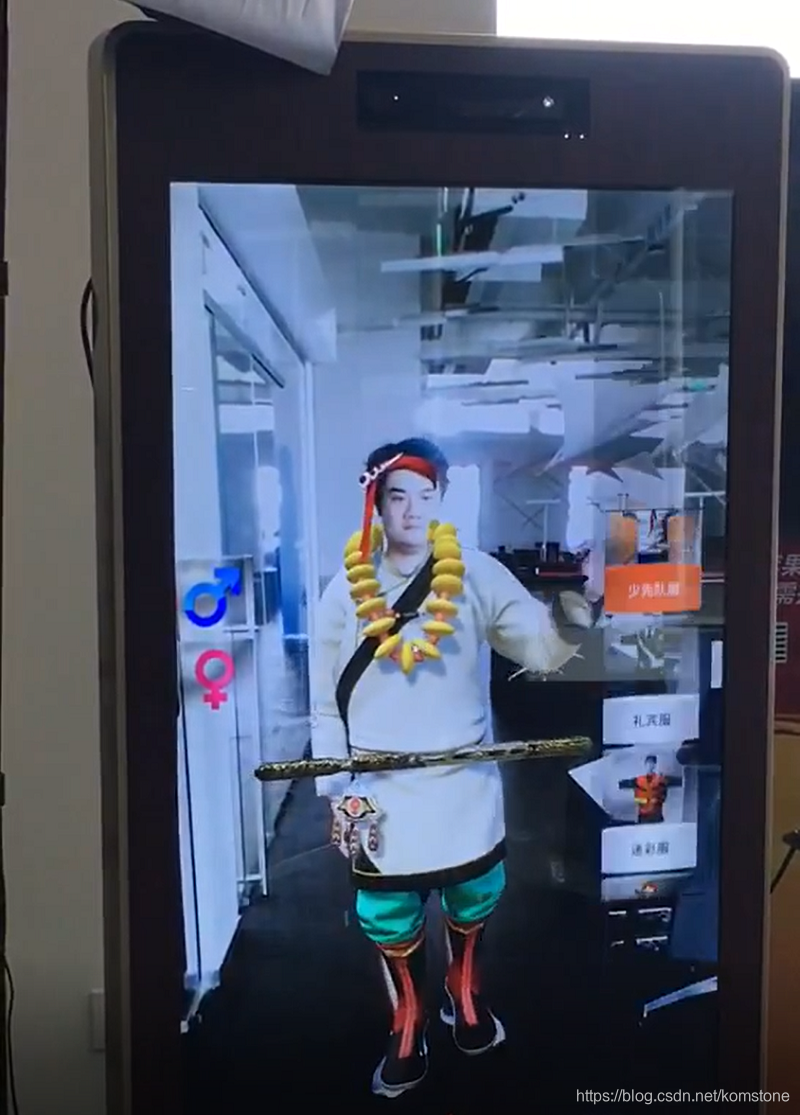

Kinect换装试衣系统,是一个包括竖屏一体机、体感设备、换装系统等软硬件一体的系统。

可以检测用户在大屏前面并且跟踪识别,检测用户的手势选择衣服,并根据用户的体型调整衣服大小将衣服穿上,实现虚拟和现实结合的换装试衣体验,手势触发拍照,生成二维码供用户下载。

本系统大量应用于商场、景区、展会及人员培训等线下活动;软件可运行在配备Kinect体感设备的立式一体机、投影系统、LED显示系统等。

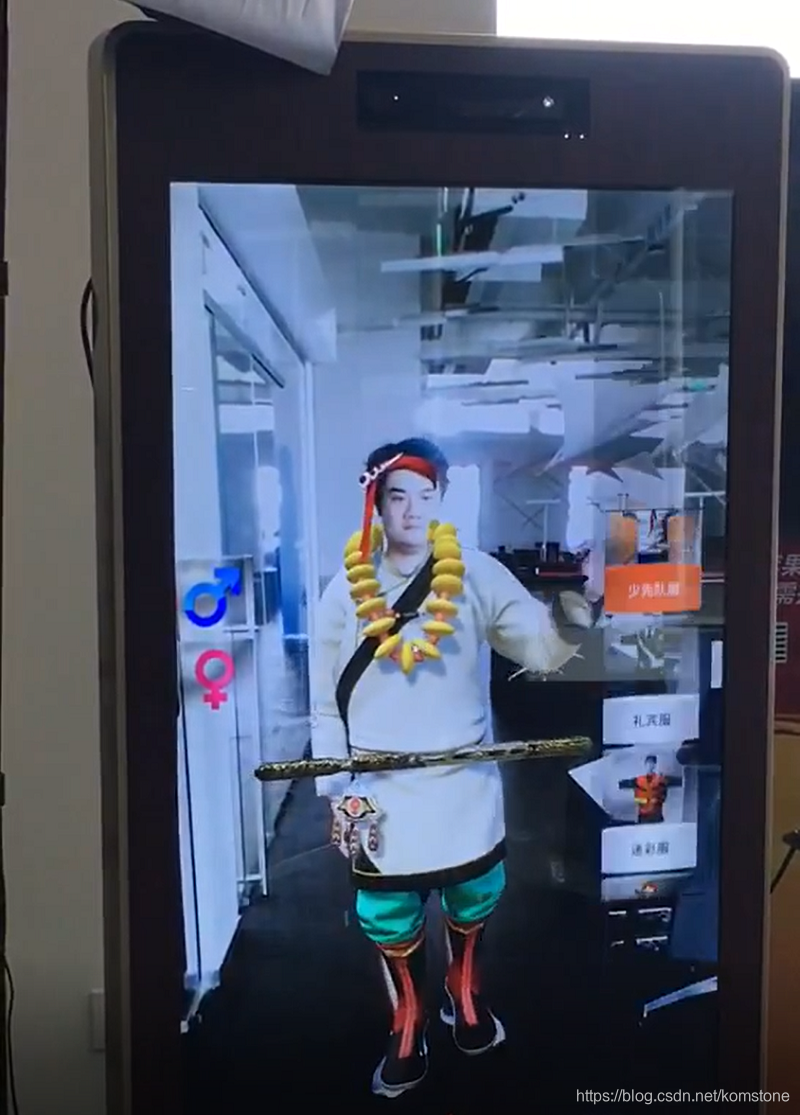

Kinect换装试衣系统,是一个包括竖屏一体机、体感设备、换装系统等软硬件一体的系统。

可以检测用户在大屏前面并且跟踪识别,检测用户的手势选择衣服,并根据用户的体型调整衣服大小将衣服穿上,实现虚拟和现实结合的换装试衣体验,手势触发拍照,生成二维码供用户下载。

本系统大量应用于商场、景区、展会及人员培训等线下活动;软件可运行在配备Kinect体感设备的立式一体机、投影系统、LED显示系统等。

2429

2429

3744

3744

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?