基本思想:通过级联弱分类器(分类能力较弱的分类器)来构造一个强分类器。

训练准备:为了描述简洁,用典型的二分类问题进行阐述。

训练集: N个多维的特征向量

分类器池:L个弱分类器

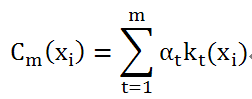

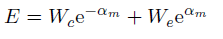

m个分类器判别结果的线性组合:

其中

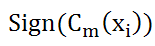

有了公式(1)对于特征向量

训练步骤

1、从分类器中选择一个分类器,使得能通过分类器的样本数量尽可能多。

数学表达:假设当前已有m-1个分类器被选入级联分类器中,对于特征向量

现在我们希望从分类器池中再选出一个分类器作为第m个分类器,加入到级联组中,数学表达如下

并根据分类器的错分率,自动调整相应的权值

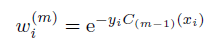

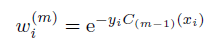

为了解决如何选择第m个分类器

其中yi为训练样本人工分类的结果,值域也为

可以看到由于前m-1个分类器和相应的权值都以确定,故

其中

根据人工标注的结果和线性分类器判别的结果可以对(5)继续分解

可以看到,对于错分的样本,对E的贡献要大,对于正确分类的样本,对E的贡献要小

由于

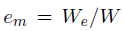

其中

2.确定权重系数

然后对

令偏导数=0求得

其中

可以看到对于错分率低的分类器,权值会是最大,加强了这个分类器的分类影响。

3.迭代运行算法,直到达到级联器中分类器的上限

参考资料:AdaBoost and the Super Bowl of Classi ers A Tutorial Introduction to Adaptive Boosting

http://summerbell.iteye.com/blog/532376

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?