我们将两种传统方法——引导滤波器 (GF) 和潜在低秩表示 (LatLRR) 的优越方面结合起来,提出了一种平衡纹理和显著性的红外和可见光图像融合方法。

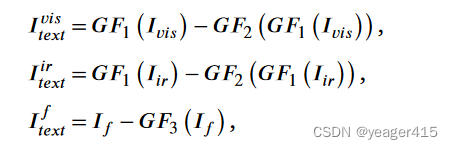

作者也说了,本文复杂的地方就在于损失函数的设计。引入GF和LatLRR作为损失项,GF和LatLRR,从源图像中提取信息。提取的信息然后进行处理并用作纹理和显著性约束。这就是所谓的平衡纹理和显著性的机制

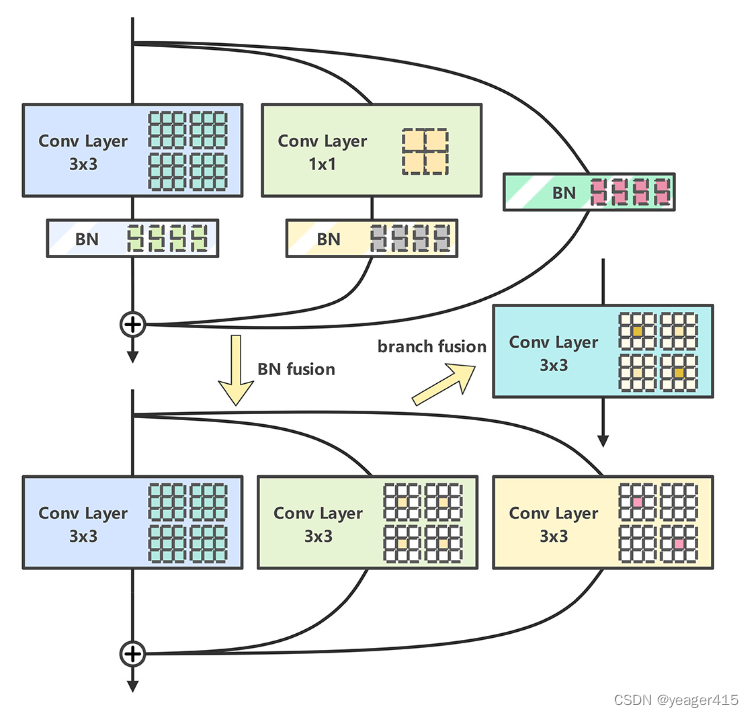

使用RepVGG来减少推理时间

end to end。提出的网络不仅轻量级,而且保留了源图像中最大量的有价值信息。

代码公开

2024 Optics and Lasers in Engineering

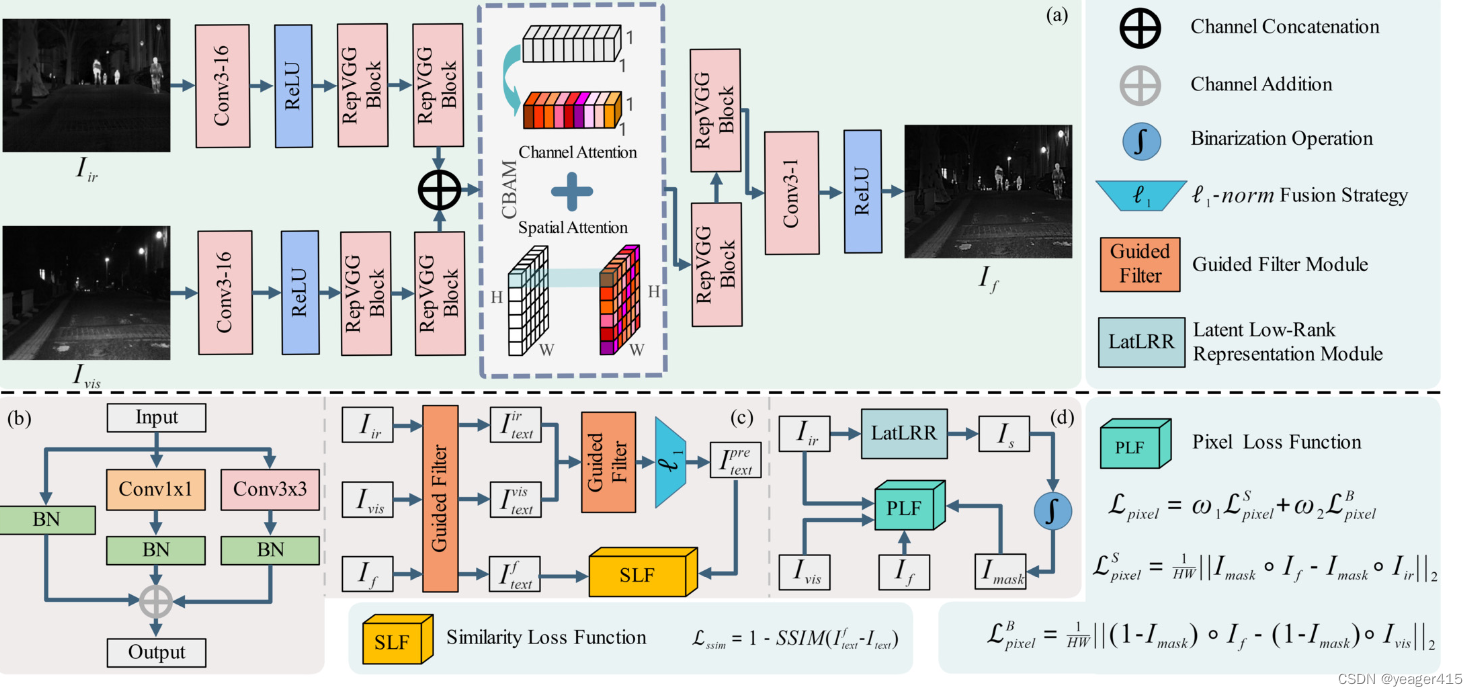

1.特征提取网络采用Pseudo-Siamese网络架构来对源图像进行差异化处理

2.重建部分引入了CBAM,通过通道和空间双重注意力机制进一步增强了模型表示能力。

3.最后,为了保持模型的轻量化,我们引入了RepVGG块以减少部署参数数量。

1、动机

在图像融合领域,保留源图像中最大量的相关信息在融合结果中是学者们的共识。然而,对于哪些信息应该被视为“有效”信息,仍然存在持续的争论。现有算法主要关注保留红外图像中的亮度信息和可见光图像中的纹理细节。

我们旨在保持相对较少的模型参数数量,同时确保融合性能。

作为一个端到端的模型,BTSFusion的目标是保持模型中前向结构的简洁,同时实现上述保留特征的目标。在网络框架的设计中,我们将算法的复杂性分配到损失函数中。

2、网络

RepVGG Block【23】通过结构重新参数化极大地提高了模型的推理速度。

这个是直接拿来用的

特征提取方面都很简单,都是conv block。重建使用了注意力机制,虽然作者说,通过CBAM消除了融合策略,但注意力机制不就是一种融合策略嘛。

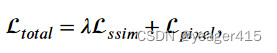

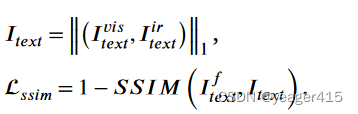

3、损失

3.1 相似性损失:

使用Guided Filter 提取纹理信息

使用L1准则初步融合VIS和IR的纹理,损失就是约束的这个pre-fuse的结果和最终的结果

3.2 元素损失

像素损失利用来自LatLRR的显著性图作为掩模来构建显著和背景区域。

同大多数方法一样:利用LatLRR分解得到IR的显著性掩码M,那么**(1-M**)就是用来提取VIS背景信息的Base掩码

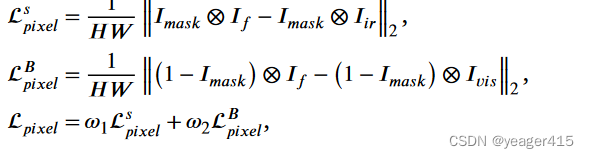

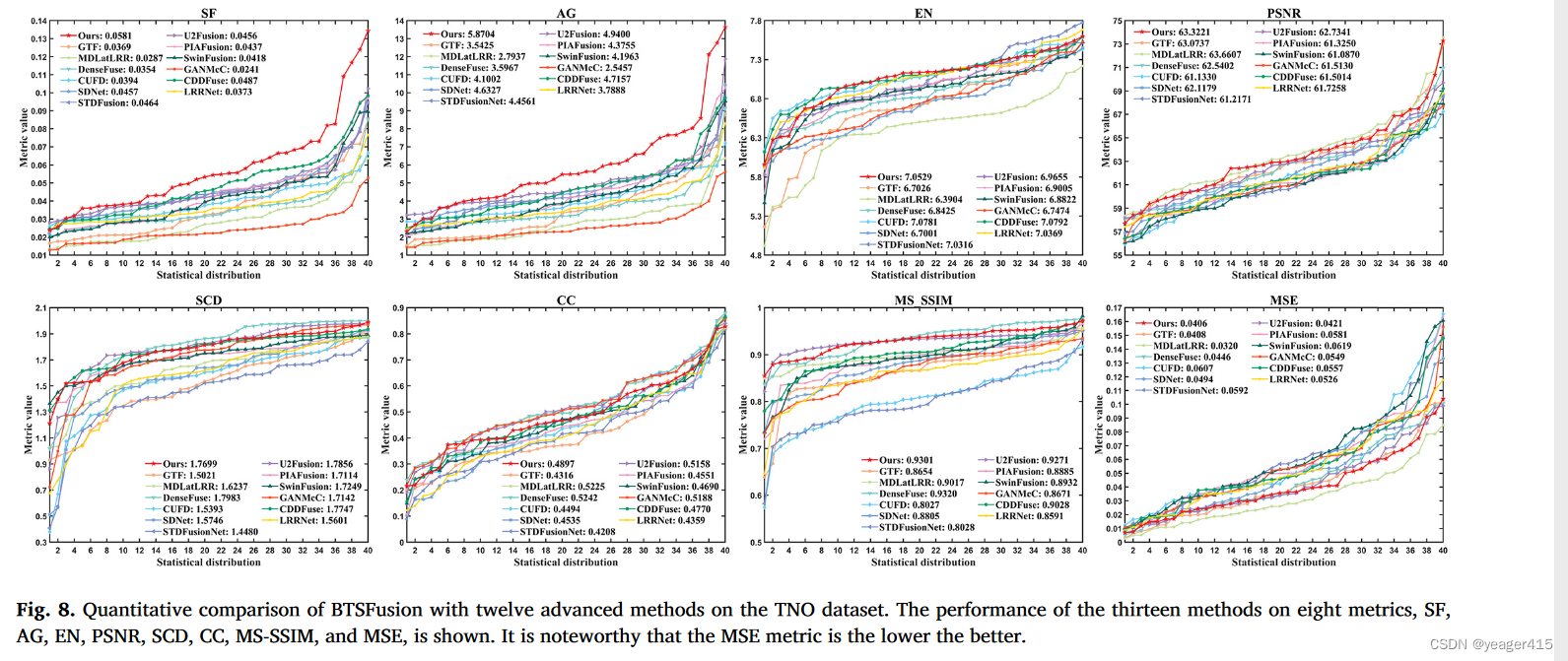

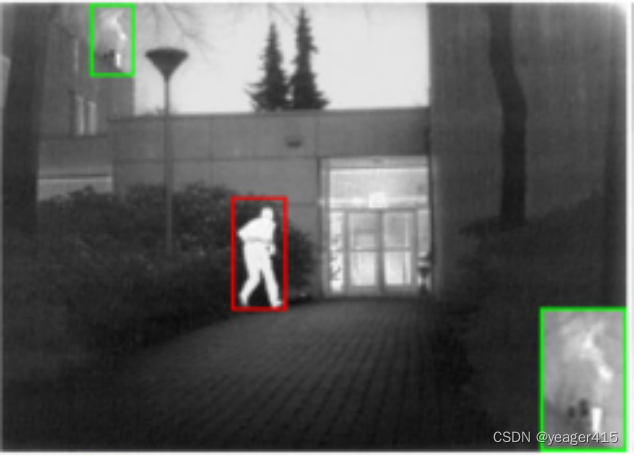

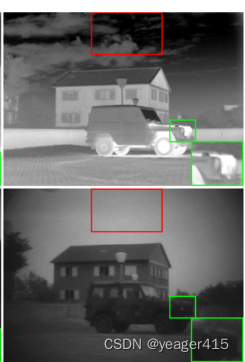

典型主观图

有种模糊的感觉,尤其是边缘,都发白

CDDFuse的结果却很好。但CDD这个树和背景的天空都与VIS一样,同时还保持了IR左上角的烟雾。

但CDD这个背景天空的纹理细节就没有了,也就是Base 偏向于IR图像。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?