个人阅读笔记,如有错误欢迎指出

期刊:IEEE TII 2022 Secure Partial Aggregation: Making Federated Learning More Robust for Industry 4.0 Applications | IEEE Journals & Magazine | IEEE Xplore

问题:

联邦学习的训练机制使得其容易受到后门攻击及成员推断攻击

当前关于联邦学习中的两种安全防御机制是割裂的(设计健壮的聚合规则,基于密码学的安全聚合协议)

创新:

限制客户端的上传比例

利用加密使服务器无法推断出私人信息,并提供安全的恶意客户端检测(同时防御客户端后门攻击和服务器推断攻击)

方法:

设置参数来控制每个客户端模型更新的上传比例---->使恶意客户端难以实现模型替换攻击(降低毒性)

通过分布式同态加密---->使模型更新对服务器不可见(服务器无法获得明文,无法推断单独的模型更新)

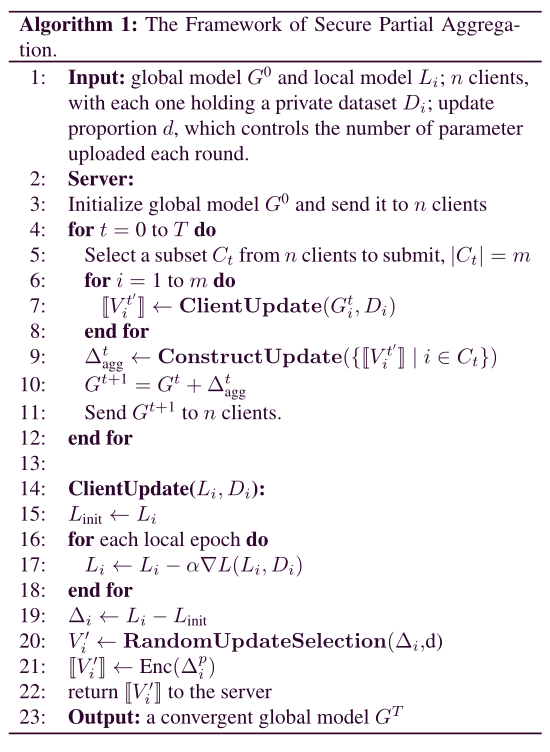

限制上传比例的聚合算法

客户端在向服务器上传其本地更新之前,要执行以和比例

为参数的RandomUpdateSelection(·)操作

其中,是模型参数的多层结构,将其faltten并concat成有

个部分的一维向量

。然后每个客户端用

随机填充

个部分,最终得到的模型更新为

服务器收到各个“部分的”客户端模型,需要将其构建聚合为完整模型,即对中的每一个部分的非零向量做平均,最终构成完整的聚合参数

实验:

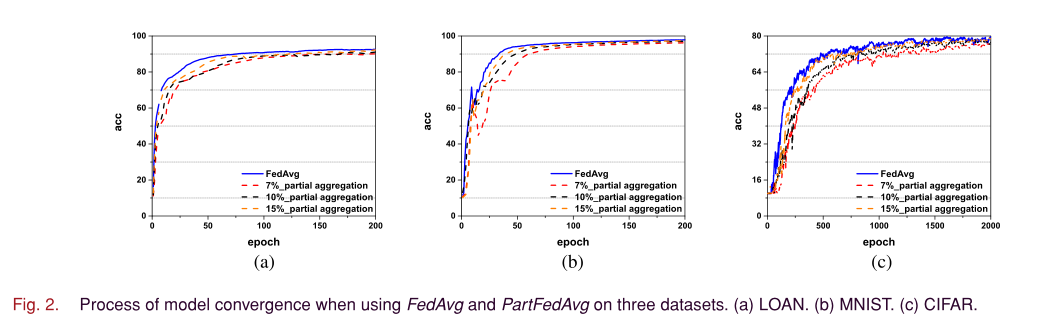

与FedAvg算法相比,本文提出的方法在精度上没有明显差异

在不同参数下模型收敛需要的轮数

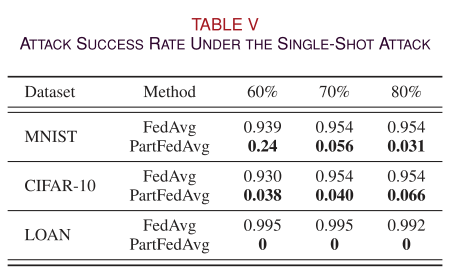

防御如模型替换攻击的single-shot攻击

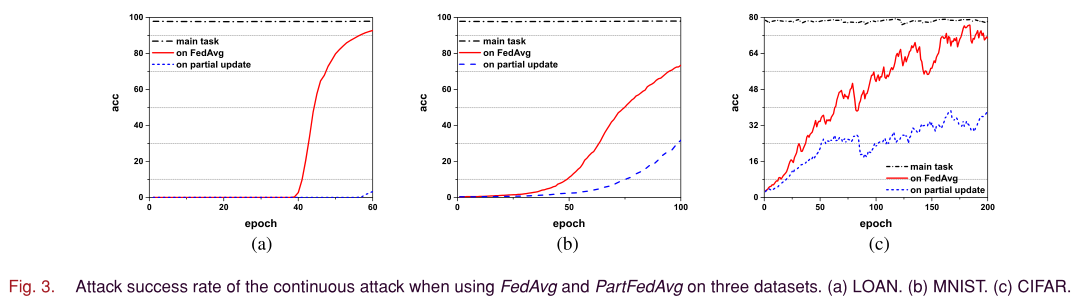

防御持续攻击

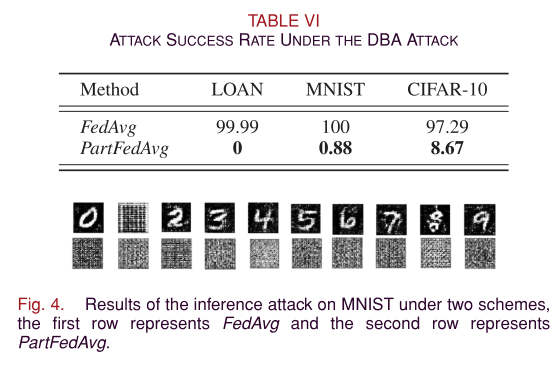

防御DBA攻击

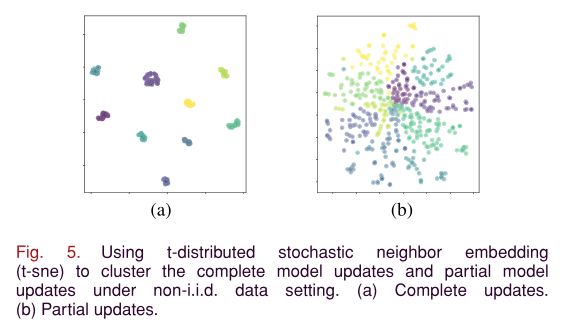

在non-iid设置下,与完整更新相比,上传部分参数的更新方不会暴露数据分布信息

读后感:

优点:

可以防御放大梯度的攻击,因为部分聚合策略让恶意客户端无法一次性执行后门攻击

可以防御推理攻击,因为客户端每次只上传部分参数,公开信息有限

可以和安全聚合策略兼容

局限性:

无法防御如符号反转攻击等无目标攻击

可以在一定程度上减轻恶意攻击的影响,但是不能完全消除恶意攻击,并且无法检测定位哪个客户端是恶意模型

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?