原论文:Rethinking the Inception Architecture for Computer Vision

作者:Christian Szegedy,Vincent Vanhoucke,Sergey Ioffe,Jonathon Shlens,Zbigniew Wojna

时间:Submitted on 2 Dec 2015 (v1), last revised 11 Dec 2015 (this version, v3)

本文的大部分观点来自于这篇论文,并且加入了一些自己的理解。该博客纯属读书笔记,欢迎吐槽。

General Design Principles

作者开始先摆出了4个通用的设计原则。

1.Avoid representational bottlenecks, especially early in the network.

因为我们只能根据表现(特征图)的各个维度的数据去粗略的提取这其中的特征,如果我们对当前的表现进行过度压缩(especially early in the network),那么很可能会造成信息的大量丢失。

2. Higher dimensional representations are easier to process locally within a network

高维表示可以用网络代替。在卷积网络中逐步增加非线性激活响应可以解耦合更多的特征,那么网络就会训练的更快。

3.Spatial aggregation can be done over lower dimensional embeddings without much or any loss in representational power

这里我理解的意思是在卷积之前对多通道的低维特征空间先进行降维(这里的降维是对通道数量进行降维)的做法不会降低特征的信息。

4.Balance the width and depth of the network

就是要找到最佳的网络拓扑结构,使得网络性能达到最优。

Factorizing Convolutions with Large Filter Size

作者提出尺寸过大的卷积滤波器会导致计算量急剧增加,例如5*5的卷积滤波器是3*3的25/9倍。所以能不能使用一个含有参数较少的多层的网络去代替参数较多的卷积滤波器,并且不会影响DNN的表达能力?

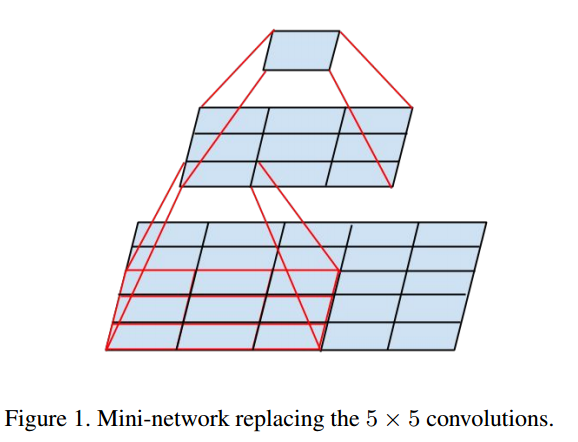

作者提出的方法是使用两层的神经网络可以代替原来的卷积滤波器来实现分解卷积滤波器。例如一个5*5的卷积滤波器可以使用一个3*3大小的两层级联网络代替。如图1所示。

图1

图1

相当于先使用一个3*3大小的卷积滤波器去卷积一个5*5大小的区块,然后将得到的输出再与包含3*3个神经元的网络层全连接最后得到一个输出。

这样参数就由原来的5*5个变成了现在的3*3*2个,减少了28%。至于计算量,作者说通过重用相邻块之间的激活同样可以减少约28%的计算量,但是具体怎么操作作者没详细说,我也不是很清楚,坐等大神解惑

还有就是作者说这样做不会降低网络的表达能力,并且通过实验表明,在网络中使用非线性激活比使用线性激活要好,不管是在第一层还是第二层。

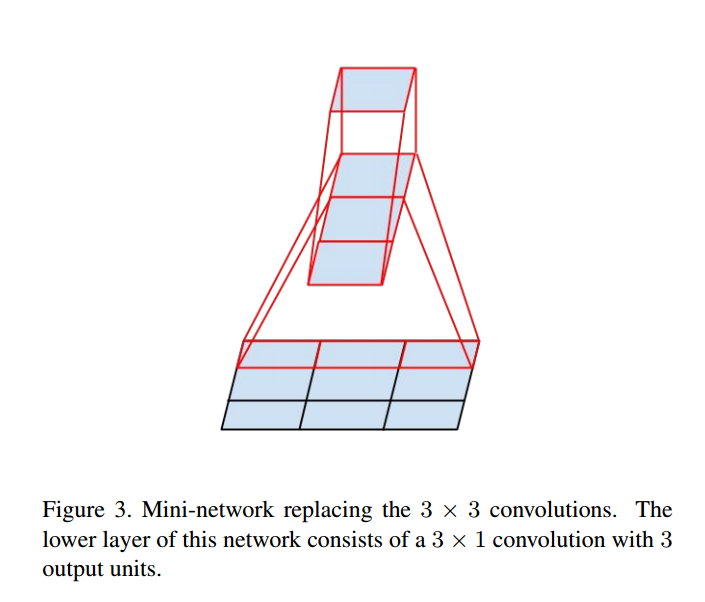

Spatial Factorization into Asymmetric Convolutions

作者在这里提出了另外一种简化卷积滤波器的方法,就是将空间的卷积运算简化成两个非对称的线性的卷积运算,也就是将一个n*n的卷积滤波器分解为两个n*1和1*n的卷积滤波器,例如3*3的卷积滤波器可以分解为3*1和1*3两个卷积滤波器,如图2所示。

图2

图2

这样参数又减少了,但是这样做在网络的浅层效果不太好。直到特征图维度不断变小,效果才开始明显。对于n*n的特征图,n一般要到12-20。在这个时候,使用7*1和1*7卷积得到的效果很好。

Utility of Auxiliary Classifiers

在V1中,文章通过使用辅助分类器,在性能上得到了一些提升,但是通过V2的BN方法,误差梯度已经可以有效地传递到网络的底层,这种辅助分类器已经没多大作用了。

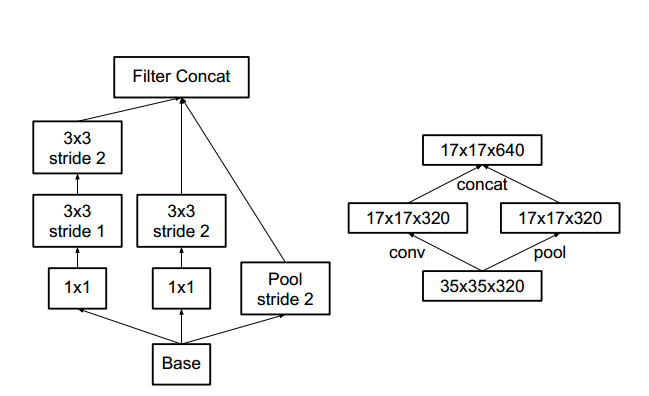

Efficient Grid Size Reduction

作者提出了一种更加有效的降低特征图维度的方法,就是使用两个并行的步长为2的池化层和卷积层。这样做可以有效的减少计算量,并且不会造成原则1所说的因过度压缩造成的信息损失。如图3所示。

图3

图3

至于这样做为什么可以防止信息损失我也不是很清楚。跟我我的理解,可能是对所有的特征图单一地进行池化过程很容易造成信息损失,因为这个过程只进行了简单的压缩出来,并没有做进一步的特征提取;而如果对所有的特征图并行地进行池化和卷积操作,相当于多了一步特征提取的操作,先对细节提取特征,然后再将特征图压缩。

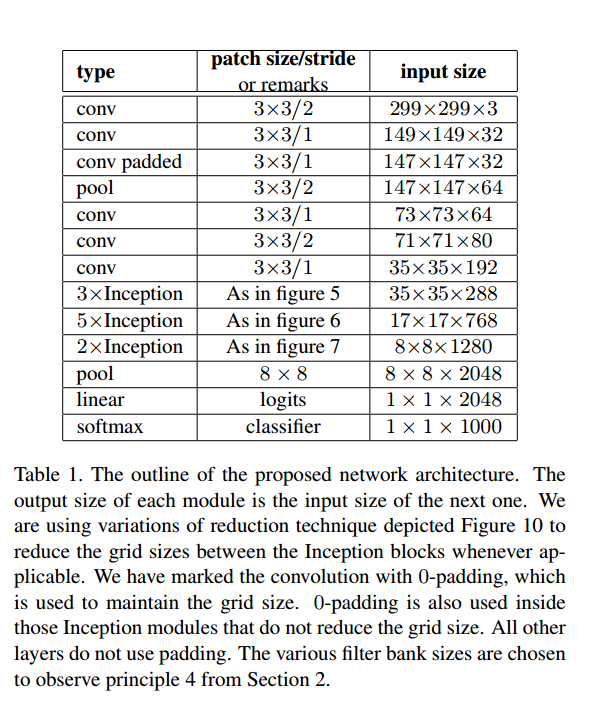

Inception-v2

大致结构如图4所示。

图4

图4

42层模型。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?