Y. Liang, Y. Li and B. -S. Shin, “Auditable Federated Learning With Byzantine Robustness,” in IEEE Transactions on Computational Social Systems, doi: 10.1109/TCSS.2023.3266019. 可免费下载:https://download.csdn.net/download/liangyihuai/87727720

机器学习 (ML) 在许多领域带来了颠覆性创新,例如医学诊断。 ML 的一个关键推动因素是大量训练数据,但由于数据孤岛和隐私问题,现有数据(例如医疗数据)并未被 ML 充分利用。 下面两张图给出了数据孤岛导致的问题应用示例。

联邦学习 (FL) 是一种很有前途的分布式学习范式来解决这个问题, 它可以在多方之间训练出一个机器学习模型,且不需要client将数据上传给服务器或其他人。

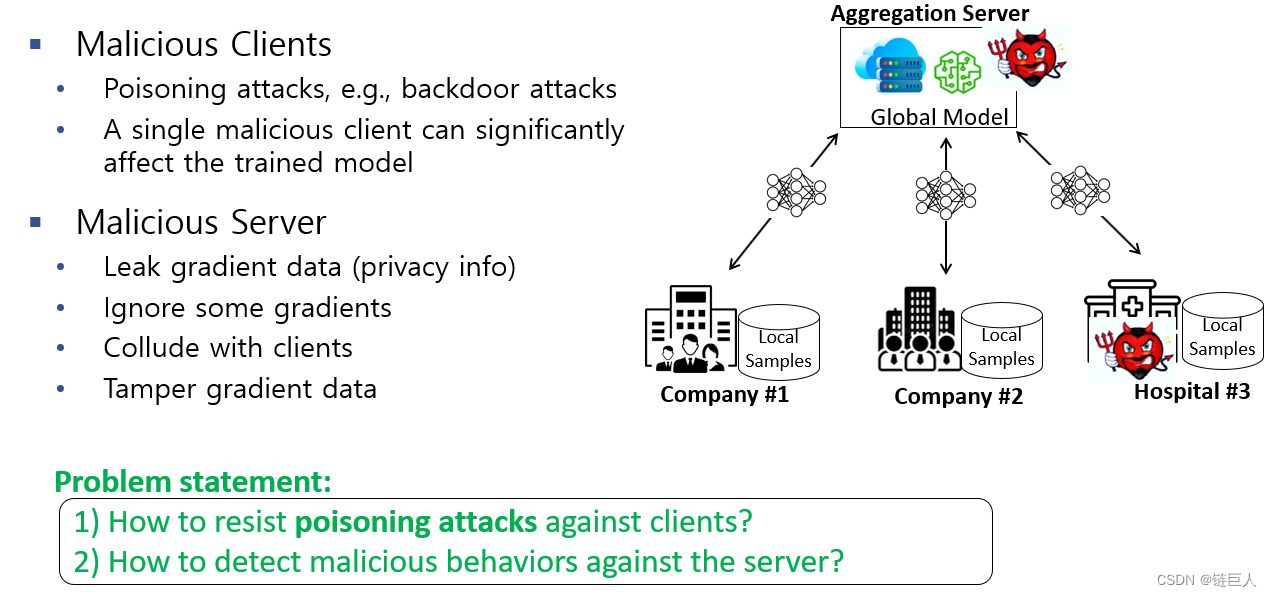

但是, 现有的 FL 方法容易受到恶意聚合器或客户端的中毒攻击或隐私泄露。 如下图所示:

本文提出了一种针对聚合器和客户端的具有拜占庭鲁棒性的可审计 FL 方案:聚合器是恶意的但可用的,客户端会实施投毒攻击。

论文针对联邦学习的cross-silo setting(多个公司、组织之间),解决了如下问题:

- 隐私保护:使用同态加密技术保护梯度数据。即使client和聚合器合谋,也无法破坏其隐私保护。

- 防止投毒攻击,且具有接近FedAvg方案的精确度。

- 可审计。任何一个参与者都能够审计来确定其它参与者(client或者聚合器)是否诚信,比如是否篡改了数据,是否诚信地聚合了梯度等等。

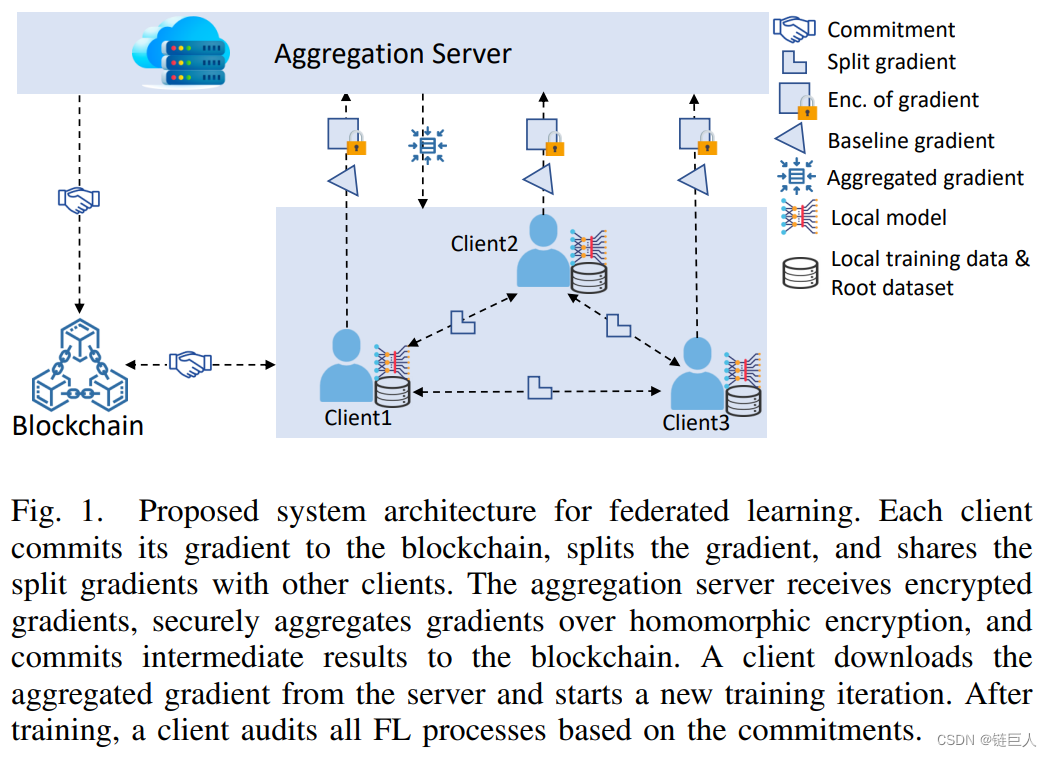

首先,应用用于同态加密的 Pedersen 承诺方案 (PCS) 来保护隐私和对 FL 过程的承诺以实现可审计性。 可审计性使客户能够验证整个 FL 流程的正确性和一致性,并识别行为不当的各方。 其次,基于 PCS 设计了一种有效的分而治之技术,允许各方合作并安全地聚合梯度以抵御投毒攻击。 这种技术使客户端能够不共享公用密钥并合作解密密文,即使其他客户端被对手破坏,也能保证客户端的隐私。 此技术经过优化以容忍客户端的丢失。 本文报告了针对恶意参与者的隐私、效率和可审计性的正式分析。 在各种基准数据集上进行的大量实验表明,该方案具有很强的鲁棒性,对中毒攻击具有较高的模型精度。

更多内容请查看论文原文:可免费下载:https://download.csdn.net/download/liangyihuai/87727720

谢谢!

1090

1090

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?