Depth Map Prediction from a Single Image using a Multi-Scale Deep Network

在这篇了论文中,我们提出了一种估计单张图片深度信息的新方法:使用神经网络对深度进行递归。分为两个步骤:首先估计出场景的整体结构,然后使用局部信息进行优化。这个网络使用。

3.1

模型结构

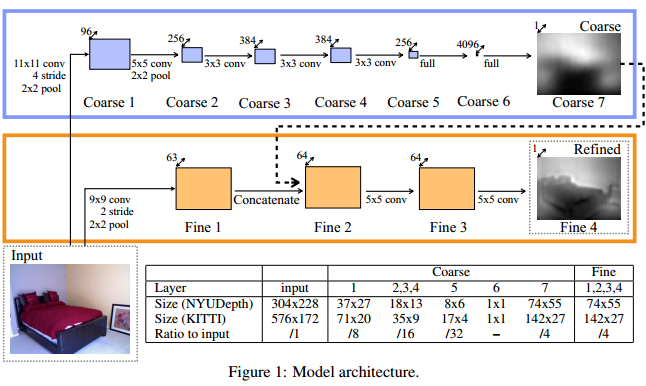

我们的网络由两个栈组成。如下图。

全局粗尺度网络

粗尺度网络的任务是使用场景的全局视角来预测整体深度图结构。网络的上几层是全连接层,因此可以包括整张图片的信息。同样的,底层和中间几层被设计通过最大池化操作降到一个小的空间维度,来连接图像不同部分。这样做了之后,这个网络能够整合整个场景全局的理解来预测深度。这样的针对全图的理解在单张图片中是需要的,因为这样可以有效地利用诸如消失点、物体位置、空间对齐等线索。局部线索(通常立体匹配)很难注意到这些重要的特征。

如上图所示,全局粗尺度网络包括了五个卷积、最大池化层,随后是两个全连接层。图中也描述了特征图和输出图的尺寸。最后的输出的尺寸是原图像素的1/4尺寸。相应的,一个中心的裁剪包括大多数的输入(我们待会儿会说到这个事情,我们在精细网络的第一层转化图像的时候,损失了图像边界的区域。)

注意输出的空间维数大于最高的卷积特征图。在通过网络预测之前,不是限制特征图尺寸的输出,而是依赖于硬编码上采样,我们允许顶层全连接层通过更大的区域来学习模板。这些是模糊的,但是将比上采样输出的8*6的预测更好。尤其是我们允许网络根据特征学习它自己的上采样。输出如下图所示。

所有的隐藏层用校正线性单元来激活(rectified linear units),随着第7层的线性的粗掠输出。dropout应用于隐藏在第6层后的全连接层。粗尺度网络卷积层(1-5)预先使用ImageNet分类训练过该模型。我们发现在ImageNET上预训练过的要比随机初始化的效果后。尽管差距不是很大。

局部细尺寸网络

在得到全局的深度图后,我们fine-scale网络来进行局部改进。这部分的工作,是编辑接收到的粗略的预测,结合例如物体和墙面边缘的局部细节。这个精细的网络只有卷积层和在第一层的边缘特征中有一个池化步骤。

当粗尺度网络能够看见整个场景,这个范围的视角下,精细网络的一个输出单元是输入中的045*45像素。卷积层被施加在目标输出尺寸的特征图中,允许在1/4输入尺寸的情况下有一个相对高像素的输出。

更具体的来说,粗略网络的输出被作为额外的低级特征图输入网络。粗略的预测被设计成具有和第一个精细网络层(池化之后)相同的空间大小,这样我们可以把二者结合起来。后续的层用0来填充卷积以保持这个尺寸。

所有的隐藏单元都用线性校正来激活。最后一个卷积层是先行的,它预测的是目标深度。我们训练粗尺度网络首先针对ground-truth目标,然后训练fine-scale网络保持粗尺度输出固定。(当我们训练fine网络时,我们不通过粗尺寸来反向传播)

尺度不变性错误

全局场景尺寸在深度预测中是根本模糊的。

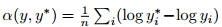

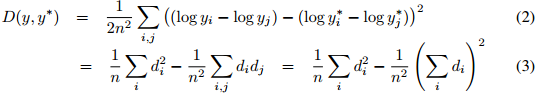

我们使用了一种尺度不变性误差去度量场景中点之间的关系,无关全局尺度的绝对值。对于一个预测的深度图y和ground truth y*,每n个像素被i索引,我们定义了一个尺度不变性误均值方差公式:

两面两个公式是展现量两种额外的能view这个度量的方法。

训练损失

除了性能评价,我们也尝试使用误差尺度不变性来作为训练损失,收到公式3的启发,我们设置每个训练样本的训练损失为:

我们使用随机在线transformations对训练数据进行扩充。

尺度:输入和目标图像的尺度按照比例缩小s倍[1,1.5],深度除以s

旋转:输入和目标旋转r[-5,5]度

平移:输入和目标随机裁剪成图1的大小

颜色:输入和输出全局乘以一个随机rbg值c[0.8,1.2]的立方。

Flips: Input and target are horizontally flipped with 0.5 probability.

翻转:输入和输出将被0.5概率的随机水平翻转。

注意图像的缩放和平移并不保留真实空间的几何关系,所以需要将变换后的图像除以尺度s。尽管平移操作不容易固定(他们有效的改变了相机和深度值的不兼容性),我们发现额外的数据能够提供更好的网络,即使场景有有轻微的改变。其他的平移、翻转和平面旋转,是几何上的保留。在测试时,我们使用一个1.0尺度缩放的中心区域的裁剪,没有旋转或者颜色改变。

实验

NYU Depth数据库

该数据集由464个由Kinect相机拍摄的室内场景的视频序列。我们使用官方的训练/测试分割,使用249个场景用于训练,215个用于测试。并使用这些场景的raw data来构建我们的训练集。RGB输入被折半降采样,从640*480降采样到320*240.因为深度和RGB相机运行着不同的可变帧率,随着时间的推移我们将每个深度图图像和它最相近的RBG图像联系起来,

3202

3202

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?