【Task03:误差从哪来】

err来源于bias,另一种来源于variance

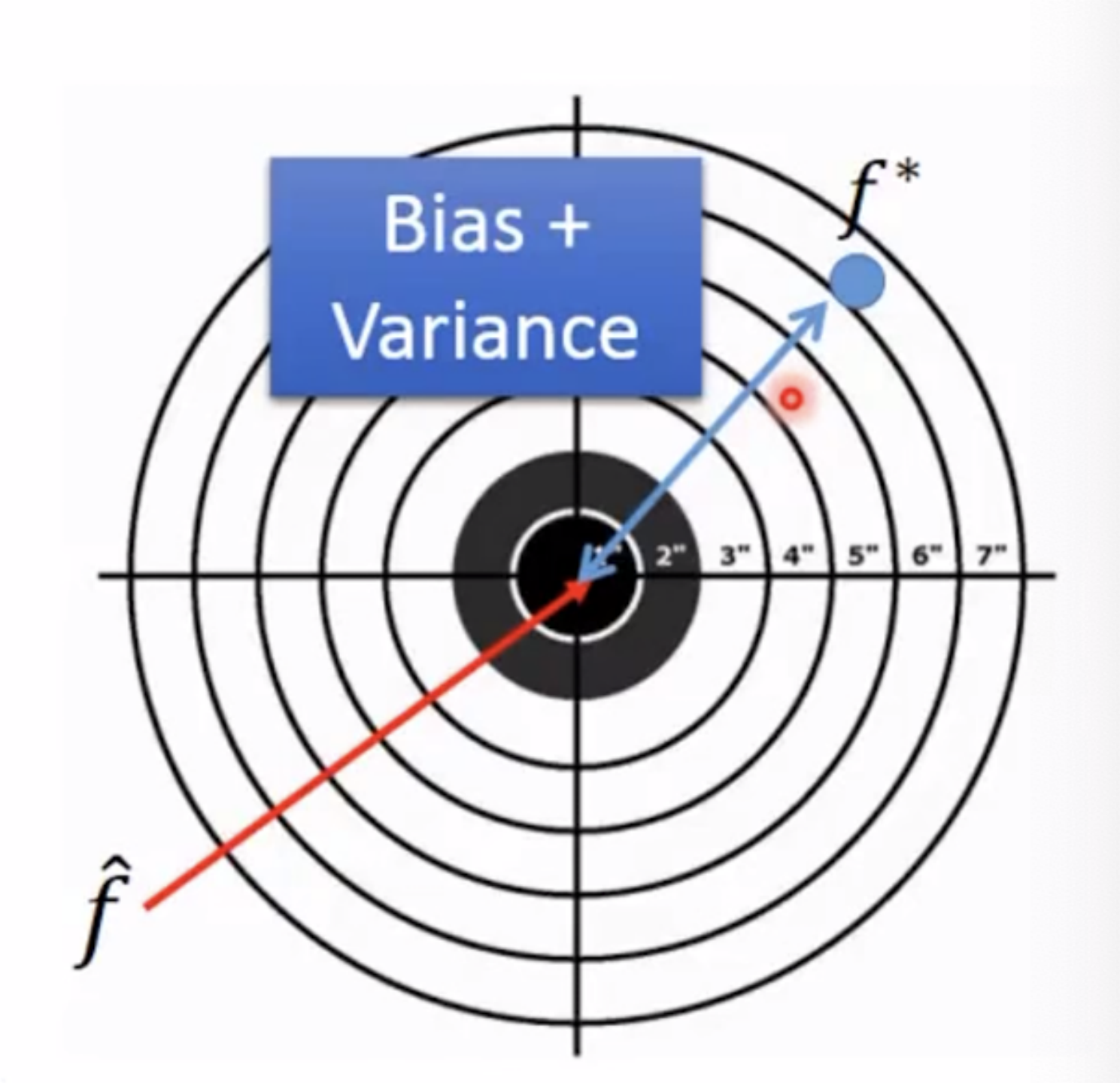

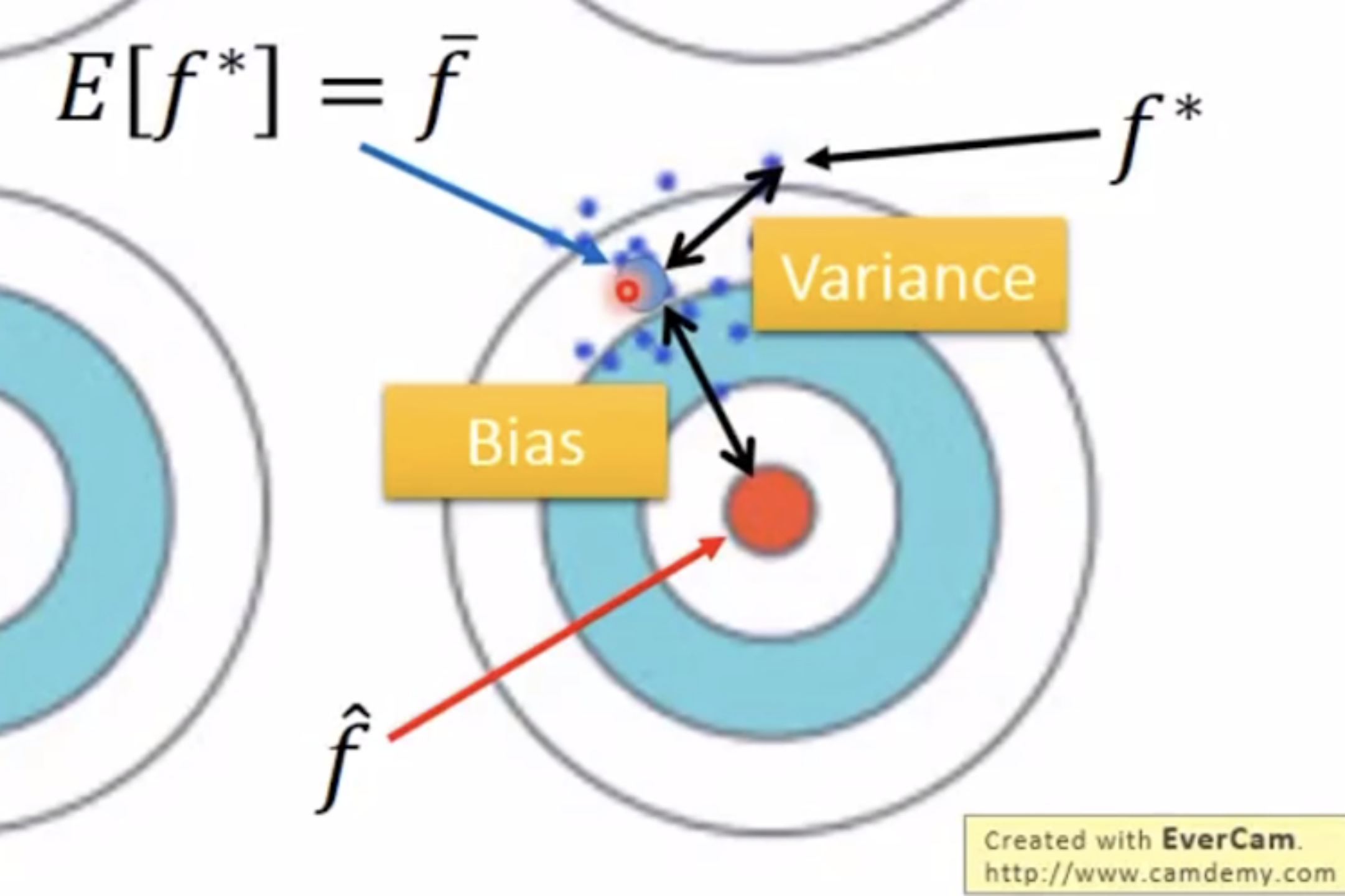

误差来源,第一个是你找出的最好的模型的平均值离理想最优模型之间的距离,这个称为bias,另一个则是你找的每一个最好的模型离平均值之间的距离,这个称为variance。主要是这两个方面。所以bias和variance两两组合,会出现低bias低variance,低bias高variance,高bias低variance以及高bias高variance。

但为什么会出现很多个f*,可以平行做n个平行实验,每一个实验都找一个f*。

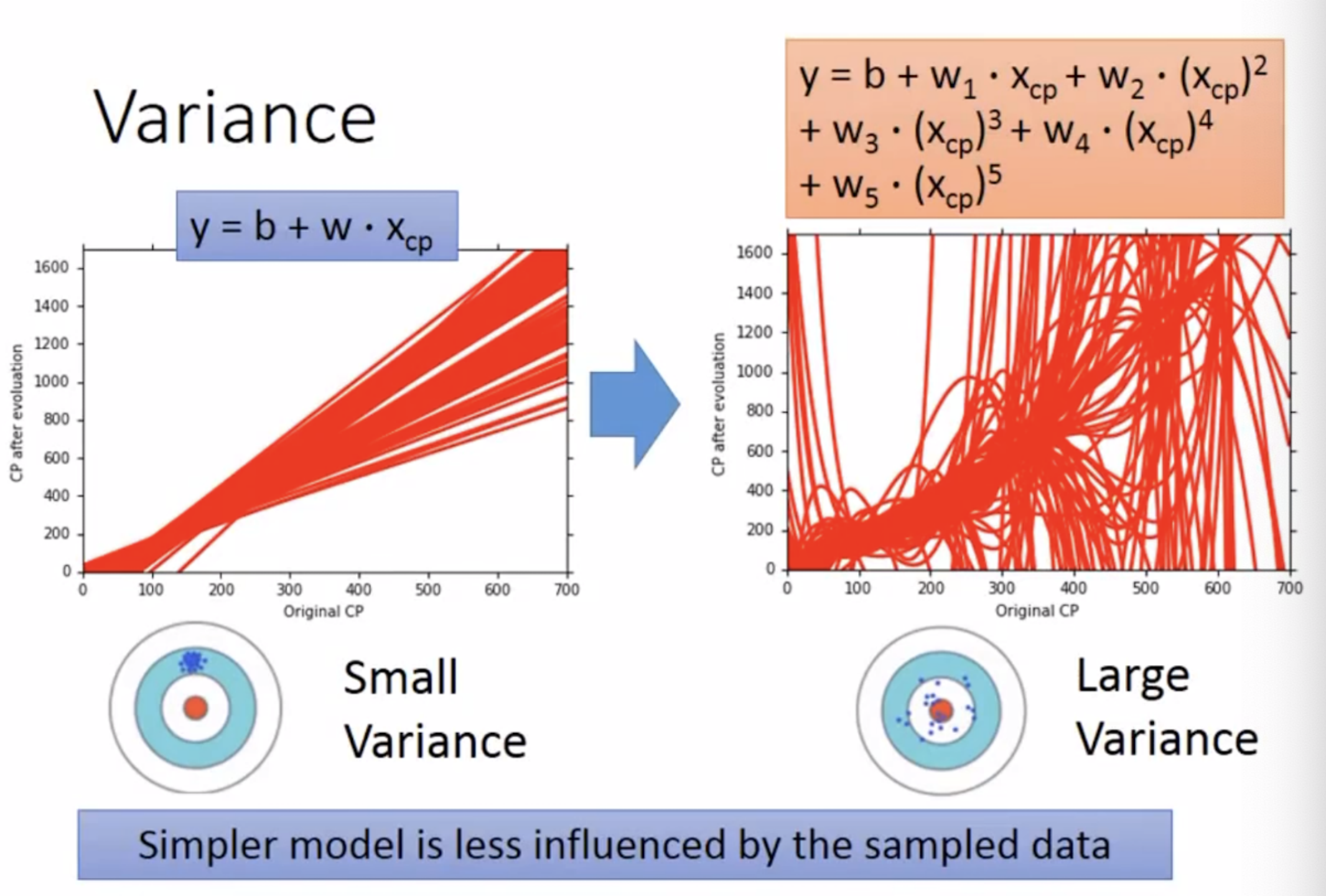

1.1 variance

使用简单模型时,其variance会比较小,但如果使用复杂模型时,其variance比较大,简单模型相较于复杂模型,其受到数据偏差影响会比较小。

1.2 bias

bias就是多个模型的平均值离理想模型的距离。

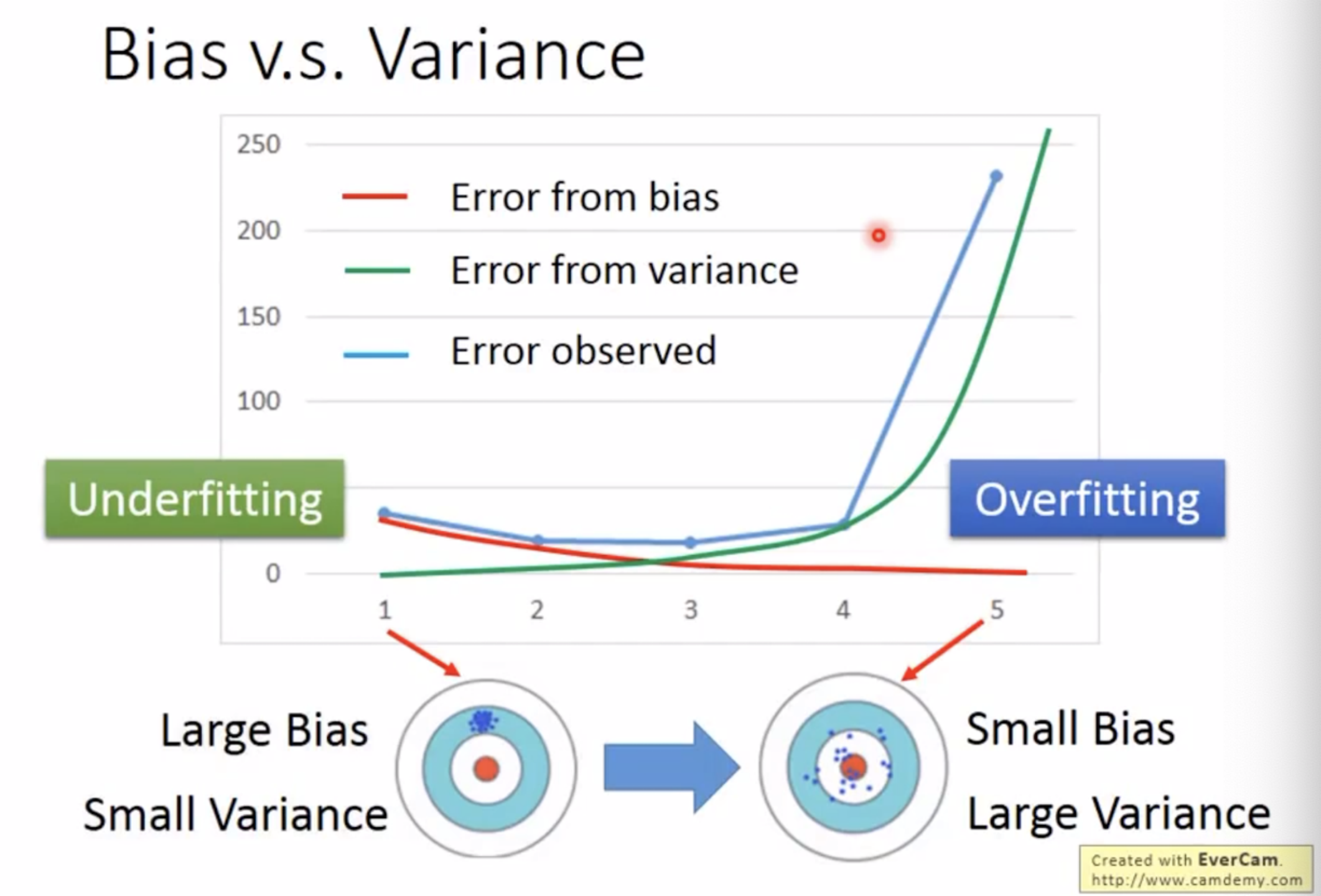

简单模型集并没有包含理想模型,而复杂模型则包含了理想模型,因此理想模型的bias会比较小。因此一个简单模型,他的variance会比较小,bias会比较大,一个复杂模型他的variance会比较大,而bias会比较小。

1.3underfitting和overfitting

如果一个模型他的误差主要来源于variance,这时可能会出现过拟合(overfitting:训练集训练模型能很好拟合,但存在很大的误差在测试集中,这时会有较大的variance,解决方法:增加你的data数量,正则化regularization,在加一个term)

如果一个模型他的误差主要来源于bias,这时可能会出现underfiting(模型都不能很好的拟合你的训练数据,这时会存在较大的bias,解决方法:需要你重新设计你的模型,增加更多的参数)。

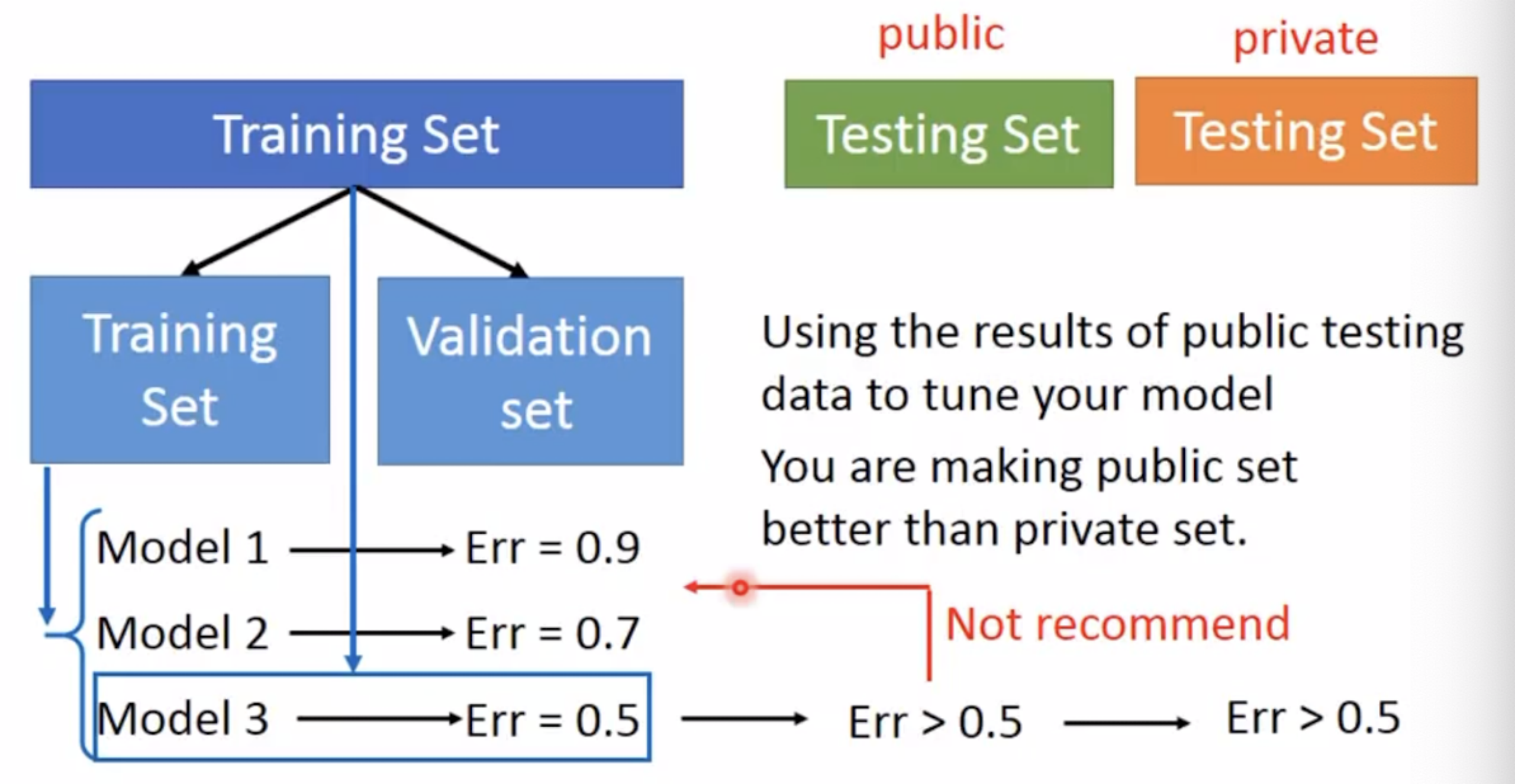

1.4交叉验证

将训练集分为实际的training set(训练模型)和validation set(选择模型),训练出n个模型,根据每个模型在validation set的训练表现(err),选出一个最佳的模型,如果你数据量不够,在用所有训练数据去跑一遍选出的模型。再根据这个最佳模型去用测试集的数据呈现,这时模型才会是最好的模型。

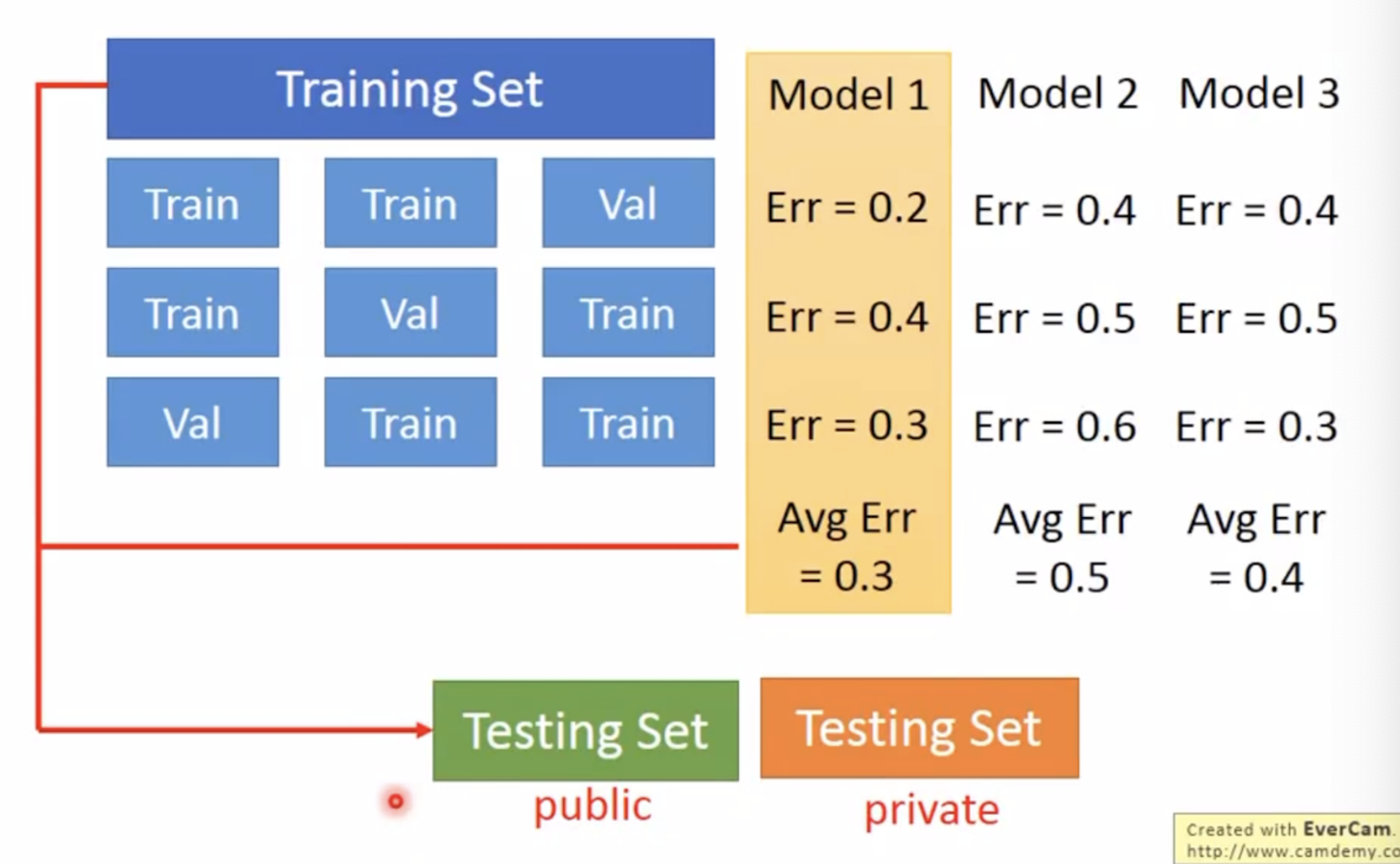

分数据:k-fold cross validation(k折交叉验证),根据多个数据分法,找出最佳的模型1后,在用完整的数据去训练模型1(确定一个最佳模型,在用所有的数据训练出最佳的参数),在用test数据去测试。

2746

2746

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?