【Task04:如何加快梯度下降速率】

1.1调整学习速率learning rate

不能过大或过小,一般需要合适的学习速率

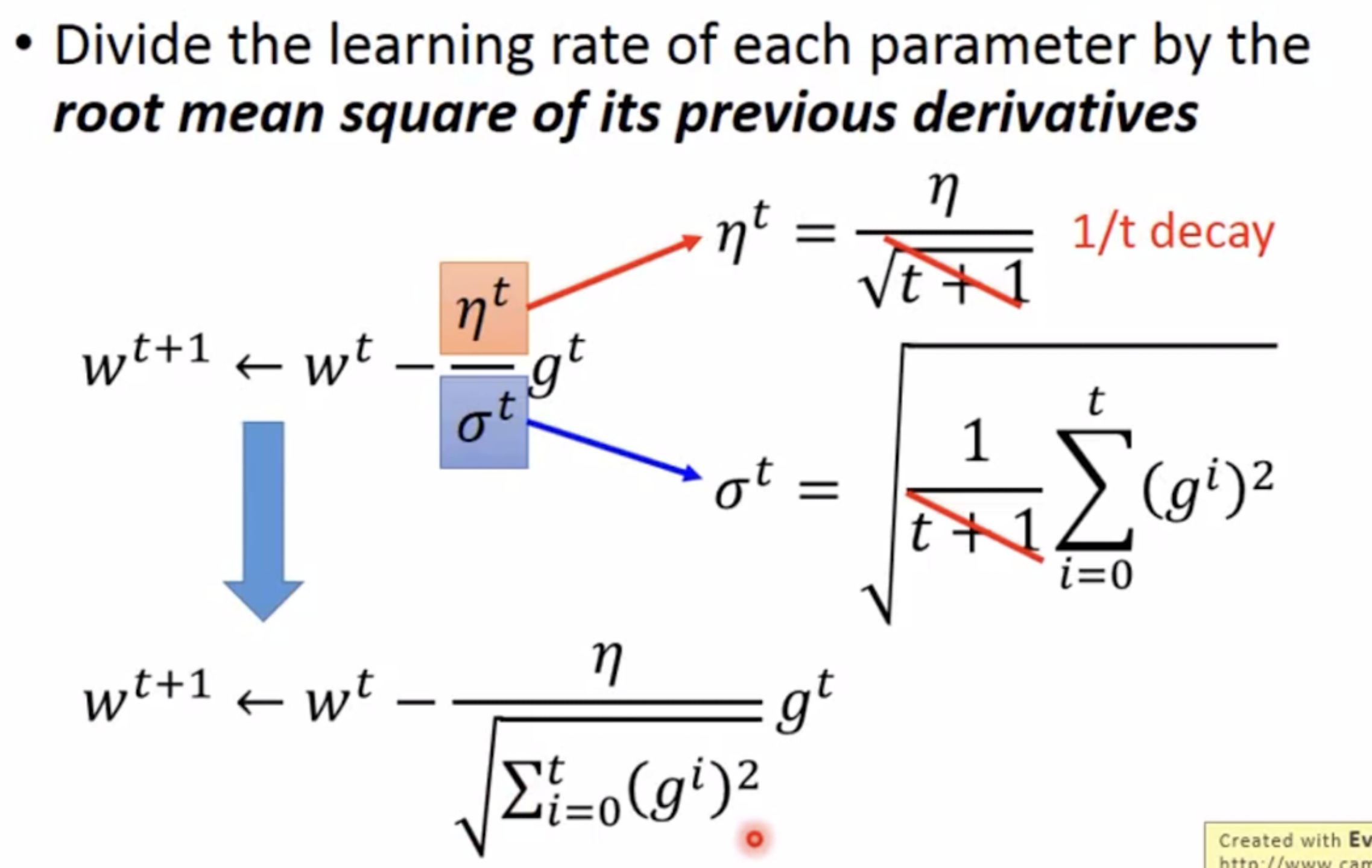

自动调整学习速率,设置一个学习速率的函数,例如

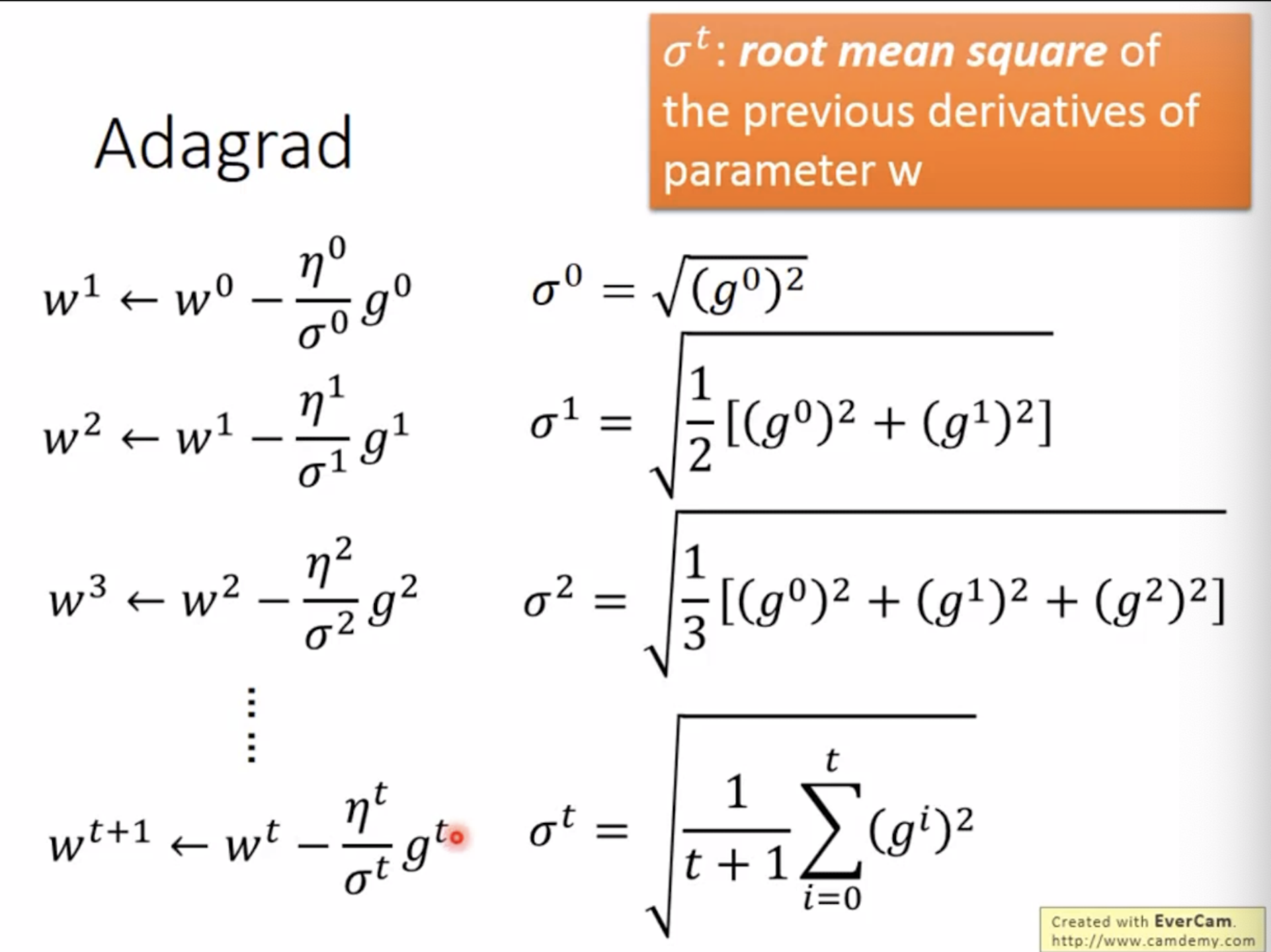

Adagrad自动调整方法,使得不同参数的学习速率都不同。

推导过程如下

因此学习速率实际变成了

找最佳步长(也就是学习速率和梯度相乘的值):一次微分的绝对值/二次微分值(

,二次微分用一次微分表示,可以减少计算量)

1.2 随机梯度下降(使得数据训练更快)

算某一个例子的loss值,不算所有例子的loss值

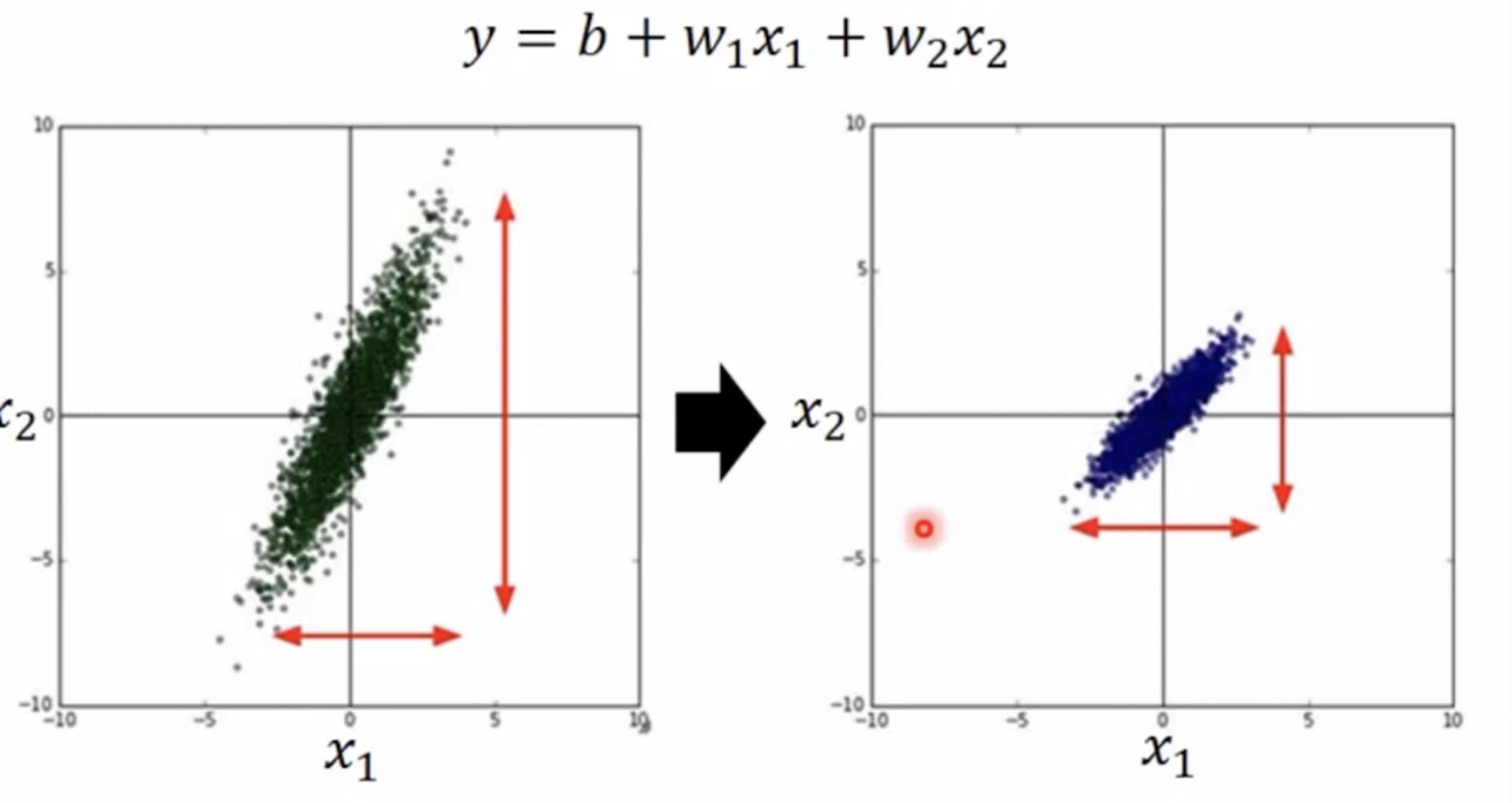

1.3 feature scaling

不同的特征他的scale一致,让每个特征值标准化,让每一个特征对于loss的贡献一致,可以充分考虑到每一个特征。

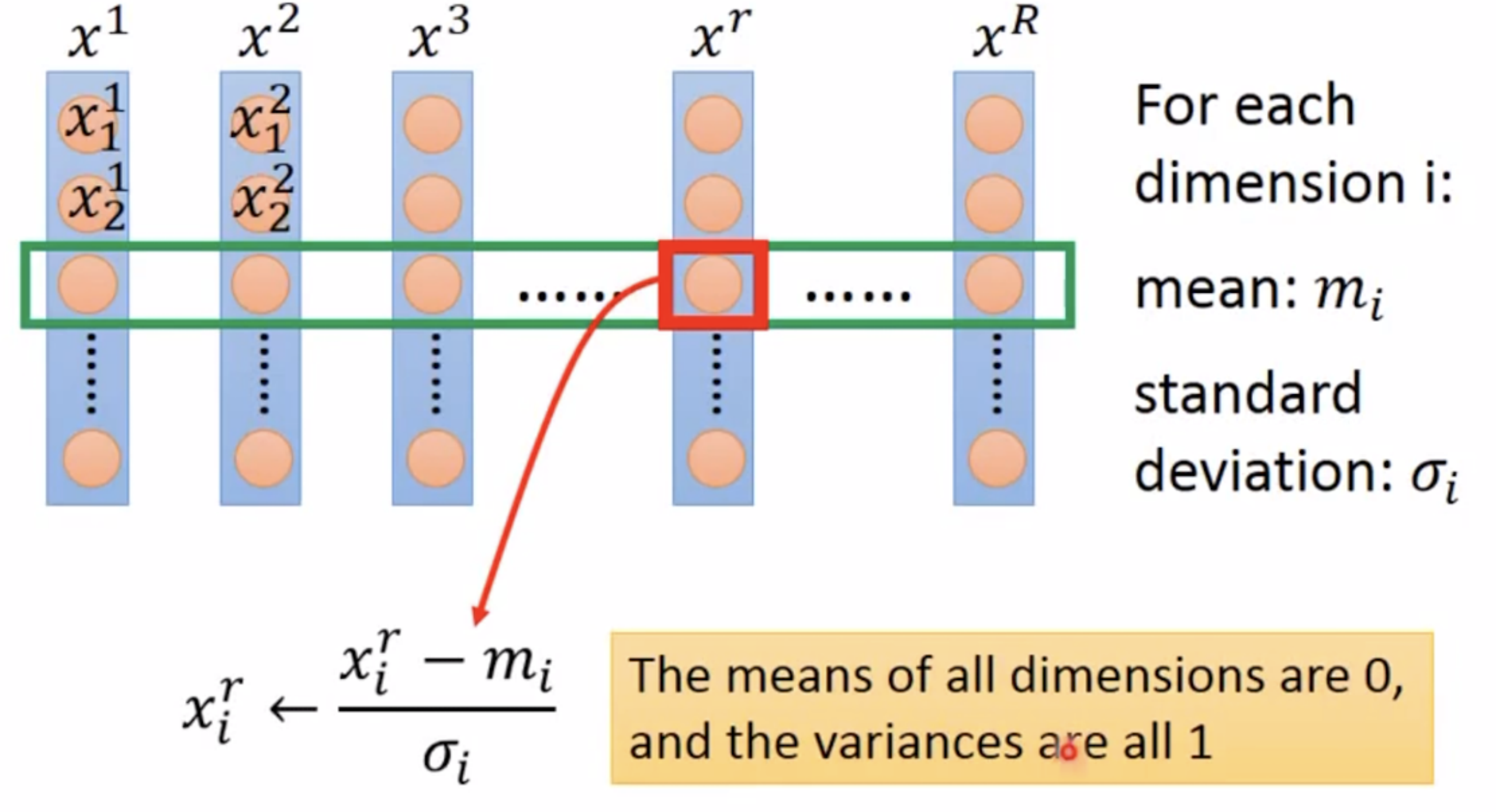

如何做feature scaling,标准化(z-score)

285

285

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?