1 Title

EQUIVARIANT HYPERGRAPH DIFFUSION NEURAL OPERATORS(Peihao Wang, Shenghao Yang, Yunyu Liu, Zhangyang Wang, Pan Li)【ICLR 2023】

2 Conclusion

Hypergraph neural networks (HNNs) using neural networks to encode hypergraphs provide a promising way to model higher-order relations in data and further solve relevant prediction tasks built upon such higher-order relations. However, higher-order relations in practice contain complex patterns and are often highly irregular. So, it is often challenging to design an HNN that suffices to express those relations while keeping computational efficiency. Inspired by hypergraph diffusion algorithms, this work proposes a new HNN architecture named ED-HNN, which provably approximates any continuous equivariant hypergraph diffusion operators that can model a wide range of higher-order relations. ED-HNN can be implemented efficiently by combining star expansions of hypergraphs with standard message passing neural networks

3 Good Sentences

1、To capture these higher-order relations, hypergraphs provide a dedicated mathematical abstraction. However, learning algorithms on hypergraphs are still far underdeveloped as opposed to those on graphs(The problems that algorithms still need develop of HyperGraph)

2、 However, traditional hypergraph diffusion needs to first handcraft potential functions to model higher-order relations and then use their gradients or some variants of their gradients as the diffusion operators to characterize the exchange of diffused quantities on the nodes within one hyperedge. (The disadvantages of previous diffusion model that needed handcraft)

3、Previous design of hyperedge potential functions is tricky. Early works adopted clique or star expansion by reducing hyperedges into edges and further used traditional graph methods. Later, researchers proved that those hyperedge reduction techniques cannot well represent higher-order relation(The problems of previous ways which to make a hypergraph potential functions )

与图的学习算法相比,超图的学习算法仍然很不发达。

在这项工作中,受到最近发展的超图扩散算法的启发(Quadratic decomposable submodular function minimization: Theory and practice、Strongly local hypergraph diffusions for clustering and semi-supervised learning、Local hyper-flow diffusion、Hypergraph clustering based on pagerank、 Nonlinear higher-order label spreading)

本文设计了一种新颖的HNN架构,该架构具有可证明的表达性,可以在保持计算效率的同时近似一类超图扩散。对于超图扩散,在传统方法中,需要手动设计势函数来模拟和表示超图中的高阶关系。这些势函数用于捕捉节点之间的复杂交互。一旦定义了势函数,就可以通过计算它们的梯度或梯度的变体来得到扩散算子。扩散算子用于描述在超边内的节点之间扩散量的交换。这些算子表征了在单个超边上的节点之间,扩散量的传递和交换。

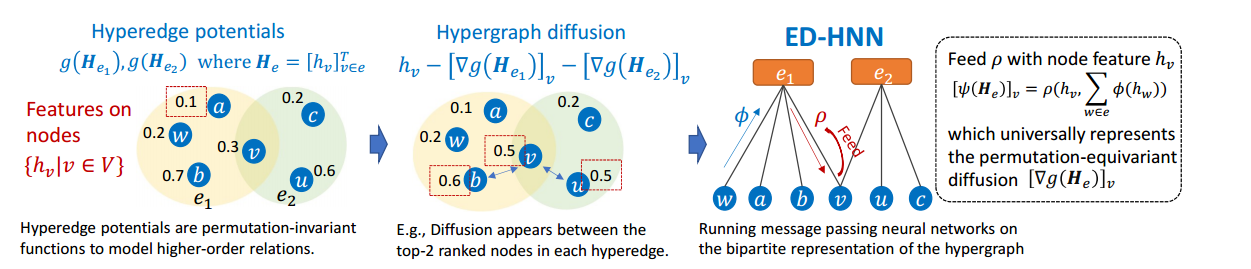

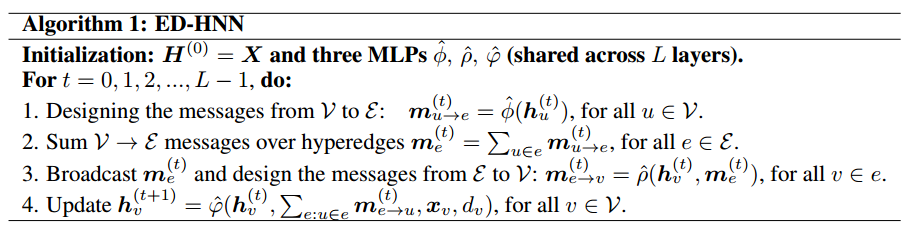

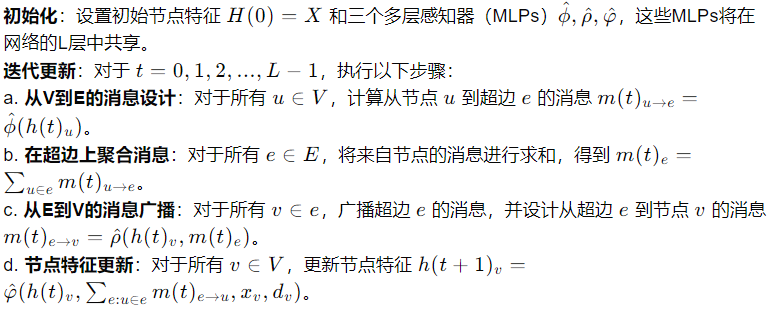

作者观察到在超图的高阶关系中常用的势函数具有排列不变性,适用于那些在关系中不区分任何节点为特殊的场景。对于这样的势函数,作者进一步展示了它们诱导的扩散算子必须是排列等变的,这保证了在节点排列变化时,扩散过程能够以一种一致的方式响应。这是一种确保模型在处理高阶关系时具有对称性和一致性的重要特性。基于前述关于排列等变扩散算子的启发,本文提出了一种新的架构。NN-parameterized architecture(NN参数化的架构),这个架构不仅能够明确表示任何排列等变的连续超边扩散算子,而且其参数还可以通过数据驱动的方式进行学习。这种设计允许模型自动从数据中学习到如何模拟复杂的高阶关系和扩散过程,而不是依赖于手工设计或预先定义的函数。结合NN参数化架构,本文最终提出了ED-HNN,ED-HNN是一种排列等变且能够处理连续超边扩散的神经网络模型,它利用了双分部图表示和标准的消息传递神经网络架构,并通过层叠架构和共享参数来构建模型。这种设计使得ED-HNN能够以数据驱动的方式学习表示复杂的高阶关系和扩散过程。

以上架构分别是超图势函数、超图扩散、以及ED-HNN。

- 超边势函数用于建模高阶关系,是排列不变的,意味着它们不依赖于节点的排列顺序。

- 超图扩散是一个过程,其中信息或状态通过超边在节点之间传递。扩散过程由超边势函数的梯度决定,这些梯度也被称为扩散算子。

- ED-HNN的设计保证了排列等变性,即模型输出对于节点排列的变化是不变的。

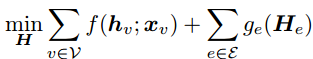

先验知识:Hypergraph Diffusion:对于v∈V,定义节点势函数,,而对于每条边,定义超边势函数

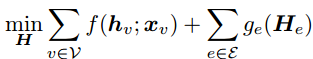

, 超图扩散结合了节点属性和超图结构,要求解决以下问题:

。在实际应用中,相同大小的超边通常共享

。在实际应用中,相同大小的超边通常共享 。下文省略了下标 e。在传统的超图扩散文献中,这两个势函数通常是通过启发式方法设计的。节点势函数通常对应于潜在特征和属性的一些负对数核。

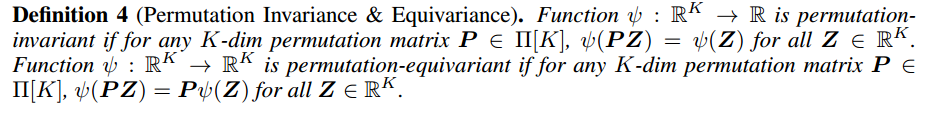

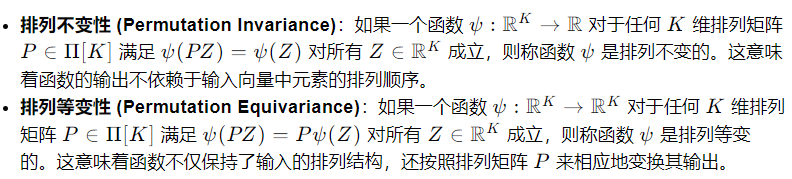

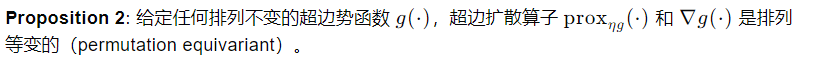

因为超边势函数更为重要和复杂,需要模拟两个以上对象之间的高阶关系,这使得超图扩散与图扩散大不相同,为了揭示超边势函数的一些特性,本文定义:Permutation Invariance & Equivariance:

其基本物理意义在于,应用的预测目标与超键中的节点身份无关,因此实际的 g 通常与节点排序保持不变。

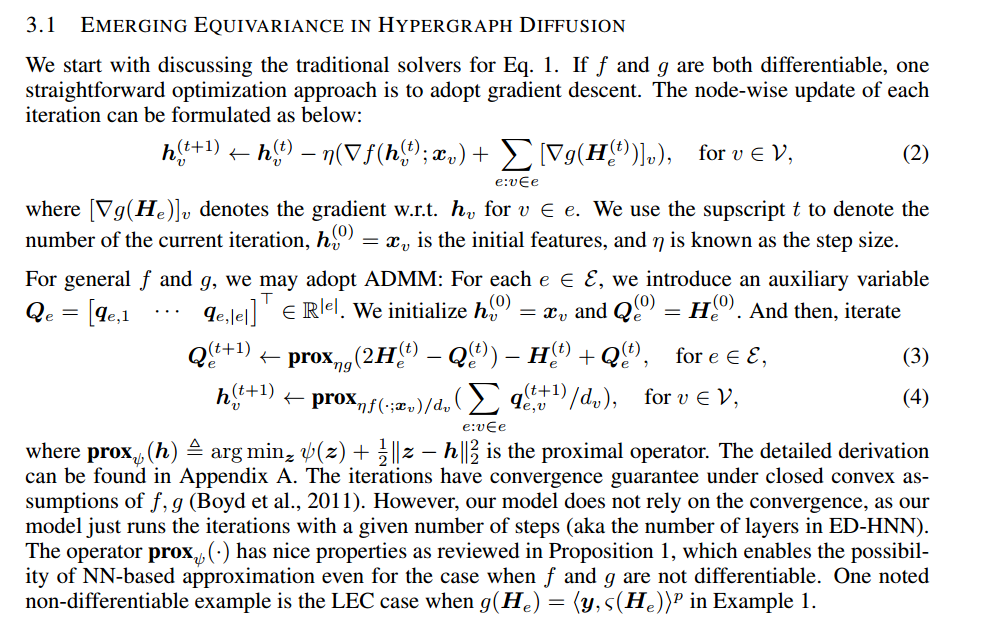

而在本文中,证明了求解 相当于迭代应用一些超图扩散算子,证明过程我就不看了,数学方面的问题搞不懂,之前那个KAN就看不懂。证明如下,

相当于迭代应用一些超图扩散算子,证明过程我就不看了,数学方面的问题搞不懂,之前那个KAN就看不懂。证明如下,

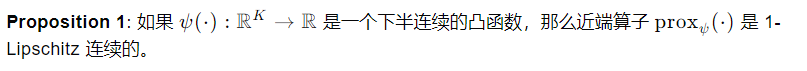

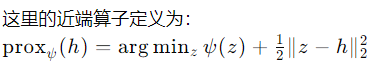

总之有两个性质,

这个性质允许:即使在 f 和 g 不可微的情况下,也可以通过近端算子来有效地更新节点特征。

这个性质允许:即使在 f 和 g 不可微的情况下,也可以通过近端算子来有效地更新节点特征。

这里的“排列不变”意味着势函数g在超边中节点的排列顺序发生变化时,其函数值保持不变。而“排列等变”则是指扩散算子在处理节点特征时,能够以一种与排列顺序相一致的方式进行操作。它揭示了排列不变势函数如何自然地导致排列等变的扩散算子,这为设计和理解超图神经网络中的扩散过程提供了理论基础。

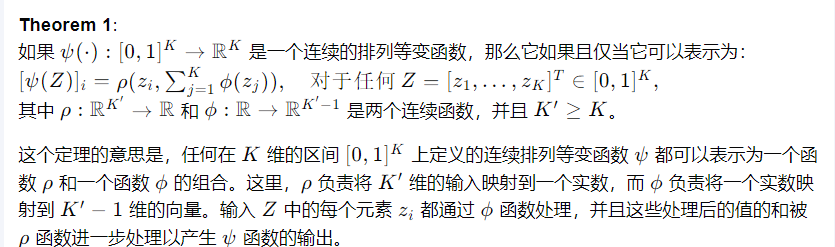

BUILDING EQUIVARIANT HYPEREDGE DIFFUSION OPERATORS:

这一节主要是构建超边扩散算子相关的,

Theorem 1 的提出为设计排列等变的神经网络架构提供了理论基础,这对于处理超图数据具有重要意义,因为超图数据天然具有耦合集合的特性。

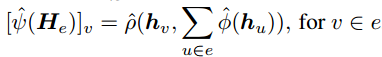

对于算子![]() 可以表示每个超边 e 的梯度

可以表示每个超边 e 的梯度![]() 或近端梯度

或近端梯度![]() ,可以将其参数化为

,可以将其参数化为 ,其中

,其中![]() 是多层感知机。

是多层感知机。

以上就是ED-HNN的算法实现。.

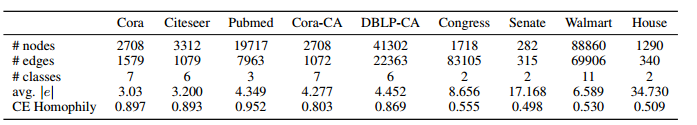

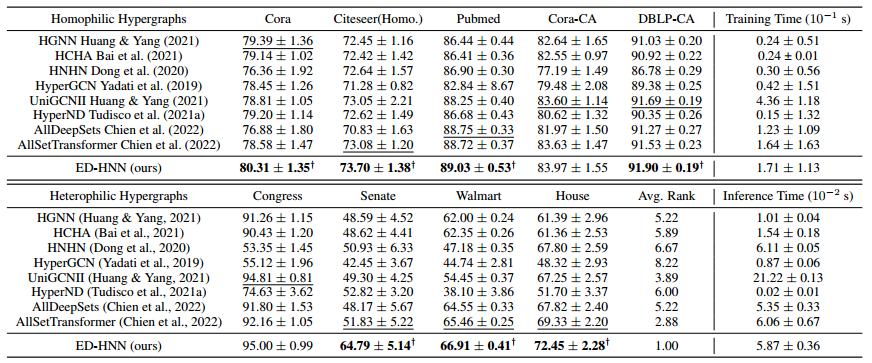

数据集: 实验结果:

实验结果:

7347

7347

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?