写一篇介绍 Transformer 神经网络模型的实现原理的论文,题目叫《 Transformer 神经网络模型的实现原理》,细化到3级目录,不少于2500字。用markdown格式输出。

Transformer 神经网络模型的实现原理

概述

Transformer神经网络模型是一种深度学习模型,其中包含了自注意力机制和分层位置编码。它从简单的结构中提取抽象的表示,用于解决认知任务,如自然语言处理,机器翻译,文本分类和语音识别。Transformer模型的工作原理是将输入序列(如一段文本)编码为内部表示,然后使用自注意力机制进行处理,以生成输出序列(如语义分析)。

本文旨在介绍Transformer神经网络模型的实现原理,包括它的结构,自注意力机制,编码技术以及模型优化等。

Transformer模型结构

Transformer模型由一系列“层”组成,每一层都包含一个输入和输出,其输入和输出可以是单独的子层,也可以是一个整体层。Transformer模型的结构如下图所示:

Transformer模型的第一层是编码层,它将输入序列编码为内部表示,使用的技术是嵌入法。编码层的输出被传递到第二层,称为自注意力层,它使用注意力机制来提取输入序列中的重要特征,并将这些特征聚集到输出序列中。最后,自注意力层的输出被传递到第三层,称为解码层,它将输出序列解码为最终的输出。

Transformer模型的另一个重要组成部分是编码技术,它将输入序列编码为内部表示,使用的技术是嵌入法。嵌入法将输入序列中的每个词映射到一个实数空间,以表示语义。在嵌入法中,每个词都被映射到一个定长的实数向量,这个向量保存了词的语义信息。

自注意力机制

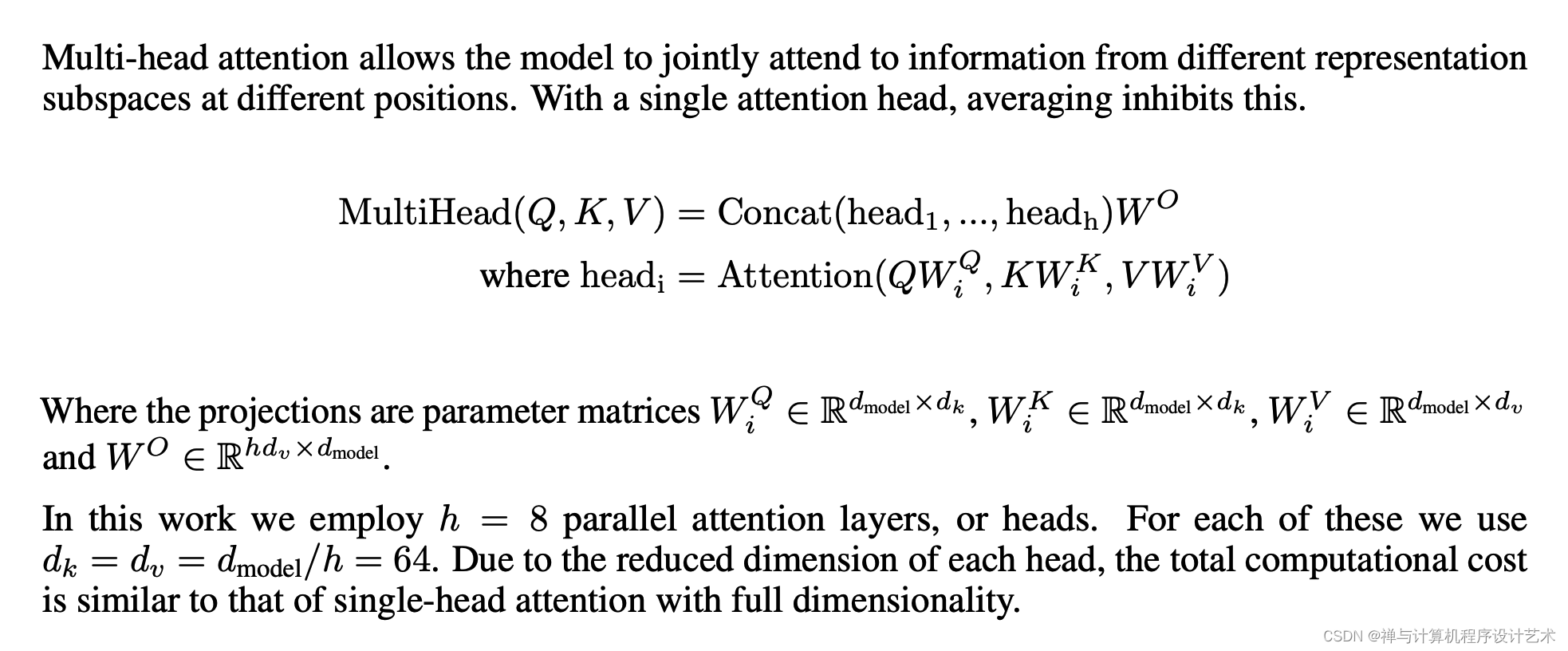

自注意力机制是Transformer模型中最重要的技术,它可以提取输入序列中的重要特征,并将这些特征聚集到输出序列中。自注意力机制的基本思想是,我们可以用一个函数来计算输入序列中各个词之间的相关性,从而提取重要特征。

自注意力机制的实现原理是,首先将输入序列映射到一个实数空间,然后使用一个可学习的参数和一个注意力函数来计算每个词之间的相关性。最后,使用一个聚合函数来聚合这些相关性,从而生成输出序列。

编码技术

Transformer模型中使用的编码技术是嵌入法,它将输入序列中的每个词映射到一个实数空间,以表示语义。嵌入法的实现原理是,首先将输入序列中的每个词映射到一个定长的实数向量,这个向量保存了词的语义信息。然后,使用可学习的参数将这些实数向量进行计算,以获得输入序列的内部表示,这就是嵌入法的基本思想。

模型优化

为了改进Transformer模型的性能,可以使用模型优化技术。模型优化技术可以通过调整参数或改变模型结构来改进模型的性能。

例如,可以使用梯度下降算法来调整参数,从而改进模型的性能。也可以使用模型压缩技术来减少模型的参数数量,从而提高模型的性能。

结论

本文详细介绍了Transformer神经网络模型的实现原理,包括它的结构,自注意力机制,编码技术以及模型优化等。Transformer模型是一种深度学习模型,其中包含了自注意力机制和分层位置编码,它从简单的结构中提取抽象的表示,用于解决认知任务,如自然语言处理,机器翻译,文本分类和语音识别。

附:模型训练代码:

https://gitcode.net/mirrors/kyubyong/transformer

# -*- coding: utf-8 -*-

# /usr/bin/python3

'''

Feb. 2019 by kyubyong park.

kbpark.linguist@gmail.com.

https://www.github.com/kyubyong/transformer

Transformer network

'''

import tensorflow as tf

from data_load import load_vocab

from modules import get_token_embeddings, ff, positional_encoding, multihead_attention, label_smoothing, noam_scheme

from utils import convert_idx_to_token_tensor

from tqdm import tqdm

import logging

logging.basicConfig(level=logging.INFO)

class Transformer:

'''

xs: tuple of

x: int32 tensor. (N, T1)

x_seqlens: int32 tensor. (N,)

sents1: str tensor. (N,)

ys: tuple of

decoder_input: int32 tensor. (N, T2)

y: int32 tensor. (N, T2)

y_seqlen: int32 tensor. (N, )

sents2: str tensor. (N,)

training: boolean.

'''

def __init__(self, hp):

self.hp = hp

self.token2idx, self.idx2token = load_vocab(hp.vocab)

self.embeddings = get_token_embeddings(self.hp.vocab_size, self.hp.d_model, zero_pad=True)

def encode(self, xs, training=True):

'''

Returns

memory: encoder outputs. (N, T1, d_model)

'''

with tf.variable_scope("encoder", reuse=tf.AUTO_REUSE):

x, seqlens, sents1 = xs

# src_masks

src_masks = tf.math.equal(x, 0) # (N, T1)

# embedding

enc = tf.nn.embedding_lookup(self.embeddings, x) # (N, T1, d_model)

enc *= self.hp.d_model**0.5 # scale

enc += positional_encoding(enc, self.hp.maxlen1)

enc = tf.layers.dropout(enc, self.hp.dropout_rate, training=training)

## Blocks

for i in range(self.hp.num_blocks):

with tf.variable_scope("num_blocks_{}".format(i), reuse=tf.AUTO_REUSE):

# self-attention

enc = multihead_attention(queries=enc,

keys=enc,

values=enc,

key_masks=src_masks,

num_heads=self.hp.num_heads,

dropout_rate=self.hp.dropout_rate,

training=training,

causality=False)

# feed forward

enc = ff(enc, num_units=[self.hp.d_ff, self.hp.d_model])

memory = enc

return memory, sents1, src_masks

def decode(self, ys, memory, src_masks, training=True):

'''

memory: encoder outputs. (N, T1, d_model)

src_masks: (N, T1)

Returns

logits: (N, T2, V). float32.

y_hat: (N, T2). int32

y: (N, T2). int32

sents2: (N,). string.

'''

with tf.variable_scope("decoder", reuse=tf.AUTO_REUSE):

decoder_inputs, y, seqlens, sents2 = ys

# tgt_masks

tgt_masks = tf.math.equal(decoder_inputs, 0) # (N, T2)

# embedding

dec = tf.nn.embedding_lookup(self.embeddings, decoder_inputs) # (N, T2, d_model)

dec *= self.hp.d_model ** 0.5 # scale

dec += positional_encoding(dec, self.hp.maxlen2)

dec = tf.layers.dropout(dec, self.hp.dropout_rate, training=training)

# Blocks

for i in range(self.hp.num_blocks):

with tf.variable_scope("num_blocks_{}".format(i), reuse=tf.AUTO_REUSE):

# Masked self-attention (Note that causality is True at this time)

dec = multihead_attention(queries=dec,

keys=dec,

values=dec,

key_masks=tgt_masks,

num_heads=self.hp.num_heads,

dropout_rate=self.hp.dropout_rate,

training=training,

causality=True,

scope="self_attention")

# Vanilla attention

dec = multihead_attention(queries=dec,

keys=memory,

values=memory,

key_masks=src_masks,

num_heads=self.hp.num_heads,

dropout_rate=self.hp.dropout_rate,

training=training,

causality=False,

scope="vanilla_attention")

### Feed Forward

dec = ff(dec, num_units=[self.hp.d_ff, self.hp.d_model])

# Final linear projection (embedding weights are shared)

weights = tf.transpose(self.embeddings) # (d_model, vocab_size)

logits = tf.einsum('ntd,dk->ntk', dec, weights) # (N, T2, vocab_size)

y_hat = tf.to_int32(tf.argmax(logits, axis=-1))

return logits, y_hat, y, sents2

def train(self, xs, ys):

'''

Returns

loss: scalar.

train_op: training operation

global_step: scalar.

summaries: training summary node

'''

# forward

memory, sents1, src_masks = self.encode(xs)

logits, preds, y, sents2 = self.decode(ys, memory, src_masks)

# train scheme

y_ = label_smoothing(tf.one_hot(y, depth=self.hp.vocab_size))

ce = tf.nn.softmax_cross_entropy_with_logits_v2(logits=logits, labels=y_)

nonpadding = tf.to_float(tf.not_equal(y, self.token2idx["<pad>"])) # 0: <pad>

loss = tf.reduce_sum(ce * nonpadding) / (tf.reduce_sum(nonpadding) + 1e-7)

global_step = tf.train.get_or_create_global_step()

lr = noam_scheme(self.hp.lr, global_step, self.hp.warmup_steps)

optimizer = tf.train.AdamOptimizer(lr)

train_op = optimizer.minimize(loss, global_step=global_step)

tf.summary.scalar('lr', lr)

tf.summary.scalar("loss", loss)

tf.summary.scalar("global_step", global_step)

summaries = tf.summary.merge_all()

return loss, train_op, global_step, summaries

def eval(self, xs, ys):

'''Predicts autoregressively

At inference, input ys is ignored.

Returns

y_hat: (N, T2)

'''

decoder_inputs, y, y_seqlen, sents2 = ys

decoder_inputs = tf.ones((tf.shape(xs[0])[0], 1), tf.int32) * self.token2idx["<s>"]

ys = (decoder_inputs, y, y_seqlen, sents2)

memory, sents1, src_masks = self.encode(xs, False)

logging.info("Inference graph is being built. Please be patient.")

for _ in tqdm(range(self.hp.maxlen2)):

logits, y_hat, y, sents2 = self.decode(ys, memory, src_masks, False)

if tf.reduce_sum(y_hat, 1) == self.token2idx["<pad>"]: break

_decoder_inputs = tf.concat((decoder_inputs, y_hat), 1)

ys = (_decoder_inputs, y, y_seqlen, sents2)

# monitor a random sample

n = tf.random_uniform((), 0, tf.shape(y_hat)[0]-1, tf.int32)

sent1 = sents1[n]

pred = convert_idx_to_token_tensor(y_hat[n], self.idx2token)

sent2 = sents2[n]

tf.summary.text("sent1", sent1)

tf.summary.text("pred", pred)

tf.summary.text("sent2", sent2)

summaries = tf.summary.merge_all()

return y_hat, summaries

73

73

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?