近日火爆科技圈,对决Open AI登顶海外App下载量第一的科技新秀Deepseek,引发媒体关注。在海内外一众大模型公司中为何脱颖而出,本博文展开深度解析。

DeepSeek-V3是由中国公司深度求索(DeepSeek)开发的一款先进的大规模语言模型。用户可以通过官方网站进行注册和使用,注册过程简单便捷,仅需手机号即可完成。DeepSeek-V3在训练效率、成本控制、评测表现以及高并发支持等方面展现了显著的优势,使其在与主流大模型的对比中脱颖而出。从训练效率来看,DeepSeek-V3拥有6710亿参数,相比Meta的Llama3(4050亿参数)提升了65%的参数量,这意味着模型具备了更强的表达能力和任务处理能力。然而,尽管参数量更大,DeepSeek-V3的训练时间却仅为2个月,比Llama3的54天缩短了11倍。同时,DeepSeek-V3仅需2048块H800GPU,而Llama3需要16384块H100GPU。足以见得,算法与模型的优化能够显著降低硬件成本,使得大规模的模型训练更加经济可行。

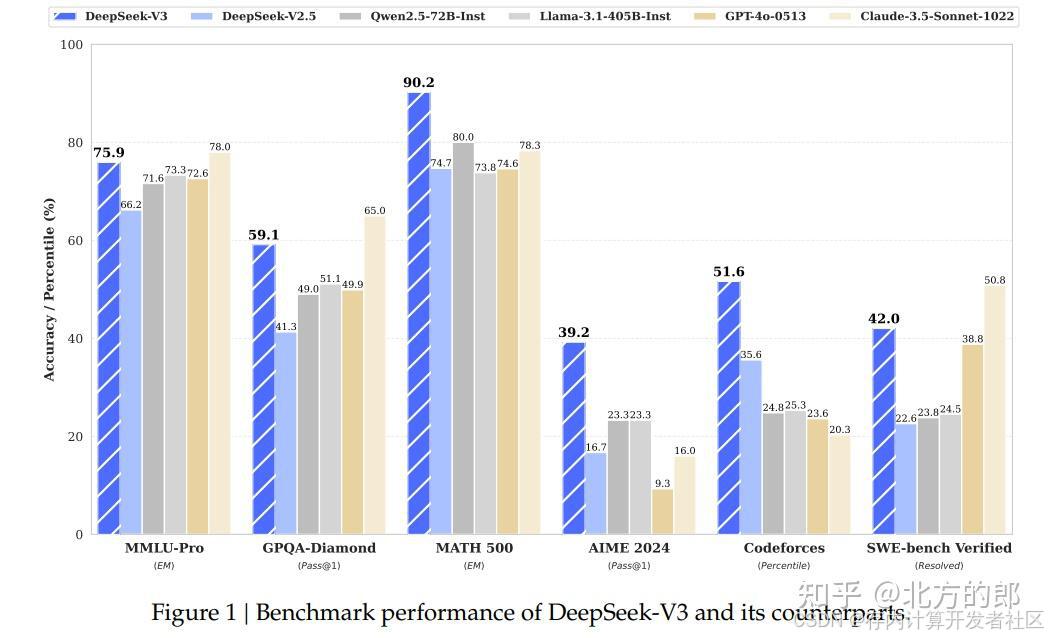

图1 DeepSeek-V3与竞品模型在多个基准测试中的性能对比图

DeepSeekV3不仅性能卓越,还在成本效益方大幅领先同类模型。根据定价信息,DeepSeekV3的输入费用仅为0.14美元/百万tokens(缓存未命中),缓存命中时更是低至0.014美元/百万tokens,输出费用也仅为0.28美元/百万tokens。相比之下,GPT-4o的输入费用高达2.5美元/百万tokens,输出费用更是10美元/百万tokens,成本差距显著。极低的调用成本使DeepSeekV3成为不少中国企业和开发者的理想选择,尤其是在预算有限的情况下实现高效且经济的AI解决方案,主打一手高性价比。

图2 DeepSeek-V3与主流大模型对比

DeepSeek V3的性价比优势迅速冲击了传统垄断结构。例如幻方量化部署MoE架构后,高频交易策略生成时延压缩至47ms,较原有系统提升6倍响应速度,这验证了专业场景的落地潜力。当单卡即可部署百亿参数模型时,中小开发者首次获得与科技巨头对等的能力起点。国内某云计算平台测试显示,基于V3架构的推理集群硬件投入降低65%,这可能改变行业对算力军备竞赛的路径依赖。中国的大模型市场已出现分化趋势:既有企业采用V3替代GPT-3.5-Turbo接口节省成本,也有初创公司基于开源模型构建垂类应用,这种多元化生态正在削弱头部厂商的垄断优势。

2022年10月,为阻止中国成为人工智能与计算领域的超级大国,美国对中国实施了广泛的芯片出口限制,但这只是中美之间持续进行的“芯片战争”中的众多打击之一。这些芯片限制的目的是想通过掐断中国获取顶尖硬件的渠道来限制中国在AI领域的发展。为应对新规,并维持在中国市场的竞争力,英伟达推出了针对中国市场的“定制版”H800芯片,其性能较H100大幅削弱,集群卡之间的互连速度被限制在约400GB/s,而H100可达 900GB/s。

图3 CNBC报道DeepSeek-V3

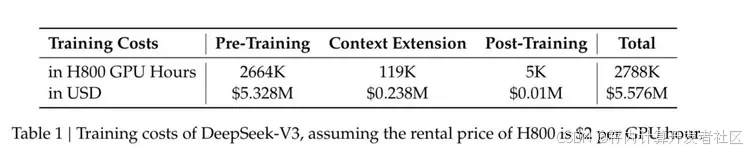

面对如此不利的硬件环境,DeepSeek的研发团队并未退缩。如图2所示,他们采用了由2048块Nvidia H800 GPU组成的集群,每块GPU通过NVLink互连实现GPU间通信,并通过InfiniBand互连实现节点间通信,总成本控制在550万美元左右,仅为GPT的1/20。这种丐版配置下,虽然GPU间通信速度还可以保证,但节点间通信很麻烦,因此DeepSeek实施了数十项优化技术以降低其训练的时间与功耗。

图4 DeepSeek-V3的训练开销

AI大模型Llama 3 405B需要在多达16k H100 GPU上训练3080万小时才能得到较满意的结果,而DeepSeek-V3仅需要在2048块 H800 GPU上训练不到280万小时就能达到与Llama并肩的性能,因此DeepSeek-V3相较于Llama 3 405B效率提升了11倍,如图4所示。

同时,DeepSeek V3的开源策略正在重塑中国大模型行业的生态格局,以对抗美国的施压。通过全系列模型开源(覆盖7B至340B参数),该团队构建了独特的开发者共创体系:在代码生成领域,某智能编程助手基于V3架构微调后,代码补全准确率提升12%,错误率下降至行业平均水平的1/3;教育行业已有教辅机构基于12B版本开发出解题准确率达92.3%的数学推理系统,服务超过200万学生。这种"基础模型开源+垂直场景订阅"的混合商业模式,成功吸引了30余家医疗设备厂商采用其定制化术语微调服务,证明开源生态与商业变现的兼容性。值得关注的是,其推理成本仅为GPT-3.5的17%,使得某县域级农商行仅用3台A100服务器便部署了完整的金融知识问答系统,突显对中小企业的友好性。

DeepSeek-V3训练降低成本主要靠三大招:压缩、并行和提升硬件使用效率。

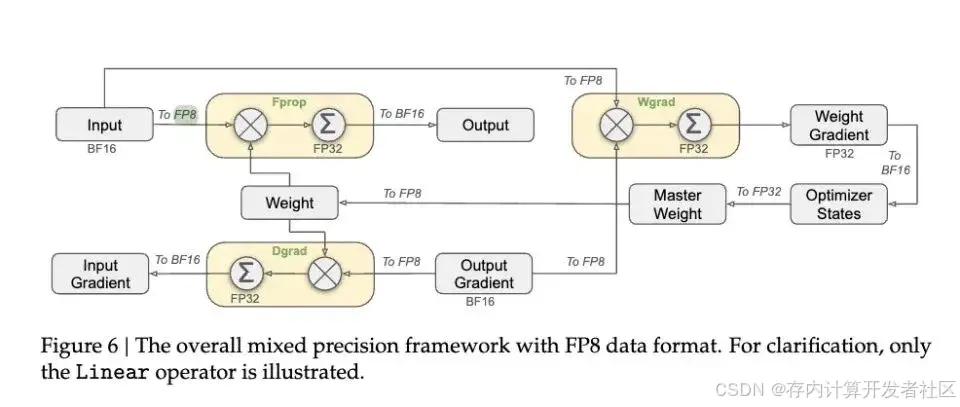

在压缩方面,DeepSeek-V3采用了“MLA多层注意力架构”和“FP8混合精度训练”。如图3所示,所谓MLA多层注意力架构即通过动态合并相邻层的key、value来减少计算量,通过这种方式训练内存占用减少了20%~30%。例如在图书检索系统中可以将“计算机技术,三楼右侧第二排”的书记为“C2-3”,而DeepSeek-V3就以这样的标签形式存储信息,若有需要时再从标签还原具体的信息。而FP8混合精度训练即大部分的前向运算都使用FP8来处理且每加128个数就把当前结果转移到科学计算器上继续计算,此外在一些重要的环节利用更精密的工具(FP32/FP64)来计算,通过这种方式使得模型训练速度大幅提升且模型最终的效果精度损失能做到小于0.25%,如图5所示。

图5 DeepSeek-V3的架构

图6 FP8混合精度训练的过程

在并行方面,DeepSeek-V3采用了“DualPipe跨节点通信”和“无辅助损失的负载均衡策略”。DualPipe跨节点通信引入了双重流水线的概念从而充分利用了原本的空闲时间,通过这种方式DualPipe算法减少了50%的计算气泡,有效隐藏了通信开销,跨节点通信优化则提升了带宽利用率,减少了20%的通信开销。而所谓的无辅助损失的负载均衡策略是让训练过程中工人各展所能的一个调整:当某个专家持续过载时,系统会自动降低其接收新任务的概率;反之,对于利用率低的专家,系统会提高其接收任务的机会。

此外,在架构方面DeepSeek-V3采用了MoE架构(Mixture of Experts)。MoE的核心理念可以这样理解:有一群各个领域的专家,共同协作解决问题。面对用户的任务,系统会智能地识别出最适合的专家来处理,通过稀疏激活机制大幅减少计算量。DeepSeek-V3采用多个小型专家的 MoE 结构,这也是模型总参数量虽高达6710亿,但运行时仅激活37B参数的原因。这种稀疏激活机制大大降低了计算量,使得模型在有限的硬件资源下,能够支持更大的规模,进而提升了训练效率。

传统的模型训练往往依赖大规模的硬件堆砌来提升性能,但 DeepSeek-V3 在硬件受限的情况下,另辟蹊径,通过软件创新实现了突破。团队实施了数十项优化技术,在数据处理和算法优化方面进行了深入探索。例如,在数据预处理阶段,通过优化数据筛选和增强策略,让模型能够更快地学习到关键信息;在算法设计上,不断调整模型的架构和训练参数,以适应有限的硬件资源。这些软件层面的创新,不仅弥补了硬件性能的不足,还推动了整个训练过程的高效进行。

从目前来看,DeepSeek-V3仍有很长的发展道路在技术层面,若国际巨头重启万卡级超大规模训练(如谷歌TPU v5集群),国内外的性能代差可能再度扩大,现有效率优势或被稀释。特朗普上台后,硬件制约将更为紧迫。美国芯片管制迫使DeepSeek与华为昇腾合作开发专用框架,虽在鹏城实验室测试中实现83%的硬件利用率,但性能仍落后主流GPU约30%。更隐蔽的风险在于数据污染——团队披露其多阶段蒸馏框架虽在数学任务提升8.7%鲁棒性,但面对ChatGPT生成数据的系统性偏差,模型纠错机制仍需完善。这些挑战揭示了一个残酷现实:在追求普惠化的道路上,技术创新必须与地缘政治、硬件迭代、数据质量等多重变量持续博弈。从更宏观的角度看,中美之间的算力竞争促使中国团队在软件层面积极寻求突破。DeepSeek-V3在训练成本、时间与核心技术方案上的创新与突破,为人工智能模型的发展提供了宝贵的经验。

905

905

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?