ps:机智流的github项目链接SmartFlowAI/Llama3-Tutorial: Llama3-Tutorial(XTuner、LMDeploy、OpenCompass) (github.com)

1. 环境配置与模型准备

1.1 环境配置

conda create -n llama3 python=3.10

conda activate llama3

conda install pytorch==2.1.2 torchvision==0.16.2 torchaudio==2.1.2 pytorch-cuda=12.1 -c pytorch -c nvidia安装 XTuner

cd ~

git clone -b v0.1.18 https://github.com/InternLM/XTuner

cd XTuner

pip install -e .[all]clone 本教程仓库

cd ~

git clone https://github.com/SmartFlowAI/Llama3-Tutorial1.2 模型准备

首先来准备 Llama3-8B-Instruct 模型权重

mkdir -p ~/model

cd ~/model

ln -s /root/share/new_models/meta-llama/Meta-Llama-3-8B-Instruct .2. Llama3 ReAct Demo

2.1 首先我们先来安装 lagent。

pip install lagent2.2 然后我们使用如下指令启动 Web Demo:

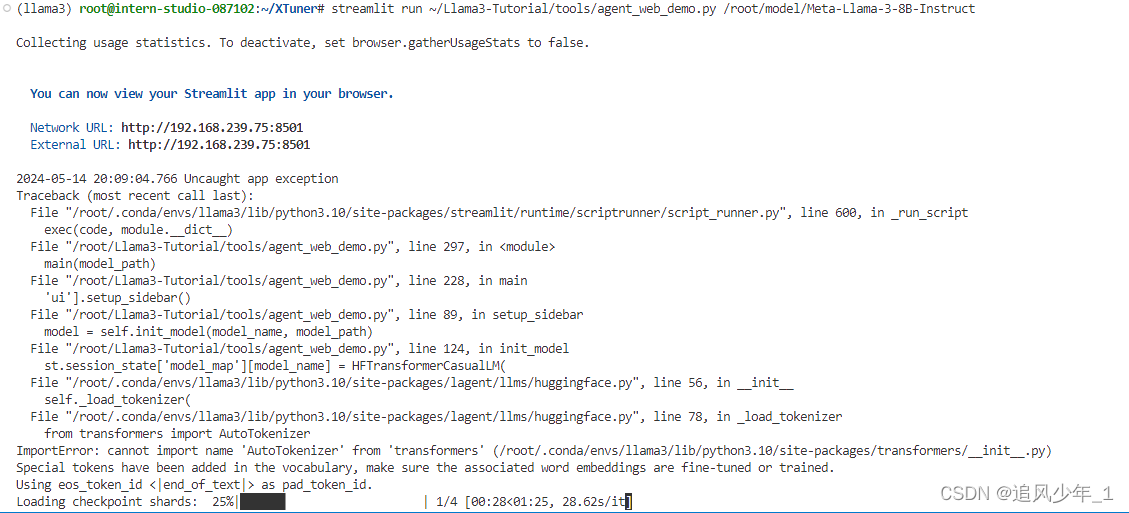

streamlit run ~/Llama3-Tutorial/tools/agent_web_demo.py /root/model/Meta-Llama-3-8B-Instruct直观体验一下 Llama3 模型在 ReAct 范式下的智能体能力。我们让它使用 ArxivSearch 工具来搜索 InternLM2 的技术报告。 从图中可以看到,Llama3-8B-Instruct 模型并没有成功调用工具。原因在于它输出了 query=InternLM2 Technical Report 而非 {'query': 'InternLM2 Technical Report'},这也就导致了 ReAct 在解析工具输入参数时发生错误,进而导致调用工具失败。

2.3 出现报错

2.4 这里 考虑重新 新建一个开发机进行连接

我们打开本机的终端,我们使用 powershell,但是要确保你的本机是由 OpenSSH 服务的。

配置 ssh 密钥一方面是方便我们登录,这样我们不用每次连接都需要输入密码,另一方面是为了我们端口映射的安全。 首先我们需要配置 ssh 密钥, 在powershell 中输入以下命令;

ssh-keygen -t rsa一路回车 即可生成 密钥

公钥默认存储在 ~/.ssh/id_rsa.pub,可以通过系统自带的 cat 工具查看文件内容:

cat ~/.ssh/id_rsa.pub查看生成的密钥

接着将这个密钥添加到InternStudio中

首先是配置SSH Key

添加后会自动识别

进行端口映射 将下面的命令复制到 powershell,

ssh -p 46549 root@ssh.intern-ai.org.cn -CNg -L 7860:127.0.0.1:7860 -o StrictHostKeyChecking=no

出现错误,发现是没有打开开发机与vscode进行连接

但是仍然报错,于是考虑在cmd中重新输入

ssh -p 48929 root@ssh.intern-ai.org.cn -CNg -L 6006:127.0.0.1:6006 -o StrictHostKeyChecking=no出现如下显示结果说明端口映射完成

2.5 修改后结果

发现是10%的A100,出现了OOM,修改为30%

3. 微调

3.1 数据集准备

由于 HuggingFace 上的 Agent-FLAN 数据集暂时无法被 XTuner 直接加载,因此我们首先要下载到本地,然后转换成 XTuner 直接可用的格式。

cd ~

cp -r /root/share/new_models/internlm/Agent-FLAN .

chmod -R 755 Agent-FLAN3.2 微调启动

已经准备好了可以一键启动的配置文件,主要是修改好了模型路径、对话模板以及数据路径。

使用如下指令以启动训练:

export MKL_SERVICE_FORCE_INTEL=1

xtuner train ~/Llama3-Tutorial/configs/llama3-agentflan/llama3_8b_instruct_qlora_agentflan_3e.py --work-dir ~/llama3_agent_pth --deepspeed deepspeed_zero2训练时间过久,需要 快2天

在训练完成后,我们将权重转换为 HuggingFace 格式,并合并到原权重中。

# 转换权重

xtuner convert pth_to_hf ~/Llama3-Tutorial/configs/llama3-agentflan/llama3_8b_instruct_qlora_agentflan_3e.py \

~/llama3_agent_pth/iter_18516.pth \

~/llama3_agent_pth/iter_18516_hf由于训练时间太长,我们也为大家准备好了已经训练好且转换为 HuggingFace 格式的权重,可以直接使用。路径位于 /share/new_models/agent-flan/iter_2316_hf。

如果要使用自己训练的权重,可以使用如下指令合并权重:

# 合并权重

export MKL_SERVICE_FORCE_INTEL=1

xtuner convert merge /root/model/Meta-Llama-3-8B-Instruct \

~/llama3_agent_pth/iter_18516_hf \

~/llama3_agent_pth/merged如果要使用已经训练好的权重,可以使用如下指令合并权重:

export MKL_SERVICE_FORCE_INTEL=1

xtuner convert merge /root/model/Meta-Llama-3-8B-Instruct \

/share/new_models/agent-flan/iter_2316_hf \

~/llama3_agent_pth/merged4. Llama3+Agent-FLAN ReAct Demo

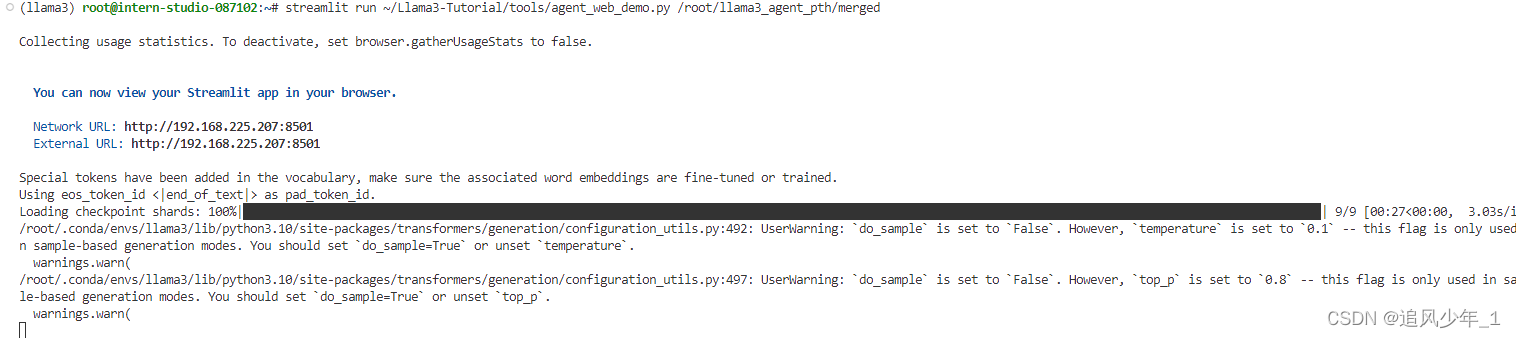

在合并权重后,我们再次使用 Web Demo 体验一下它的智能体能力吧~

使用如下指令启动 Web Demo:

streamlit run ~/Llama3-Tutorial/tools/agent_web_demo.py /root/llama3_agent_pth/merged可以看到,经过 Agent-FLAN 数据集的微调后,Llama3-8B-Instruct 模型已经可以成功地调用工具了,其智能体能力有了很大的提升。

898

898

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?