目录

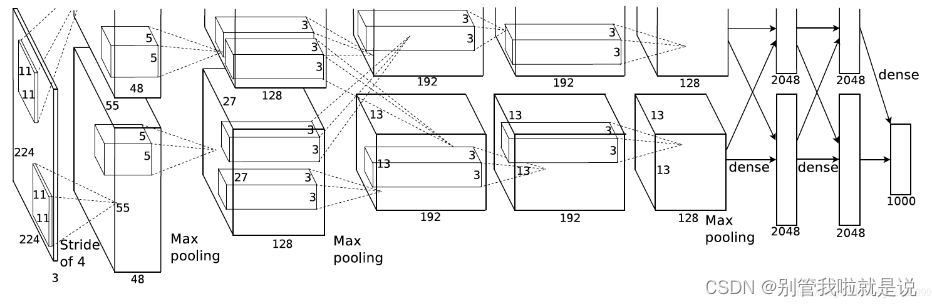

AlexNet网络包括8层(不含输入层);前五层为卷积层,后三层为全连接层

1.输入层

输入层大小为227x227x3

2.C1层——卷积层

处理流程:卷积→ReLu→池化→归一化

(1)卷积:

输入:227x227

卷积核:96个11x11x3 padding=0,stride=4

输出特征图:55x55x96

(227-11)/4+1

(2)ReLu

(3)池化:使用3x3步长为2的池化单元(重叠池化,步长小于池化单元的宽度)。输出为27x27x96((55-3)/2+1)

(4)归一化:局部归一化,输出的仍为27x27x96,输出分为两组,每组的大小为27x27x48

3.C2层——卷积层

处理流程:卷积→ReLu→池化→归一化

(1)卷积:

输入:2组27x27x48,

卷积核:每组128个5x5x48的卷积核,padding=2,stride=1

输出:2组27x27x128((27-5+2x2)/1+1)

(2)ReLu

(3)池化:使用3x3步长为2的池化单元(重叠池化,步长小于池化单元的宽度)。输出为13x13x256((27-3)/2+1)

(4)归一化:局部归一化

4.C3层——卷积层

处理流程:卷积→ReLu

(1)卷积:

输入:13x13x256

卷积核:2组384个3x3x256的卷积核,padding=1,stride=1

输出:13x13x384((13-3+2x1)/1+1)

(2)ReLu

5.C4层——卷积层

处理流程:卷积→ReLu

(1)卷积:

输入:13x13x384,分为两组,每组13x13x192

卷积核:2组192个3x3x192的卷积核,padding=1,stride=1

输出:13x13x384((13-3+2x1)/1+1),分为两组,每组13x13x192

(2)ReLu

6.C5层——卷积层

处理流程:卷积→ReLu→池化

(1)卷积:

输入:13x13x384,分为两组,每组13x13x192

卷积核:2组128个3x3x192的卷积核,padding=1,stride=1

输出:13x13x256((13-3+2x1)/1+1)

(2)ReLu

(3)池化:使用3x3步长为2的池化单元(重叠池化,步长小于池化单元的宽度)。输出为6x6x256((13-3)/2+1)

7.F1层——全连接层

处理流程:全连接→ReLu→Dropout

(1)全连接:

输入:6x6x256

卷积核:2组4096个6x6x256的卷积核,padding=0,stride=1

由于卷积核尺寸刚好与输入尺寸相同,即卷积核中的每个系数只与特征图(输入)尺寸的一个像素值相乘,一一对应,因此,该层被称为全连接层

输出:1x1x4096((6-6)/1+1)

(2)ReLu

(3)Dropout:抑制过拟合,随机地断开某些神经元的连接或者是不激活某些神经元

8.F2层——全连接层

处理流程:全连接→ReLu→Dropout

(1)全连接:

输入:4096个向量

(2)ReLu

(3)Dropout:抑制过拟合

9.输出层

F2层输出的4096个数据与输出层1000个神经元进行全连接,经过训练后输出1000个float型的值,即预测结果

201

201

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?