2024年06月17日至21日,计算机视觉与模式识别国际顶级学术会议CVPR 2024在美国华盛顿州西雅图市举行。CVPR(IEEE Conference on Computer Vision and Pattern Recognition)会议由IEEE举办,是CCF推荐A类会议,Core Ranking A*类会议。在2024年谷歌学术国际最新学术期刊和会议影响力排名中,CVPR蝉联第四,仅次于自然科学顶刊Nature、Science,和NEJM。收录的论文代表了计算机视觉和模式识别领域的最新发展方向和最高研究水平,入选标准严苛。据统计,今年共提交了 11532 份论文,2719 篇被接收,录用率为 23.6%。

半监督是用少量有监督样本和大量无监督样本 正确时产生正反馈,错误时产生负反馈,从而预测。

meanteacher

剪枝:噪声用来防止过拟合 dropout:神经网络防止过拟合 softmax归一化函数压缩到0-1之间 独热标签。

Mean Teacher 模型是一种半监督学习方法,旨在提高深度学习模型在有限标注数据下的表现。 它最初是由 Antoine Romero 等人在 2018 年提出的。 Mean Teacher 模型通过结合教师网络和学生网络的思想来提升模型的泛化能力。 以下是对 Mean Teacher 模型的详细解释:

基本概念

-

学生网络和教师网络 :

- 学生网络 是主要进行训练的模型,通过标注和未标注的数据进行学习。

- 教师网络 是学生网络的一个移动平均版本,随着训练的进行,教师网络会逐渐更新,反映学生网络的参数。因为在MT模型的训练过程中,Mean Teacher 首先对学生模型进行训练,并利用梯度下降法更新其模型参数,其次计算学生模型参数的指数移动平均值,并将计算结果更新为教师模型的参数。由于教师模型是连续若干训练step产生的学生模型的平均值,我们称之为平均教师方法。

-

半监督学习 :

- 在半监督学习中,通常会有少量标注数据和大量未标注数据。 Mean Teacher 模型旨在利用这些未标注数据,通过预测和生成伪标签来提高学习效果。

-

知识蒸馏,参数的作用(Knowledge Distillation)

- 是学生-教师模型的核心思想。在蒸馏过程中,教师网络将其所学的知识通过输出软标签传递给学生网络,学生网络的目标就是调整自己的参数,使得它的输出分布与教师网络尽量接近。这种方式比直接训练学生网络来得更加高效,因为教师网络的软标签包含了更多的信息(如类间关系)而不仅仅是硬标签(单一的类别标签)。

- 学生网络的参数通过优化上述损失来逐渐吸收教师网络的知识,从而提高其性能。

训练过程

-

初始化 :

- 初始值的选择:通常,学生模型的初始参数可能会设置为随机值,也可以设定为教师模型的初始参数。如果学生模型的初始值较好,EMA 更新的速度会更快

-

前向传播 :

- 对于每一个批次,学生网络将处理标注数据和未标注数据。

- 教师网络将使用学生网络的参数更新,通常采用指数移动平均(EMA)来更新。

- 在本文中平滑因子为0.5

-

损失函数 :

- 标注数据的损失 :使用标准的损失函数(如交叉熵损失)计算学生网络在标注数据上的预测误差。

- 未标注数据的损失 :通过学生网络和教师网络的输出之间的差异来计算,通常使用一致性损失(如均方误差或交叉熵损失)来确保学生网络的预测与教师网络的输出一致。

-

参数更新 :

- 根据标注数据的损失和未标注数据的损失共同更新学生网络的参数。

- 教师网络的参数则通过对学生网络参数的移动平均进行更新。

-

在学生-教师模型(Student-Teacher model)中,教师模型(通常是一个较大的、预训练过的模型)和学生模型(一个较小的模型)通过知识蒸馏(Knowledge Distillation)进行训练。这里的“教师”是一个已经训练好且性能优越的模型,通常拥有较高的计算能力,而“学生”则是一个计算资源较为有限、结构较为简洁的模型,学生模型的目标是通过从教师模型中“学习”来达到接近教师性能的表现。

参数的改变对标签的影响

在学生-教师模型中,通常存在两种主要的标签类型:硬标签(Hard labels)和软标签(Soft labels)。每个标签都能在不同程度上影响学生模型的学习过程,下面我们来具体讨论参数改变对标签的影响。

1. 硬标签与软标签

-

硬标签是标准的目标标签,通常来自于训练数据集。例如,在分类任务中,硬标签是一个离散的类别标签(如 0 或 1)。

-

软标签是教师模型生成的连续值(通常是教师模型的输出概率分布),通过对教师模型的输出进行软化,学生可以从中获得更多的信息。例如,教师模型输出的不是硬性的类别标签,而是一个经过温度(temperature)处理后的概率分布。软标签包含了类别之间的相对概率信息,学生通过模仿这些概率分布来进行训练。

-

2. 教师模型参数的改变对标签的影响

-

教师模型的性能和输出的稳定性:教师模型的参数变化直接影响其对每个输入样本的预测结果(软标签)。如果教师模型的参数发生变化,可能会影响其输出的概率分布。教师模型通常是通过反向传播不断优化参数,以生成更准确的预测结果。当教师模型的参数调整(例如更新了训练数据、改进了优化算法等),它生成的软标签会有所变化。这意味着学生模型会接收到不同的软标签,这可能导致学生学习到不同的表示。

-

温度参数(Temperature)对软标签的影响:在知识蒸馏过程中,通常会使用一个温度参数来调整教师模型输出的概率分布。温度越高,输出的概率分布越平滑,学生模型能够从中学到更多类别间的相对信息;温度越低,分布越尖锐,类别间的区别更加明显。如果改变教师模型的温度参数,可能会导致软标签的变化,从而影响学生模型学习的内容。

-

教师模型的过拟合与泛化能力:如果教师模型的参数过拟合,输出的软标签可能会变得过于确定,并且可能失去一定的泛化能力。学生模型在这种情况下,虽然可能能够更准确地模仿教师模型的预测,但也可能会继承教师模型的过拟合现象,从而影响其在新样本上的表现。因此,教师模型的参数变化,特别是与过拟合有关的变化,会影响学生模型的学习效果。

-

3. 学生模型参数的改变对标签的影响

-

学生模型的参数更新:在知识蒸馏的训练过程中,学生模型的参数会被调整,以便更好地模仿教师模型的软标签。学生模型的学习目标通常是最小化与教师模型输出的软标签之间的差异。如果学生模型的参数发生变化(例如,更新了权重或者修改了网络结构),它的输出也会发生变化,这可能导致学生模型对标签的理解发生偏移。

-

学生的过拟合与泛化:类似于教师模型,如果学生模型的参数过拟合,学生在学习过程中可能会过于依赖教师模型的软标签,而忽视了数据本身的固有结构。这种情况下,学生的输出标签可能会变得过于局限,无法很好地泛化到新的数据。

-

4. 标签的变化对训练过程的影响

-

软标签的平滑性:软标签比硬标签包含更多信息,特别是类别之间的相似度。通过模仿教师模型的软标签,学生模型能够学习到更丰富的特征表示。如果教师模型的参数发生变化,可能会导致标签变得更平滑或更尖锐,从而影响学生模型的训练过程。例如,如果教师模型的软标签变得更加平滑,学生模型可能会学习到更多的类间关系,从而提升其泛化能力。

-

标签分布的变化:如果教师模型的输出标签分布发生了显著的变化,可能会影响学生模型的训练难度。如果软标签的分布更加复杂或不确定,学生模型的训练可能会变得更加困难,可能需要更多的训练时间或更多的正则化策略来有效学习。

-

总结

在学生-教师模型中,教师模型的参数变化直接影响其输出的软标签,这些标签对学生模型的训练有重要影响。教师模型输出的软标签不仅决定了学生模型学习的内容,还可能影响学生的泛化能力和性能。而学生模型的参数更新则决定了它如何更好地学习并模仿教师模型的标签,进而影响其最终的表现。

- 增强的泛化能力 :通过引入教师网络,模型能够更好地利用未标注数据,从而提高对新样本的泛化能力。

- 稳定性 :教师网络的移动平均更新使得训练过程更加稳定,减少了模型的波动性。

应用领域

Mean Teacher 模型被广泛应用于图像分类、语义分割等任务,尤其在那些标注数据稀缺的情况下,能够有效提升模型性能。

总结

Mean Teacher 模型通过结合教师和学生网络的思想,为半监督学习提供了一种有效的方法,特别是在面对有限标注数据时,能够显著提高模型的学习能力和泛化能力。 这一模型的设计思想在深度学习领域引起了广泛的关注,并在后续的研究中被进一步扩展和应用。

method

在构建神经网络的时候,有时候我们并不想计算某个节点的梯度,在mxnet的symbol模块中提供了一个stop_gradient方法可以设置不计算某个NDArray的梯度,此时如果对设置的NDArray计算梯度时,会返回0。

在机器学习和统计学中, 标记和未标记特征的经验分布 (Empirical Distribution of Labeled and Unlabeled Features)通常涉及对不同类型数据的处理和分析,尤其是在监督学习(labeled data)和无监督学习(unlabeled data)中的应用。以下是关于这个概念的详细解释。

经验分布

1. 标记数据(Labeled Data) :

标记数据是指每个样本都附有标签或目标值(例如分类任务中的类别标签或回归任务中的数值标签)。 在这种数据中,我们可以根据标签来进行监督学习。

-

标记数据的经验分布 :标记数据的经验分布是指基于现有样本数据估算的目标变量(标签)分布。 在分类任务中,我们可能会关心每个类别的频率; 而在回归任务中,我们可能会关心标签的数值分布。 经验分布通常通过计算每个类别或目标值出现的频率来估算。

例如,假设我们有如下的分类任务数据:

标签 = { 0 , 1 , 1 , 0 , 2 , 1 }

那么标签的经验分布可以通过计算每个标签的频率来表示,例如类别

0出现2次,类别1出现3次,类别2出现1次。

2. 未标记数据(Unlabeled Data) :

未标记数据是指没有目标变量或标签的数据。 未标记数据在半监督学习(semi-supervised learning)中有重要应用,在这种学习框架下,通常会结合少量标记数据和大量未标记数据来训练模型。

-

未标记数据的经验分布 :对于未标记数据,我们通常关注特征变量(即输入特征)的分布。 例如,在特征空间中,未标记数据的经验分布可以表示各个特征值的出现频率或概率分布。

假设我们有一个二维数据集,其中每个样本有两个特征(例如

X1和X2)。 对于未标记数据,我们可能会计算特征X1和X2在样本中的频率分布,表示为直方图或核密度估计。

3. 标记和未标记特征的经验分布差异 :

在很多实际任务中,标记数据和未标记数据可能具有不同的分布,尤其是在分布偏移(distribution shift)或标签偏差(label bias)存在的情况下。 对这两种数据的经验分布进行比较和分析,可以帮助我们理解数据的特征,并为模型设计提供指导。

-

监督学习中的标记数据分布 :在监督学习中,模型的训练通常基于标记数据的分布。 因此,标记数据的经验分布(即特征和标签的联合分布)对模型训练和预测非常重要。

-

半监督学习中的未标记数据分布 :在半监督学习中,虽然未标记数据没有标签,但它们的特征分布仍然对模型学习有帮助。 我们可以通过未标记数据推测出特征空间中的结构信息,辅助模型更好地泛化。

4. 经验分布的应用 :

-

模型的估计 :经验分布可以用于估计数据的真实分布,帮助我们进行假设检验或参数估计。 例如,基于标记数据的经验分布,我们可以训练一个分类器; 而基于未标记数据的经验分布,可以通过无监督学习方法来发现数据的潜在结构。

-

处理数据不平衡 :在某些任务中,标记数据的类别分布可能不均衡,这时候可以使用未标记数据的分布信息来辅助处理数据不平衡问题。 通过不同的策略,如重采样或生成对抗网络(GAN)等方法,可以缓解这种不平衡问题。

总结:

标记和未标记特征的经验分布是指在监督学习和无监督学习中,通过样本数据估算得到的分布。 这些分布帮助我们理解数据的整体特性,支持不同学习任务的模型训练和推断。 尤其在半监督学习和处理数据不平衡时,未标记数据的经验分布往往与标记数据的分布密切相关,并且对提升模型

cutmix具体工作

随机梯度下降

(Stochastic Gradient Descent,SGD)是一种优化算法,常用于训练机器学习模型,尤其是神经网络。 它通过在每次迭代中随机选择一个样本来更新模型参数,从而在整个数据集上找到损失函数的最小值。

基本原理

-

梯度下降的概念 :梯度下降是一种通过计算损失函数相对于模型参数的梯度,来更新参数以减小损失的优化方法。 通常,计算梯度时会使用整个训练数据集,这种方法称为批量梯度下降(Batch Gradient Descent)。

- 计算梯度:SGD通过反向传播算法计算每个参数对损失函数的梯度,即每个参数如何影响误差。

- 更新参数:在每次迭代时,SGD根据计算出的梯度对参数进行更新。与批量梯度下降(使用整个数据集计算梯度)不同,SGD每次使用一个样本来计算和更新参数,从而减少计算量。

-

随机梯度下降 :SGD 与批量梯度下降的不同之处在于它在每次更新时仅使用一个样本(或少量样本)。 这种方法的优点包括:

- 速度快 :每次迭代的计算量小,更新频繁。

- 更好的收敛性 :随机性帮助算法跳出局部最优解。

公式

优缺点

优点 :

- 高效性 :每次更新使用一个样本,计算速度快。

- 适应性 :能够更好地应对大规模数据集和在线学习任务。

缺点 :

- 噪声大 :单个样本的随机性可能导致损失函数震荡,收敛不稳定。

- 学习率选择 :学习率的选择至关重要,过大可能导致发散,过小则收敛慢。

改进方法

为了解决 SGD 的一些缺点,出现了多种改进方法,如:

α=2N+1

这里的 NN 是所选定的周期数(窗口大小)。较小的 NN 值会使得 EMA 对最新数据更敏感,而较大的 NN 则使 EMA 更加平滑。

- 动量(Momentum) :在更新中引入之前的更新方向,使收敛更平滑。

- Adam(Adaptive Moment Estimation): 结合了动量和自适应学习率的方法,表现优异。

-

总结

随机梯度下降是一种高效的优化算法,尤其适用于大规模和在线学习的场景。 虽然其在收敛性和稳定性上存在一些挑战,但通过适当的改进方法,可以有效提升性能。

-

groundtruth

- 有标签数据在教师网络形成的强监督信号

-

EMA

- (Exponential Moving Average,指数移动平均)是一种用于平滑时间序列数据的统计分析方法,广泛应用于金融市场分析、信号处理和机器学习等领域。EMA 相比于简单移动平均(SMA)更敏感于最近的数据点,因此能够更快速地反映数据的变化趋势。

-

EMA的计算方法

EMA的计算公式为:

EMAt=α⋅xt+(1−α)⋅EMAt−1

其中:

- EMAt 是当前时刻 t 的指数移动平均值。

- xt 是当前时刻的实际观察值。

- EMAt−1 是前一个时刻的EMA值。

- α 是平滑因子,计算公式为:

元素数乘

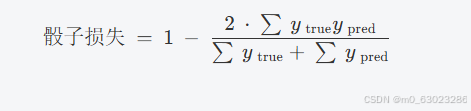

Dice loss

骰子损失是涉及图像分割的任务中常用的损失函数,尤其是在医学成像中。它基于 Dice coefficient(骰子系数),该系数是两个样本之间重叠的度量。骰子系数的范围是 0 到 1,其中 1 表示完全重叠,0 表示没有重叠。

公式

骰子系数的计算公式为:

Dice=2∣X∩Y∣∣X∣+∣Y∣

哪里:

- ∣X∣ 是集合中的元素数 X(预测的分割)。

- ∣Y∣是集合中的元素数 Y(地面实况分割)。

- ∣X∩Y∣ 是两个集合共有的元素数。

为了在损失函数中使用它,Dice 损失定义为:

Dice Loss=1−Dice Coefficient

此公式可确保在 Dice 系数最大化时损失最小。

特性和优势

-

对类不平衡的敏感性 :骰子丢失在类不平衡的场景中特别有用(例如,感兴趣区域与背景相比较小的医学图像)。在这些情况下,二进制交叉熵等传统损失函数可能表现不佳。

-

可微性 : Dice 损失是可微的,这使得它可以有效地用于基于梯度的优化算法。

-

关注重叠 :它直接关注预测区域和真实区域之间的重叠,使其对分割任务有效。

实现

以下是使用 TensorFlow/Keras 在 Python 中的简单实现:

import tensorflow as tf

def dice_loss(y_true, y_pred, smooth=1e-6):

y_true_f = tf.flatten(y_true)

y_pred_f = tf.flatten(y_pred)

intersection = tf.reduce_sum(y_true_f * y_pred_f)

return 1 - (2. * intersection + smooth) / (tf.reduce_sum(y_true_f) + tf.reduce_sum(y_pred_f) + smooth)应用

骰子损失广泛用于:

- 医学图像分割(例如,肿瘤分割)。

- 计算机视觉中的语义分割任务。

- 精确边界检测至关重要的任何场景。

3. 生成监控信号:

2. 最终伪标签Y u的获得

-

交叉熵损失

-

是分类任务中广泛使用的损失函数。对于二元或多类分类,交叉熵损失衡量基本事实和预测概率之间的差异:

对于二进制分类,交叉熵损失为:

-

-

对于多类分类,交叉熵损失概括为:

- N 是类的数量, ytrue,i 是类的真值概率 i和 ypred,,i ,i 是类的预测概率

- 当您想要优化像素分类精度(通过交叉熵)和结构相似性(通过 Dice 损失)时,Dice 损失和交叉熵损失的线性组合非常有用。通常,这个组合损失函数如下所示:

λ1和 λ2 是控制每个损失项的相对权重的超参数

在本文中θs就是两个函数算出的损失值

评分标准

DICE评分

(DICE Coefficient) 是一种用于衡量两个集合相似度的指标,通常用于自然语言处理、计算机视觉等领域,尤其在文本匹配、语义分割、图像处理等任务中应用广泛。DICE系数是一种基于集合交集的相似度度量,它的计算方式与 Jaccard系数 类似,但略有不同。

DICE系数的值范围是0到1,值越大表示两个集合越相似,值越小则表示它们越不相似

医学影像中,DICE系数可以用来量化自动分割的区域与手工标注的区域之间的重叠程度。

Jaccard评分(Jaccard Index)

也称为 Jaccard相似系数,是一种用来衡量两个集合相似度的指标。它通常用于计算两个集合的交集与并集的比率,反映了它们之间的相似度。

对于两个集合 AA 和 BB,Jaccard系数的计算公式为:

区别

与 DICE系数 比较,Jaccard系数只计算交集与并集的比率,而DICE系数则是交集与集合大小总和的两倍比率,Jaccard系数比DICE系数的计算方式更为保守(即它的值通常较小)。Jaccard系数更适用于关注集合的“覆盖度”比率的场景,而DICE系数则在重视交集部分重要性的情况下,尤其是在图像处理领域中应用更广泛。

Hausdorff 距离

(或称为 Hausdorff 距离度量)是度量空间中用于测量两个集合之间“远近”程度的一种方式,通常用于度量集合之间的相似性。

Hausdorff 距离提供了一种有效的方法来比较两个集合的相似性,尤其适用于集合间的几何对比和匹配。它不仅能够衡量集合的“形状”差异,还能处理复杂的拓扑结构。在实际应用中,Hausdorff 距离常常被用来衡量两个物体或图像的相似度,或者评估模型与实际数据之间的差异。

平均表面距离 (ASD, Average Surface Distance)

是一种常用于医学图像处理、计算机视觉和图像分割评估的度量方法。它主要用于衡量两个表面之间的相似性,特别是在医学图像中评估分割算法的准确性时,ASD被广泛使用。

医学图像分割:例如,在CT或MRI图像中,ASD可以用来评估肿瘤、器官或其他解剖结构的分割准确性。

区别

- Hausdorff距离计算的是两个表面之间的最大距离,它关注最远点对之间的差异,可能对噪声较为敏感。

- 平均距离误差则是简单的表面距离平均,但它有时可能不如ASD能够揭示出全局形状差异。

-

核密度估计 (KDE)

- 是一种非参数方法,用于根据有限数据样本估计随机变量的概率密度函数 (PDF)。它广泛用于统计和机器学习,用于了解数据分布、平滑和异常值检测。

- KDE 的工作原理是在每个数据点上放置一个平滑、连续的核函数(通常是高斯函数),然后将这些函数相加以创建总体概率密度函数的估计值。其思路是用反映数据基本分布的平滑曲线来近似数据的真实分布。

-

消融研究

- 是一种研究方法,用于了解系统中不同组件或策略的贡献,通常在机器学习、深度学习或其他计算方法的背景下进行。在插 值策略 的情况下,消融研究通常涉及测试不同的插值方法,以评估它们对模型性能的个别影响。

- 插值策略是用于估计连续域中两个已知数据点之间的值的技术。在机器学习中,它们通常应用于数据增强、图像处理等任务,甚至在模型架构中(例如注意力机制或卷积网络中的上采样)。

- β消融实验”( β消融研究)通常是指机器学习或科学研究中的一种技术,其中系统地删除或更改特定组件或变量,例如 β(超参数或模型的特定部分),以评估它们对系统整体性能的影响。在 消融研究中 ,研究人员旨在通过测试系统在有和没有因素时的表现来了解不同因素的重要性。

-

概率图与未标记图像

- 在这种背景下, 未标记的图像 XupX u p 和 XuqXuq 作为输入,分别传入Teacher网络,得到概率图。概率图即网络对每个类别的预测概率分布。

- 对于每张输入图像,Teacher网络不仅给出一个确定的标签(如猫或狗),而是给出一个概率分布,它表示该图像属于每个类别的概率。这种信息比硬标签更为丰富,因为它包含了网络对不同类别的“不确定性”。

- 这种概率图可以帮助学生网络在训练时不仅仅关注最终的预测标签,还能学习到类别之间的相对关系、类别之间的相似性等更细致的信息。

- 监控信号(monitoring signal)通常是指用于监督训练过程的一种信号,它可以引导网络学习的方向,特别是在没有标签的情况下。生成监控信号的一个常见方式是通过教师网络生成的伪标签,这些标签并非是手工标注的,而是通过教师网络对未标记数据的预测生成的概率分布。该分布反映了教师网络的信心以及对于不同类别的预期。

- 这些概率图作为监控信号,会被传递到学生网络,从而帮助学生网络在没有标签的情况下进行训练。 通过这种方式,即使没有明确的标注数据,学生网络也可以有效地学习和优化自己的参数。

-

4. 为什么要这样做 :

- 增强模型的泛化能力 :未标记数据中的信息可以帮助模型更好地泛化到新的、未见过的数据。 Teacher网络提供的软标签(概率分布)能够让学生网络捕捉到更多的特征和类别间的细微差异,而不仅仅是从硬标签中学习。

- 提升半监督学习性能 :在许多实际任务中,标注数据非常稀缺且昂贵,而未标记数据却较为丰富。 通过让学生网络学习来自Teacher网络的概率图,可以有效地利用未标记数据,从而提高模型的性能。

- 引导学习过程 :通过将Teacher网络的输出作为学生网络的训练信号,教师网络为学生网络提供了学习方向,帮助学生网络更好地收敛,尤其在标签稀缺的情况下,避免学生网络陷入过拟合。

-

1. 初始伪标签Pu的生成

-

二进制分割任务: 在二进制图像分割任务中,模型需要将每个像素分类为两种类别之一(例如,前景和背景)。 伪标签

Pu是通过对未标记图像的预测进行阈值处理来生成的。 这里提到的 公共阈值0.5 意味着如果模型预测的概率值大于0.5,则该像素被标记为前景类;如果小于0.5,则标记为背景类。 这是基于一个常见的阈值方法,将连续的预测概率值转化为二进制标签。 -

多类分割任务: 对于多类图像分割任务,每个像素可能属于多个类别中的一种。 在这种情况下,伪标签

Pu是通过 argmax操作 生成的,即选择每个像素预测概率最大的类别作为其标签。 -

初始的伪标签

Pu可能包含一些噪声,特别是一些错误的标签或离群点(即与周围像素明显不同的区域)。 为了去除这些离群像素,可以采用 最大连通分量 方法。 这意味着,最终的伪标签Y u是通过选择图像中最大连通区域的标签来获得的,从而去除那些孤立或错误分类的像素。例如,如果某个物体的像素分布中有一些非常小的区域被错误标记为前景类(可能是噪声),最大连通分量的方法会去除这些孤立的像素,只保留与物体其他部分相连的像素,形成一个连通区域。最大连通分量法的核心思路是,图像中的标签应该遵循空间上的连贯性,即相同类别的像素应该在空间上是连通的,而孤立的像素很可能是标注错误的噪声。 通过最大连通分量法,可以找到图像中最大、最为连贯的区域,并将这些区域保留下来,作为最终的伪标签。 这种方法通常会丢弃那些孤立或小范围的错误标签,因为它们通常不构成一个大的连通区域。

总结

骰子损失是分割任务的可靠选择,尤其是在处理不平衡的数据集时。通过关注预测段和真实段之间的重叠,它为优化提供了有意义的梯度,从而在许多应用程序中获得更好的性能。

753

753

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?