2024/3/15

1,概念解释:通义千问,是阿里云推出的一个超大规模的语言模型,功能包括多轮对话、文案创作、逻辑推理、多模态理解、多语言支持。能够跟人类进行多轮的交互,也融入了多模态的知识理解,且有文案创作能力,能够续写小说,编写邮件等。

2,多模态大模型:多模态大模型是一种基于深度学习的机器学习技术,其核心思想是将不同媒体数据(如文本、图像、音频和视频等)进行融合,通过学习不同模态之间的关联,实现更加智能化的信息处理。多模态大模型的优点在于能够充分利用不同媒体数据的信息,提取出更加丰富、全面的特征,从而提高模型的性能和泛化能力。

3,XrayGLM,首个会看胸部X光片的中文多模态医学大模型,基于visualGLM-6B在X光诊断数据集上微调的X光诊断问答的项目。其在医学影像诊断和多轮交互对话上显示出了非凡的潜力。

该项目为促进中文领域医学多模态大模型的研究发展,发布了XrayGLM数据集及模型,其在医学影像诊断和多轮交互对话上显示出了非凡的潜力。

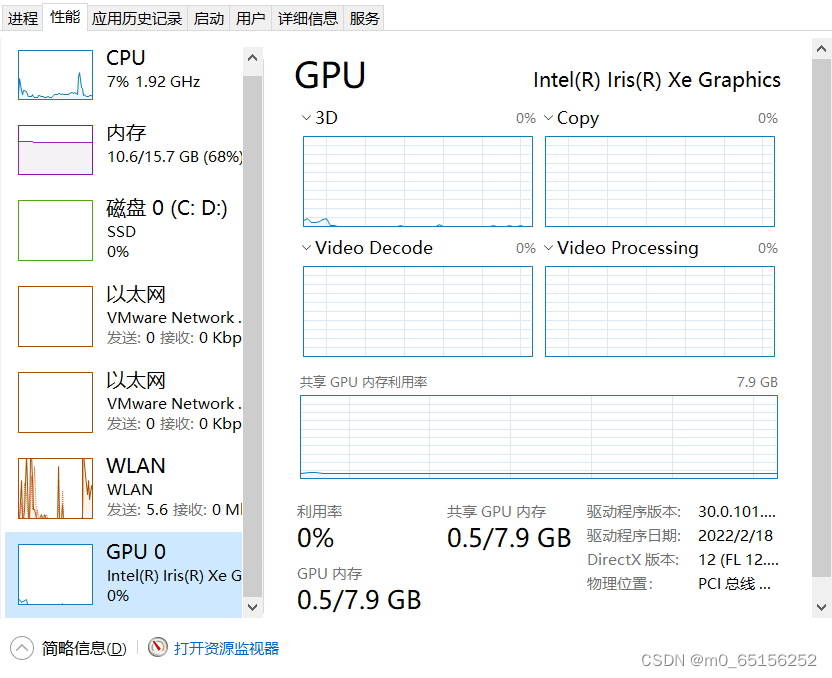

4,ctrl+shift+esc启动资源管理器,点击性能来查看:

GPU0就是我们俗称的集显=集成显卡是主板自带的显卡。

2024/3/16

1,使用GPU就需要依赖CUDA(Compute Unified Device Architecture)这个NVIDIA的并行计算架构,并且我们还需要在服务器上安装CUDNN(CUDA Deep Neural Network)库,以提供更高效的深度学习计算。

2,Intel集成显卡并不支持CUDA。与NVIDIA独立显卡相比,集成显卡通常缺乏可用于并行计算任务的CUDA核心数量。因此,大多数集成显卡无法使用CUDA进行并行计算任务。

3,ModelScope和HuggingFace:为了构建国内的AI模型分享网站,阿里公司在大语言模型火爆AI领域的大背景下选择跟进,推出了对标huggingface的modelscope(理解为国内开源模型分享网站)。

模型下载方式:

1) 从官网下载:一般连接不上,下载不下来。

git clone https://huggingface.co/THUDM/chatglm-6b

2) 清华云盘:需要手动下载。

https://cloud.tsinghua.edu.cn/d/674208019e314311ab5c/

3) 从modelscope社区下载:比较方便,但有些模型找不到。

git clone https://www.modelscope.cn/ZhipuAI/ChatGLM-6B.git

4) 通过python代码从modelscope下载

pip install modelscope

from modelscope.models import Model

model = Model.from_pretrained(‘ZhipuAI/ChatGLM-6B’,revision=’v1.0.19’)

revision参数可选,如果不指定版本号,则会下载模型的默认版本。

4,使用curl进行API测试:

curl 命令是一个在 Linux 系统中利用 URL 工作的命令行文件传输工具,常用于服务访问和文件下载。

本文介绍了阿里云的通义千问,一个具备多轮对话、文案创作和多模态理解的大型语言模型,以及XrayGLM在医疗领域的应用。同时,讲述了CUDA和CUDNN在GPU中的作用,以及阿里在国内推出ModelScope,模仿HuggingFace,以促进AI模型的分享与应用。

本文介绍了阿里云的通义千问,一个具备多轮对话、文案创作和多模态理解的大型语言模型,以及XrayGLM在医疗领域的应用。同时,讲述了CUDA和CUDNN在GPU中的作用,以及阿里在国内推出ModelScope,模仿HuggingFace,以促进AI模型的分享与应用。

350

350

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?