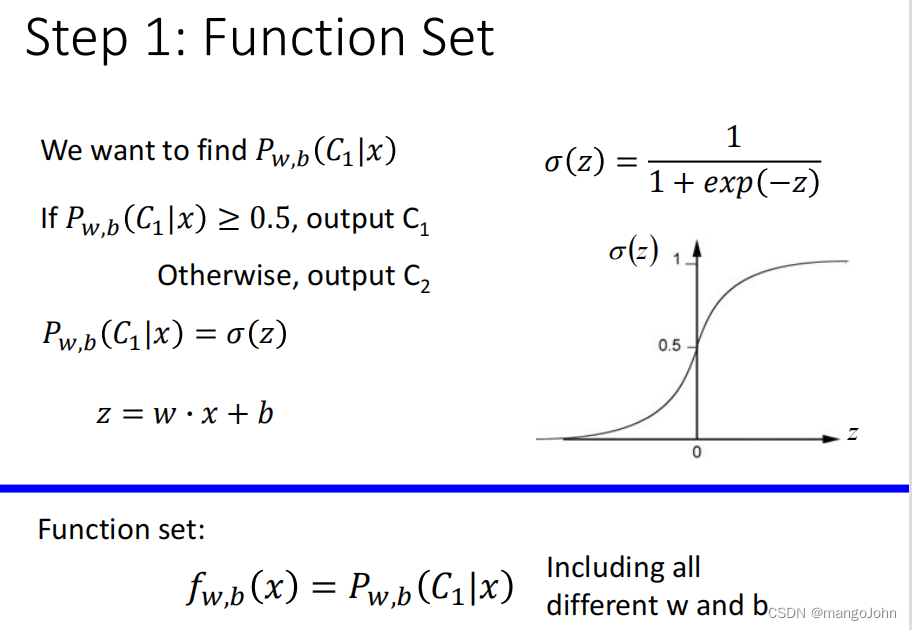

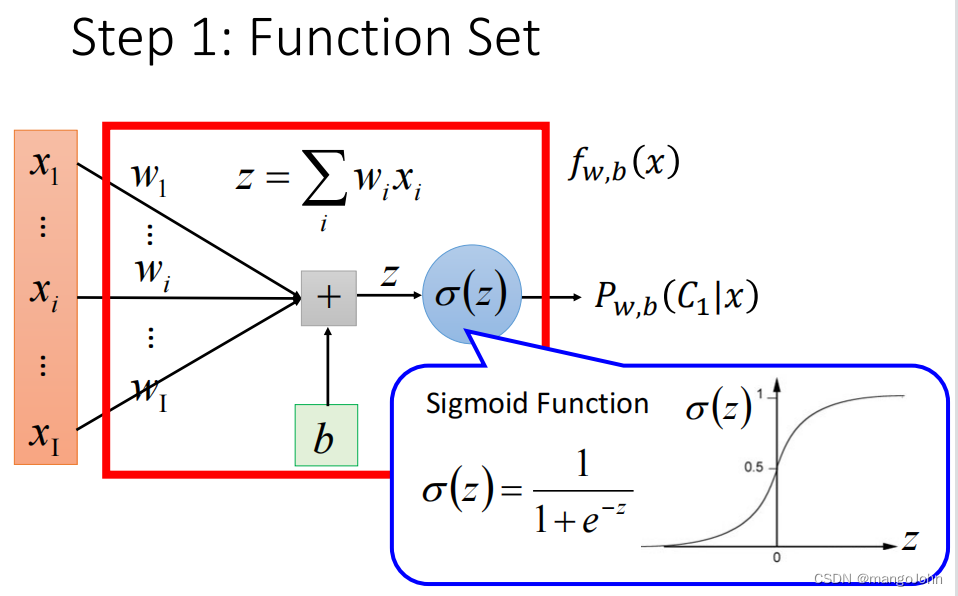

第一步中建立的函数集是:

第一步中建立的函数集是:

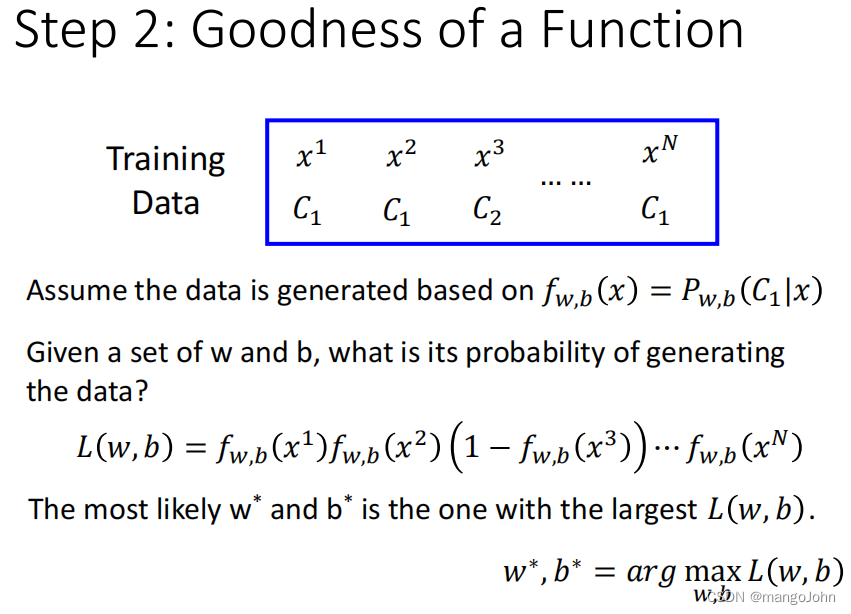

最有可能的w*和b*是使L(w,b)最大的那个。

最有可能的w*和b*是使L(w,b)最大的那个。

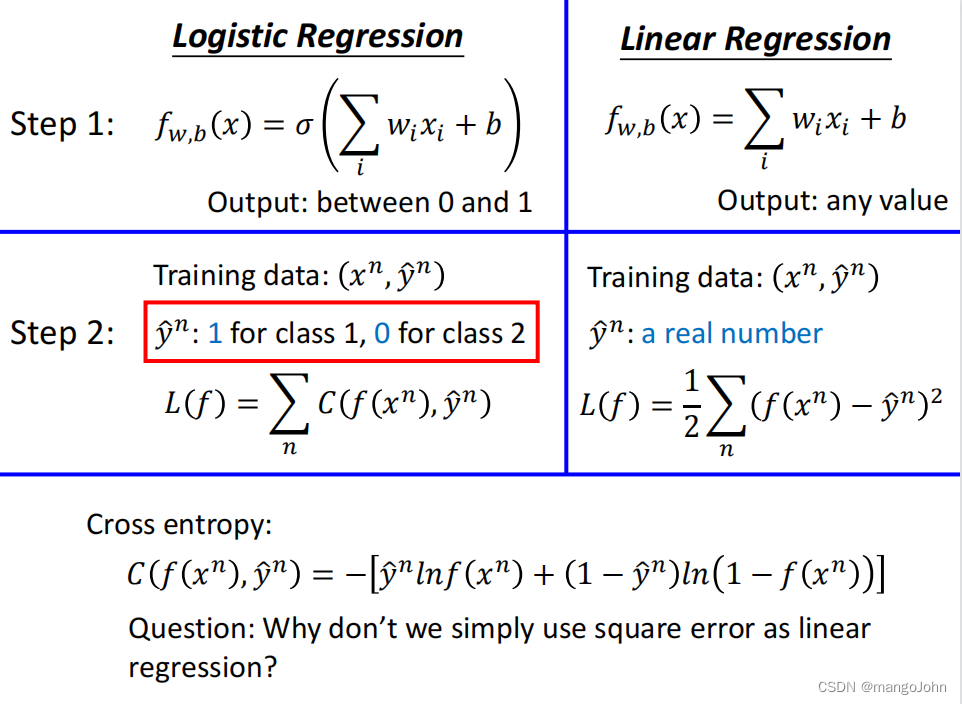

两个贝努利分布之间的交叉熵

两个贝努利分布之间的交叉熵

问题:为什么我们不简单地使用平方差作为线性回归?

问题:为什么我们不简单地使用平方差作为线性回归?

是目标,

是现在模型的output,相减差代表离目标的差距有多大

逻辑回归和线性回归有相同的update公式,只是代入的值不同

逻辑回归和线性回归有相同的update公式,只是代入的值不同

=1时,离目标很远或很近,微分都为零

=0时,离目标很远或很近,微分也都为零

在交叉熵中,离目标远则微分大,update变化量大

在交叉熵中,离目标远则微分大,update变化量大

在平方差中,离目标远微分小,update速度慢

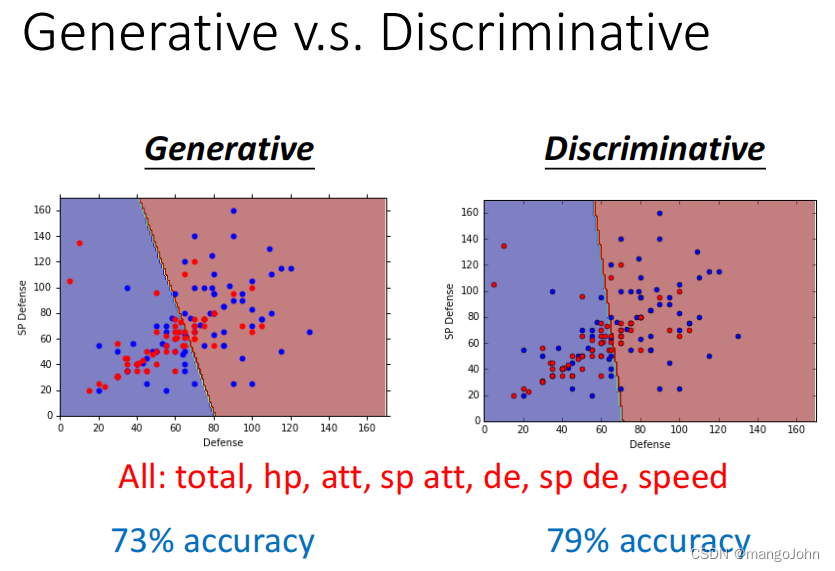

逻辑回归和generative用的一样的模型,但找出的是不一样的参数,找到的w和b也不一样

逻辑回归和generative用的一样的模型,但找出的是不一样的参数,找到的w和b也不一样

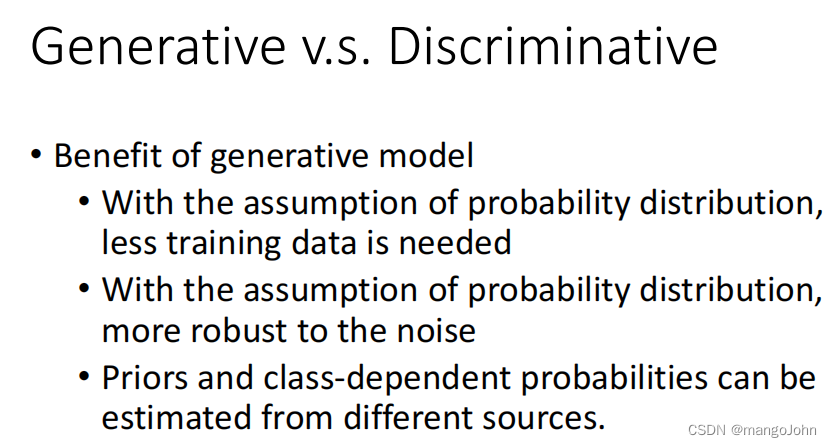

generative模型的好处

●用假设概率分布,则需要较少的训练数据

●用假设概率分布,抗噪声能力强

●先验概率和类相关概率可以从不同的来源进行估计。

做完softmax会限制output

做完softmax会限制output

maximum entropy也类似

y是probability distribution

y是probability distribution

minimize cross entropy来自于maximum likelihood

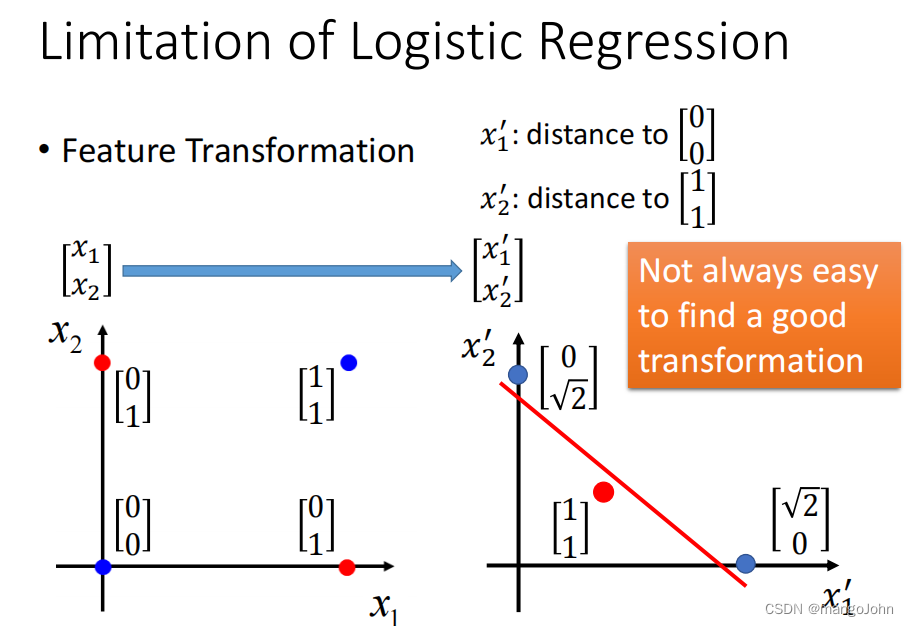

做不到将class1和class2平分为两边

做不到将class1和class2平分为两边

找到transformation不容易

找到transformation不容易

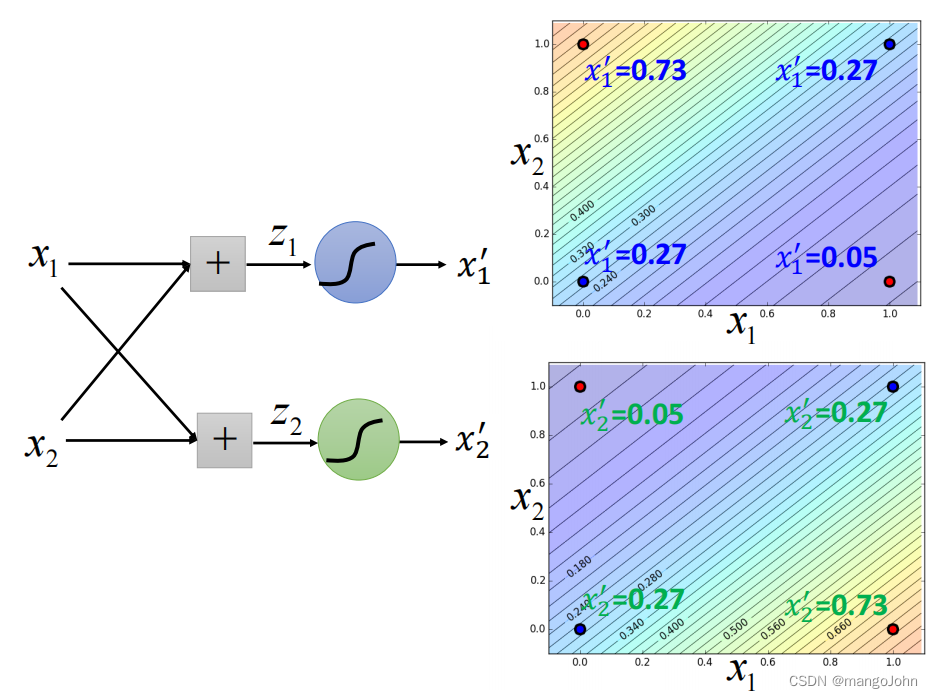

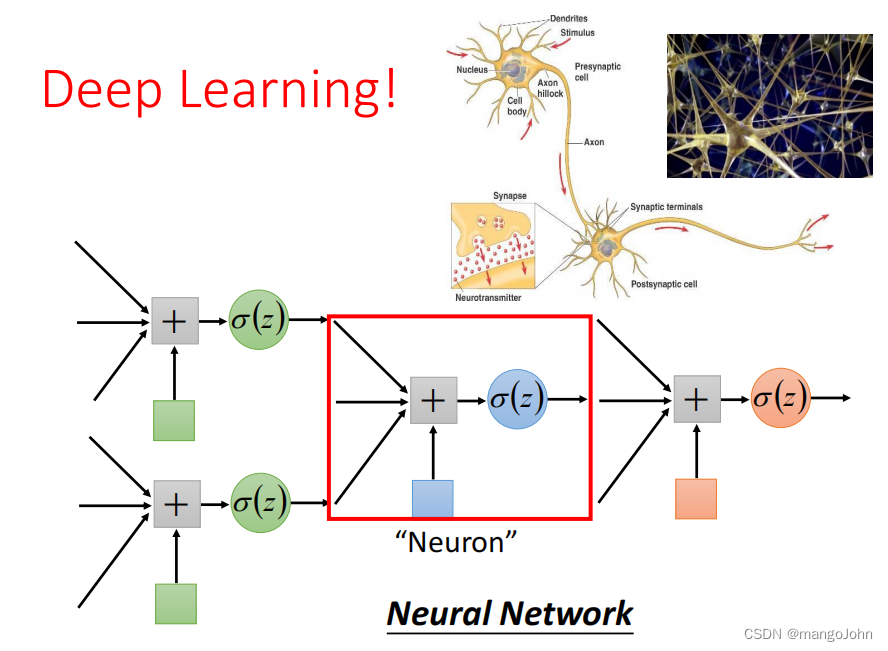

级联逻辑回归模型

级联逻辑回归模型

通过两个logistic regression model得到transformation后的x1‘,x2’

再用另外一个loigstic regression model进行classification

用红色的logistic regression将红蓝点分开

用红色的logistic regression将红蓝点分开

每个logistic regression都是一个neuron神经元,整个就是神经网络

每个logistic regression都是一个neuron神经元,整个就是神经网络

1813

1813

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?