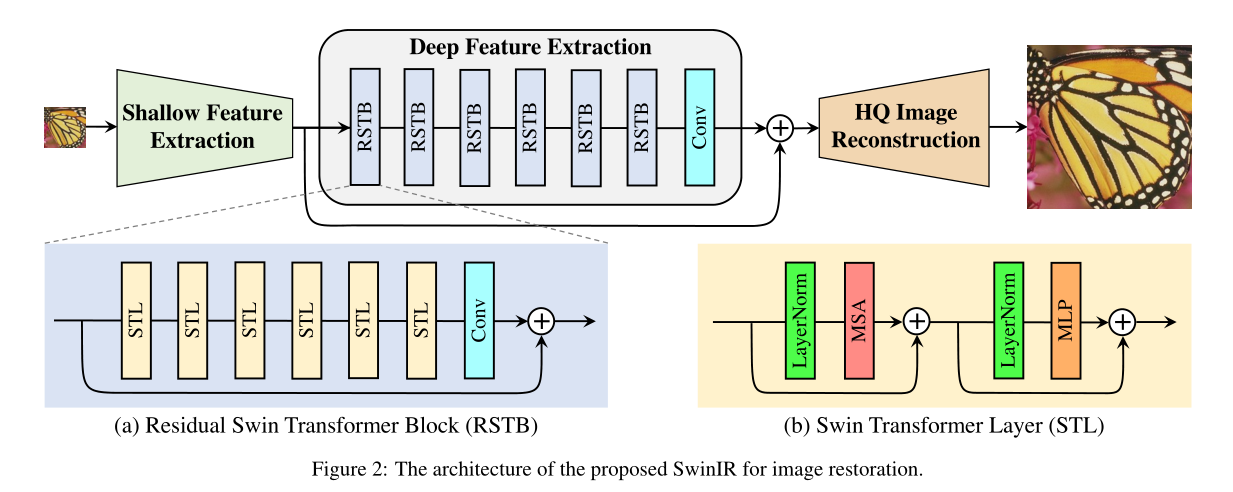

图像恢复是一个长期存在的低水平视觉问题,旨在从低质量图像(例如,缩小尺寸、噪声和压缩图像)中恢复高质量图像。虽然最先进的图像恢复方法是基于卷积神经网络的,但很少有人尝试使用Transformers,因为它在高级视觉任务中表现出令人印象深刻的性能。在本文中,我们提出了一种基于Swin Transformer的用于图像恢复的强基线模型SwinIR。SwinIR由三部分组成:浅层特征提取、深层特征提取和高质量图像重建。特别地,深度特征提取模块由几个剩余的Swin-Transformer块(RSTB)组成,每个块具有多个Swin-Transform器层以及剩余连接。我们在三个具有代表性的任务上进行了实验:图像超分辨率(包括经典、轻量级和真实世界的图像超分辨率)、图像去噪(包括灰度和彩色图像去噪)和JPEG压缩伪影减少。实验结果表明,SwinIR在不同任务上比最先进的方法高出0.14~0.45dB,而参数总数可以减少67%。

1. Introduction

图像恢复,如图像超分辨率(SR)、图像去噪和JPEG压缩伪影减少,旨在从低质量退化的图像中重建出高质量的干净图像。自从几项革命性的工作[18,40,90,91]以来,卷积神经网络(CNN)已成为图像恢复的主要工具[43,51,43,81,92,95,24,93,46,89,88]。大多数基于CNN的方法侧重于精细的架构设计,如残差学习[43,51]和密集连接[97,81]。尽管与传统的基于模型的相比,性能显著提高。它们通常遭受源于基本卷积层的两个基本问题。首先,图像和卷积核之间的交互是内容无关的。使用相同的卷积核来恢复不同的图像区域可能不是最佳选择。其次,在局部处理的原理下,卷积对于长程依赖性建模是无效的。作为CNN的替代方案,Transformer[76]设计了一种自注意机制来捕捉上下文之间的全局交互,并在几个视觉问题上表现出了良好的性能[6,74,19,56]。然而,用于图像恢复的视觉转换器[9,5]通常将输入图像划分为固定大小(例如,48×48)的补丁,并独立处理每个补丁。这样的策略不可避免地会产生两个缺点。首先,边界像素不能利用补丁之外的相邻像素进行图像恢复。第二,恢复的图像可能在每个补丁周围引入边界伪影。虽然这个问题可以通过补丁重叠来缓解,但它会带来额外的计算负担。最近,Swin Transformer[56]融合了CNN和Transformer的优势,显示出了巨大的前景。一方面,由于局部注意力机制,它具有CNN处理大尺寸图像的优势。另一方面,它具有Transformer的优点,可以使用移位窗口方案对长程依赖进行建模。在本文中,我们提出了一种基于Swin Transformer的图像恢复模型,即SwinIR。更具体地说,SwinIR由三个模块组成:浅层特征提取、深层特征提取和高质量图像重建模块。浅层特征提取模块利用卷积层提取浅层特征,直接传输到重构模块,以保存低频信息。深度特征提取模块主要由残差Swin-Transformer块(RSTB)组成,每个块利用几个Swin-Transformers层进行局部关注和跨窗口交互。此外,我们在块的末尾添加了一个卷积层来进行特征增强,并使用残差连接来提供特征聚合的快捷方式。最后,在重建模块中融合浅特征和深特征,以实现高质量的图像重建。与流行的基于CNN的图像恢复模型相比,基于Transformer的SwinIR有几个好处:(1)图像内容和注意力权重之间基于内容的交互,这可以解释为空间变化的卷积[13,21,75]。(2) 长程依赖性建模是通过移位窗口机制实现的。(3) 用更少的参数获得更好的性能。例如,如图6所示,与现有的图像SR方法相比,SwinIR以更少的参数实现了更好的PSNR。

2. Related Work

2.1. Image Restoration

与通常基于模型的传统图像恢复方法[28,72,73,62,32]相比,基于学习的方法,尤其是基于CNN的方法,由于其令人印象深刻的性能而变得更加流行。他们经常从大规模配对数据集中学习低质量和高质量图像之间的映射。自开创性工作SRCNN[18](用于图像SR)、DnCNN[90](用于图像去噪)和ARCNN[17](用于JPEG压缩伪影减少)以来,已经提出了一系列基于CNN的模型,通过使用更精细的神经网络架构设计来提高模型表示能力,如残差块[40,7,88],致密嵌段[81,97,98]和其他[10,42,93,78,77,79,50,48,49,92,70,36,83,30,11,16,96,64,38,26,41,25]。其中一些已经利用了CNN框架内的注意力机制,如通道注意力[95,15,63]、非局部注意力[52,61]和自适应补丁聚合[100]。

2.2. Vision Transformer

最近,自然语言处理模型Transformer[76]在计算机视觉界非常受欢迎。当用于视觉问题,如图像分类[66,19,84,56,45,55,75]时,目标检测[6,53,74,56]、分割[84,99,56,4]和人群计数[47,69],它通过探索不同区域之间的全局交互来学习关注重要的图像区域。由于其令人印象深刻的性能,Transformer也被引入图像恢复[9,5,82]。Chen等人[9]提出了一种基于标准Transformer的用于各种恢复问题的骨干模型IPT。然而,IPT依赖于大量参数(超过115.5M个参数)、大规模数据集(超过110万个图像)和多任务学习来获得良好的性能。Cao等人[5]提出了VSR Transformer,它使用自注意机制在视频SR中进行更好的特征融合,但图像特征仍然是从CNN中提取的。此外,IPT和VSR Transformer都是逐片关注的,这可能不适合图像恢复。此外,一项并行工作[82]提出了一种基于Swin Transformer[56]的U形架构。

3. Method

3.1. Network Architecture

如图2所示,SwinIR由三个模块组成:浅层特征提取、深层特征提取和高质量(HQ)图像重建模块。我们对所有恢复任务使用相同的特征提取模块,但对不同的任务使用不同的重建模块。

Shallow and deep feature extraction.

......

Image reconstruction.

......

3.2. Residual Swin Transformer Block

......

4. Experiments

4.1. Experimental Setup

对于经典图像SR、真实世界图像SR、图像去噪和JPEG压缩伪影减少,RSTB数、STL数、窗口大小、通道数和注意力头数通常分别设置为6、6、8、180和6。一个例外是,为了减少JPEG压缩伪影,窗口大小被设置为7,因为我们在使用8时观察到性能显著下降,这可能是因为JPEG编码使用8×8图像. 对于轻量级图像SR,我们将RSTB数量和通道数量分别减少到4和60。在[95,63]之后,当在测试中使用自集成策略[51]时,我们用符号“+”标记模型,例如SwinIR+。由于篇幅限制,补充资料中提供了培训和评估的详细信息。

4.2. Ablation Study and Discussion

对于消融研究,我们在经典图像SR(×2)的DIV2K[1]上训练SwinIR,并在Manga109[60]上进行测试。

Impact of channel number, RSTB number and STL number

我们在图3(a)、3(b)和3(c)中分别显示了RSTB中的通道数、RSTB数和STL数对模型性能的影响。观察到PSNR与这三个超参数呈正相关。对于通道数量,尽管性能不断提高,但参数总数呈二次方增长。为了平衡性能和模型大小,我们在休息实验中选择180作为通道数。对于RSTB数量和层数,性能增益逐渐饱和。我们为它们两者选择6,以获得相对较小的模型。

Impact of patch size and training image number; model convergence comparison.

我们将所提出的SwinIR与具有代表性的基于CNN的模型RCAN进行了比较,以比较基于Transformer和基于CNN模型的差异。从图3(d)可以看出,在不同的补丁大小上,SwinIR比RCAN表现更好,并且当补丁大小更大时,PSNR增益变得更大。图3(e)显示了训练图像数量的影响。当百分比大于100%(800个图像)时,Flickr2K的额外图像将用于训练。有两个观察结果。首先,正如预期的那样,SwinIR的性能随着训练图像数量的增加而提高。其次,与IPT中观察到的基于Transformer的模型严重依赖于大量训练数据不同,即使数据集很小(即25%,200张图像),SwinIR也比使用相同训练数据的基于CNN的模型取得了更好的结果。我们还在图3(f)中绘制了SwinIR和RCAN训练期间的PSNR。很明显,SwinIR比RCAN收敛得更快、更好,这与之前的观察结果相矛盾,即基于变换的模型通常收敛缓慢。

Impact of residual connection and convolution layer in RSTB.

表1显示了RSTB中的四种残差连接变体:无残差连接,使用1×1卷积层,使用3×3卷积层和使用三个3×3卷积层(中间层的信道号设置为网络信道号的四分之一)。从表中,我们可以得出以下观察结果。首先,RSTB中的残差连接很重要,因为它将PSNR提高了0.16dB。其次,使用1×1卷积带来的改进很小,可能是因为它不能像3×3卷积那样提取局部邻近信息。第三,尽管使用三个3×3卷积层可以减少参数的数量,但性能略有下降

4.3. Results on Image SR

Classical image SR. 表2显示了SwinIR(中等规模)与最先进方法之间的定量比较:DBPN[31]、RCAN[95]、RRDB[81]、SAN[15]、IGNN[100]、HAN[63]、NLSA[61]和IPT[9]。正如人们所看到的,当在DIV2K上训练时,SwinIR在几乎所有五个基准数据集上针对所有比例因子都实现了最佳性能。对于比例因子4,Manga109上的最大PSNR增益达到0.26dB。注意,RCAN和HAN引入了通道和空间注意力,IGNN提出了自适应补丁特征聚合,NLSA基于非局部注意力机制。然而,所有这些基于CNN的注意力机制的性能都比所提出的基于Transformer的SwinIR差,这表明了所提出的模型的有效性。当我们在更大的数据集(DIV2K+Flickr2K)上训练SwinIR时,性能进一步提高了很大的幅度(高达0.47dB),实现了比相同的基于Transformer的模型IPT更好的精度,尽管IPT在训练中使用ImageNet(超过130万张图像),并且具有大量参数(115.5万)。相比之下,即使与最先进的基于CNN的模型(15.4~44.3M)相比,SwinIR也有少量的参数(11.8M)。至于运行时间,代表性的基于CNN模型RCAN、IPT和SwinIR分别需要0.2、4.5和1.1秒才能在1024×1024的图像上进行测试。视觉对比如图4所示。SwinIR可以恢复高频细节,缓解模糊伪影,产生清晰自然的边缘。相比之下,大多数基于CNN的方法会产生模糊的图像,甚至不正确的纹理。与基于CNN的方法相比,IPT生成更好的图像,但它会受到图像失真和边界伪影的影响。

Lightweight image SR. 我们还将SwinIR(小尺寸)与最先进的轻量级图像SR方法进行了比较:CARN[2]、FALSR-A[12]、IMDN[35]、LAPAR-A[44]和LatticeNet[57]。除了PSNR和SSIM,我们还报告了参数总数和乘法累加运算(在1280×720 HQ图像上评估),以比较不同模型的模型大小和计算复杂度。如表3所示,在不同的基准数据集上,在参数总数和多累积操作相似的情况下,SwinIR的PSNR幅度高达0.53dB,优于竞争方法。这表明SwinIR架构对于图像恢复是高效的。

Real-world image SR. 图像SR的最终目标是用于真实世界的应用。最近,Zhang等人[89]为真实世界的图像SR提出了一个实用的退化模型BSRGAN,并在真实场景中取得了令人惊讶的结果1。为了测试SwinIR在现实世界SR中的性能,我们通过使用与用于低质量图像合成的BSRGAN相同的退化模型来重新训练SwinIR。由于没有真实的高质量图像,我们只提供与代表性的双三次模型ESRGAN[81]和最先进的现实世界图像SR模型RealSR[37]、BSRGAN[89]和Real ESRGAN[70]的视觉比较。如图6所示,SwinIR产生了具有清晰和尖锐边缘的视觉愉悦的图像,而其他比较方法可能会出现不令人满意的伪影。此外,为了充分利用SwinIR在实际应用中的潜力,我们进一步提出了大型模型,并在更大的数据集上进行训练。实验表明,它可以处理更复杂的损坏,并在真实世界的图像上实现比当前模型更好的性能。

4.4. Results on JPEG Compression Artifact Reduction

表4显示了SwinIR与现有JPEG压缩伪影减少方法的比较:ARCNN[17]、DnCNN-3[90]、QGAC[20]、RNAN[96]、RDN[98]和DRUNet[88]。所有比较的方法都是基于CNN的模型。在[98,88]之后,我们在两个基准数据集(Classic5[22]和LIVE1[67])上测试了JPEG质量因子10、20、30和40的不同方法。正如我们所看到的,对于不同的质量因子,所提出的SwinIR在两个测试数据集上的平均PSNR增益至少为0.11dB和0.07dB。此外,与之前最好的模型DRUNet相比,SwinIR只有1150万个参数,而DRUNet是一个有3270万个参数的大型模型。

4.5. Results on Image Denoising

我们分别在表5和表6中显示了灰度图像和彩色图像的去噪结果。比较的方法包括传统模型BM3D[14]和WNNM[29],基于CNN的模型DnCNN[90],IRCNN[91],FFDNet[92],N3Net[65],NLRN[52],FOCNet[38],RNAN[96],MWCNN[54]和DRUNet[88]。在[90,88]之后,比较的噪声水平包括15、25和50。可以看出,我们的模型比所有比较方法都能获得更好的性能。特别是,在拥有100张高分辨率测试图像的大型Urban100数据集上,它超过了最先进的模型DRUNet高达0.3dB。值得指出的是,SwinIR只有12.0万个参数,而DRUNet有3270万个参数。这表明SwinIR体系结构在学习用于恢复的特征表示方面是高效的。不同方法的灰度和彩色图像去噪的视觉比较如图6和图7所示。正如我们所看到的,我们的方法可以去除严重的噪声破坏,并保留高频图像细节,从而产生更清晰的边缘和更自然的纹理。相比之下,其他方法要么过于平滑,要么过于清晰,无法恢复丰富的纹理。

706

706

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?