1 简介

论文题目:Collective Event Detection via a Hierarchical and Bias Tagging Networks with Gated Multi-level Attention Mechanisms

论文来源:EMNLP 2018

论文链接:https://aclanthology.org/D18-1158.pdf

代码链接:https://github.com/yubochen/NBTNGMA4ED

1.1 创新

- 提出一个新的模型用于事件检测,使用一个分等级和带偏置的标注网络,同时检测一个句子中的多个事件,使用一个门控多等级的注意力机制,自动地抽取和动态地合并上下文信息。

2 背景知识

- 在ACE 2005数据集中,接近30%的句子包含多个事件。

3 方法

模型的整体框架如上图所示,主要包括下面4个部分:

- Embedding Layer:使用Skip-gram对token进行编码。

- BiLSTM Layer:使用BiLSTM对句子进行编码,整个句子的编码表示为 h s i = [ h → N w , h ← 1 ] h_{si}=[\overrightarrow{h}_{N_w},\overleftarrow{h}_{1}] hsi=[hNw,h1]

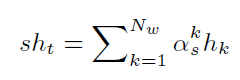

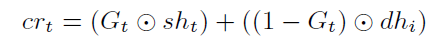

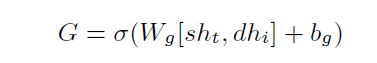

- Gated Multi-level Attention:该部分包括两个部分句子级注意力层和文档级注意力层,然后使用Fusion Gate融合这两部分信息,最后每个token被表示为

x

r

t

=

[

e

t

,

c

r

t

]

xr_t=[e_t,cr_t]

xrt=[et,crt],公式如下:

句子级:

|

|

|

文档级:

最后将上述两个部分的信息进行合并:

|

|

- Hierarchical Tagging Layer:该部分使用两个Tagging LSTM和一个tagging 注意力自动地事件之间的依赖.

第一层(与LSTM类似,增加了 t t − 1 1 t_{t-1}^1 tt−11):

第二层(与第一层类似增加了 T t a T_t^a Tta):

其中 T t a T_t^a Tta由下面tagging attention计算:

最后对输入进行分类:

损失函数如下,使用了偏置权重

4 实验

实验结果如下图:

消融实验:

Case Study:

2284

2284

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?