每天给你送来NLP技术干货!

来自:知识工场

一、研究背景

跨语言摘要(Cross-Lingual Summarization)旨在为一种语言的文档生成另一种语言的摘要。目前已有的跨语言摘要研究主要关注在新闻报道[1,2],生活指南[3]以及百科文章[4]上,缺乏针对于对话文档的研究。不同于其他文档,对话文档记录了由多名参与者所提供的结构化对话信息,有着信息分散、话题转移频率高等特点。

为了推进针对于对话文档的跨语言摘要研究,我们与微信模式识别中心展开合作,共同提出了跨语言对话摘要任务并构建了第一个大规模的跨语言对话摘要基准数据集ClidSum。在此基础上,我们制定了不同的预训练策略来提升已有多语言预训练模型(即mBART-50)在跨语言对话摘要上的适应力,并提出了mDialBART跨语言对话摘要预训练模型。目前该工作已被EMNLP 2022主会接收。相关链接如下:

Paper:https://arxiv.org/abs/2202.05599

Code :https://github.com/krystalan/ClidSum

二、ClidSum构建流程

PART 01

构建思路

以往的跨语言摘要数据集主要通过两种方式构建:(1)将单语摘要数据集中的摘要部分从源语言翻译至目标语言,这样原始文档与翻译后的摘要便可构成跨语言摘要样本;(2)从多语言网站上直接收集跨语言摘要对,例如在维基百科中,将某一词条的主体部分当作源语言文档,并将该词条在其余语言版本中的首段当作目标语言摘要。

通过调研,我们发现目前没有公开的网络资源提供多语言对话数据,因此我们采用方法(1)来构建跨语言对话摘要数据集,即选择已有的单语对话摘要数据集,并翻译其中的摘要部分。

PART 02

数据选择

在比较了已有的单语对话摘要数据集[5]后,我们选择了SAMSum数据集[6]以及MediaSum数据集[7]。SAMSum和MediaSum有着较高的质量,包含了真实世界中或人工标注的单语言对话-摘要对,涉及到人们生活的多种场景。这两个数据集也在近几年的单语对话摘要研究中也备受关注[5]。

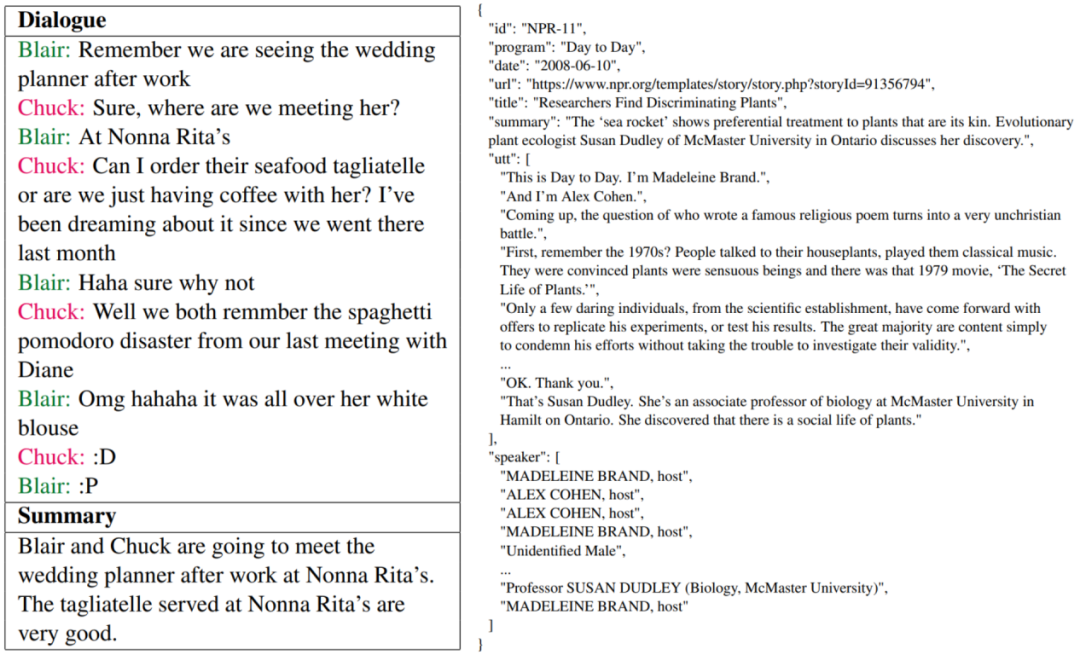

图1 SAMSum(左)与MediaSum(右)单语摘要数据集中的样例

PART 03

标注过程

在确定单语对话摘要数据集之后,我们采用人工翻译的方式将SAMSum的全部摘要(约16K)以及MediaSum的部分摘要(40K)从英文分别翻译至汉语与德语。

在翻译过程中,我们采用了严格的质量控制流程,所有英汉译员均通过了英文专八(TEM-8)的资格认定,所有英德译员均通过了英文专八(TEM-8)与德语专八(PGH)的资格认定。除此之外,还有数据审查人员与数据专家对翻译结果进行抽查与评定,确保所得到的汉语/德语摘要的质量。

我们将翻译后的SAMSum数据集称为XSAMSum,将MediaSum被翻译的部分称为XMediaSum40k,没翻译的部分称为MediaSum424k。

PART 04

数据统计

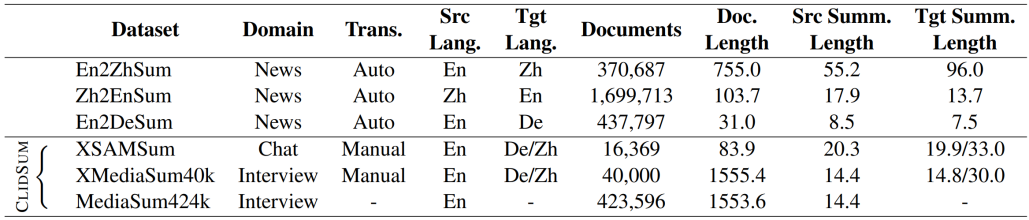

表1 先前跨语言摘要数据集与ClidSum数据集的统计对比

如上表所示,ClidSum一共包含了约56K英中跨语言对话摘要对,以及56K英德跨语言对话摘要对。其中约16K来自SAMSum,40K来自MediaSum。此外,SAMSum的文档平均长度为83.9,而MediaSum则长达上千单词。因此,ClidSum对短文本与长文本均有涉及。

三、mDialBART预训练模型

01

动机

现有的多语言预训练生成模型(例如mBART和mT5)在预训练阶段仅学习到了底层的语言建模能力,并没有建模跨语言能力以及理解对话文档的能力。为了帮助多语言预训练生成模型更好地完成跨语言对话摘要任务,我们在mBART的基础上提出了mDialBART预训练生成模型。

02

预训练任务

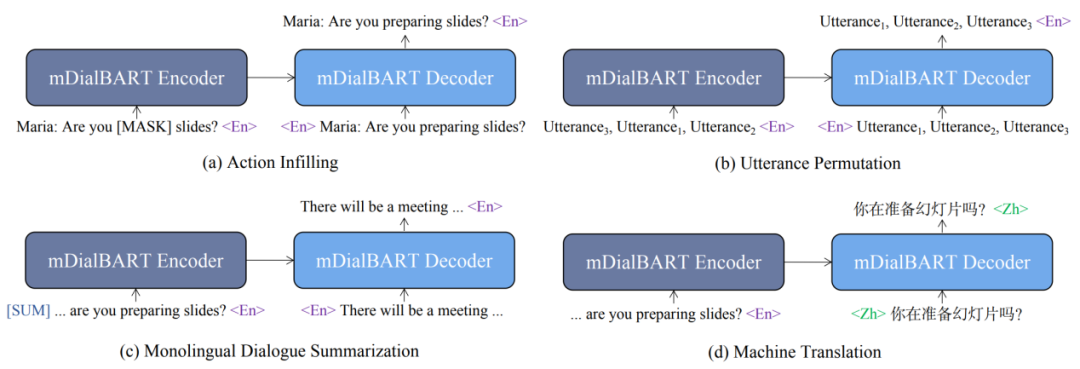

图2 mDialBART中的四个预训练任务

如上图所示,为了提升模型理解对话文档的能力,我们采用了action infilling和utterance permutation预训练任务。其中action infilling随机掩码了对话文档中的重要信息,并让模型恢复原始对话文档,受启发于S-BART[8],我们将对话文档中的who-doing-what信息视为重要信息。Utterance permutation打算了一篇对话文档中的utterance顺序,并让模型进行恢复。除此之外,我们还采用了单语对话摘要(monolingual dialogue summarization)任务以及机器翻译(machine translation)任务同时让模型学习摘要和翻译的能力。

03

实验结果

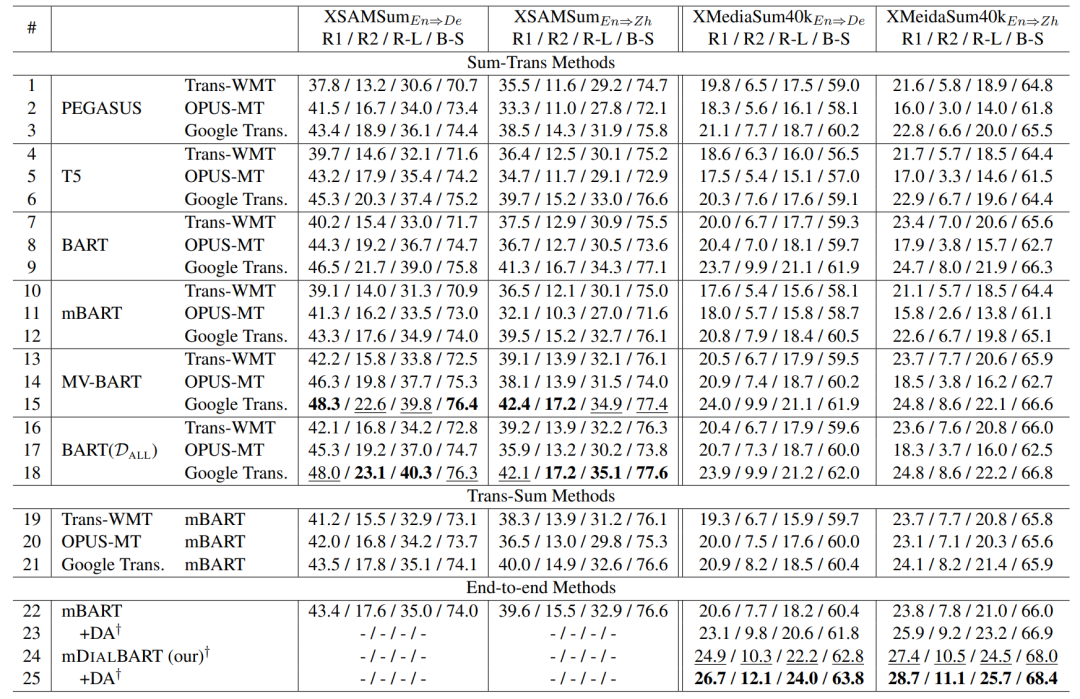

表2 主实验结果

表2 主实验结果

如上表所示,我们在XMediaSum40k上对比了mDialBART和众多基线模型,发现该预训练生成模型能够更好地用于跨语言对话摘要任务。

04

获取模型

我们已将mDialBART的模型参数开源在Huggingface社区,你可以通过下面的方式进行调用:

from transformers import MBartForConditionalGeneration

mdialbart_de = MBartForConditionalGeneration.from_pretrained('Krystalan/mdialbart_de')

mdialbart_zh = MBartForConditionalGeneration.from_pretrained('Krystalan/mdialbart_zh')

四、总 结

在本文中,我们提出了跨语言对话摘要任务并构建了第一个大规模的跨语言摘要对话基准数据集ClidSum。在构建过程中,我们采用了人工翻译已有单语对话摘要数据集的方式合成了跨语言对话摘要数据集,并进行了严格的质量控制流程。除此之外,为了让已有多语言预训练生成模型更好地完成该任务,我们在mBART的基础上提出了mDialBART,利用四个预训练任务进一步提升模型理解对话、摘要和翻译的能力。实验结果证明了mDialBART的有效性。

五、参考文献

[1] Junnan Zhu, Qian Wang, Yining Wang, Yu Zhou, Jiajun Zhang, Shaonan Wang, Chengqing Zong. NCLS: Neural Cross-Lingual Summarization. In Prof. EMNLP 2019.

[2] Tahmid Hasan, Abhik Bhattacharjee, Wasi Uddin Ahmad, Yuan-Fang Li, Yong-Bin Kang, Rifat Shahriyar. CrossSum: Beyond English-Centric Cross-Lingual Abstractive Text Summarization for 1500+ Language Pairs. ArXiv preprint, abs/2112.08804.

[3] Faisal Ladhak, Esin Durmus, Claire Cardie, Kathleen McKeown. WikiLingua: A New Benchmark Dataset for Cross-Lingual Abstractive Summarization. In Findings of EMNLP 2020.

[4] Laura Perez-Beltrachini and Mirella Lapata. Models and Datasets for Cross-Lingual Summarisation. In Prof. EMNLP 2021.

[5] Xiachong Feng, Xiaocheng Feng, Bing Qin. A Survey on Dialogue Summarization: Recent Advances and New Frontiers. In Prof. IJCAI 2022 (survey track).

[6] Bogdan Gliwa, Iwona Mochol, Maciej Biesek, Aleksander Wawer. SAMSum Corpus: A Human-annotated Dialogue Dataset for Abstractive Summarization. In Prof. of the 2nd Workshop on New Frontiers in Summarization.

[7] Chenguang Zhu, Yang Liu, Jie Mei, Michael Zeng. MediaSum: A Large-scale Media Interview Dataset for Dialogue Summarization. In Prof. NAACL 2021.

[8] Jiaao Chen and Diyi Yang. Structure-Aware Abstractive Conversation Summarization via Discourse and Action Graphs. In Prof. NAACL 2021.

论文&文稿作者

责任编辑:王文

📝论文解读投稿,让你的文章被更多不同背景、不同方向的人看到,不被石沉大海,或许还能增加不少引用的呦~ 投稿加下面微信备注“投稿”即可。

最近文章

COLING'22 | SelfMix:针对带噪数据集的半监督学习方法

ACMMM 2022 | 首个针对跨语言跨模态检索的噪声鲁棒研究工作

ACM MM 2022 Oral | PRVR: 新的文本到视频跨模态检索子任务

投稿或交流学习,备注:昵称-学校(公司)-方向,进入DL&NLP交流群。

方向有很多:机器学习、深度学习,python,情感分析、意见挖掘、句法分析、机器翻译、人机对话、知识图谱、语音识别等。

记得备注~

416

416

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?