主题

在上下文学习中,语言模型究竟学到了什么? 探索结构化任务假说

时间

2024.10.13 15:00-16:00 周日

入群

论文:What Do Language Models Learn in Context? The Structured Task Hypothesis. (ACL 2024)

地址:https://arxiv.org/pdf/2406.04216代码链接: https://github.com/eth-lre/LLM_ICL/

大纲

导论

假设1: 任务选择

假设2: 元学习

假设3: 结构化任务选择

结论

引言

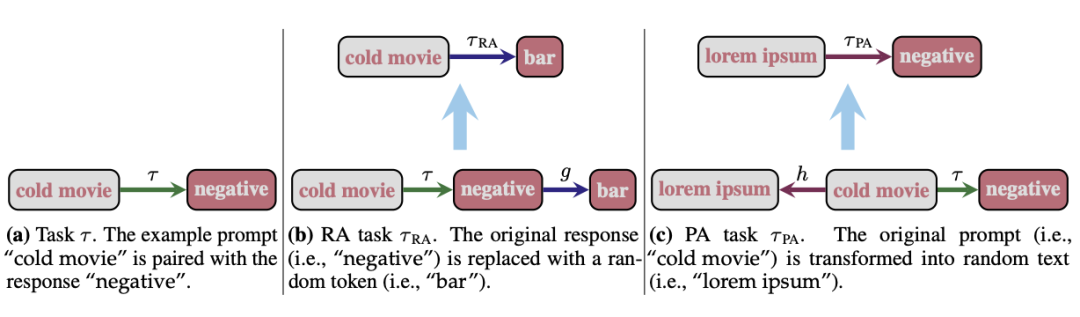

大型语言模型(LLMs)展现了通过演示中的上下文示例学习新任务的能力,这被称为上下文学习(ICL)。因此,许多研究致力于揭示ICL背后的理论。其中一个流行的假设是通过任务选择来解释ICL:LLMs基于演示示例识别任务,并将其泛化到提示中。另一个流行的假设认为ICL是一种元学习形式,即模型在预训练时学习一种学习算法,并将其应用于演示示例。最后,第三种假设认为LLMs利用演示来选择预训练期间学习的任务组合来执行ICL。

我们通过一系列源自常见文本分类任务的实验,实证探讨了这三种解释LLMs上下文学习能力的假设。我们通过反例推翻了前两个假设,并提供了支持第三个假设的证据。我们的结果表明,LLMs可以通过组合预训练期间学习的任务,在上下文中学习新的任务。

嘉宾介绍

李矫达,瑞士联邦理工学院(ETH)人工智能中心的博士生,由Ryan Cotterell和Stefan Feuerriegel共同指导。他还与Mrinmaya Sachan密切合作。ETH数据科学硕士学位,在香港城市大学电子与通信工程本科。

研究兴趣包括自然语言处理中的可解释性和形式语言理论。

编辑:聂耳聪

966

966

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?