长短期记忆网络 LSTM(输入门、遗忘门、输出门)

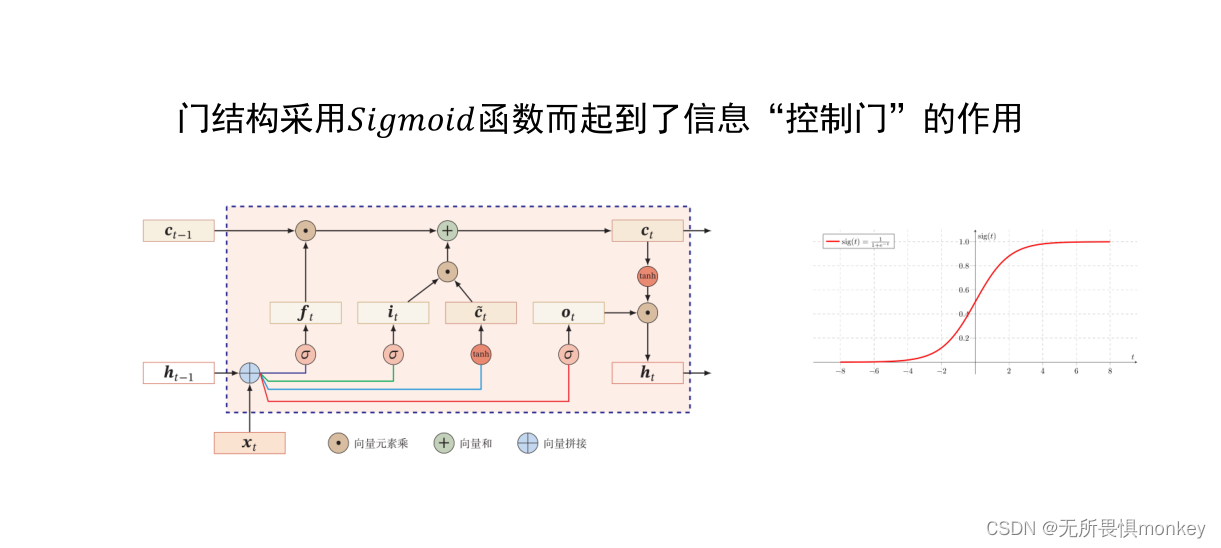

是一种循环神经网络的变体,普遍应用于NLP。主要特点是它引入了类似于逻辑电路中的门控原理,来解决传统循环神经网络中的梯度爆炸问题,但又因为继承了CNN的输出转下次输入特性,仍然广泛应用于NLP中,捕捉长期以来关系。

输入门

输入门决定哪些信息将被更新到记忆单元中。记忆单元就是上图中最上面水平的线。输入门通过使用 Sigmoid 函数来控制输入的重要程度。输入门的计算是一个逐元素的乘法操作,它将当前时间步的输入和前一时间步的输出作为输入,并将结果传递给记忆单元。

遗忘门

类似于数字逻辑电路的非门,它能够决定记忆单元里的那些数据不被输出,称为“遗忘”。利用sigmod来量化记忆程度,0为完全遗忘,1为完全记忆。

输出门

输出守门员。将输出结果其传递给下一个时间步的输出。它通过使用 Sigmoid 函数来控制记忆单元中的信息的输出程度。同也Tanh 函数对记忆单元中的信息进行处理。输出门用的也是逐元素的乘法操作,它将当前时间步的输入和前一时间步的输出作为输入,并将结果传递给输出层。

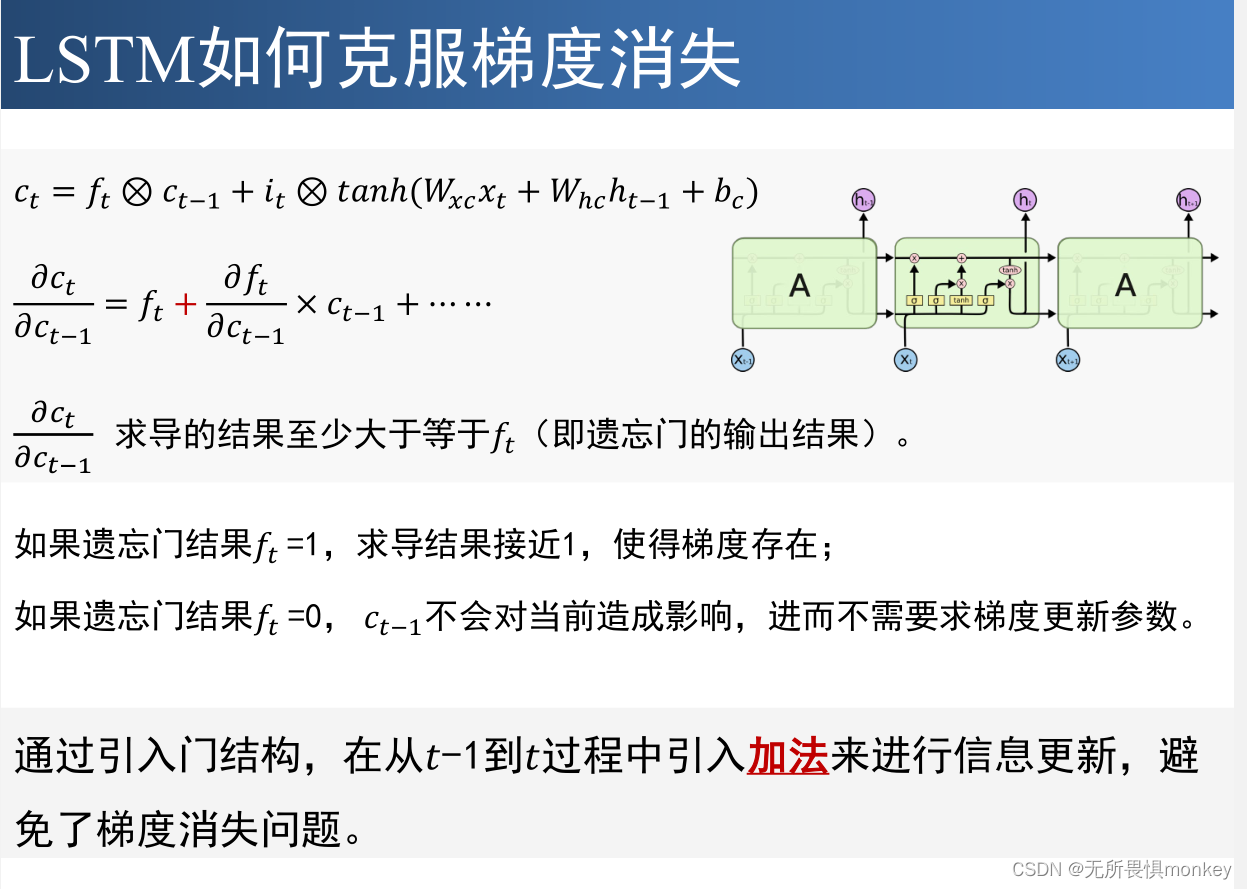

LSTM 如何克服梯度消失问题:

用人话来讲就是因为LSTM的遗忘和输出特性,有些数据被遗忘,有的的数据被留下来,不断有新数据的加入,在一定程度上能客服梯度消失。就跟家里热水器一样,有的热水回流进水箱,有的热水输出,但是水箱中源源不断有冷水加入,这就是客服梯度消失的基本原理。

门控循环单元神经网络 GRU(更新门、重置门)

更新门 :更新门决定了前一时间步的隐藏状态要在当前时间步保留多少信息。它通过使用 Sigmoid 函数来控制信息的保留程度。

重置门 :重置门决定了前一时间步的隐藏状态要在当前时间步有多少影响力。同样使用 Sigmoid函数来控制前一时间步的隐藏状态对当前时间步的影响程度,并将结果与当前时间步的输入进行组合。

写在最后

非常非常感谢魏老师一学期的启蒙,虽说本人学艺不精,但确实知道了那么些东西,写博客确实提升很大,对思路有很大的影响,只不过时间真的好挤。

最近几天总是觉得还有点什么事没干,wc原来最后一次作业还没写,整乐了,不是老师提醒根本没想起来,这里感谢一下老师提醒。但是还是不妨碍我说HBU666,课程不给退课,哥们超了6学分硬修,谁家大三满课?教学秘书的一句话给我整笑了:“你想退课为啥当初还选呢”,要不是之前好几次选课不中我会全选?修不够学分又是我的问题了呗,再退一步说,既然都不允许退课了,退课系统删了得了呗。

附带本人大三下课表:

开心得嘞。

6366

6366

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?