事件共指消解调研

- 1. 背景

- 2. 共指消解评价指标

- 3. 术语

- 4. 常用数据

- 5. 相关论文概述

- 5.1 21年论文 《A context-Dependent Gated Module for Incorporating Symbolic Semantics into Event Coreference Resolution》

- 5.2 16年论文《Event Linking with Sentential Features from Convolutional Neural Networks》

- 5.3 21年论文 《Exploiting Document Structures and Cluster Consistencies for Event Coreference Resolution》

- 5.4 18年论文 《Resolving Event Coreference with Supervised Representation Learning and Clustering-Oriented Regularization》

- 5.5 其他论文

- 参考

在事件抽取项目完成一段时间后,在去年末开始了事件关系抽取的调研。本篇不具体谈技术,主要是对事件共指关系消解做一个简单的调研记录,后续将会补充相关论文研读系列博客。

1. 背景

1.1 事件关系分类

在逻辑层面上,公认的事件关系包括:

- 共指关系

- 因果关系

- 子事件关系

- 时序关系

本篇博文主要针对事件共指关系。

1.2 事件共指关系挖掘应用

可以辅助人们从多源数据/多源信息中发现相同事件,进一步进行事件信补全或验证。

2. 共指消解评价指标

共指消解任务(包括事件共指消解、实体共指消解等)中常用评价指标有:MUC,B3,CEAF,以及BLANC。

在实际应用中,通常会采用上述指标的多种的平均值作为最终的评估指标,比如:CoNLL、AVG-F。

很多博客都对这几个评价指标有所解释,但是都描述得不清楚,如果想深入了解,可以看相关论文(参见文末参考文档);另外,也附上 官方评测代码地址,里面有示例。

3. 术语

3.1 事件共指挖掘相关术语

- 事件句/事件描述(event mention) vs 触发词 (trigger):通常事件描述或者事件句是触发词所属的那句话;触发词是短语或者词。

- 事件共指消解:判断触发词所触发的事件描述是否指向现实世界的同一事件(

不同评测数据标准稍有差异,比如ACE数据对于是否为共指关系的标准更严格)。 - 同指链:具有同指关系的所有事件描述构成一个同指链。

- 单链:不具有同指关系的单个事件描述。

3.2 事件属性

每个事件除事件触发词、事件类型、事件子类型、事件论元和事件论元的角色信息外通常还有四种属性:

- 事件的极性(polarity):表示肯定的事件或表示否定的事件。

- 事件的时态(tense):过去发生的事件、正在发生的事件、将来即将发生的事件,以及无法确定时态的事件。

- 事件的指属(genericity):特指(specific)事件、泛指(generic)事件。

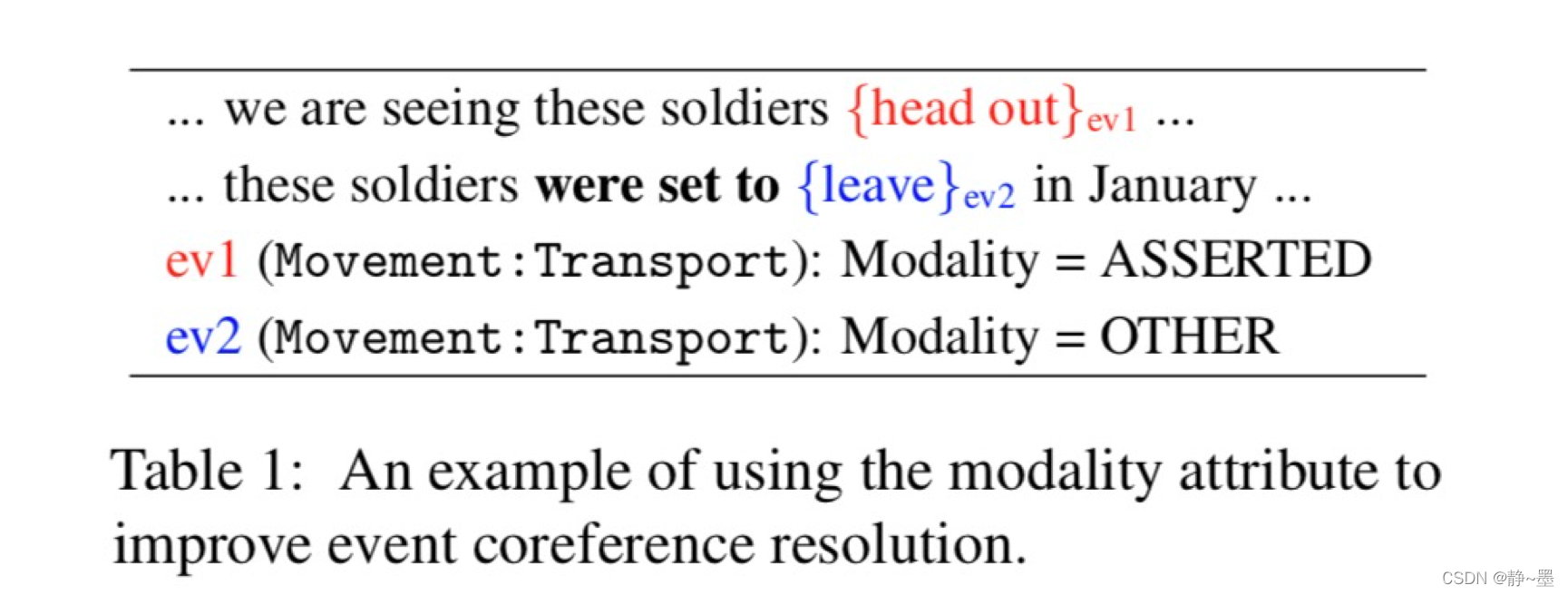

- 事件的形态(modality):语气非常肯定(asserted)的事件、信念事件(believed event)、假设事件(hypothetical event)等。

有些事件共指消解模型可能会使用到这些信息。

4. 常用数据

ACE、KBP、ECB

5. 相关论文概述

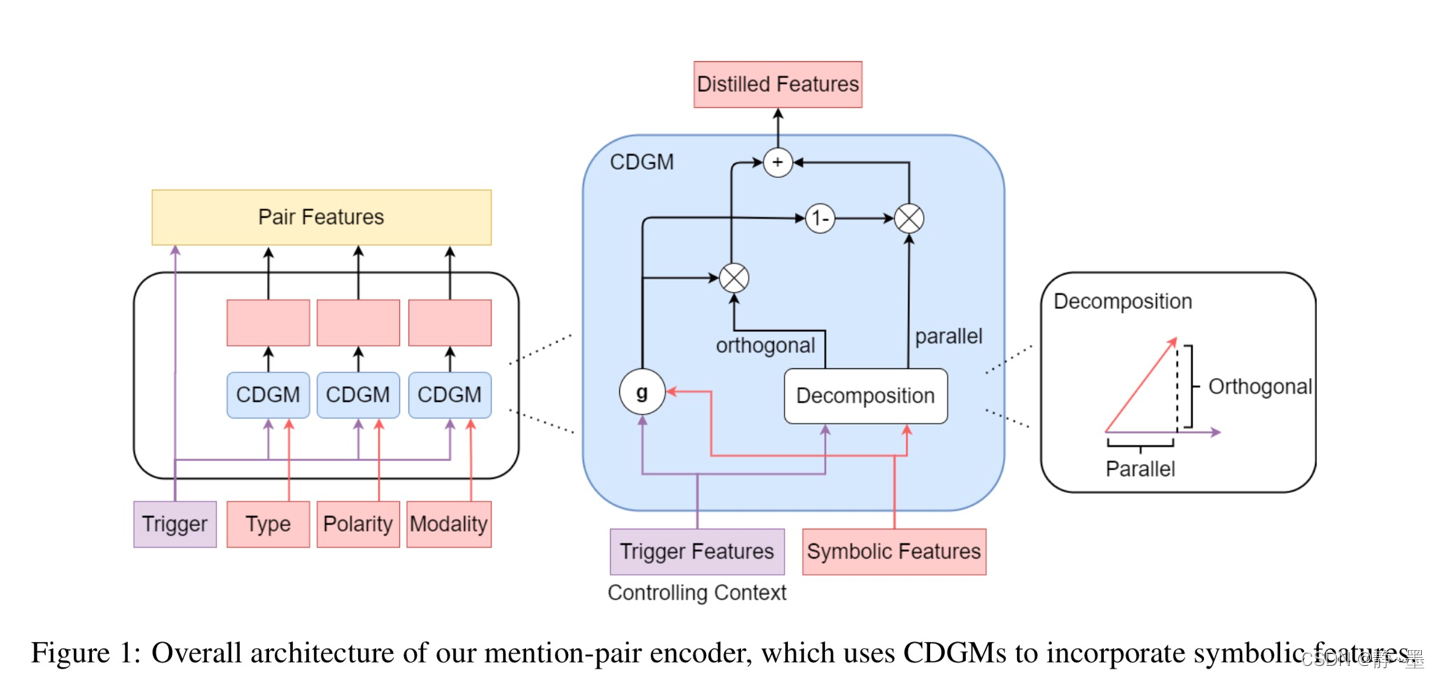

5.1 21年论文 《A context-Dependent Gated Module for Incorporating Symbolic Semantics into Event Coreference Resolution》

- 代码开源

- 类型:篇章内事件指代消解

- 实验数据与指标:

- KBP16(英文) :CoNLL 43.55;AVG 40.61

- ACE05(英文):CoNLL 62.07;AVG 69.76

- 整体思想:利用符号型特征(如事件类型、事件论元及事件的属性信息等)对事件信息做补充,从而进行事件共指消解。

- 整体框架:Mention-Pair Encoder and Scorer

- 创新点:

- 利用门控机制(context-dependent gated module,CDGM),过滤可能符号信息中可能存在的噪声或错误;

- 训练时在符号特征中随机加入噪声(一定概率替换符号特征值为随机采样值)。

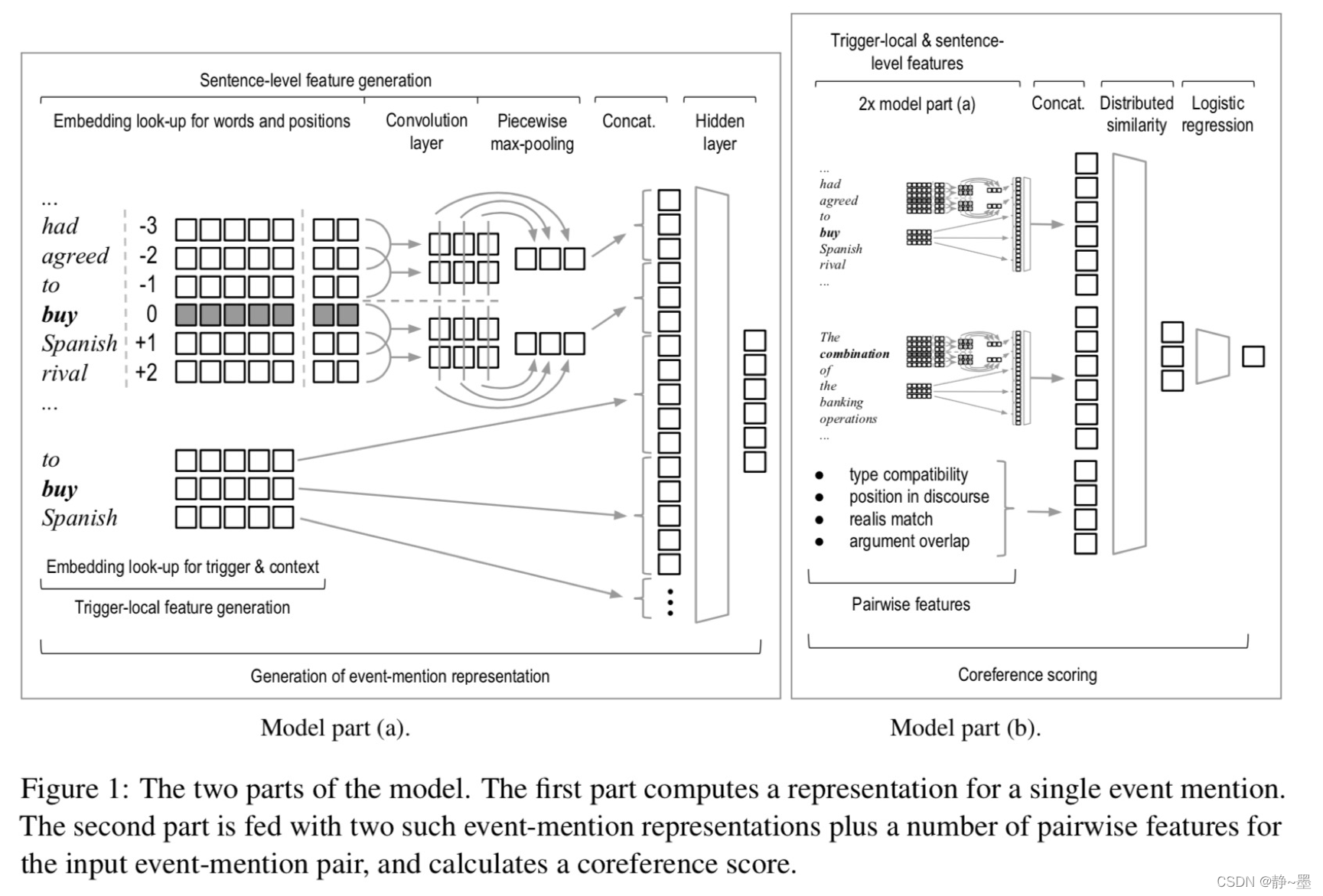

5.2 16年论文《Event Linking with Sentential Features from Convolutional Neural Networks》

- 类型:篇章内事件指代消解

- 实验数据与指标:

- ACE(英文) :BLANC 73.31,B-CUBED 88.26,MUC 52.09,Positive links:51.71

- 思想:利用卷积神经网络获取(上下文)句子级特征,再联合词级别及pairwise特征进行二分类(coreference score)。

- 整体框架:Mention-Pair Encoder and Relation Classifier

- 创新点:

- 如何表征单个event mention:使用DMCNN相同框架

- 如何对event mention pairs进行表征:融合两个事件描述的其他特征的匹配信息(如事件类型、论文重叠情况等)

- 如何进行二分类:sigmoid函数(这里和5.1论文不同,5.1论文的模型最后进行共指分数计算使用的是一个简单的线性层,结合argmax在所有候选结果里找分数最大的那一个;这里是使用二分类模型计算共指分数,结合阈值进行判定;)

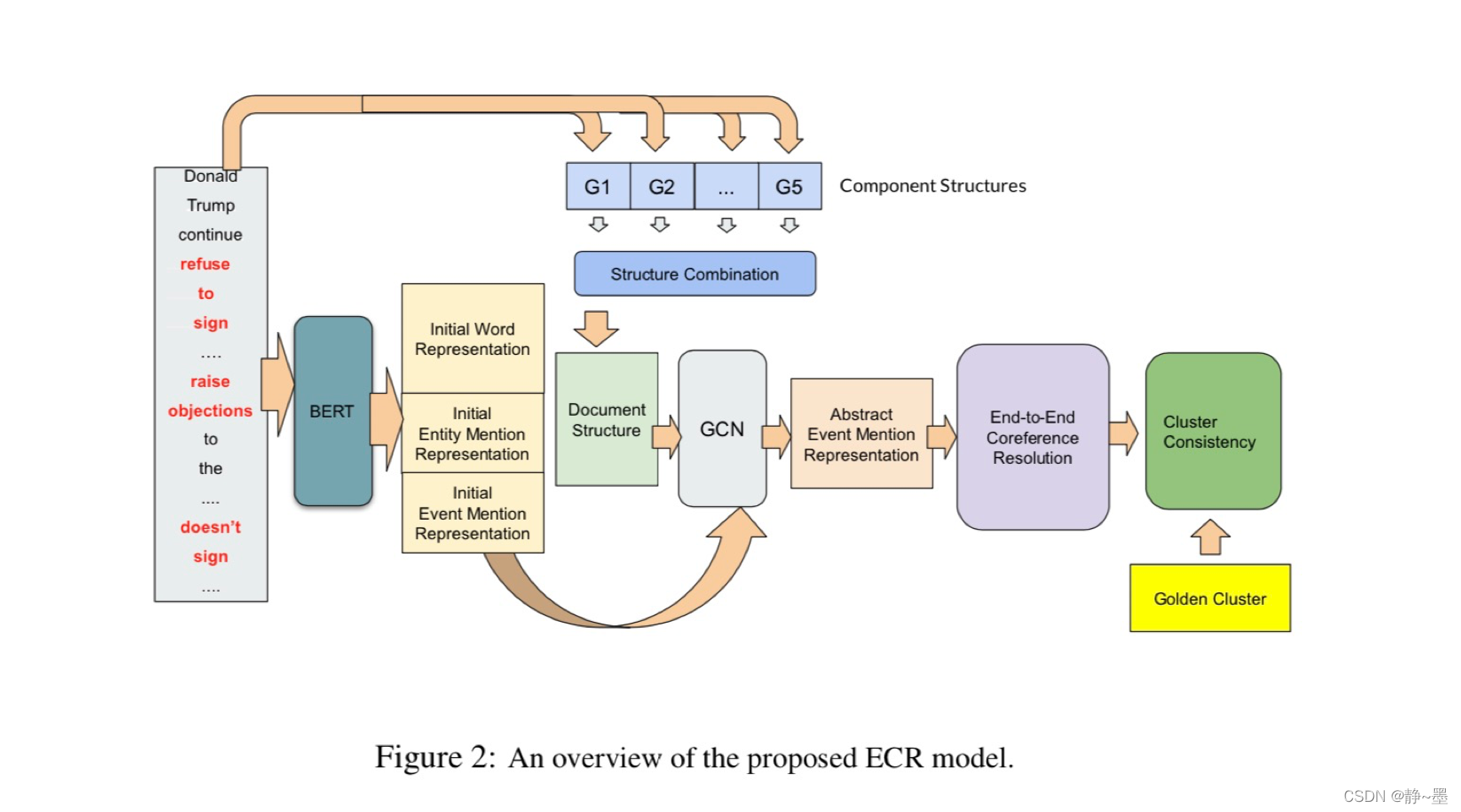

5.3 21年论文 《Exploiting Document Structures and Cluster Consistencies for Event Coreference Resolution》

- 类型:篇章内事件指代消解

- 实验数据与指标

- KBP2016(英文):B352.77;CEAFe52.29;MUC38.37;BLANC35.66;AVG44.77;

- KBP2017(英文):B351.93;CEAFe52.82;MUC40.73;BLANC34.75;AVG45.06。

- 思想:通过构造图网络利用图卷积的方式实现相关信息交互(比如:共指实体、共指上下文词等),同时在目标损失上也从聚类角度增加了预测cluster和gold cluster之间一致性约束预测共指链及GT共指链的一致性,从而优化表示学习。

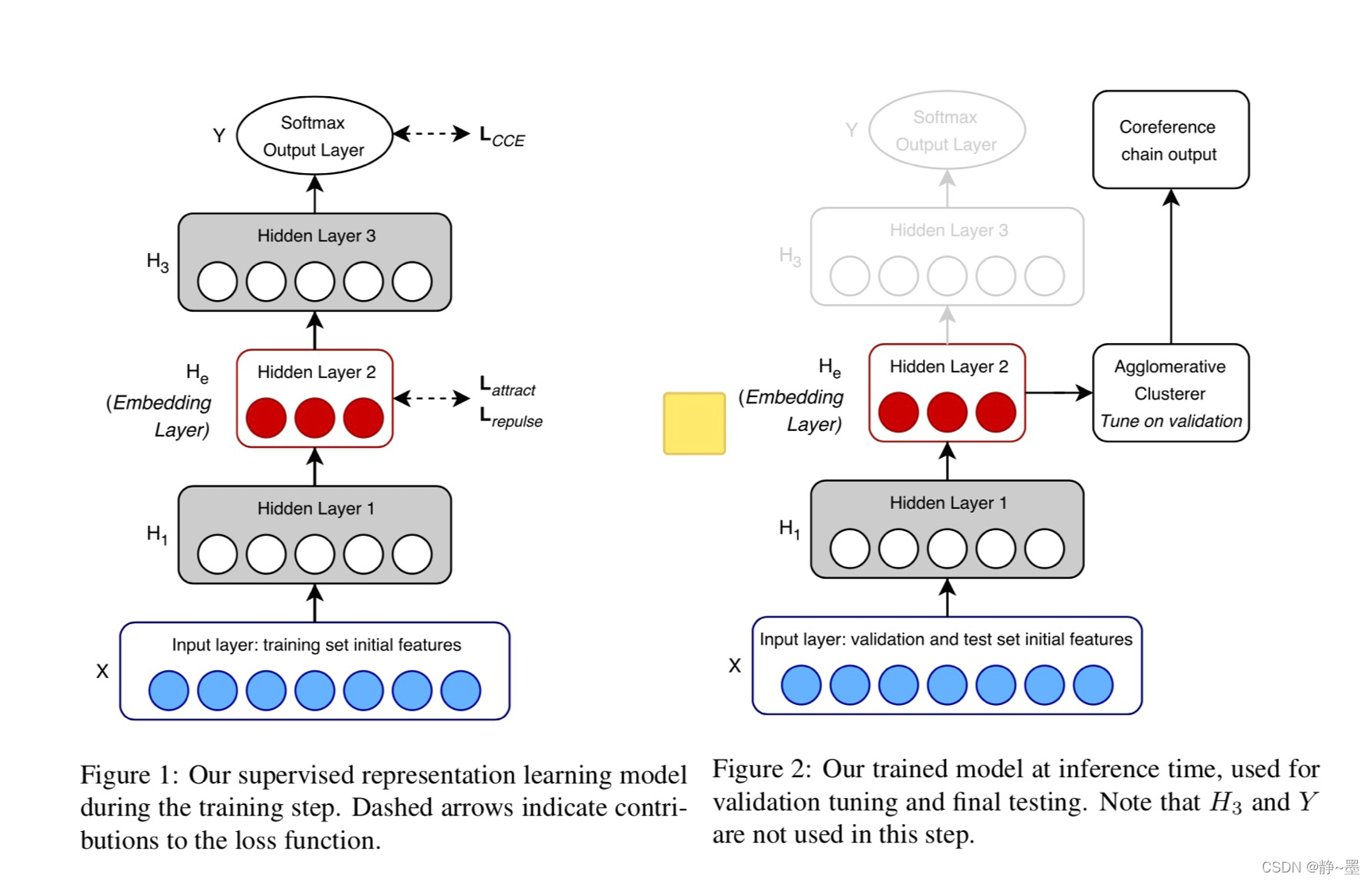

5.4 18年论文 《Resolving Event Coreference with Supervised Representation Learning and Clustering-Oriented Regularization》

- 代码开源

- 类型:篇章内/跨篇章事件指代消解

- 实验数据与指标:

- ECB(英文,篇章内事件指代消解):MUC 63;B3 92;CM 86;CE 88;BLANC 75;CoNLL 81。

- 思想:设计了一个基于监督的聚类框架。基本假设为共指事件的表征应该是相近的,(和5.3类似)在损失函数上利用了聚类蔟的性质(类内距离,类间距离)做约束。

- 创新点:

- 训练时:视为M+1分类问题,M+1中的1是针对所有单链实体。同时在损失函数上增加正则项约束(Clustering-Oriented Regularization,CORE),即共指链上的事件描述(trigger)的表征(中间层)应该相近,不同共指链上则应该不同。

- 预测时:取中间层做事件表征,再自底向上进行层次聚类。

5.5 其他论文

还有一些泛读过的论文也列举在这里

- 19年论文《Selective Expression For Event Coreference Resolution on

Twitter》 - 13年《Chinese Event Coreference Resolution: Understanding the

State of the Art》 - 09年论文《A Pairwise Event Coreference Model, Feature

Impact and Evaluation for Event Coreference Resolution 》 - 17年论文《面向多语料库的通用事件指代消解》

- 19年中文论文《融合篇章表征的事件指代消解研究》

参考

- [1]. 史树敏, 黄河燕, and 刘东升. 自然语言文本共指消解性能评测算法研究. Diss. 2008.

- [2]. Vilain, Marc, et al. “A model-theoretic coreference scoring scheme.” Sixth Message Understanding Conference (MUC-6): Proceedings of a Conference Held in Columbia, Maryland, November 6-8, 1995. 1995.

- [3]. Recasens, Marta, and Eduard Hovy. “BLANC: Implementing the Rand index for coreference evaluation.” Natural Language Engineering 17.4 (2011): 485-510.

- [4]. Lai, Tuan, et al. “A context-dependent gated module for incorporating symbolic semantics into event coreference resolution.” arXiv preprint arXiv:2104.01697 (2021).

- [5]. Krause, Sebastian, et al. “Event linking with sentential features from convolutional neural networks.” Proceedings of The 20th SIGNLL Conference on Computational Natural Language Learning. 2016.

- [6]. Tran, Hieu Minh, Duy Phung, and Thien Huu Nguyen. “Exploiting document structures and cluster consistencies for event coreference resolution.” Proceedings of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing (Volume 1: Long Papers). 2021.

- [7]. Kenyon-Dean, Kian, Jackie Chi Kit Cheung, and Doina Precup. “Resolving event coreference with supervised representation learning and clustering-oriented regularization.” arXiv preprint arXiv:1805.10985 (2018).

- [8]. Chao, Wenhan, et al. “Selective expression for event coreference resolution on twitter.” 2019 International Joint Conference on Neural Networks (IJCNN). IEEE, 2019.

- [9]. 吴瑞萦, and 孔芳. “融合篇章表征的事件指代消解研究.” 北京大学学报 (自然科学版) 1 (2020).

- [10]. Chen, Chen, and Vincent Ng. “Chinese event coreference resolution: Understanding the state of the art.” Proceedings of the Sixth International Joint Conference on Natural Language Processing. 2013.

- [11]. Chen, Zheng, Heng Ji, and Robert M. Haralick. “A pairwise event coreference model, feature impact and evaluation for event coreference resolution.” Proceedings of the workshop on events in emerging text types. 2009.

- [12]. 陆震寰, 孔芳, and 周国栋. “面向多语料库的通用事件指代消解.” 中文信息学报 32.1 (2018): 51-58.

- [13]. Choubey, Prafulla Kumar, and Ruihong Huang. “Improving event coreference resolution by modeling correlations between event coreference chains and document topic structures.” Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). 2018.

- [14]. Lu, Jing, and Vincent Ng. “Event coreference resolution with non-local information.” Proceedings of the 1st Conference of the Asia-Pacific Chapter of the Association for Computational Linguistics and the 10th International Joint Conference on Natural Language Processing. 2020.

- [15]. Lu, Yaojie, et al. “End-to-end neural event coreference resolution.” Artificial Intelligence 303 (2022): 103632.

- [16]. Lu, Jing, and Vincent Ng. “Joint learning for event coreference resolution.” Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). 2017.

1837

1837

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?