本文希望从网络架构设计和新颖的训练数据合成来提升去噪性能。作者提出了 Swin-Conv-UNet 盲去噪模型。整体结构来自 UNet,模块的设计思想结合了 DRUNet 和 SwinIR。

基于 Swin-Conv-UNet 结果和数据分析的盲去噪方法

论文名称:Practical Blind Denoising via Swin-Conv-UNet and Data Synthesis

论文地址:https://arxiv.org/pdf/2203.13278.pdf

盲去噪任务介绍

作为基本的图像复原问题,图像去噪 (Image Denoising) 问题的目标是从噪声图片中重建清晰的图像,越来越受到人们的关注。它是诸多视觉任务的第一步,且能够帮助评估不同图像先验和优化算法的有效性。目前已经提出了基于深度学习的方法的多种网络架构和超分网络的训练策略来改善去噪的性能。顾名思义,Image Denoising 任务需要两张图片,一张清晰的图和一张带噪声的图。去噪模型的目的是根据后者生成前者,而退化模型的目的是根据前者生成后者。经典去噪任务认为:噪声类型和噪声水平 (noise type and noise level) 是已知的。 但是,在实际应用中,这种噪声作用十分复杂,不但强度水平未知,而且噪声类型也难以简单建模 (白噪声,JPEG 压缩噪声,泊松噪声,相机传感器噪声等)。这种噪声类型或噪声水平未知的超分任务我们称之为盲去噪任务 (Blind Image Denoising)。对于这类任务的深度学习方法目前有两大类:其一是把噪声类型简单建模为加性高斯白噪声 (Additive White Gaussian Noise, AWGN),并想办法改进模型,因为网络架构可以帮助捕获图像先验来提升去噪任务的性能;其二是去关注训练数据或者噪声建模。但是,以 AWGN 简单建模的训练样本和真实图像之间存在一个域差。以 AWGN 为噪声训练得到的网络在实际应用时,这种域差距将导致比较糟糕的性能。

从模型架构和噪声类型建模两个方面提升去噪性能

从模型架构和噪声类型建模两个方面提升去噪性能

已有一些相关的工作希望建模更接近真实世界噪声,通过利用数字传感器的物理特性和成像流水线的步骤,已有的工作[1]设计了一种相机传感器噪声合成方法,并提供了一种有效的深度原始图像去噪模型。但是它主要关注相机传感器引起的噪声,而缺乏对通用盲去噪方法的思考。

去噪模型的架构可以帮助捕获图像先验来提升去噪任务的性能,所以也是值得考虑的因素之一。

所以这个工作试图通过新颖的网络架构设计和新颖的训练数据合成来提升去噪性能。对于网络架构设计的部分,不同类型的架构具有互补的图像先验的捕捉能力,可以结合使用以提高性能。因此,作者考虑了两种模型,分别是 DRUNet 和 SwinIR。作者提出了一个 Swin-Conv 模块,以结合残差卷积层的 local 建模能力和 Swin 模块的 non-local 建模能力,然后将其作为主要构建模块插入到 UNet 模型架构中。对于噪声模拟部分,作者同时考虑了加性高斯白噪声,泊松噪声,斑点噪声,JPEG 压缩噪声和相机传感器噪声等类型,以模拟真实世界噪声。

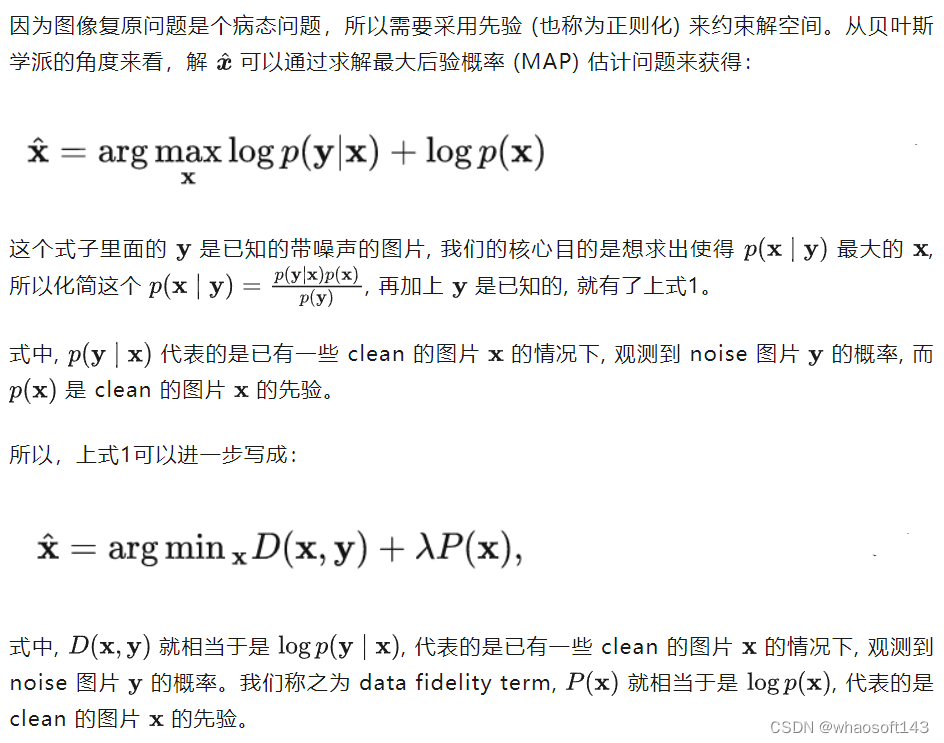

图像复原问题的建模

可以看出解决盲去噪的关键在于对 noise 图像的退化过程进行建模以及对 clean 图像的先验设计。

可以看出解决盲去噪的关键在于对 noise 图像的退化过程进行建模以及对 clean 图像的先验设计。

很明显,退化过程是由来自训练数据的噪声图像隐式定义的,这表明训练数据的噪声图像负责深度盲去噪模型来捕捉退化过程的知识。为了提高深度盲去噪模型的图像先验建模能力,应该重点改善以下三个因素,包括网络结构、模型大小和干净的图像训练数据。很明显,退化过程是由训练数据的噪声图像隐式定义的,这表明训练数据的噪声图像负责 Blind Imag

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

6528

6528

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?