作者提出了一个用于基于事件的人类动作识别的大规模基准数据集,称为HARDVS。它包含了300类人类活动和DAVIS346相机拍摄的超过10万个事件序列。此外作者提出了一种新的时空特征学习和融合框架ESTF,用于基于事件流的人类动作识别。人类动作识别真实大规模基准数据集HARDVS:300个类别和超过100K的事件序列

论文: https://arxiv.org/abs/2211.09648

代码及数据集: https://github.com/Event-AHU/HARDVS

导读

人类动作识别(HAR)算法的主流是基于RGB相机开发的,这些相机通常具有照明、快速运动、隐私保护和大能耗的特点。同时,受生物学启发的事件相机由于其独特的特性,如高动态范围、密集的时间但稀疏的空间分辨率、低延迟、低功耗等,引起了人们的极大兴趣。由于它是一种新兴的传感器,甚至没有真实的大规模HAR数据集。考虑到其巨大的实用价值,我们提出了一个大规模的基准数据集来弥补这一差距,称为HARDVS,它包含300个类别和超过100K的事件序列。我们评估并比较了多种流行的HAR算法的性能,这些算法为未来的工作提供了广泛的基线进行比较。

此外我们提出了一种新的时空特征学习和融合框架ESTF,用于基于事件流的人类动作识别。它首先使用StemNet将事件流数据嵌入到空间和时间两个分支中,然后使用Transformer网络对时空双分支特征进行交互和融合。最后将其输入到用于预测的分类头中。在多个数据集上进行的实验充分验证了我们模型的有效性。

图1 现有基于事件的数据集与HARDVS数据集规模的比较

表1 现有基于事件的数据集与HARDVS数据集的比较 whaosoft aiot http://143ai.com

图2 HARDVS数据集的样本示例

网络框架

图3 网络结构示意图

上图展示了ESTF的框架图,所提出的ESTF架构包含三个主要的学习模块,即(1)初始时空嵌入模块,(2)时空增强学习模块,以及(3)时空融合模块。具体来说,在给定输入事件流数据的情况下,我们首先分别提取初始空间和时间嵌入。然后,设计了一个时空特征增强学习模块,通过深入捕捉事件流的空间相关性和时间相关性,进一步丰富事件流数据表示。最后,设计了一个有效的融合模块,将空间和时间线索集成在一起,以获得最终的特征表示。

-

1)初始时空嵌入模块

-

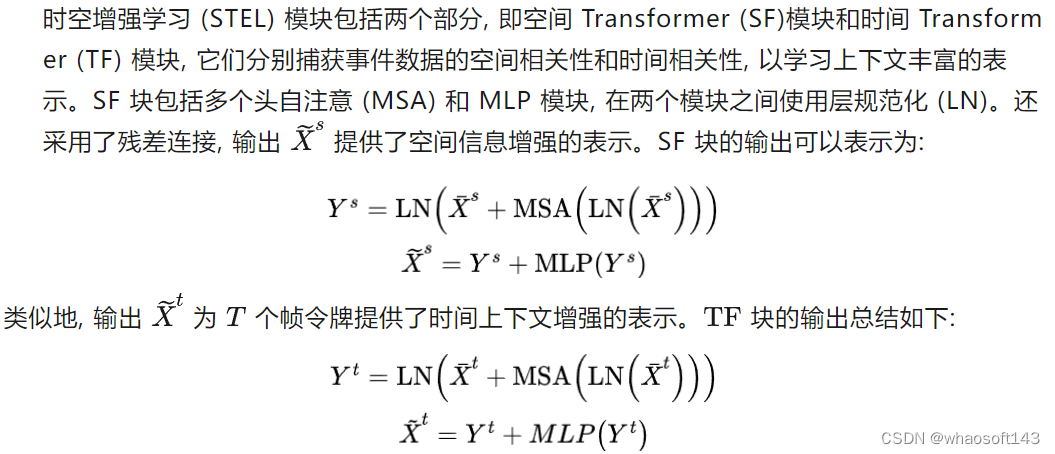

2)时空增强学习模块

-

3)时空融合模块。

损失函数

我们提出的 ESTF 框架可以端到端的方式进行优化。采用标准的交叉熵损失函数

实验结果

表2 在数据集N-Caltech101上的结果

表3 在数据集ASL-DVS上的结果

表4 多种方法在HARDVS数据集上的结果

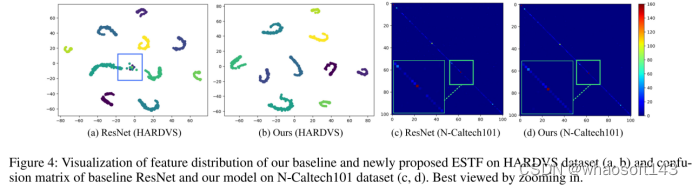

图4 特征分布可视化

表5 成分分析

总结

在本文中,我们提出了一个用于基于事件的人类动作识别的大规模基准数据集,称为HARDVS。它包含了300类人类活动和DAVIS346相机拍摄的超过10万个事件序列。这些视频反映了各种视图、照明、运动、动态背景、遮挡等对10个流行的和最近的分类模型进行了评估,以供未来的工作进行比较。此外,我们还提出了一种新的基于事件的时空Transformer(简称ESTF),进行时空增强学习和融合,以实现准确的动作识别。在多个基准数据集上进行的大量实验验证了我们提出的框架的有效性。它在N-Caltech101和ALS-DVS数据集上设置了新的SOTA性能。我们希望所提出的数据集和基线方法将推动基于事件相机的人类动作识别的进一步发展。在在我们未来的工作中,我们将考虑将颜色框架和事件流结合在一起,以实现高性能的动作识别。

2621

2621

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?