Learning to Adapt Invariance in Memory for Person Re-identification

Zhun Zhong(厦大), Liang Zheng, Zhiming Luo, Shaozi Li, Yi Yang 2019 arxiv

1. 摘要

作者的一系列论文在ReID领域来说相对有一定的传承性,而且在ReID领域也是广泛使用的几篇文章。作者在计算机视觉顶会上发表过的几篇ReID领域论文如下:

- 基于k互近邻的rerank几乎对所有ReID算法都有大幅性能提升

- 随机擦除技术简单有效,能有效模拟遮挡问题,基本是ReID的数据扩增标配方法之一,

- CamStyle解决相机不变性问题,也是ECN系列中的C

- HHL基本是ECN的雏形,ECN中的三个不变性使用了EC两个

- ECN,提出了ECN三个不变性并使用了Memory策略来将原先的mini-batch内的特征比较问题上升到整个数据集的特征比较问题

- 本文,是ECN+GCN的融合产物,简单的思路但再次提近了10个点

回到本文,即本质还是ECN+那个Memory策略(2019年有几篇reid论文都用到了这一策略,如ECN,PAUL等并且证明提点很大),而且作者还指出ECN中原先的N是根据模型检索的结果直接挑选的top-rank作为N的,但模型训练初期的检索能力不强,因此ECN的这一策略有一定的不合理性,于是提出融合其团队2019的另一篇GCN的人脸论文来解决这一问题。做的也还是处理域内变化的问题。其实ECN发布之后,实验室一位师姐也是正准备做ECN+GCN融合的算法,但进度没有作者快,并且作者他们做的性能也更好一些。

2. 介绍

红色箭头表示push开,绿色箭头表示pull到一起。

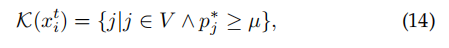

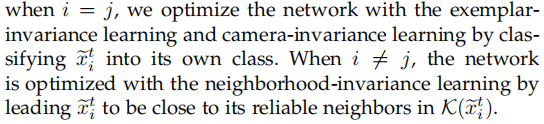

先还是ECN的三个不变性EI,CI,NI,分别是:目标域的每一张图像视为一个类别,push开,即样本不变性;相机迁移后ID不变的相机不变性,pull到一起;一张图像在训练时和测试一样做检索得到的top-rank(如何选top-rank是本文解决的问题,也是这里和ECN不同)邻居和该图像属于相同ID,即邻居不变性,pull到一起。三种不变性都有缺陷,存在奇异点,但三者之间相互权衡,最终在ECN中证明了能达到一个相当强的跨域性能(market上75%的rank@1)。当然,ECN中的memory策略对这一性能也是功不可没,因此本文也使用了memory机制,还用了两个,源域和目标域各一个,虽然会带来少量的计算量和计算时间的增加,但却对性能提升至关重要。

其思想是:

在训练时,比方说计算triplet损失,如果用传统的mini-batch优化,计算的就是一个batch内的样本相似度,但其实应该是计算该样本和整个数据集的相似度才合理,于是就用上了memory。这一策略在NI时做的那个“检索”过程是最明显的一个需要进行相似度计算的例子,因此memory在ECN中的使用也就更合理,因为ECN比之前的HHL只加了N,而N可能最受到相似性比较的影响,于是在ECN中提出memory可能主要就是为了NI服务的。

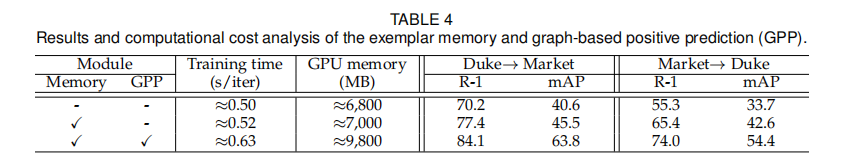

这里继续使用memory,提点很大。并且由于NI中top-rank在ECN中那样直接选择不是很合理,于是作者提出融合一个基于GCN(图卷积)的Graph-based Positive Prediction (GPP)方法。

3. 方法

框图为:

思路很清晰:

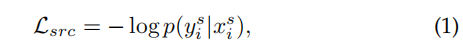

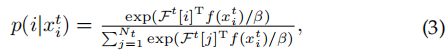

先是用源域图像训练ReID backbone,损失监督为:

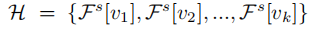

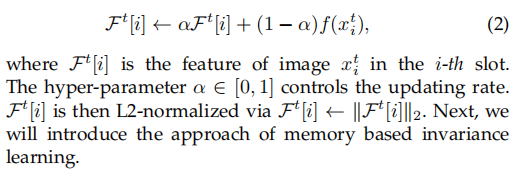

即普通的交叉熵损失。与此同时,构建源域图像特征的Source Memory,其每个slot存储了一张图像的特征,每次迭代后更新该特征,每次迭代后的特征用于构建图卷积网络(节点),用于预测当前正进行前向传播的图像的top-rank的检索结果(邻居)构建图卷积网络并预测其是输入图像的正样本还是负样本?(二分类),然后下一次迭代时图像特征得到了更新,这些节点又会发生变化,top-rank也会变,其更新如下所示:节点特征为:

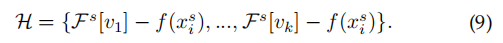

然后减去输入图像的特征进行norm,为:

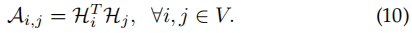

计算图邻接矩阵即边,即节点间相似性为:

然后按照如下方式更新:

然后进行分类,损失监督为:

以上即GPP的内容,图解如下:

通过四个阶段,用labeled源域数据训练一个GPP网络,让网络能够从输入图像的top-rank中跳出概率较大的邻居作为NI的正邻居,那这一措施在目标域上也能有效完成这一目的。

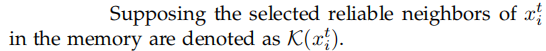

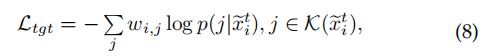

在目标域,就是进行ECN三个不变性学习,只不过NI用到的正邻居不是用普通版本(ECN的那个做法),而是用现在的GPP来找即:

同样,memory也在。不变性学习损失如下:

EI:

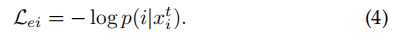

CI:

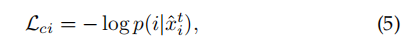

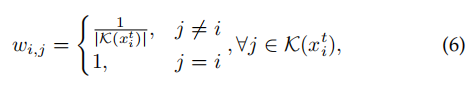

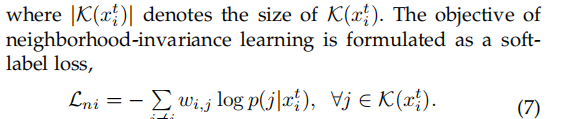

NI:

三者可以整合为:

总损失:

而Memory的更新和ECN一样:

4. 实验

4.1 示例

4.2 实验细节

4.3 参数分析

一张图像迁移成多少张图像合适?

消融:

变体:

其中

性能:

和SOTA比:

目前最高的跨域性能

1853

1853

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?